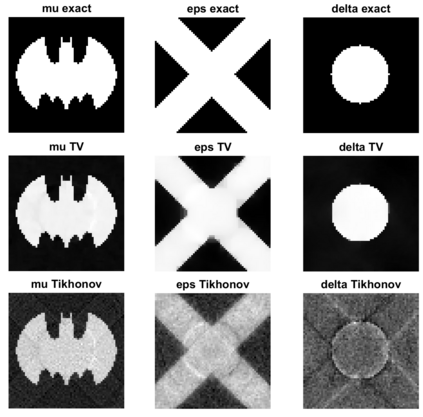

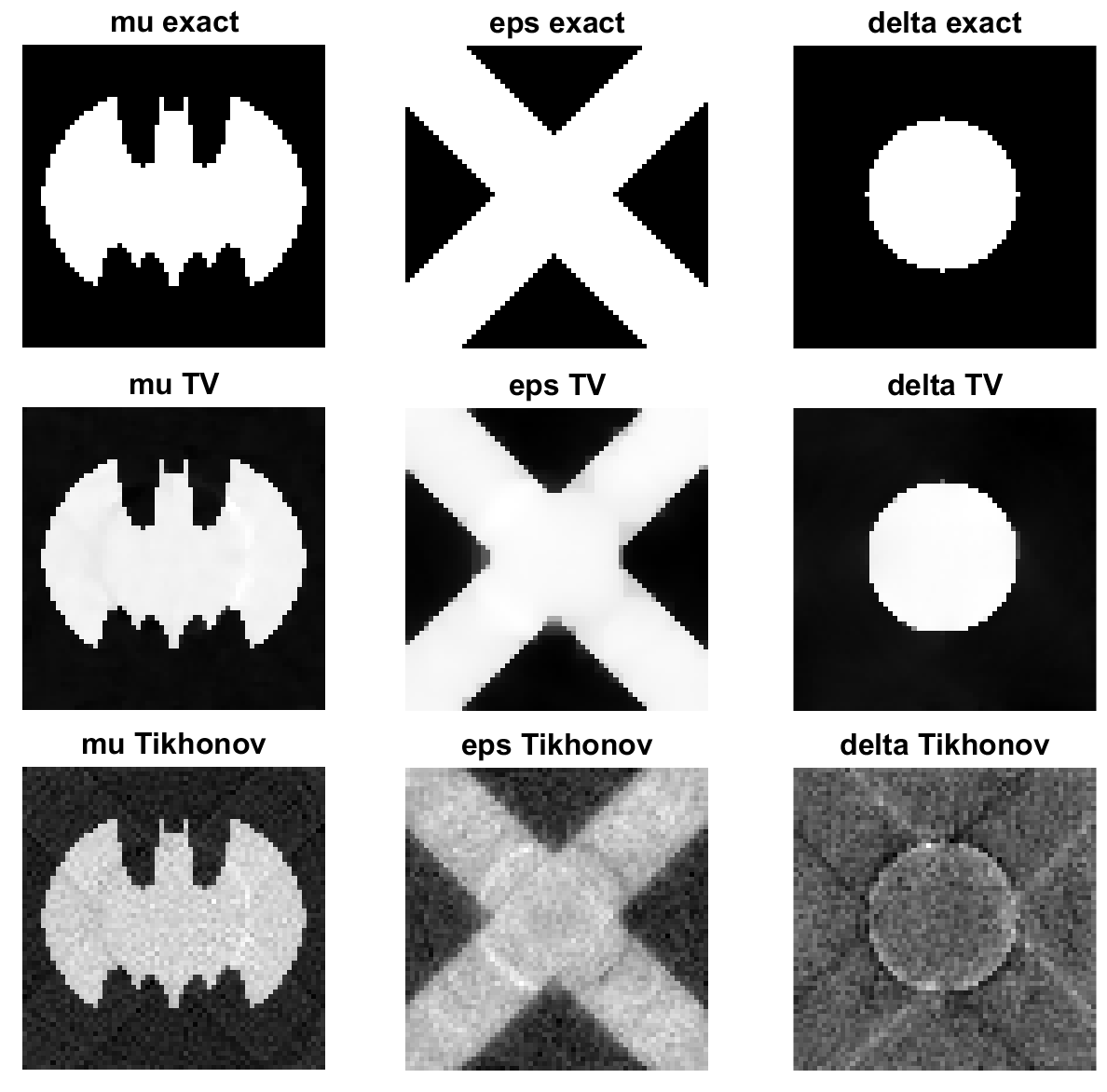

We develop an efficient algorithm for the regularization of nonlinear inverse problems based on the discrepancy principle. We formulate the problem as an equality constrained optimization problem, where the constraint is given by a least squares data fidelity term and expresses the discrepancy principle. The objective function is a convex regularization function that incorporates some prior knowledge, such as the total variation regularization function. Using the Jacobian matrix of the nonlinear forward model, we consider a sequence of quadratically constrained optimization problems that can all be solved using the Projected Newton method. We show that the solution of the sub-problem results in a descent direction for an exact merit function. This merit function can then be used to describe a formal line-search method. We also formulate a slightly more heuristic approach that simplifies the algorithm and results in a significant computational improvement. We illustrate the robustness and effectiveness of our approach using a number of numerical experiments. We consider Talbot-Lau x-ray phase contrast imaging as application.

翻译:我们根据差异原则,为非线性反向问题的正规化开发一种有效的算法。我们将这一问题表述为平等限制优化问题,其制约由最小正方数据忠诚术语给出,并表达差异原则。目标功能是包含某些先前知识的 convex 正规化功能,如全变异正规化功能。我们使用非线性前方模型的Jacobian矩阵,考虑一系列可使用预测的牛顿方法解决的四边制约优化问题。我们显示,子问题解决方案导致精确功绩功能的下降方向。然后,该功绩函数可用于描述正式的直线搜索方法。我们还制定了一种略微更精细的方法,简化了算法,并导致显著的计算改进。我们用一些数字实验来说明我们方法的稳健性和有效性。我们把Talbot-Lau X射相对比图像视为应用。