题目: Efficient and Scalable Bayesian Neural Nets with Rank-1 Factors

摘要:

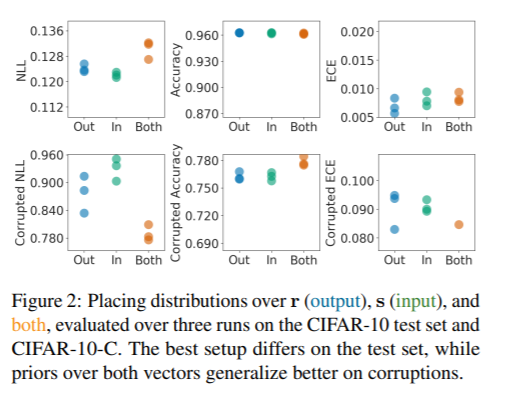

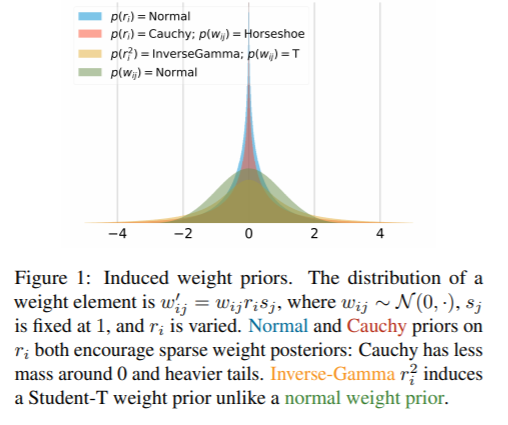

贝叶斯神经网络(BNNs)在提高现代深度学习的鲁棒性和不确定性量化方面取得了成功。然而,它们通常在规模和参数效率上与欠拟合作斗争。另一方面,深度集成已成为不确定性量化的替代方案,虽然在某些问题上表现优于BNNs,但也存在效率问题。目前还不清楚如何结合这两种方法的优点并纠正它们的共同问题。为了解决这个问题,我们提出一个BNNs的秩-1参数化,其中每个权矩阵只涉及一个秩-1子空间上的分布。我们还重新使用混合近似后验来捕获多个模式,与典型的混合不同,这种方法允许的内存增加要小得多(例如,对于大小为10的ResNet-50混合,仅增加0.4%)。我们进行了一个系统的实证研究来改善训练。对于ImageNet上的ResNet-50、CIFAR-10/100上的ResNet 28-10和MIMIC-III上的RNN, rank-1 BNNs在测试集和out- distribution变体上的对数似然、准确性和校准方面实现了最先进的性能。

成为VIP会员查看完整内容

相关内容

专知会员服务

9+阅读 · 2020年6月10日

专知会员服务

54+阅读 · 2020年3月5日

专知会员服务

7+阅读 · 2019年12月3日

专知会员服务

36+阅读 · 2019年11月12日