PTGAN for Person Re-Identification

Person Transfer GAN to Bridge Domain Gap for Person Re-Identification

CVPR 2018

文章链接:https://arxiv.org/abs/1711.08565

动机:

现有的Re-ID数据集相对于实际应用场景差距较大(人与摄像头数量、光照,时间,角度等)。

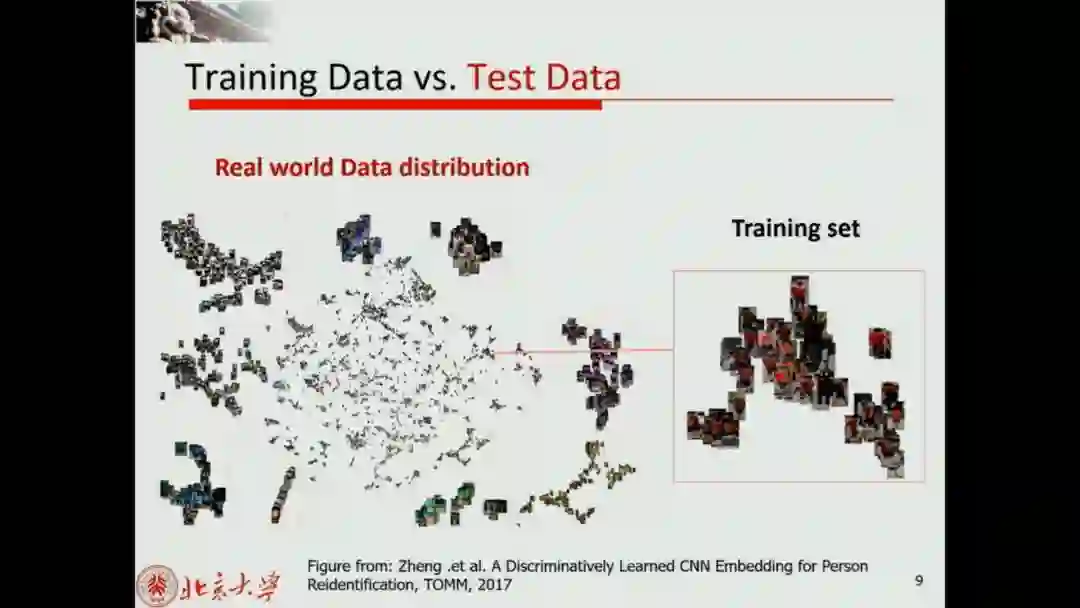

不同数据集之间存在风格的差距,在一个数据集上训练模型,在另外一个数据集上进行预测性能不一定很好。

摘要:

本文提出了一种针对于ReID的生成对抗网络PTGAN,可以实现不同ReID数据集的行人图片迁移,在保证行人本体前景不变的情况下,将背景转换成期望的数据集style。另外本文还提出一个大型的ReID数据集MSMT17,这个数据集包括多个时间段多个场景,包括室内和室外场景,是一个非常有挑战的数据集。论文用PTGAN来缩小不同数据集间的domain gap,并在新提出的MSMT17这个大数据集和其他一些公开的小数据集上做了实验。

贡献:

1.制作公开MSMT17数据集

2.提出了PTGAN,对数据集信息风格的转换。

3.分析了阻碍re-id应用的一些问题

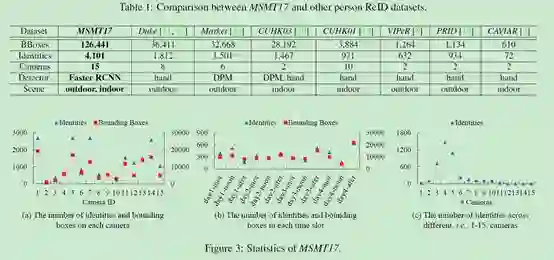

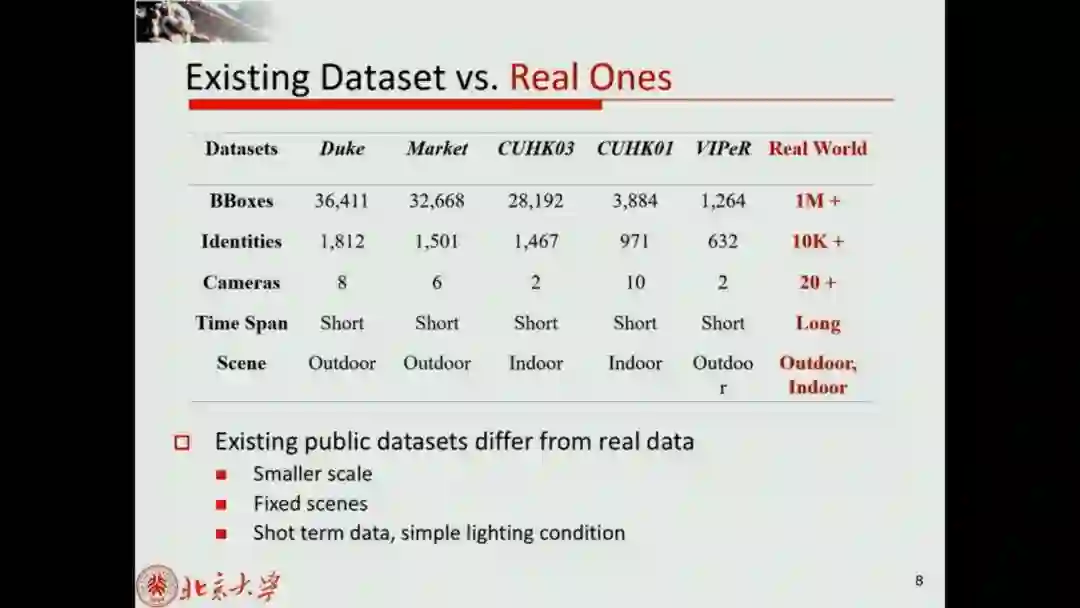

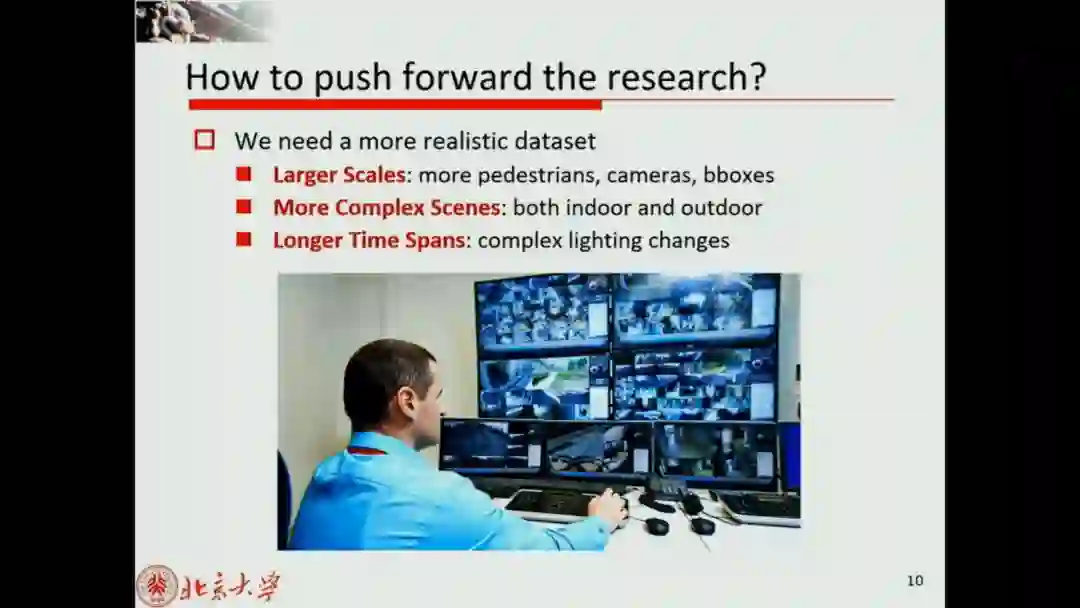

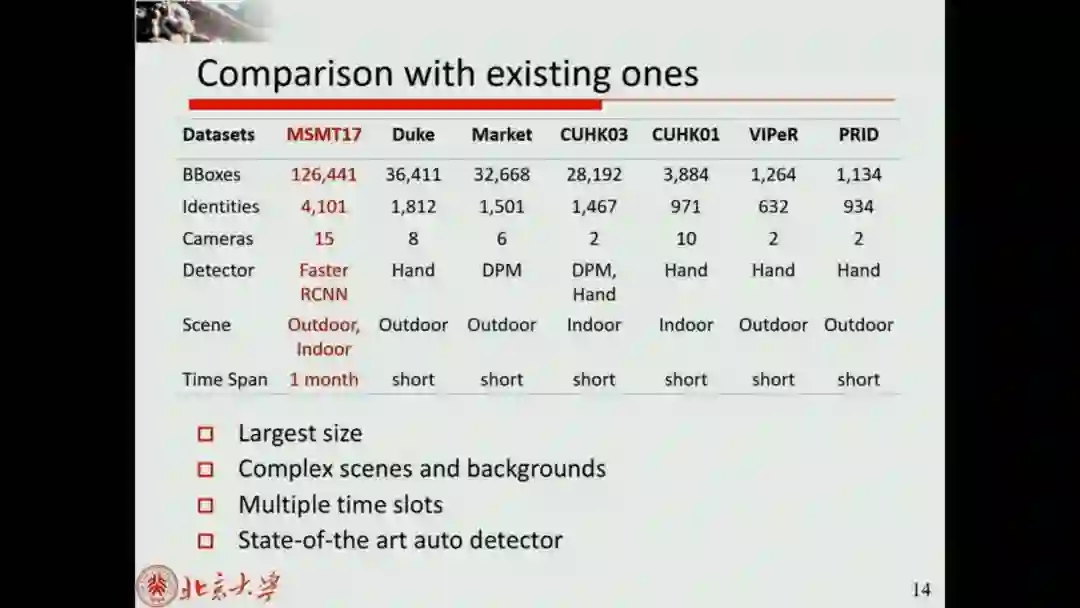

现有数据集的局限性:

人以及摄像头的数量不够大

单一的场景:要么室内或者室外

由短时间的监控录像组成,没有显著的光照变化,bbox要么是由人工标注要么是采用过时的检测器DPM

MSMT17是一个大型的ReID数据集,现在的一些公开数据集的准确度已经被刷得很高,这个数据集的提出进一步延续了ReID的发展。不过数据集目前还有公开,等待论文接收后数据集可以公开。

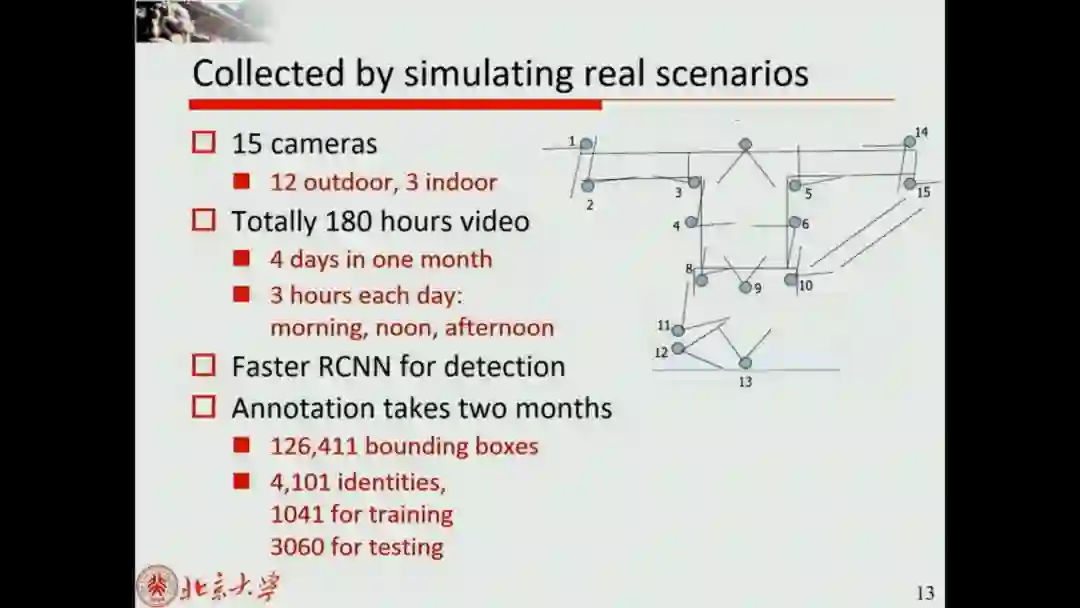

MSMT17数据集有以下几个特性:

- 数据采集时长约为180小时

- 总共有15个相机,其中12个室外相机,3个室内相机

- 行人框由FasterRCNN机标完成

- 最后总共有4101个行人的126441个boundingboxes

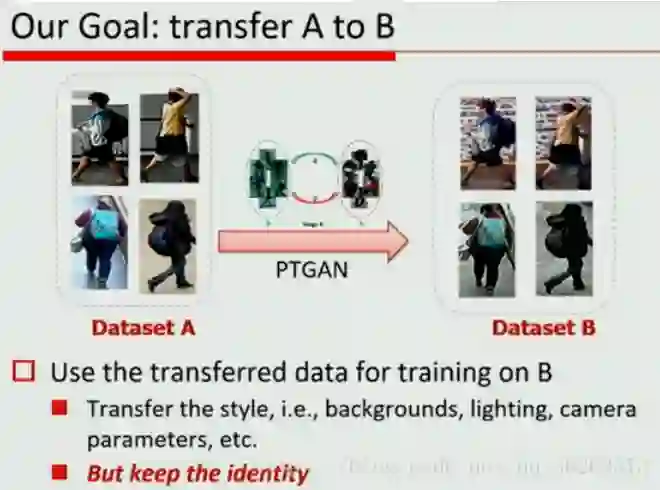

在一个dataset上训练,在另一个dataset上测试往往效果不好。因此提出:Person Transfer Generative Adversarial Network (PTGAN)

图像间风格转换使用GAN

1条件GAN

2Cycle-GAN

3用GAN产生新样本

Person Transfer GAN(PTGAN)是作者提出的一个针对于ReID问题的GAN。这个GAN最大的特点就是在尽可能保证行人前景不变的前提下实现背景domain的迁移。

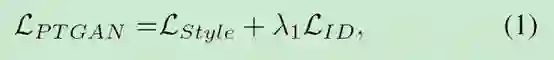

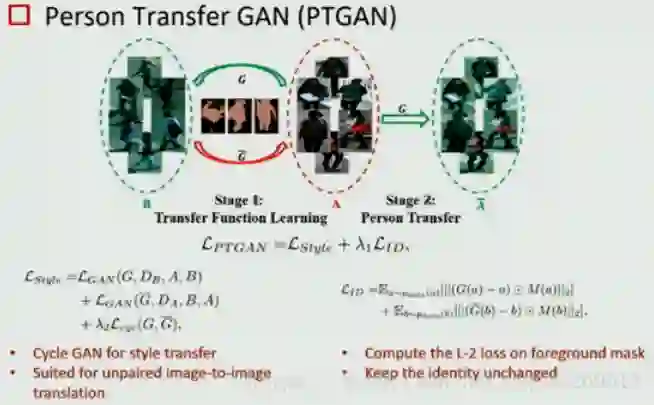

首先PTGAN网路的损失函数包括两部分:

其中LStyle代表生成的风格损失,或者说domain损失,就是生成的图像是否像新的数据集风格。LID代表生成图像的ID损失,就是生成的图像是否和原始图像是同一个人。λ1是平衡两个损失的权重。下面的关键就是看这两个损失怎么定义。

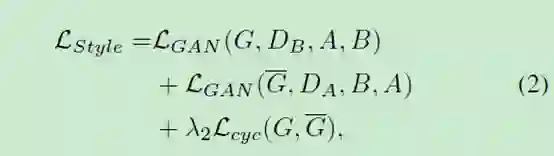

首先PTGAN的基础是CycleGAN,所以loss也和正常的CycleGAN的loss差不错。首先第一部分是LStyleLStyle,这个就是标准的CycleGAN的判别loss。

以上几部分都是正常的CycleGAN的损失,保证生成的图片和期望的数据集的domain是一样的。G表示从A到B和G的样式映射函数,-G表示从B到A的样式映射函数.DA和DB分别是A和B的样式鉴别器。

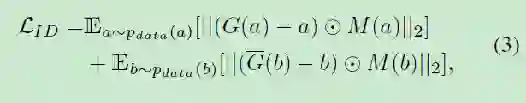

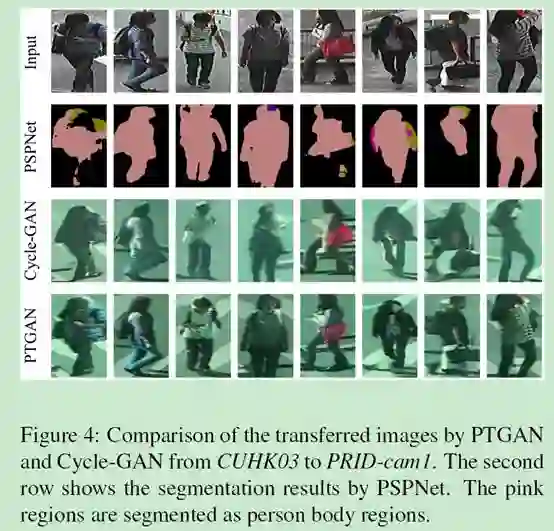

论文的另外一个改进的地方就是LID。为了保证图片迁移过程中前景不变,先用PSPNet对图片进行了一个前景分割,得到一个mask区域。传统的CycleGAN并不是用于ReID任务,因此也不需要保证前景物体的ID信息不变,这样的结果就是前景可能模糊之类的质量很差,更糟糕的现象是行人的外观可能改变,比如衣服颜色发生了改变,这是ReID任务非常不希望见到的。为了解决这个问题,论文提出LID损失,用PSPNet提取的前景,这个前景就是一个mask,最后ID损失为

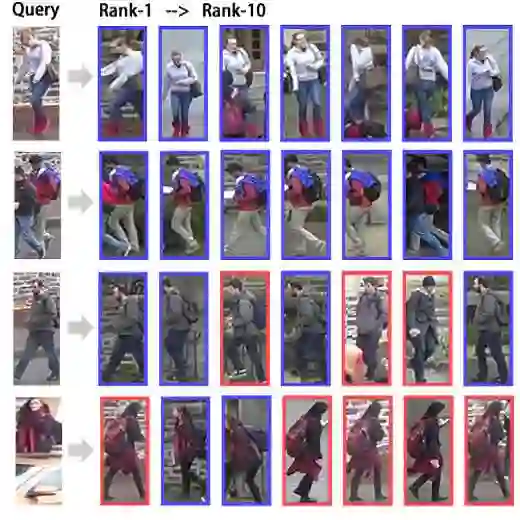

其中M(a)和M(b)是两个分割出来的前景mask,本论文使用PSPNet人物图像上的mask。ID loss将会约束行人前景在迁移过程中尽可能的保持不变。最后转换的效果如下图所示

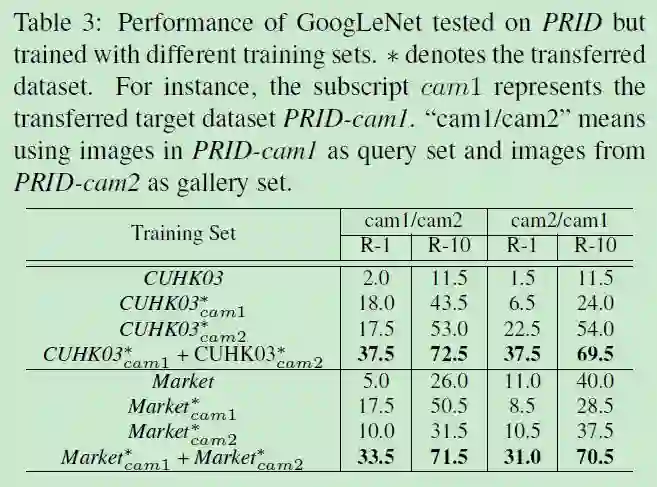

测试性能:

这个性能表很有意思的是,直接transfer to测试集的效果没有很好。但是训练集用trans to训练集+测试集来做训练,效果提升一倍。这说明,对于小数据集而已,query镜头和gallery镜头下的信息都必不可少,学习两个镜头下的差异非常有帮助。

实验结果

实验结果如上表,虽然论文没有用特别复杂的网络来训练,但是将另外一个数据集通过 PTGAN 迁移到 MSMT 上都能增加 MSMT17 数据集上的performance。并且从准确度上看 MSMT17 还是一个非常难的数据集