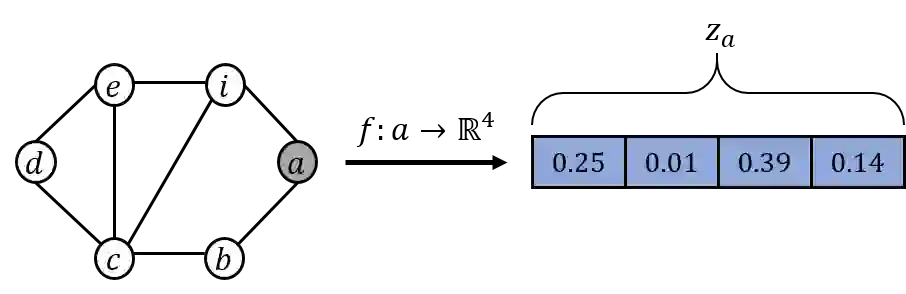

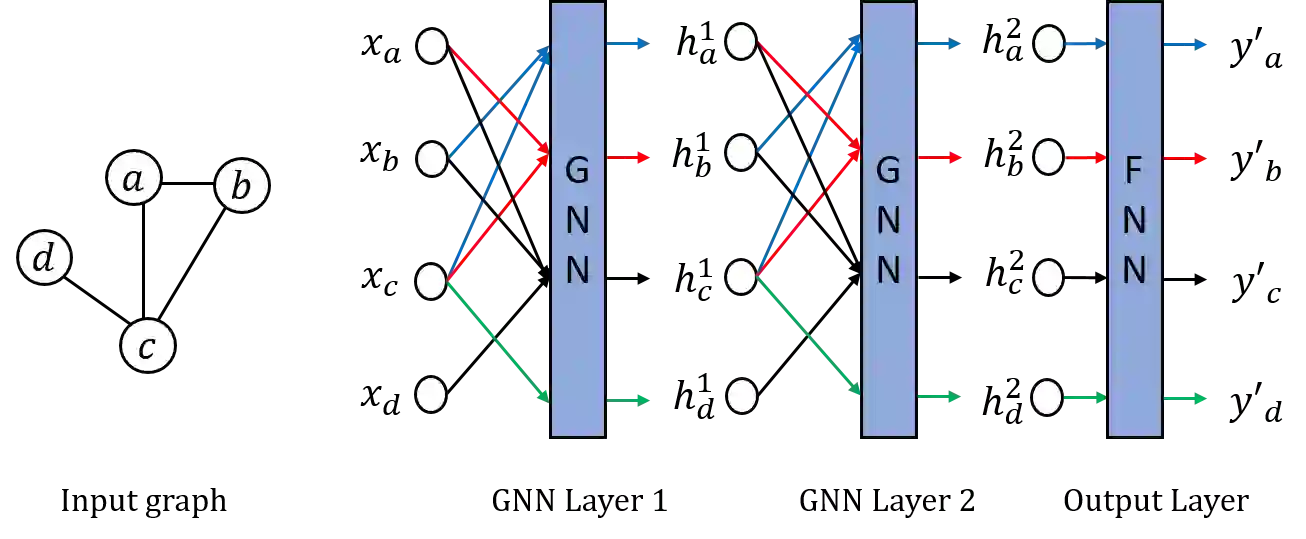

Graphs representation learning has been a very active research area in recent years. The goal of graph representation learning is to generate graph representation vectors that capture the structure and features of large graphs accurately. This is especially important because the quality of the graph representation vectors will affect the performance of these vectors in downstream tasks such as node classification, link prediction and anomaly detection. Many techniques are proposed for generating effective graph representation vectors. Two of the most prevalent categories of graph representation learning are graph embedding methods without using graph neural nets (GNN), which we denote as non-GNN based graph embedding methods, and graph neural nets (GNN) based methods. Non-GNN graph embedding methods are based on techniques such as random walks, temporal point processes and neural network learning methods. GNN-based methods, on the other hand, are the application of deep learning on graph data. In this survey, we provide an overview of these two categories and cover the current state-of-the-art methods for both static and dynamic graphs. Finally, we explore some open and ongoing research directions for future work.

翻译:近年来,图表代表学是一个非常活跃的研究领域。图形代表学的目标是生成图表代表矢量,精确地捕捉大图表的结构和特征。这特别重要,因为图形代表矢量的质量将影响这些矢量在节点分类、链接预测和异常探测等下游任务中的性能。许多技术是用来生成有效的图形代表矢量的。两个最常见的图表代表学类别是图形嵌入方法,没有使用基于图形的神经网(GNN),我们将其称为基于非GNN的图形嵌入方法和基于图形神经网(GNN)的方法。非GNN图形嵌入方法基于随机行走、时间点进程和神经网络学习方法等技术。而基于GNN的方法则是在图形数据上进行深层学习的应用。在本次调查中,我们概述了这两个类别,并覆盖了目前用于静态和动态图形的最新技术方法。最后,我们探讨了未来工作的一些开放和持续的研究方向。