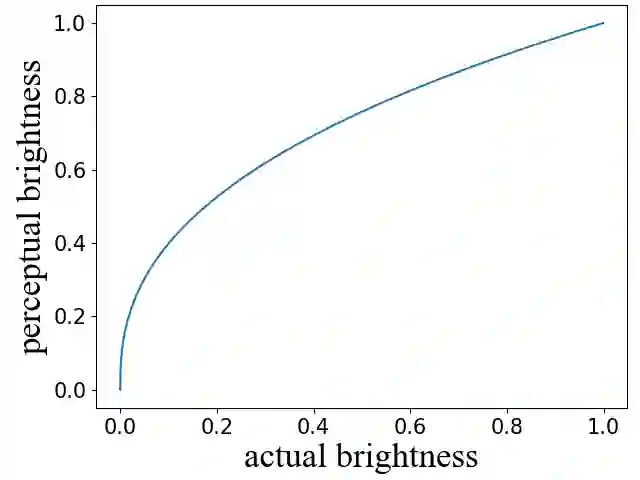

PSNR and SSIM are the most widely used metrics in super-resolution problems, because they are easy to use and can evaluate the similarities between generated images and reference images. However, single image super-resolution is an ill-posed problem, there are multiple corresponding high-resolution images for the same low-resolution image. The similarities can't totally reflect the restoration effect. The perceptual quality of generated images is also important, but PSNR and SSIM do not reflect perceptual quality well. To solve the problem, we proposed a method called regional differential information entropy to measure both of the similarities and perceptual quality. To overcome the problem that traditional image information entropy can't reflect the structure information, we proposed to measure every region's information entropy with sliding window. Considering that the human visual system is more sensitive to the brightness difference at low brightness, we take $\gamma$ quantization rather than linear quantization. To accelerate the method, we reorganized the calculation procedure of information entropy with a neural network. Through experiments on our IQA dataset and PIPAL, this paper proves that RDIE can better quantify perceptual quality of images especially GAN-based images.

翻译:PSNR 和 SSIM 是超分辨率问题中最广泛使用的衡量标准, 因为它们很容易使用, 并且可以评估生成图像和参考图像之间的相似性。 然而, 单个图像超分辨率是一个错误的问题, 同一低分辨率图像存在多个相应的高分辨率图像。 这些相似性无法完全反映恢复效果。 生成图像的感知质量也很重要, 但 PSNR 和 SSIM 并不反映感知质量 。 为了解决问题, 我们建议了一种叫作区域差异差信息酶的方法, 以测量相似性和感知质量 。 为了克服传统图像信息超分辨率无法反映结构信息的问题, 我们建议用滑动窗口测量每个区域的信息。 考虑到人类视觉系统对低亮度的亮度差异更加敏感, 我们使用 $\ gamma$ 的四分化而不是线度化 。 为了加速方法, 我们用一个神经网络重组了信息信箱的计算程序 。 通过对我们的 IQA 和 PIPAL 进行实验, 此纸质证明G 特别是质量 。