继 Yann LeCun 为存在数据偏见的算法辩护被骂退出推特之后,BLM 运动继续在学界蔓延。MIT 宣布永久下架包含种族和性别歧视标签图像的 Tiny Images 数据集,并致歉。此外,谷歌研究科学家 Samy Bengio 针对学界中的「名人效应」提出自己的建议,呼吁「有意识地引用较低关注度学者的论文」,从而引发网友热议。

![]()

轰轰烈烈的「Black Lives Matter」运动已经持续了一个多月,虽然已有缓和迹象,但整体运动开始往各领域蔓延,包括学术界。

在活动刚开始的第十几天,全美学界曾掀起过一场停摆 24 小时的运动,arXiv、Nature、Science 全部暂停更新,以重新思考黑人群体在学界的地位。

虽然活动仅进行了一天,但「思考」远未结束。最近,一位非裔女科学家把大家重新拉回了这一话题。

事件的起因是 DeepMind 6 月 29 号官宣的一门生成对抗网络(GAN)课程。课程的内容比较基础,主要介绍 GAN 的原理、优化、改进以及一些变体。

乍看之下,这门课好像没什么问题。但是,一位名叫 Adji Bousso Dieng 的研究者质问道:「既然你们要开 GAN 的课,为什么我在 DeepMind 提出的 PresGAN 没有被包含在内?是因为这篇论文的一作(我)是黑人女性吗?」「我已经厌倦了这种轻视、轻易抹掉我的贡献的行为。」

![]()

这位 Adji Bousso Dieng 是什么来头?

Dieng 来自非洲塞内加尔,是哥伦比亚大学统计学系的一名博士研究生。她的主要研究方向是将概率图形建模和深度学习结合起来,为结构化的高维数据设计模型。她的研究工作得到了谷歌博士奖学金的支持。

读博期间,Dieng 连续几年在 ICLR、NeurIPS 等顶会参与组织 workshop,还在微软、Facebook AI 、DeepMind 做过实习生。上面提到的 PresGAN 便是她在 DeepMind 实习期间做的。

根据 Dieng 提供的链接,我们找到了这篇论文。在论文中,Dieng 提出了一种 GAN 变体 PresGAN,主要改进的地方是在密集网络的输出中添加噪声并对熵正则化对抗损失进行优化。添加的噪声对预测性对数似然的易处理近似进行渲染,并实现训练流程的稳定。实验结果表明,PresGAN 可以减轻模式崩溃并生成高感知质量的样本。此外,PresGAN 还可以缩小传统 GAN 和变分自编码器在预测性对数似然方面的性能差距。

![]()

论文链接:https://arxiv.org/pdf/1910.04302.pdf

虽然宣称的效果还不错,但遗憾的是,这篇论文在 Google Scholar 上的被引量只有「5 次」。

![]()

有人认为,这就是一篇平平无奇的论文,评估结果也很弱,即使在 CIFAR-10 上也比 SOTA 差很多。

![]()

而且,这只是一篇挂在 arXiv 上的论文,还没有经过同行评审。「多数人不会倾向于引用一篇未经同行评审的论文。」

![]()

总之,大家认为,这篇论文之所以被引量低,并不是因为种族问题,而是论文本身不够硬。

但也有人在看过论文后表示,这是一篇不错的论文,可能真的被社区低估了。

![]()

论文的质量究竟如何,我们需要仔细研读才能得出结论。但有一点可以肯定,搬出种族歧视大旗似乎并不是解决学术问题的合理方法。

「我认为你应该用科学的方式来证明自己的观点,写一篇博客来告诉大家为什么你的论文应该被引用。」

![]()

这个话题引起了谷歌研究科学家、Yoshua Bengio 的兄弟 Samy Bengio 的注意。他认为,要从根本上改善弱势群体在学界的地位,应该从改变引用习惯做起。

Samy Bengio:建议大家多引用少数群体的论文

Samy Bengio 在自己的 Facebook 主页发帖表达了自己的看法。

![]()

坚持科学理性的学术立场虽然不易,但很有必要,这是提升机器学习社区质量和多样性的必由之路。我们大家每一小步的正确举动都将累积成社区长远发展的一大步。Adji Dieng 这件事令我萌生了一种想法:我们所有人在引用彼此的文献时,可以有意识地选择那些关注度较低的作者的论文,而不是选择名人作者的论文;引用那些每天受系统性问题之害的作者,而不是那些已经受益颇多的作者。我们都清楚论文引用在机器学习领域至关重要,我的这个想法实施起来简单有效。大家觉得呢?有其他好的建议也请分享。

对此,有人在 reddit 上发帖提问:学术引用真的已经只看作者,而不重论文实际内容了吗?

![]()

对于 Samy Bengio 博客中提出的「多引用关注度较低的作者的论文」,网友也纷纷表达了自己的看法。

下面这位网友表示,ta 完全赞成引用关注度较低学者的论文,但绝不应该因为种族或者名气等外部原因而做出不理性客观的引用,要以论文相关性为引用基准。

![]()

而对于「学术引用已经基于作者,而非论文实际内容」的提问,下面这位网友表示,这似乎就是我们经常在做的事情。每篇论文都以「计算机视觉已经成功地应用于 xx 任务」开头,并且像完成任务般列举出与论文主题相关性甚小却由名人撰写的论文。

![]()

但也有人表示,虽然 ta 也认为不应该基于作者来引用论文,并且赞成支持少数群体论文的观点。但 Samy Bengio 的建议是否正确仍待商榷。

![]()

盲目的学术崇拜肯定不利于新研究、新观点和新技术的推广,也不利于构建一个健康理性的社区。但如果真的按照 Samy Bengio 的建议而有意识地多引用关注度较低的作者的论文,这是否又会走入另一个极端呢?

不止学者陆续发声表达自己的观点,学术机构也在行动。

近日,为了营造健康的学术氛围,反对并遏制种族歧视等各类偏见,MIT 也采取了相应的行动:将存在种族歧视和性别偏见内容的 Tiny Images 数据集永久移除。

![]()

Tiny Images 数据集中包含大量冒犯性标签的图像。

该数据集创建于 2006 年,删除它的原因是这个有八千万张图像的数据集中含有大量的带有种族歧视等偏见的内容。比如,该数据集中有这样的照片:黑人和猴子的照片被贴上 Nigger 标签;穿着比基尼的妇女被贴上妓女的标签等,将毫无关系的图像内容和一些侮辱性词汇牵扯在一起。更糟糕的是,那些使用该数据集训练的 AI 模型也会带有这样的有害偏见。

![]()

Tiny Images 数据集中带有 Nigger 标签的图像。

这些图像数据是基于 WordNet 分类词库从搜索引擎自动收集的。WordNet 具有强大的关联性,会根据单词的意义将不同的词组成相应的集合,因而带有一定的偏向性。那么在搜索引擎上搜索图像时,获得的图片也相应地具有强烈的偏见性。

此外,数据集的规模不仅非常大,而且这些图像的分辨率只有 32x32 像素,也从未存储过原始的高分辨率版本,以至于人们难以用肉眼识别它们的内容。即使人工检查也无法保证能够完全清除这些有冒犯性的图像。

这些因素都使得 MIT 不得不删除了 Tiny Images 数据集,目前该数据集已经下线并且永远不会再上线。

MIT 也对删除 Tiny Images 数据集给出了官方声明:

![]()

在声明中,MIT 表示已经注意到 Tiny Images 数据集包含一些侮辱性词汇以及冒犯性的图像,并高度关注这件事,同时向受到影响的人道歉。因此决定正式撤销 Tiny Images 数据集。此外,MIT 还要求社区以后都不再使用它,并且删除已下载的该数据集的任何副本。

最后,MIT 表示:「含有偏见和冒犯性的图像以及带有侮辱性的词汇,会迫使社区疏远重要的组成部分——人才,而人才正是我们想方设法吸纳的。此外,该数据集还会导致使用它训练的 AI 系统也包含有害偏见,此类有偏见的图像也有损计算机视觉社区努力构建的包容文化,这些都与我们努力维护的价值观背道而驰。」

https://www.theregister.com/2020/07/01/mit_dataset_removed/

https://www.reddit.com/r/MachineLearning/comments/hjlsy8/d_samy_bengios_post/

https://groups.csail.mit.edu/vision/TinyImages/

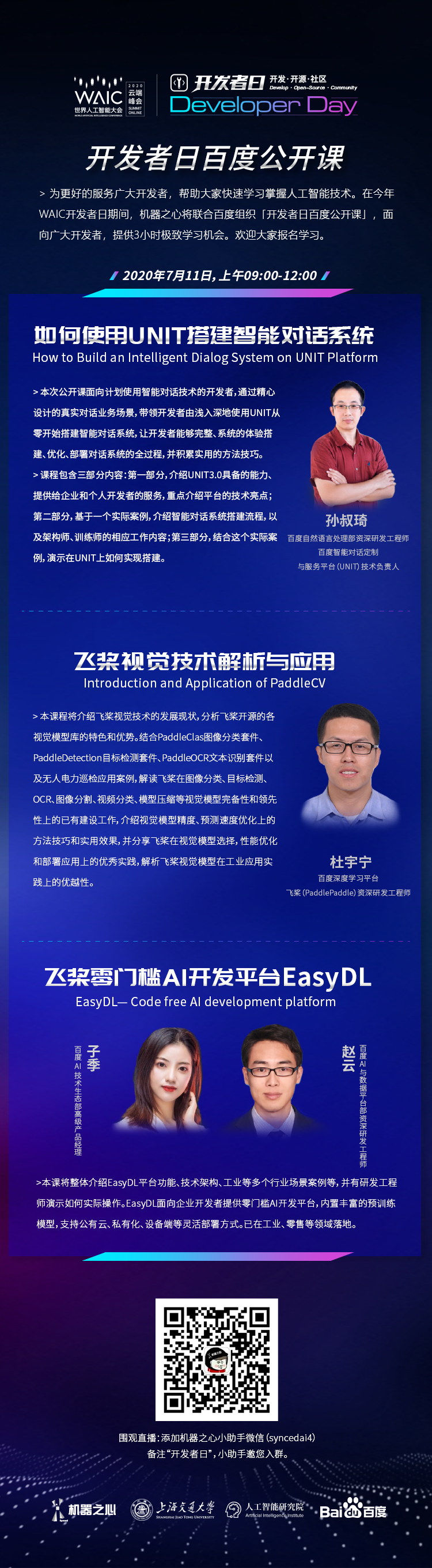

7月11日09:00-12:00,机器之心联合百度在WAIC 2020云端峰会上组织「开发者日百度公开课」,为广大开发者提供 3 小时极致学习机会,从 NLP、CV 到零门槛 AI 开发平台 EasyDL,助力开发者掌握人工智能开发技能。扫描图中二维码,加机器之心小助手微信邀您入群。

![]()