ICML 2019录取结果出炉,Ian Goodfellow等入选论文推荐

新智元原创

新智元原创

编辑:肖琴

【新智元导读】ICML 2019的录取结果昨天已经出炉,许多投稿者在Twitter发表“中了”的消息,新智元摘选了几篇不错的ICML中奖论文,包括Ian Goodfellow等人的论文,一起来先睹为快吧!

昨天,ICML 2019的论文入选结果已经出炉,你的论文中了吗?

来自Reddit的讨论贴

尽管完整录取列表尚未公开,不过已经有许多投稿者在Twitter发表“中了”的消息。

下面,新智元摘选了几篇不错的ICML中奖论文,一起来先睹为快吧。

首先介绍来自加州大学圣地亚哥分校Yao Qin、Garrison Cottrell和前谷歌大脑Ian Goodfellow等人的论文,在这篇论文中,研究人员提出了语音识别的对抗样本。

1、Imperceptible, Robust, and Targeted Adversarial Examples for Automatic Speech Recognition

https://arxiv.org/abs/1903.10346

作者:Yao Qin, Nicholas Carlini, Ian Goodfellow, Garrison Cottrell, Colin Raffel

对抗样本(adversarial examples)是一种专门设计的输入,其目的是使机器学习模型产生错误的输出。

对抗样本在图像领域已经得到了广泛的研究。在图像领域中,可以通过对图像进行细微的修改来产生对抗样本,从而导致分类错误,这在物理世界中具有实用价值。

但是,目前应用于语音识别系统的有针对性的对抗样本却缺乏这两种特性:人类可以很容易地识别对抗性干扰,并在通过扬声器播放时它们并不生效。

本研究在这两个方面都取得了进展。首先,我们利用听觉掩码(auditory masking)的心理声学原理,在人类听不到的音频区域添加对抗扰动,开发出有效的、不易察觉的音频对抗样本(通过人类研究得到验证),同时对任意完整的句子保持100%的针对性成功率。

接下来,我们通过构造在应用于真实的模拟环境扭曲后仍然有效的扰动,从而在物理世界的无线音频对抗样本方面取得了进展。

2、TensorFuzz: Debugging Neural Networks with Coverage-Guided Fuzzing

https://arxiv.org/abs/1807.10875

作者:Augustus Odena, Ian Goodfellow

众所周知,由于各种原因,机器学习模型难以调试(debug)或解释。这造成了最近机器学习的 “可重复性危机”(reproducibility crisis)—— 对难以调试的技术做出可靠的实验结论是很棘手的。

神经网络又特别难以 debug,因为即使是相对直接的关于神经网络的形式问题,解决的计算成本也很高,而且神经网络的软件实现可能与理论模型有很大的差异。

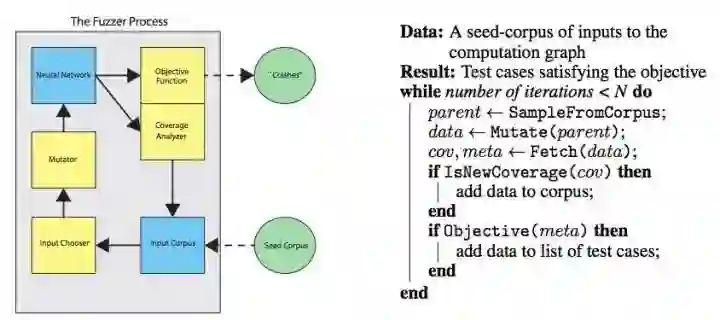

在这项工作中,我们利用传统软件工程中的一种技术 —— 覆盖引导模糊测试(coverage guided fuzzing,CGF),并将其应用于神经网络的测试。

具体来说,这项工作有以下贡献:

我们对神经网络引入了 CGF 的概念,并描述了如何用快速近似最近邻算法( fast approximate nearest neighbors algorithms)以通用的方式检查覆盖率。

我们开源了一个名为 TensorFuzz 的 CGF 软件库。

我们使用 TensorFuzz 在已训练的神经网络中查找数值问题,在神经网络及其量化版本之间查找分歧,以及在字符级语言模型中查找不良行为。

图:fuzzing 主循环的简略描述。左:模糊测试程序图,表示数据的 flow。右:用算法的形式描述了模糊测试过程的主循环。

相关阅读:

谷歌大脑开源 TensorFuzz,自动 Debug 神经网络!

接下来介绍的论文来自罗格斯大学Han Zhang和Dimitris Metaxas,以及谷歌大脑的 Ian Goodfellow 和 Augustus Odena,在这篇论文中,他们提出 “自注意力生成对抗网络”(SAGAN),将自注意力机制(self-attention mechanism)引入到卷积 GAN 中,作为卷积的补充,取得了最优的结果。

3、Self-Attention Generative Adversarial Networks

arxiv.org/abs/1805.08318

作者:Han Zhang, Ian Goodfellow, Dimitris Metaxas, Augustus Odena

在这篇论文中,我们提出自注意力生成对抗网络( Self-Attention Generative Adversarial Network ,SAGAN)。SAGAN 允许对图像生成任务进行注意力驱动、长相关性的建模。传统的卷积 GAN 生成的高分辨率细节仅作为在低分辨率特征图上的空间局部点的函数。在 SAGAN 中,可以使用来自所有特征位置的线索来生成细节。此外,鉴别器可以检查图像的远端部分的高度详细的特征彼此一致。此外,最近的研究表明,生成器条件会影响 GAN 的性能。

利用这些发现,我们将谱归一化到 GAN 生成器中,并发现这改进了训练动态。我们提出的 SAGAN 达到了最优的结果,将 Inception score 从当前最高的 36.8 提高到 52.52,并且在具有挑战性的 ImageNet 数据集上将 Frechet Inception distance 从 27.62 降低到 18.65。注意力层的可视化表明,生成器利用与对象形状相对应的邻域,而不是固定形状的局部区域。

相关阅读:

Ian Goodfellow 等提出自注意力 GAN,ImageNet 图像合成获最优结果!

接下来推荐的论文来自东京大学的Kenta Oono和Taiji Suzuki,这篇论文有41页,对于会议论文来说确实有点长。

4、Approximation and Non-parametric Estimation of ResNet-type Convolutional Neural Networks

arxiv.org/abs/1903.10047

作者:Kenta Oono, Taiji Suzuki

卷积神经网络(CNNs)在多个函数类中均能达到最优逼近和估计误差率(在minimax意义上)。然而,由于包括Holder类在内的重要函数类的稀疏约束,以往分析的最优CNN的范围过于广泛,难以通过优化获得。

我们证明了一个ResNet类型的CNN可以在更合理的情况下在这些类别中获得minimax最优错误率——它可以是密集的,它的宽度、通道大小和过滤器大小相对于样本大小是恒定的。

其核心思想是,只要神经网络具有\textit{block-sparse}结构,我们就可以通过定制的CNN来复制全连接神经网络(FNN)的学习能力。从某种意义上说,我们的理论是通用的,我们可以自动地将block-sparse FNN所实现的任何近似率转换成CNN的近似率。作为应用,我们使用相同策略推导出针对Barron类和Hölder类的CNN的近似误差和估计误差。

5、Imitation Learning from Imperfect Demonstration

https://arxiv.org/abs/1901.09387

作者:Yueh-Hua Wu, Nontawat Charoenphakdee, Han Bao, Voot Tangkaratt, Masashi Sugiyama

模仿学习(Imitation learning, IL)的目的是通过演示学习最优策略。然而,由于收集最优示例的成本很高,因此此类演示通常并不完美。为了有效地从不完美的演示中学习,我们提出了一种新的方法,利用置信评分(confidence scores)来描述演示的质量。更具体地说,我们提出了两种基于confidence的IL方法,即两步的重要性加权IL (2IWIL)和具有不完美演示和置信度的生成对抗性IL (IC-GAIL)。我们证明了,仅给出一小部分次优演示的置信度得分在理论上和经验上都显着提高了 IL 的性能。

更多ICML 2019录取论文

1、Heterogeneous Model Reuse via Optimizing Multiparty Multiclass Margin

作者:吴西竹,周志华,柳松

2、Importance Sampling Policy Evaluation with an Estimated Behavior Policy

arxiv.org/abs/1806.01347

作者:Josiah Hanna, Scott Niekum, Peter Stone

3、Extrapolating Beyond Suboptimal Demonstrations via Inverse Reinforcement Learning from Observations

arxiv.org/abs/1904.06387

作者:Daniel S. Brown, Wonjoon Goo, Prabhat Nagarajan, Scott Niekum

4、Global Convergence of Block Coordinate Descent in Deep Learning

arxiv.org/abs/1803.00225

作者:Jinshan Zeng, Tim Tsz-Kit Lau, Shaobo Lin, Yuan Yao

5、Learn-to-Grow for addressing Catastrophic Forgetting in Continual Machine Learning

https://arxiv.org/abs/1904.00310

作者:Xilai Li, Yingbo Zhou, Tianfu Wu, Richard Socher, Caiming Xiong

6、Imitating Latent Policies from Observation

https://arxiv.org/abs/1805.07914

Ashley D. Edwards, Himanshu Sahni, Yannick Schroecker, Charles L. Isbell

7、Using Pre-Training Can Improve Model Robustness and Uncertainty

arxiv.org/abs/1901.09960

作者:Dan Hendrycks, Kimin Lee, Mantas Mazeika

8、Hyperbolic Disk Embeddings for Directed Acyclic Graphs

arxiv.org/abs/1902.04335

作者:Ryota Suzuki, Ryusuke Takahama, Shun Onoda

9、Finding Options that Minimize Planning Time

arxiv.org/abs/1810.07311

作者:Yuu Jinnai, David Abel, D Ellis Hershkowitz, Michael Littman, George Konidaris

10、Discovering Options for Exploration by Minimizing Cover Time

https://arxiv.org/abs/1903.00606

作者:Yuu Jinnai, Jee Won Park, David Abel, George Konidaris

更多阅读

新智元春季招聘开启,一起弄潮 AI 之巅!

岗位详情请戳:

【加入社群】

新智元 AI 技术 + 产业社群招募中,欢迎对 AI 技术 + 产业落地感兴趣的同学,加小助手微信号:aiera2015_2 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名 - 公司 - 职位;专业群审核较严,敬请谅解)。