语音合成论文和英伟达撞车,韩国小哥紧急放出全部草稿代码和样本 | 资源帖

晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

由于和英伟达研究撞车,韩国一位研究语音合成的作者已经哭晕了。

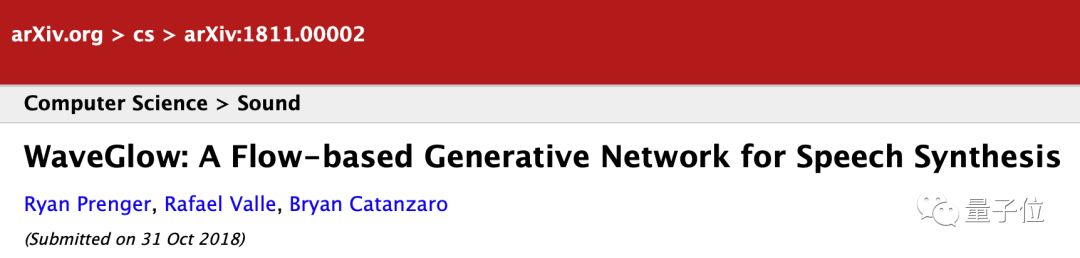

10月31日,英伟达在arXiv网站上传了一篇论文——WaveFlow:一个用于音频合成基于流的生成网络。

英伟达论文地址:

https://arxiv.org/abs/1811.00002

而一位韩国首尔大学的学生发现,自己的研究成果竟然和英伟达高度相似,为了和英伟达抢时间,他们在11月6日赶紧也向arXiv上传了论文。

论文第二作者昨晚还在reddit发帖,并抢时间放出源代码,以此安慰在角落哭泣的第一作者。

FloWaveNet项目

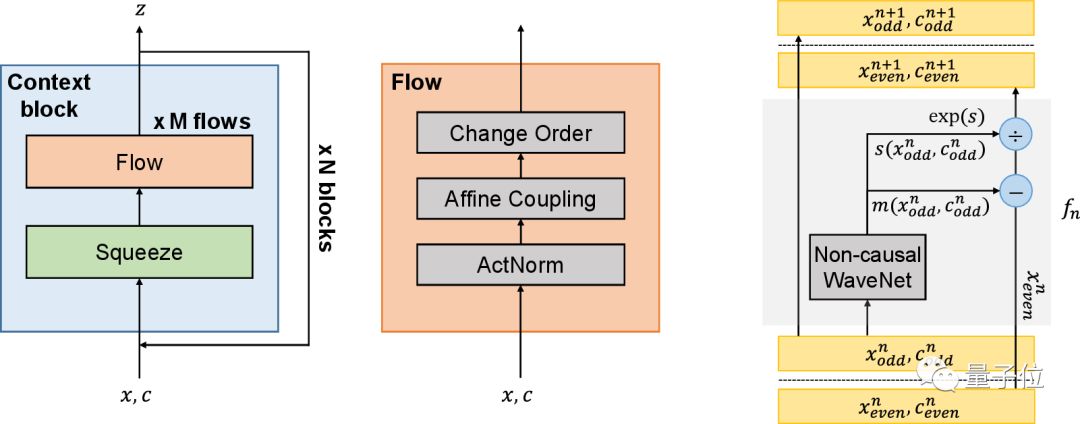

这位韩国学生公布的FloWaveNet,是一种基于流生成模型的原始音频合成方法,只需要一个最大似然损失,不需要其他额外的损失函数。该模型可以实时高效地采样原始音频,而且合成音频的清晰度已经能和WaveNet相媲美。

英伟达也公布了自己的WaveGlow:一种基于流的网络,能够从梅尔频谱图(mel-spectrograms)中合成高质量的语音。 它借鉴了OpenAI的生成网络Glow和DeepMind的WaveNet,能够提供快速,高效和高质量的音频合成,而无需自动回归(auto-regression)。 WaveGlow仅由单一成本函数进行训练,使用单一网络实现,使得训练过程简单而稳定。

源代码与合成音频样品

作者已经在GitHub上公布了FloWaveNet源代码,并和百度研究院数月前发布的语音合成项目ClariNet进行对比。

FloWaveNet项目地址:

https://github.com/ksw0306/FloWaveNet

ClariNet项目地址:

https://github.com/ksw0306/ClariNet

这两个项目都是基于PyTorch实现,此外用户还需要安装音频分析包librosa。

为了展示效果,作者还放出了与原始音频、WaveNet合成音频样品的对比(第一段为原始音频、第二段为FloWaveNet合成,第三段为WaveNet合成):

另外,英伟达也放出了自己的WaveGlow的项目和多段音频对比,但是却没有提供源代码:

https://nv-adlr.github.io/WaveGlow

不过,有英伟达论文的第三方PyTorch实现可用:

https://github.com/npuichigo/waveglow

因祸得福

帖子发出后2个小时内,获得了热烈讨论。有人分享了类似“撞车”经验,表示单枪匹马很难与大公司众多工程师竞争,自己开始某项研究数月后,就被DeepMind抢发了论文。

不过还是有人鼓励作者,英伟达的WaveGlow目前仅仅是提交到arXiv,还未正式发表,希望作者不要担心。

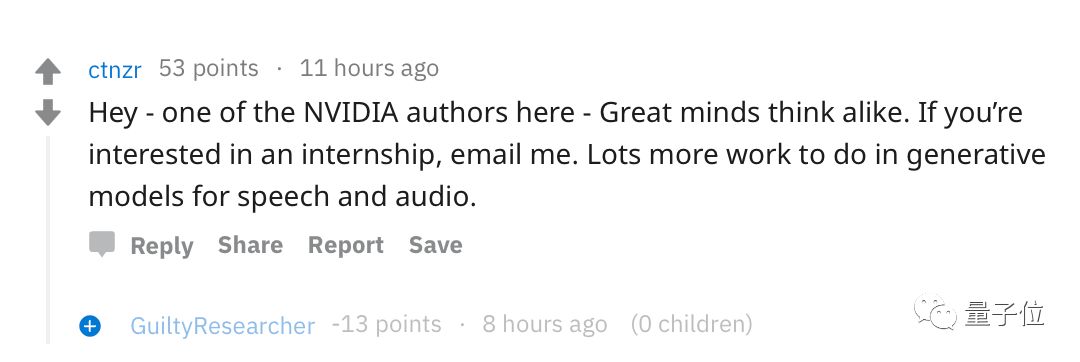

很快帖子就吸引来了行业大咖。英伟达WaveGlow作者之一、负责应用深度学习的副总裁Bryan Catanzaro在回帖中点赞,并且抛出了橄榄枝,希望发帖者能够去英伟达实习。

不知道这算不算因祸得福呢?

— 完 —

年度评选申请

加入社群

量子位AI社群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

活动策划招聘

量子位正在招聘活动策划,将负责不同领域维度的线上线下相关活动策划、执行。欢迎聪明靠谱的小伙伴加入,并希望你能有一些活动策划或运营的相关经验。相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态