ICLR 2018十佳论文

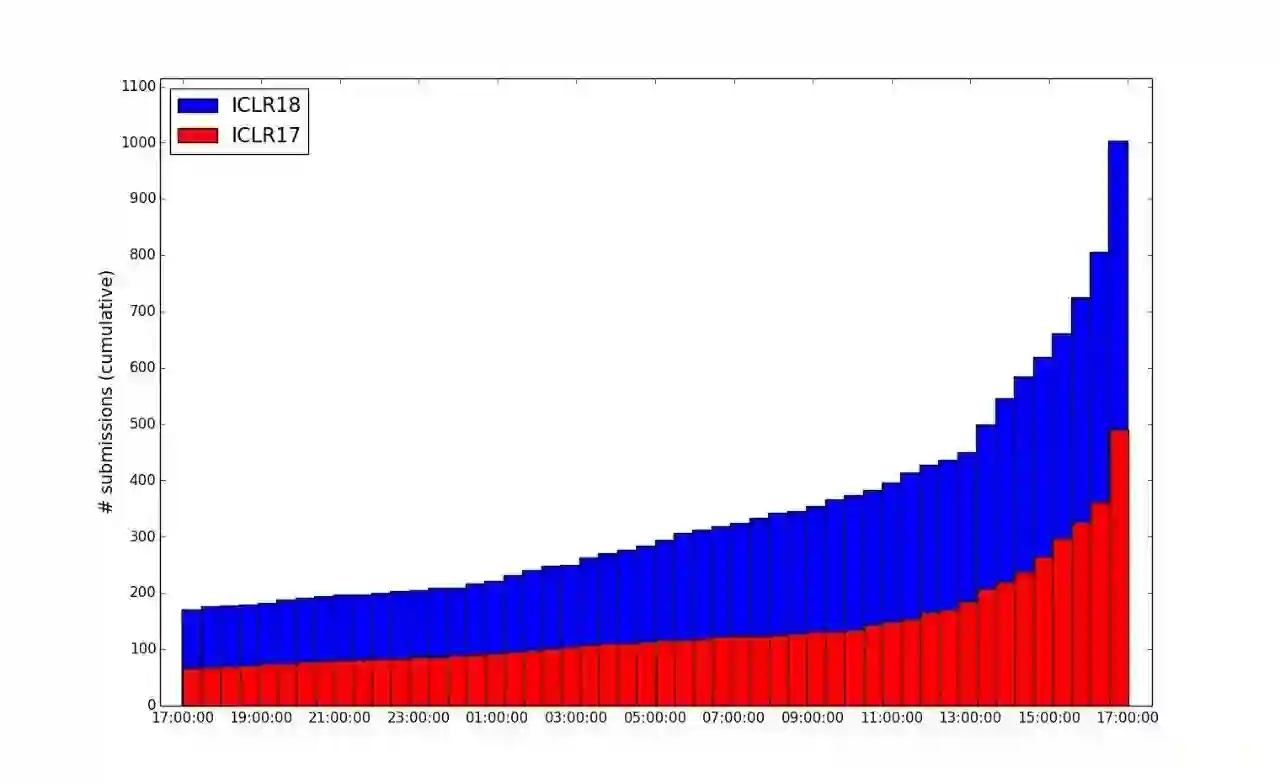

ICLR 2018的论文投递于10月27日截止。论文的提交情况充分表明学者们本着精益求精的精神直到最后时刻还在修改完善论文。在最后一天(截止时刻前24小时),论文提交量由不足200篇暴增至1003篇,其中有200多篇论文是最后半小时提交的。

从上图也可以看出,ICLR 2018的论文提交量相比ICLR 2017翻倍了,充分体现了深度学习领域热度的提高。以及拖延症从去年一直流行到了今年

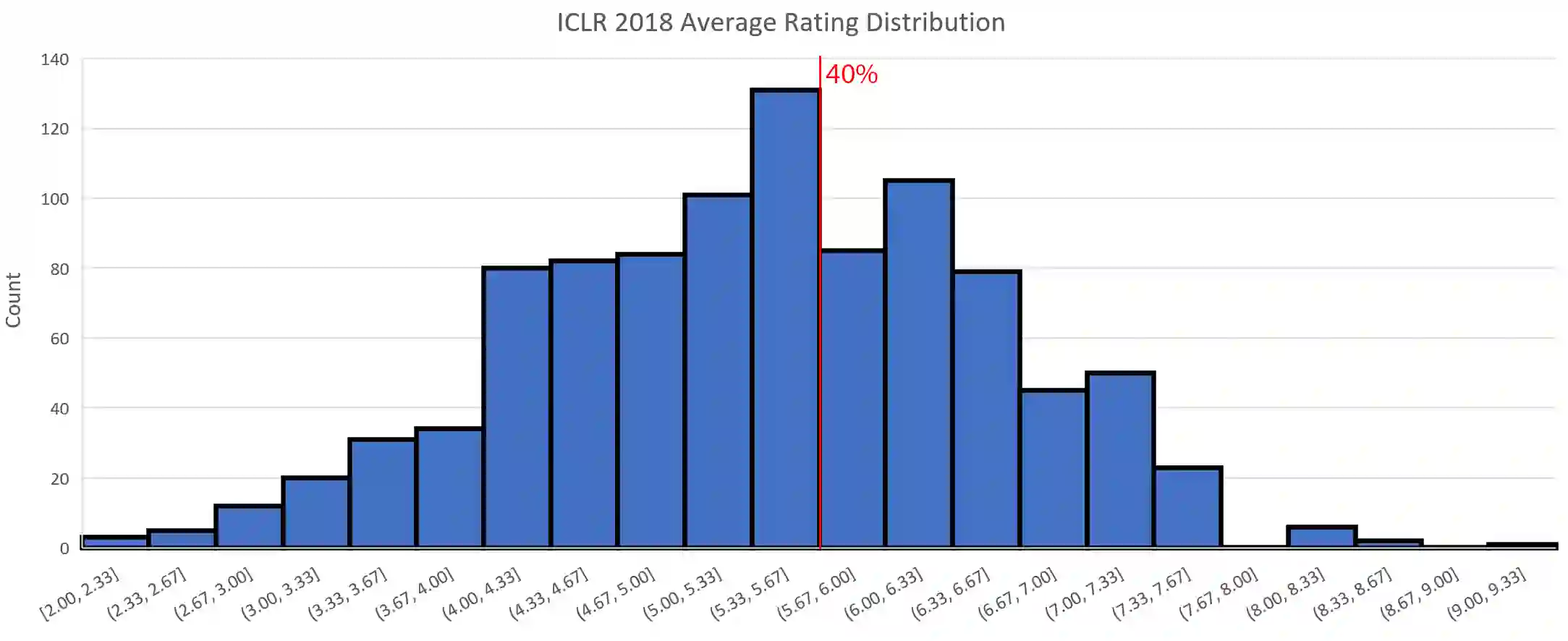

在提交的1003篇论文中,有效提交共981篇。评审已于2017年11月27日结束,但并不是所有评分都公布了。到2017年12月1日为止,共有979篇论文获得了至少一个评分。

ICLR评分分布

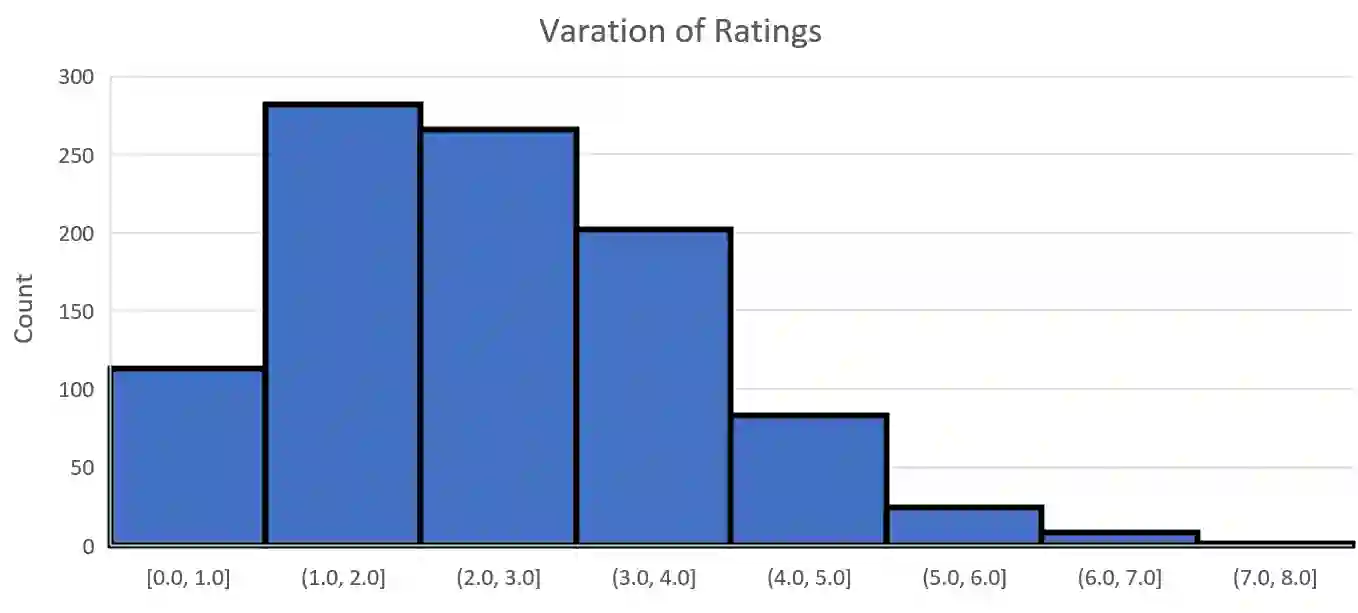

对于大多数论文(87%)而言,最高评分与最低评分之间的分差不超过3分。由此可见,在深度学习领域,学术共同体的分歧并不是特别大。

同篇论文最高分与最低分之间分差的分布

十佳论文

1. Certifiable Distributional Robustness with Principled Adversarial Training

提出了一种高效明确的敌对训练过程,在训练数据扰动剧烈的情况下仍能保证计算和统计的性能。

匿名评审意见节选:

本文提出了一个将分布鲁棒性引入神经网络训练的明确方法,以减轻对抗样本的影响。这个想法是训练一个模型,该模型的训练不仅考虑其在未知分布上的表现,同时考虑其在最坏分布上的表现。(AnonReviewer2)

本文应用了鲁棒优化文献中最近发展出来的想法,具体来说,使用Wasserstein度量进行分布鲁棒优化,并且表明在鲁棒性要求不太高的前提下,该框架对平滑损失函数的优化难度和原本不考虑对抗攻击的情形是一致的。我认为这个想法符合直觉,是合理的。虽然只有在鲁棒性要求较低的情形下才有效,但在实践中,这种情形比扰动严重的情形要常见得多。(AnonReviewer1)

2. On the Convergence of Adam and Beyond

我们研究了Adam、RMSProp等流行的优化算法的收敛性,并提出了这些方法的新变体,这些变体在凸优化中收敛到最优解,并且这样的收敛是可验证的。

匿名评审意见节选:

本文有三大贡献:一、它表明Adam算法收敛性的证明是错误的;二、它提出了对抗性例子和随机例子,Adam算法在这些例子上收敛的情况是最糟糕的,也就是说,我们不可能修正Adam算法的证明;三、它提出了一个Adam算法的变体(AMSGrad),该变体修正了原始Adam算法证明中的问题,而且看起来具有良好的经验性质。(AnonReviewer1)

本文指出了Adam算法收敛性现有证明中的一个错误,Adam算法是深度学习中最流行的算法之一。此外,它还举出了一个简单的一维反例,Adam算法在上面无法收敛。这一问题也存在于RMSprop算法(RMSprop算法可以看成是Adam算法的一个不带动量的特殊情形)。(AnonReviewer3)

3. Emergence of grid-like representations by training recurrent neural networks to perform spatial localization

在训练用于导航任务的循环神经网络过程中,涌现了空间的神经表示(大脑中的类网格细胞和边缘细胞)。

匿名评审意见节选:

本文通过训练用于导航任务的循环神经网络,更好地理解了内嗅皮质中的网格细胞的功能定位。

这是我看到的第一篇提出网格细胞是因导航任务而产生的论文。(AnonReviewer2)

4. Multi-Scale Dense Networks for Resource Efficient Image Classification

本文研究了测试网络计算资源受限条件下的图像分类问题。与目前最先进的框架相比,本文提出的二维多尺度卷积神经网络架构的表现显著提示了。

匿名评审意见节选:

本文考虑了单张图像分类有单独的时间限制和分类一组图像有一个总的时间限制两种情况。本文使用了在深度和尺度上进行对角传播的卷积神经网络结构,因而每个激活映射是通过一些特征间的密集连接构建的,这些连接既可以是相同尺度的特征之间的,也可以是与更精细尺度上的特征之间的。这样就可以快速构建粗尺度的映射,然后不断通过低层和更精细的尺度的前向传播进行更新,因而可以用于任何中间阶段的图像分类。模型的评估在ImageNet和CIFAR-100上进行。(AnonReviewer1)

模型基于多尺度的卷积神经网络,这个架构与Saxena和Verbeek于2016年提出的neural fabric有些类似,但是使用了Huang等人于2017年提出的密集连接,并且在每一层上都配备了分类器。对于给定的输入图像而言,多分类器允许精细地选择需要的计算量。多尺度的表示改善了网络前期的表现。最后,密集连接可以减少前期分类器对特征表示的负面效果,使得后面的网络层能充分发挥效果。(AnonReviewer3)

5. i-RevNet: Deep Invertible Networks

普遍认为,深度卷积网络的成功是建立在逐渐丢弃和当前问题无关的输入差异基础上的。本文表明这种信息的损失并不是必须的。本文通过层叠的同胚层构建了一个完全可逆的i-RevNet网络,换句话说,这个网络没有丢弃信息。

匿名评审意见节选:

作者的架构基于Gomez等人于2017提出的可逆残差网络(RevNet)和Shi等人于2016年提出的可逆降采样算子。网络的逆(分类)路径使用与正向(重建)路径相同的卷积。它还在输出运算中使用减法代替加法,以便重建中间层和输入层。

作者报告了ILSVRC-2012验证集上的top-1错误率,以表明他们的方法在大规模分类问题上是有效的。模型得到了与原始的Resnet及RevNet模型相当的结果。然而,新模型在参数预算方面是昂贵的,因为它需要比RevNet和Resnet架构多6.5倍的参数。不过,分类和重建的结果仍然令人印象深刻,因为该工作是第一个实践上的证据,证实了在大规模分类任务中学习可逆表示(可逆表示保存了输入相关信息)是可能的。(AnonReviewer1)

6. Learning to Represent Programs with Graphs

程序的一些结构可以表示为图,神经网络可以学习这些图来查找bug。

匿名评审意见节选:

这篇论文展示了一个机器学习的创新应用,在程序的AST上使用图神经网络,检测错误变量使用和基于上下文环境预测变量名。这一模型在二千九百万行(SLOC)规模的代码上得到了验证。(AnonReviewer1)

核心想法是将程序表示为图,GGNN(Gated Graph Neural Nets)可以将图作为输入,然后训练GGNN进行依赖于上下文语义的token级别的预测。(AnonReviewer3)

很高兴看到这个方法速度很快——看起来快到可以用在真实的IDE环境中。(AnonReviewer2)

7. Boosting Dilated Convolutional Networks with Mixed Tensor Decompositions

我们引入了一个新的概念——混合张量分解(mixed tensor decompositions),并使用它证明了相互连通的扩张卷积网络提升了其表达能力。

匿名评审意见节选:

作者研究了扩张卷积网络,表明在不同阶段连通两个扩张卷积网络(通过混合张量分解将其形式化)增加了其表达能力。(AnonReviewer1)

现有的研究更多关注网络的深度,并确定了更深的网络相比较浅的网络更富表达力。相反,本文关注连通性这一架构特征。这是一个重要的基础性问题,其理论的发展也是坚实的。在开发深度网络设计的新工具方面,这个结论很有用。(AnonReviewer3)

8. Stabilizing Adversarial Nets with Prediction Methods

我们提出了一个针对交替SGD方法的简单修改,称为预测步骤,提高了对抗网络的稳定性。

匿名评审意见节选:

无论是从直觉上来说,还是从数学上来说,本文提出的方法都具有非常清晰的动机。同时,作者提供了其收敛性表现的理论保证。我特别喜欢那个谐振子的类比。(AnonReviewer2)

9. Continuous Adaptation via Meta-Learning in Nonstationary and Competitive Environments

一个简单的基于梯度的元学习算法,用于适应动态变化的对抗情境。表明元学习的适应性最强。

论文的想法是将非稳定任务作为一个稳定任务序列,并训练代理利用序列任务间的关系,以便在测试时能应付非稳定性。(AnonReviewer2)

10. Wasserstein Auto-Encoders

提出了一个基于Wasserstein距离的自动编码器,改善了VAE(Variational Auto-Encoder,变分自动编码器)的取样特性。

这篇精心撰写的论文填补了W-GAN和VAE之间的空白。对于非该领域专家的评审者而言,它的可读性很强。(AnonReviewer1)

自动编码器采用最大传输的双正则化设计,论文提出的工作在同一个框架下同时支持了确定性和随机的解码器。在我看来,这是本论文至关重要的贡献之一。(AnonReviewer3)

搜索和下载

ICLR官方的openreview.net仅可搜索论文的标题、摘要,不过我们可以使用iclr2018.smerity.com进行全文搜索。

后台留言“iclr2018”可打包下载十佳论文。