加入极市专业CV交流群,与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度 等名校名企视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

或许 Jürgen Schmidhuber 无休止的论战可以告一段落了!

自 2018 年图灵奖授予 Yoshua Bengio、Geoffrey Hinton 和 Yann LeCun 三位深度学习先驱之后,LSTM 之父 Jürgen Schmidhuber 就此在社交网络上展开了一波又一波的论战,极力肯定和推广长短期记忆网络(LSTM)在人工神经网络和深度学习领域的巨大作用。

如今,LSTM 终于获得了学界的认可。

近日,奥地利人工智能高级研究所(IARAI)宣布其创始人、LSTM 提出者和奠基者 Sepp Hochreiter 教授获得了 IEEE CIS 2021 年神经网络先驱奖(Neural Networks Pioneer Award),以表彰他对长短期记忆网络(LSTM)的发展做出的卓越贡献。

曾获 2016 年神经网络先驱奖的 Jürgen Schmidhuber 也表达了对 Sepp Hochreiter 教授的祝贺。

该奖项开始于 1991 年,由 IEEE 计算智能协会(CIS)每年颁发一次,主要授予那些对神经网络领域的早期概念和持续性发展做出突出贡献的学者。具体而言,该奖项主要表彰以下两种类型的开创性贡献:(1)根本性理解和(2)工程应用。

获奖者可以是个人,也可以是不超过 3 人的团体,获奖者通过发明新技术、取得创新性技术发展、实现新产品或者管理创新性产品设计或生产流程,进而对神经网络的理论、技术和应用发展做出贡献。

在历届 IEEE 神经网络先驱奖获得者中,我们可以看到很多熟悉的大佬,例如 2018 年图灵奖得主、深度学习三巨头 Yoshua Bengio(2019)、Yann LeCun(2014)和 Geoffrey Hinton(1998)。

此外,获奖者中也不乏华人。2014 年,时任香港中文大学教授的 Jun Wang 与 Yann LeCun 共同获得了当年的神经网络先驱奖,以表彰其在神经动力优化方面做出的突出成就。

图源:https://www.erg.cuhk.edu.hk/erg/node/81

接下来,我们具体来看本年度 IEEE 神经网络先驱奖获得者 Seep Hochreiter 在神经网络领域都做了哪些突出贡献。

1967 年,Sepp Hochreiter 出生于德国米尔多夫,是一位计算机科学家。从 2006 年到 2018 年,他领导了生物信息研究所。2018 年以来,他又领导了约翰 · 开普勒林茨大学(JKU)的机器学习研究所。2017 年,他成为林茨理工学院(LIT)AI 实验室的负责人,该实验室致力于推进人工智能的研究。

Sepp Hochreiter 在机器学习、深度学习和生物信息学领域都做出了巨大的贡献。Sepp Hochreiter 在 1997 年与 Jürgen Schmidhuber 联合发表了长短期注意(LSTM)的论文,被认为是机器学习发展史上的一座里程碑。深度学习的基础就是基于 Sepp Hochreiter 对梯度消失和梯度爆炸的分析构建的。

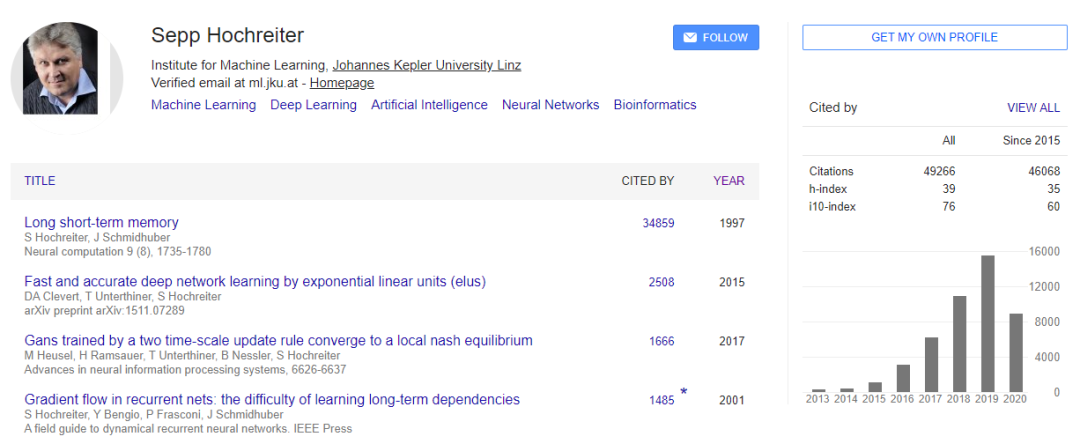

在谷歌学术上,Seep Hochreiter 的 LSTM 论文被引量已经近 35000。

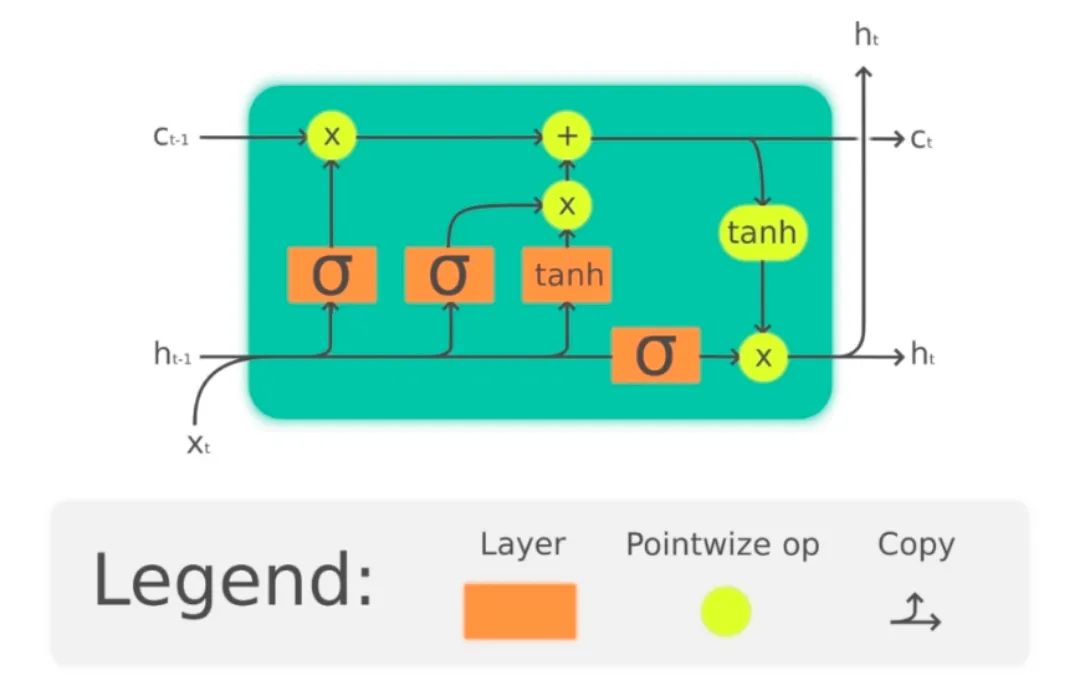

LSTM 是一种特殊的循环神经网络(RNN),Sepp Hochreiter 在 1991 年分析了随时间反向传播(BPTT)带来的梯度爆炸和梯度消失问题。1997 年,Sepp Hochreiter 与 Jürgen Schmidhuber 在 LSTM 论文中引入 CEC 单元解决 BPTT 带来的梯度爆炸和消失问题。之后又有许多研究者对其进行了改进和普及。

LSTM 单元基本结构,图源:https://en.wikipedia.org/wiki/Long_short-term_memory

此外,Sepp Hochreiter 提出了平滑的极小值(flat minima)作为学习人工神经网络的首选解决方案,以确保有较低的泛化误差。他还为神经网络提出了新的激活函数以改进学习,比如指数线性单元(ELU)。Sepp Hochreiter 在强化学习和支持向量机(SVM)方面也做出了贡献。

https://www.iarai.ac.at/news/sepp-hochreiter-receives-ieee-cis-neural-networks-pioneer-award-2021/

https://cis.ieee.org/getting-involved/awards/past-recipients#NeuralNetworksPioneerAward

推荐阅读

![]()

添加极市小助手微信

(ID : cv-mart)

,备注:

研究方向-姓名-学校/公司-城市

(如:目标检测-小极-北大-深圳),即可申请加入

极市技术交流群

,更有

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、

干货资讯汇总、行业技术交流

,

一起来让思想之光照的更远吧~

觉得有用麻烦给个在看啦~

![]()