报告题目: Attention in Deep learning

摘要:

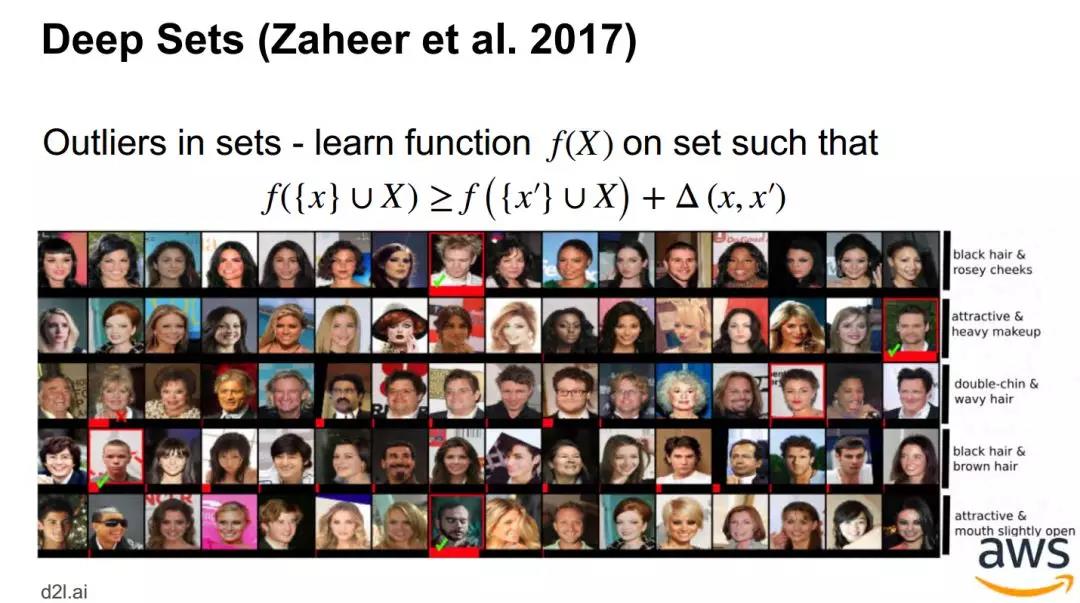

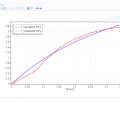

注意力是非参数模型在深度学习中的关键机制。可以说,这是深度学习模型最新进展的基础。除了在神经机器翻译中介绍,它还可以追溯到神经科学。并且可以说是通过LSTMs的门控或遗忘机制引入的。在过去的5年里,注意力一直是推动自然语言处理、计算机视觉、语音识别、图像合成、解决旅行推销员问题或强化学习等领域的技术发展的关键。本教程对各种注意事项提供了一个连贯的概述,让其亲身体验如何复制和应用注意力机制,并且更深入地了解潜在的理论,详细展示了从最早的NWE到最新的Multiple Attention Heads的相关内容。

报告主要分为六个部分:

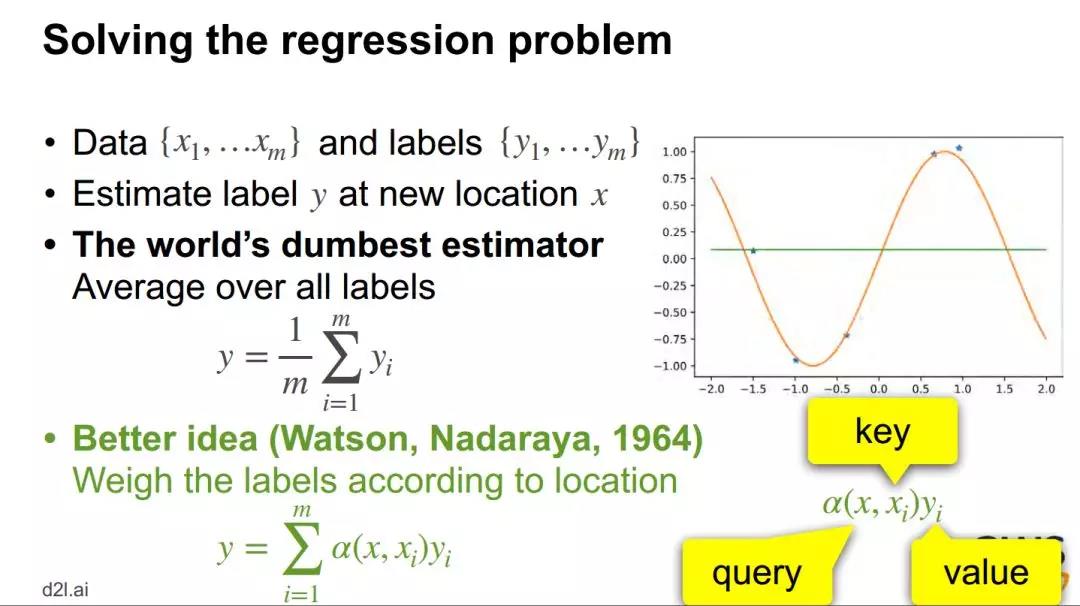

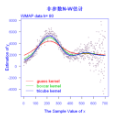

- Watson Nadaraya Estimator(NWE):最早的非参数回归(Nonparametric Regression)的工具之一,更具体地说是最早核回归技术(Kernel Regression Technique)由Nadaraya和Watson两人同时于1964年独立的提出。

- 池化 Pooling

- 单目标 - 从池化 pooling 到注意力池化 attention pooling

- 层次结构 - 分层注意力网络 Hierarchical attention network

- 迭代池化 Iterative Pooling

- 问答 Question answering / 记忆网络 memory networks

- 迭代池化与生成器 Iterative Pooling and Generation

- 神经机器翻译

- 多头注意力网络 Multiple Attention Heads

- Transformers / BERT

- Lightweight, structured, sparse

- 资源

邀请嘉宾:

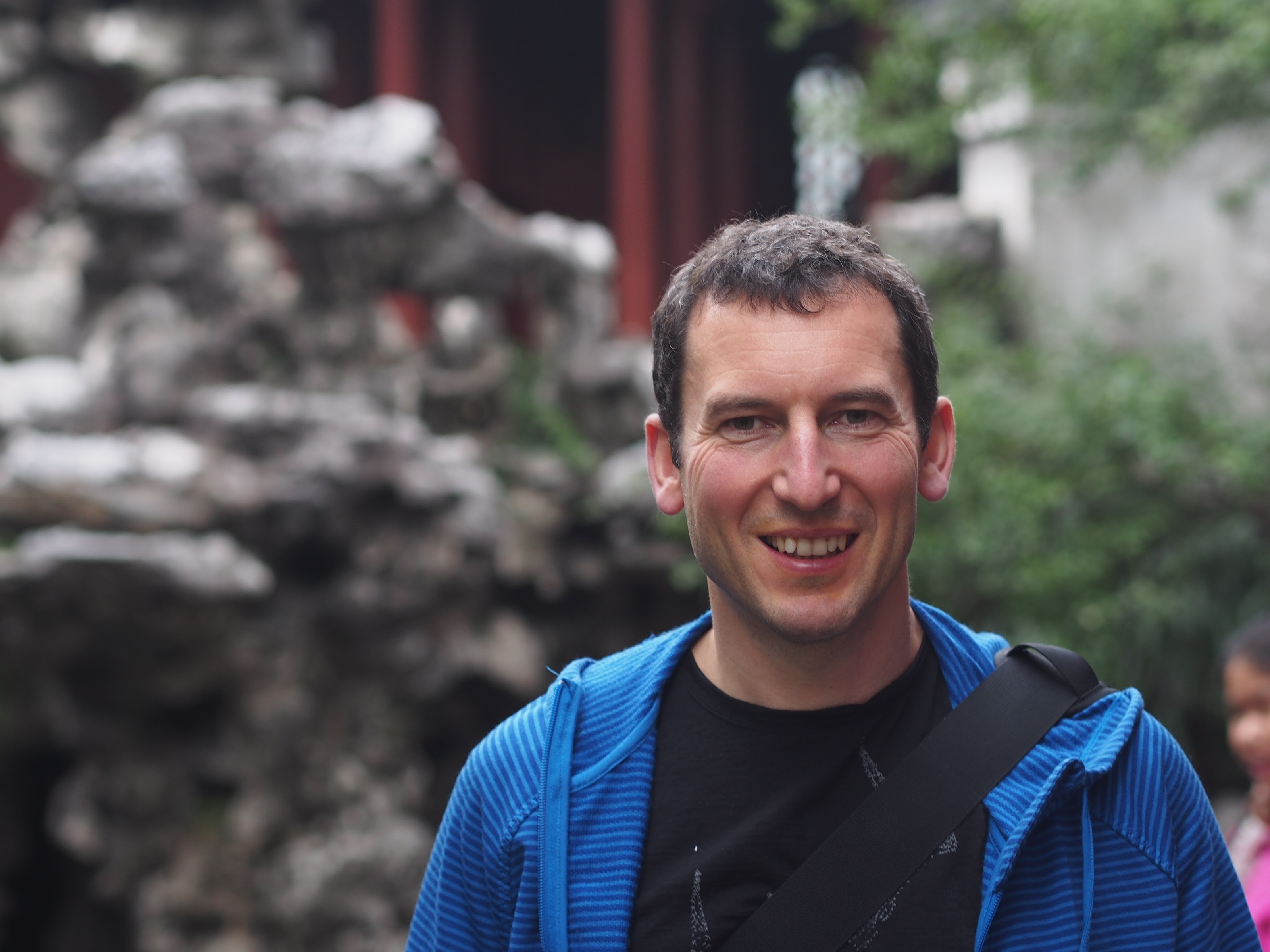

Alexander J. Smola是亚马逊网络服务总监,2016年7月,加入了亚马逊网络服务(Amazon Web Services),打造人工智能和机器学习工具。主要研究兴趣包括深度学习:特别是状态更新、不变性和统计测试的算法;算法的可伸缩性、统计建模。

Aston Zhang是亚马逊网络服务人工智能的一名应用科学家。他的研究兴趣是深度学习。他在伊利诺伊大学香槟分校获得了计算机科学博士学位。他曾担任大数据前沿的编委会成员和ICML、NeurIPS、WWW、KDD、SIGIR和WSDM的项目委员会成员(审稿人)。他的书《深入学习》(Dive into Deep Learning)于2019年春季在加州大学伯克利分校(UC Berkeley)教授,并已被全世界用作教科书。

成为VIP会员查看完整内容

相关内容

专知会员服务

106+阅读 · 2019年12月11日

Arxiv

21+阅读 · 2018年12月25日

Arxiv

13+阅读 · 2018年1月6日