阿里达摩院最新《时间序列Transformer建模》综述论文

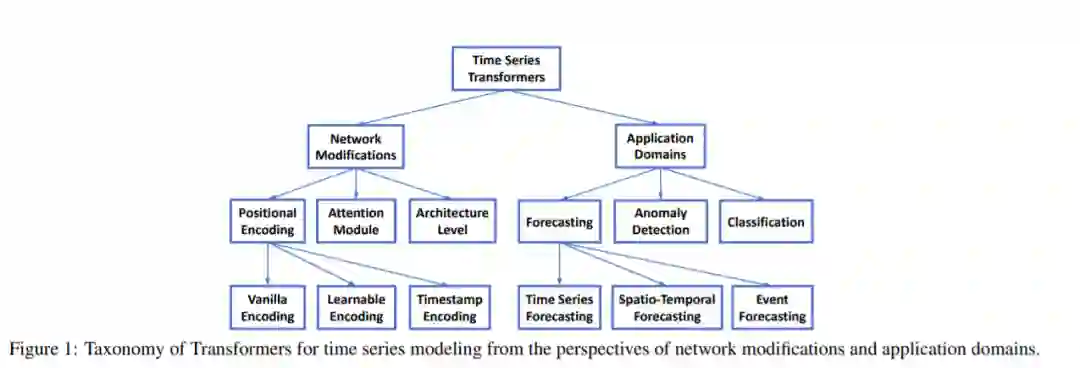

Transformers在自然语言处理和计算机视觉的许多任务中都取得了卓越的性能,这也引起了时间序列社区的极大兴趣。在Transformer的众多优点中,捕获长期依赖关系和交互的能力对时间序列建模特别有吸引力,这使得各种时间序列应用取得了令人兴奋的进展。在本文中,我们系统地回顾了用于时间序列建模的Transformer方案,通过一个新的分类,从两个角度总结了现有的时间序列Transformer,突出了它们的优势和局限性。从网络改造的角度,总结了时间序列Transformers的模块级适应性和体系结构级适应性。从应用的角度出发,我们根据预测、异常检测和分类等常用任务对时间序列Transformer进行分类。根据经验,我们执行稳健分析、模型规模分析和季节性趋势分解分析,以研究《Transformers》在时间序列中的表现。最后,我们讨论并提出未来的研究方向,以提供有用的研究指导。

https://www.zhuanzhi.ai/paper/8f0056e334c5add24b42ee4e57763f50

由于Transformer在自然语言处理(NLP) [Kenton and Toutanova, 2019]、计算机视觉(CV) [Dosovitskiy et al., 2021]、语音处理[Dong et al., 2018]和其他学科[Chen et al., 2021b]方面的出色表现,其在深度学习方面的创新[Vaswani et al., 2017]最近引起了极大的兴趣。在过去的几年中,许多Transformer的变种被提出,以大大提高各种任务的最先进的性能。不同方面的文献综述较多,如NLP应用方面的文献[Qiu et al., 2020;Han et al., 2021], CV applications [Han et al., 2020;Khan等人,2021年;Selva等人,2022年)、高效Transformer [Tay et al., 2020]和注意力模型[Chaudhari et al., 2021; Galassi et al., 2020]。

在时序数据的长距离依赖和交互中,transformer表现出了很强的建模能力,因此在时间序列建模中很有吸引力。由于时间序列数据和时间序列任务的特殊特性,许多Transformer的变体被提出以适应各种时间序列任务中的时间序列数据,如预测[Li et al., 2019; Zhou et al., 2021; Zhou et al., 2022],异常检测[Xu et al., 2022; Tuli et al., 2022],分类[Zerveas et al., 2021; Yang et al., 2021],等等。例如,季节性或周期性是时间序列的一个重要特征[Wen等人,2021a],如何有效地建模长期和短期的时间相关性,并同时捕获季节性仍然是一个挑战[Wu et al., 2021; Zhou et al., 2022]。由于Transformer for time series是深度学习领域的一个新兴领域,对Transformer for time series进行系统、全面的研究将对时间序列学界大有裨益。我们注意到,存在一些关于时间序列深度学习的综述,包括预测[Lim和Zohren, 2021;Benidis等人,2020年;Torres et al., 2021],分类[Ismail Fawaz et al., 2019], anomaly detection [Choi et al., 2021; Blazquez-Garc ´ ´ıa et al., 2021]和数据增强[Wen et al., 2021b],但很少或没有对时间序列的Transformers 进行深入分析。

在本文中,我们旨在通过总结现有的时间序列Transformers来填补上述空白。具体来说,我们首先简要介绍了普通的Transformer,然后从网络修改和应用领域的角度提出了一种新的时间序列Transformer分类。对于网络修改,我们考虑了针对时间序列数据优化的transformer的低层模块调整和高层架构改进。在应用方面,我们总结和分析了用于流行时间序列任务的transformer,包括预测、异常检测和分类。对于每个时间系列的《Transformers》,我们都分析了它的见解、优势以及局限性。为了提供如何在时间序列中使用transformer的实用指南,我们进一步对时间序列transformer进行了一些实证研究,包括稳健性分析、模型规模分析和季节趋势分解分析。最后,我们提出并讨论未来可能的发展方向,包括时间序列Transformers的归纳偏差,时间序列Transformers和GNN,时间序列Transformers的预训练,以及时间序列Transformers和NAS。据我们所知,本文是第一次全面系统地总结了Transformers在时间序列数据建模方面的最新进展。我们希望这个综述将点燃对时间系列Transformers的进一步研究兴趣。

https://arxiv.org/abs/2202.07125

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“TTS” 就可以获取《阿里巴巴发布最新《时间序列Transformer建模》综述论文》专知下载链接