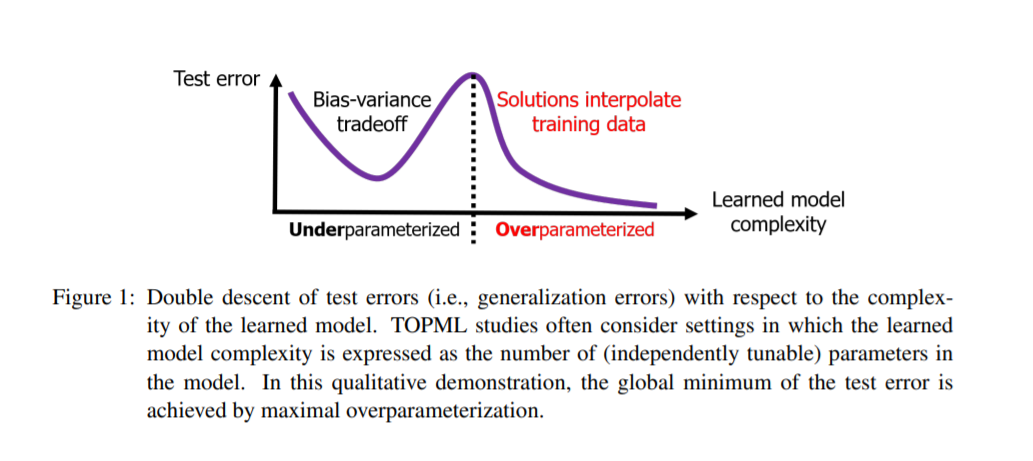

机器学习(ML)最近的快速进展提出了一些科学问题,挑战了该领域长期存在的教条。最重要的谜题之一是过度参数化模型的良好经验泛化。过度参数化的模型对于训练数据集的大小来说过于复杂,这导致它们完美地拟合(即插值)训练数据,而训练数据通常是有噪声的。这种对噪声数据的插值传统上与有害的过拟合有关,但最近观察到,从简单的线性模型到深度神经网络的各种插值模型在新测试数据上都能很好地泛化。事实上,最近发现的双下降现象表明,在测试性能上,高度过度参数化的模型往往比最好的欠参数化模型更好。理解这种过度参数化的学习需要新的理论和基础的实证研究,即使是最简单的线性模型。这种理解的基础已经在最近对过度参数化线性回归和相关统计学习任务的分析中奠定,这导致了双下降的精确分析特征。本文简要概述了这一新兴的过度参数化ML理论(以下简称为TOPML),并从统计信号处理的角度解释了这些最新发现。我们强调将TOPML研究领域定义为现代ML理论的一个子领域的独特方面,并概述了仍然存在的有趣的未决问题。

https://www.zhuanzhi.ai/paper/182ad6c4b994aa517d10319504e9bb3a

引言

深度学习技术已经彻底改变了许多工程和科学问题的解决方式,使数据驱动方法成为实践成功的主要选择。当前的深度学习方法是经典机器学习(ML)设置的极限开发版本,以前这些设置受到有限的计算资源和训练数据可用性不足的限制。目前已建立的实践是从一组训练示例中学习高度复杂的深度神经网络(DNN),这些示例虽然本身很大,但相对于DNN中的参数数量来说相当小。虽然这种过度参数化的DNN在ML实践中是最先进的,但这种实际成功的根本原因仍不清楚。特别神秘的是两个经验观察结果: 1) 模型中添加更多参数的明显益处(在泛化方面),2) 这些模型即使完美地拟合了噪声训练数据,也能很好地泛化。这些观察结果在现代ML的不同结构中都得到了体现——当它们首次被用于复杂的、最先进的DNN时(Neyshabur et al., 2014; Zhang et al., 2017)),它们已经在更简单的模型家族中出土,包括宽神经网络、核方法,甚至线性模型(Belkin et al., 2018b; Spigler et al., 2019; Geiger et al., 2020; Belkin et al., 2019a)。

在本文中,我们综述了最近发展起来的过度参数化机器学习理论(简称TOPML),该理论建立了与训练数据插值(即完美拟合)相关的现象相关的基本数学原理。我们很快将提供一个过度参数化ML的正式定义,但在这里描述一些模型必须满足的显著属性,以合格为过度参数化。首先,这样的模型必须是高度复杂的,因为它的独立可调参数的数量要远远高于训练数据集中的示例数量。其次,这样的模型绝不能以任何方式被明确地规范化。DNN是过度参数化模型的常见实例,这些模型通常没有明确的正则化训练(参见,例如,Neyshabur et al., 2014; Zhang et al., 2017)。这种过度参数化和缺乏显式正则化的组合产生了一个可插值训练示例的学习模型,因此在任何训练数据集上都实现了零训练误差。训练数据通常被认为是来自底层数据类(即噪声数据模型)的噪声实现。因此,插值模型完美地拟合了基础数据和训练示例中的噪声。传统的统计学习总是将噪声的完美拟合与较差的泛化性能联系在一起(例如,Friedman et al., 2001, p. 194);因此,值得注意的是,这些插值解决方案通常能很好地泛化到训练数据集以外的新测试数据。

在本文中,我们回顾了TOPML研究的新兴领域,主要关注在过去几年发展的基本原理。与最近的其他综述相比(Bartlett et al., 2021; Belkin, 2021),我们从更基本的信号处理角度来阐明这些原则。形式上,我们将TOPML研究领域定义为ML理论的子领域,其中1. 明确考虑训练数据的精确或近似插值 2. 相对于训练数据集的大小,学习模型的复杂性较高。

本文组织如下。在第2节中,我们介绍了过度参数化学习中插值解的基础知识,作为一个机器学习领域,它超出了经典偏方差权衡的范围。在第3节中,我们概述了最近关于过度参数化回归的结果。在这里,我们从信号处理的角度直观地解释了过度参数化学习的基本原理。在第4节中,我们回顾了关于过度参数化分类的最新发现。在第5节中,我们概述了最近关于过度参数化子空间学习的工作。在第6节中,我们考察了最近关于回归和分类以外的过度参数化学习问题的研究。在第7节中,我们讨论了过度参数化ML理论中的主要开放问题。