有人用YOLOv5和CLIP做了一个找图神器!搜图、裁剪一步到位!在线可试玩...

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

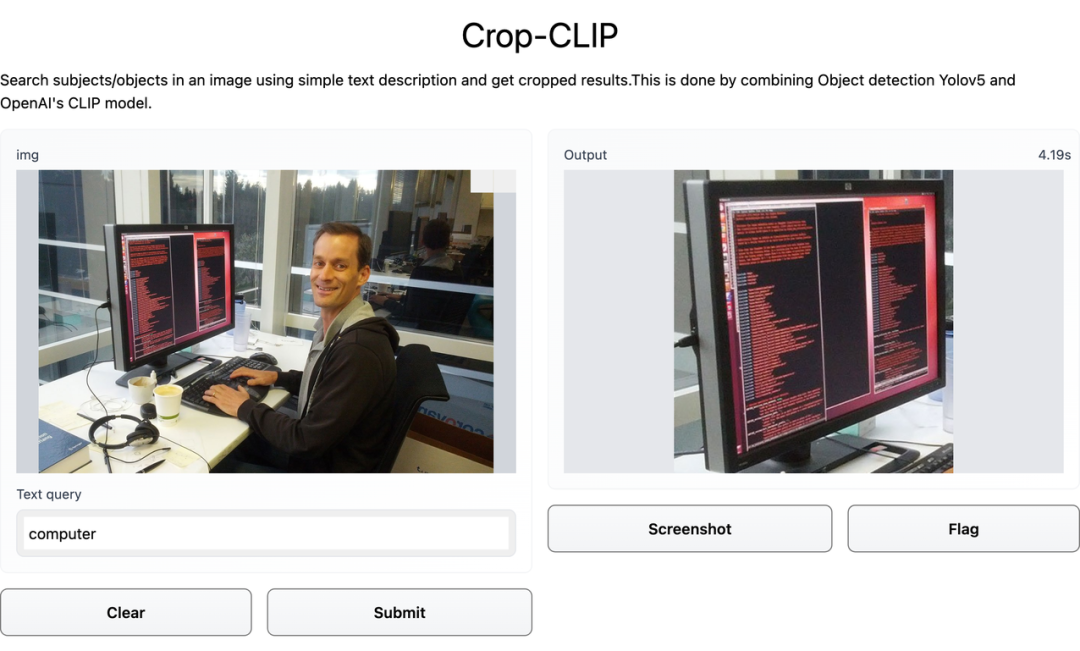

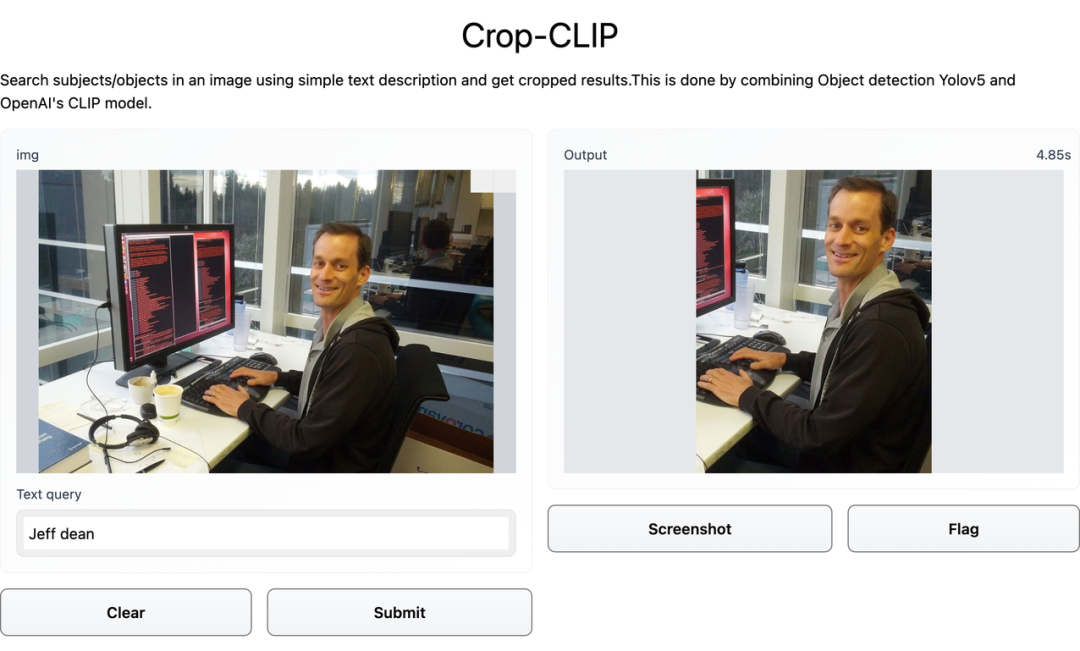

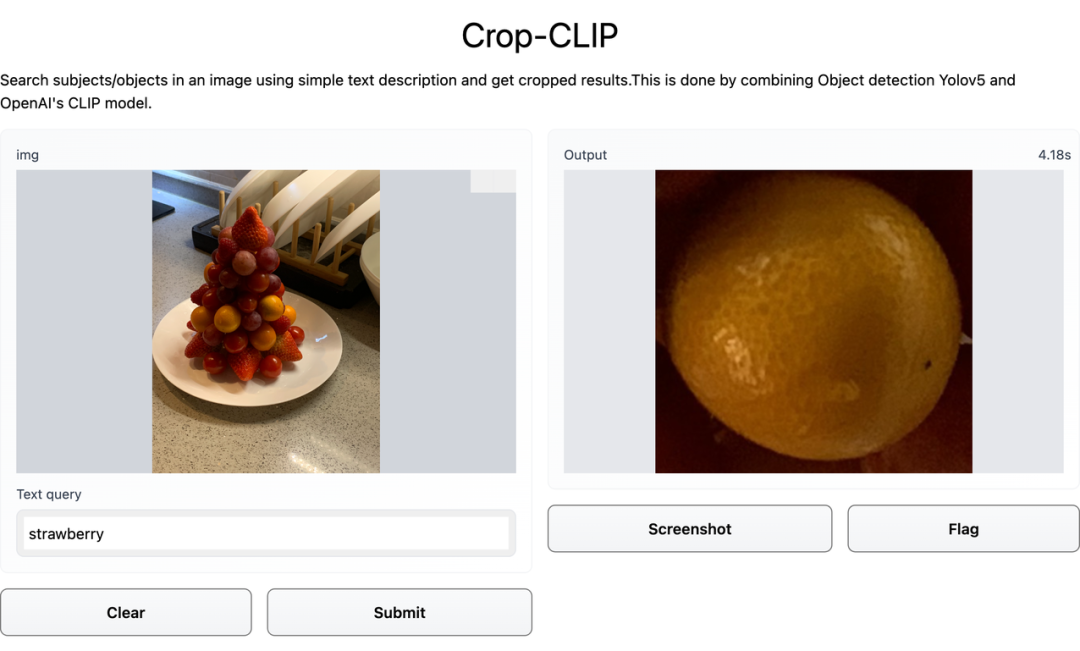

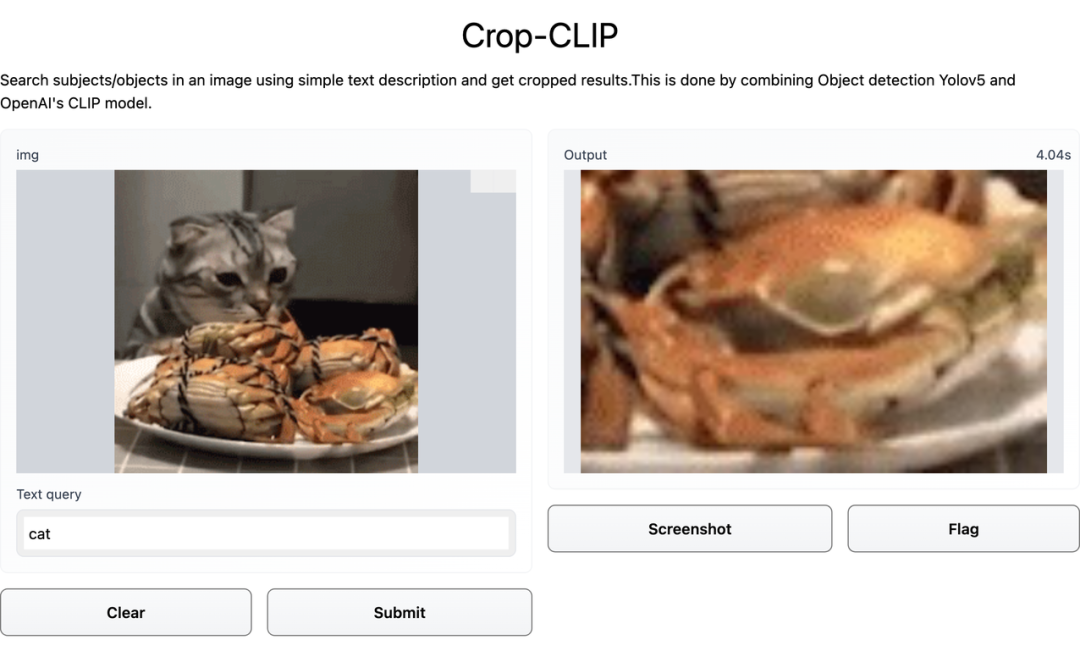

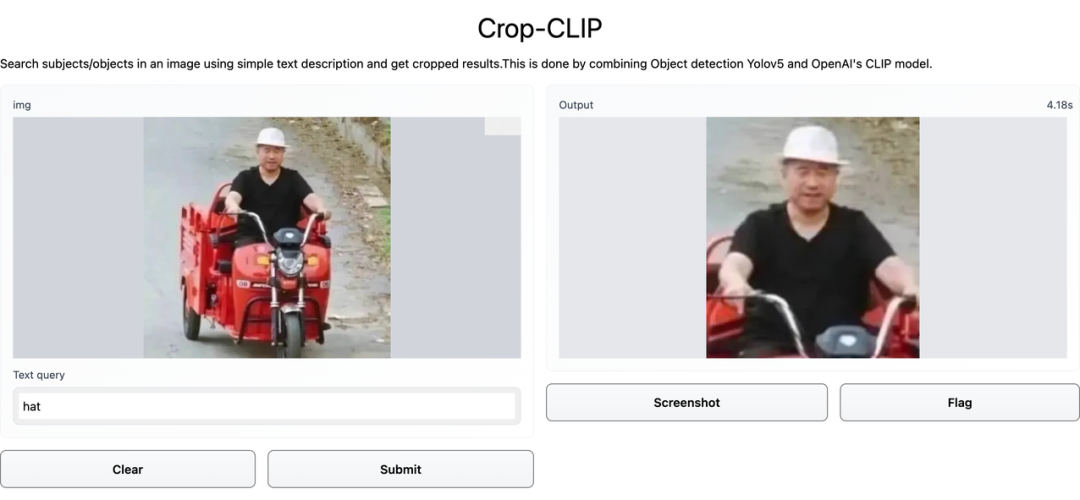

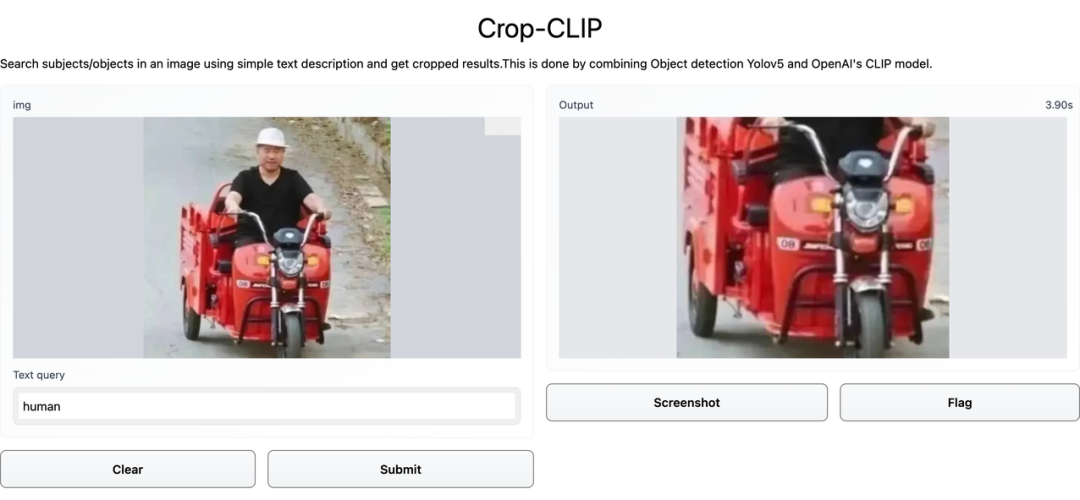

给 Crop-CLIP 一个口令,就能自动搜图,还能帮忙裁剪出图片中的关键部分。

项目地址:https://github.com/vijishmadhavan/Crop-CLIP

在线试用地址:https://huggingface.co/spaces/Vijish/Crop-CLIP

检测和裁剪对象 (yolov5s)

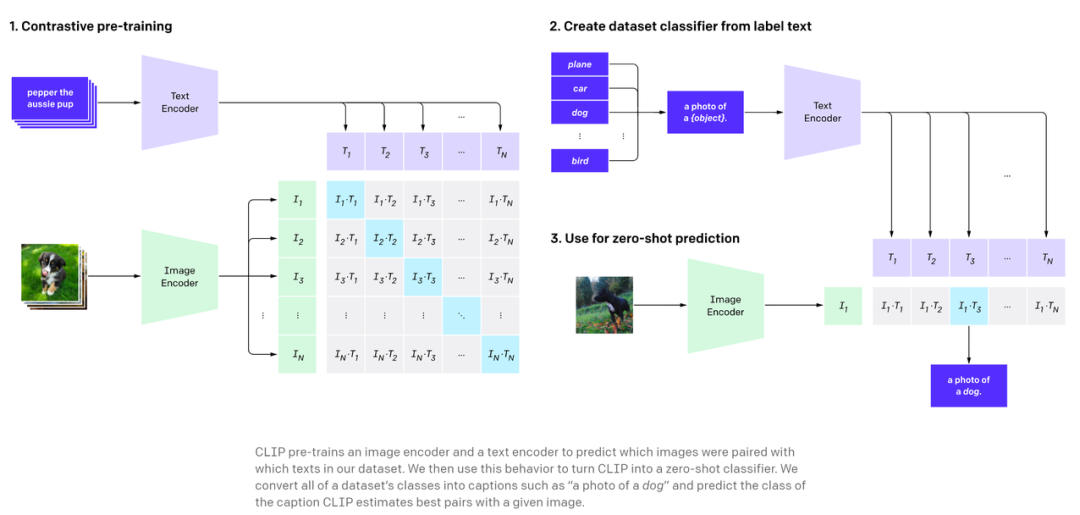

使用 CLIP 对裁剪后的图像进行编码

使用 CLIP 编码搜索查询

找到最佳匹配部分

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

CVer-Transformer交流群成立

扫码添加CVer助手,可申请加入CVer-Transformer 微信交流群,方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加小助手微信,进交流群

▲点击上方卡片,关注CVer公众号

登录查看更多

相关内容

Arxiv

1+阅读 · 2022年4月17日

Arxiv

0+阅读 · 2022年4月15日

Arxiv

0+阅读 · 2022年4月15日

Arxiv

18+阅读 · 2019年9月25日