【泡泡机器人】一文带你入门语义SLAM

传统SLAM定位继SLAM++,ORB-SLAM,LSD-SLAM等风起云涌之后(更多参见http://www.openslam.org/),似乎归于平静。之前知乎甚至有人称:SLAM已然做得尽头,已经没有太多可以扩展的余地。

高翔在《视觉SLAM14讲》369页指出:未来SLAM很大的一个方向是与深度学习结合,通过语义与SLAM相互结合,两者之间相互促进,相互补充。然而不幸的是,一直以来无论是知乎还是其他途径,都较少查到类似的资料。

传统SLAM主要解决的问题是:机器人在哪里,机器人要怎么走。但是没有回答:机器人周边环境的物体是什么,有什么特点。当然,这个问题随着万能的深度学习已经得到很好的解决,也有类似的文章发表,对典型的几篇文章做简要介绍。

(1)Meaningful Maps With Object-Oriented Semantic Mapping:start - Trung T. Pham作者官方主页,看作者这两年发的一堆论文,超大神。

其实作者的思路也比较简单:

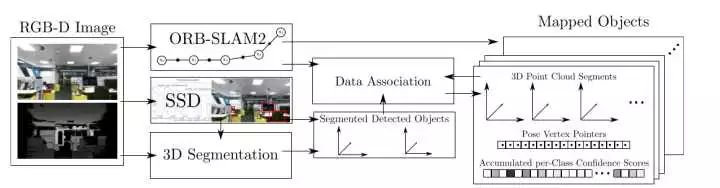

利用现在检测速度很快的SSD,以及基本上可以达到实时定位的ORB-SLAM2相互促进。然后通过把深度图进行划分,物体检测,最终输出带有语义信息的语义地图。个人觉得,本文的难点在数据的融合,也就是流程图的第三部分,两者之间怎么去相互配合。

其次本文作者比较谦虚的承认:为什么没有取名为语义SLAM,是因为该工作只是用SLAM促进分割,并没有用语义分割去促进定位。实际上两者应该是相辅相成的,只不过貌似后者还没有人做罢了。

本文在实时性和计算量应该算是比较合理的,一般GPU应该能跑起来;缺点是地图可读性比较差。

02

Semi-Dense 3D Semantic Mapping from Monocular SLAM

文章下载链接如下:https://www.baidu.com/link?url=kcEXflO8Re_2DuI1UBWn1D-CxBevkDy_a3ZLA1zZXEO7hoMPk-b6JOiYj1Fktb1p&wd=&eqid=c9a2dfe900002485000000065a1e67f2

东南大学的一个同学做的,算是参考文献就6页的神文,CVPR2016最佳论文之一。

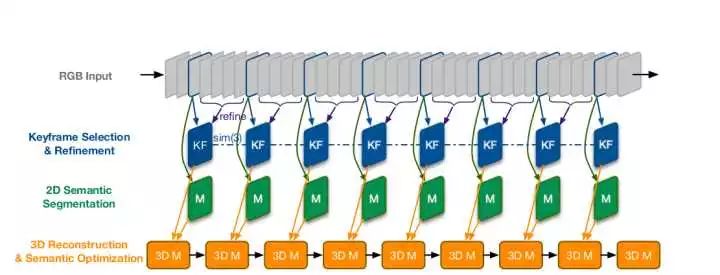

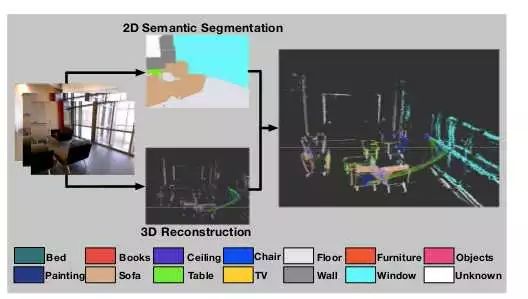

大致思路:利用LSD-SLAM作为框架,结合CNN进行有机融合,选择关键帧进行做深度学习实现语义分割,之后选择相邻的几帧做增强。

效果不错,但是我没有看出来他地图在哪里,而且不知道其在真正的大规模室外场景效果怎么样。

03

Probabilistic Data Association for Semantic SLAM

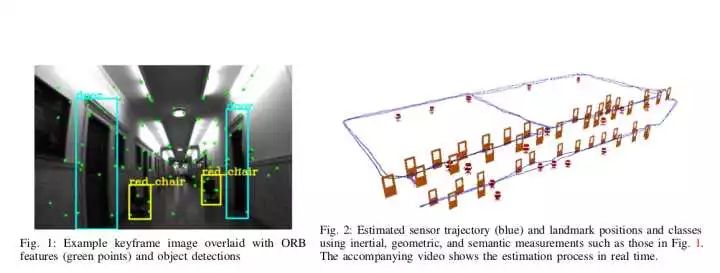

2017年ICRA论文,作者通篇是公式,没有找到源代码。

效果也还不错,然而论文没有给如何框架。

其他的,可以参见前几天的一篇中文综述《基于深度学习的视觉 SLAM 综述》,全文写得很烂,文末的参考文献值得一看。

以及今年机器人最顶会ICRA的论文

大概长这样,有差不多20多篇谈到SLAM与深度学习的结合。

如果你想下载上图中的精彩论文

可以点击上方【泡泡机器人SLAM】,关注公众号

回复关键字:语义SLAM

即可获得全部文章的下载链接

本文来自泡泡机器人成员的知乎回答

泡泡机器人公众号运营团队编辑发布

参与:Brad Lucas

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com