每日三篇 | 可视化神经网络损失曲面;BN层原理;频率无关词嵌入

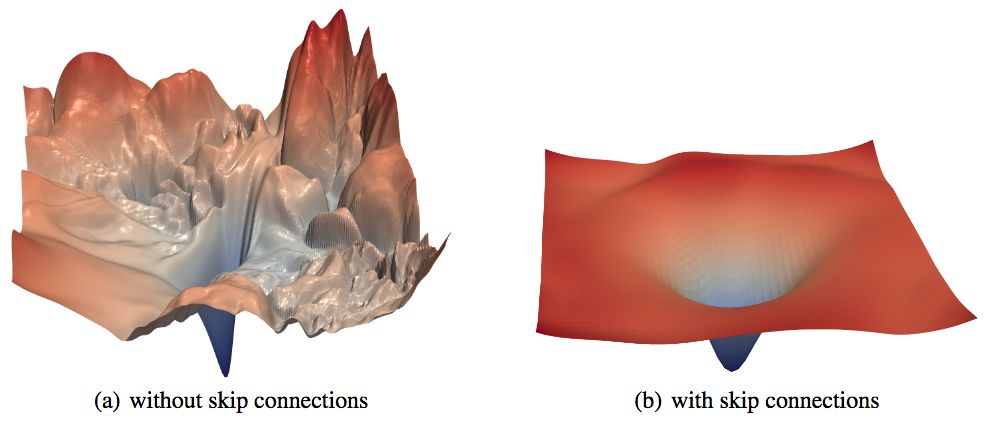

Visualizing the Loss Landscape of Neural Nets

Hao Li、Zheng Xu、Gavin Taylor、Christoph Studer、Tom Goldstein等在NIPS 2018上发表了可视化神经网络损失曲面的工作,通过可视化方法揭示了神经网络架构设计(例如跳层连接)和训练参数选择的作用。

地址:http://papers.nips.cc/paper/7875-visualizing-the-loss-landscape-of-neural-nets

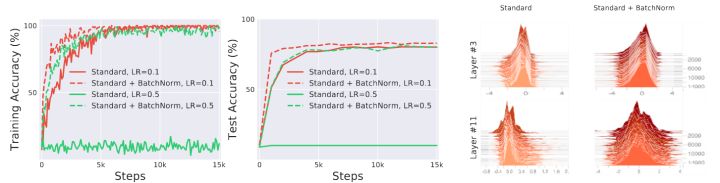

How Does Batch Normalization Help Optimization?

虽然BN(批归一化)现在已经是很常用的神经网络构件,但是关于它的理论研究其实还不怎么充分。提出BN的论文标题为Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift(批归一化:通过降低内部协方差偏移加速深度网络训练),但是BN降低内部协方差偏移这个观点很多人不怎么认可。MIT的Shibani Santurkar、Dimitris Tsipras等在NIPS 2018上口头报告的这篇论文主张,BN非但没有降低内部协方差偏移,反而增加了内部协方差偏移。BN之所以有效,是因为BN使损失平面更平滑了,和内部协方差偏移无关。

地址: http://papers.nips.cc/paper/7515-how-does-batch-normalization-help-optimization

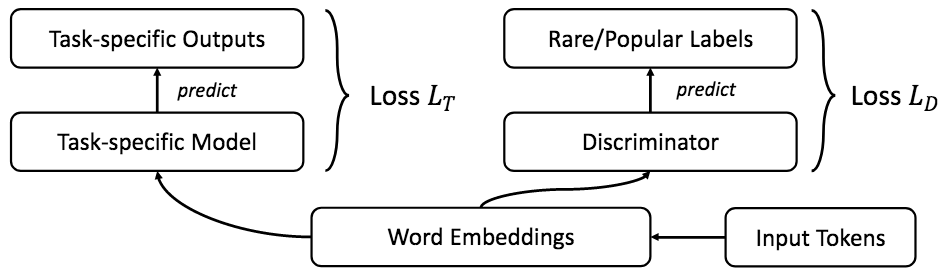

FRAGE: Frequency-Agnostic Word Representation

这项在NIPS 2018发布的北大和微软亚洲研究院的合作研究指出,当前在多种任务上学习到的词嵌入存在词频偏差:语义上相似的罕见词和常见词在嵌入空间中的距离可能很远。他们提出了一种简单而有效的对抗训练方法,通过模糊高频词嵌入和低频词嵌入的界限缓解这一问题。该方法在词相似性、语言建模、机器翻译、文本分类等自然语言处理任务上取得了超越基线的表现。

地址:http://papers.nips.cc/paper/7408-frage-frequency-agnostic-word-representation