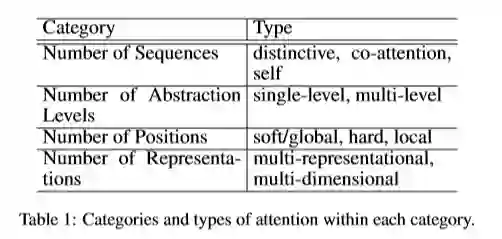

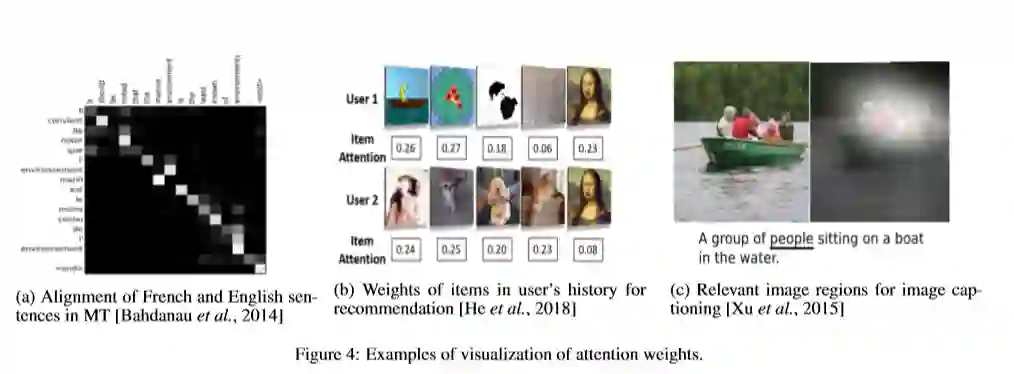

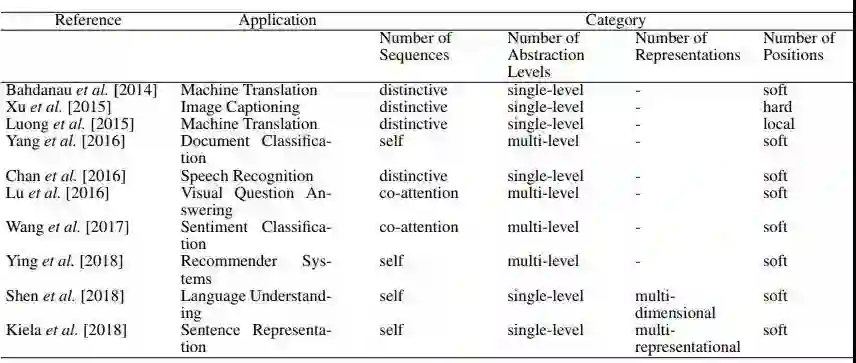

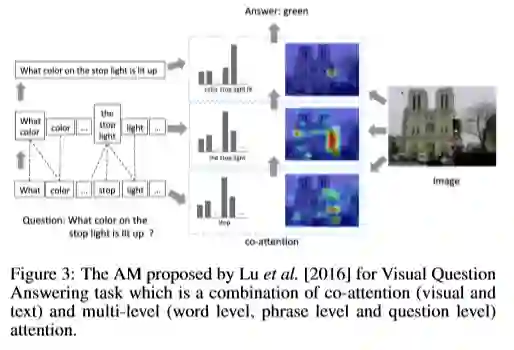

Attention模型目前已经成为神经网络中的一个重要概念,注意力模型(AM)自机器翻译任务【Bahdanau et al 2014】首次引入进来,现在已经成为主流的神经网络概念。这一模型在研究社区中非常受欢迎,适用领域非常广泛,包括自然语言处理、统计学习、语音和计算机视觉方面的应用。本篇综述提供了关于注意力模型的全面概述,并且提供了一种将现有注意力模型进行有效分类的分类法,调查了用于不同网络结构的注意力模型,并显示了注意力机制如何提高模型的可解释性,最后,讨论了一些受到注意力模型较大影响的应用问题。

成为VIP会员查看完整内容

相关内容

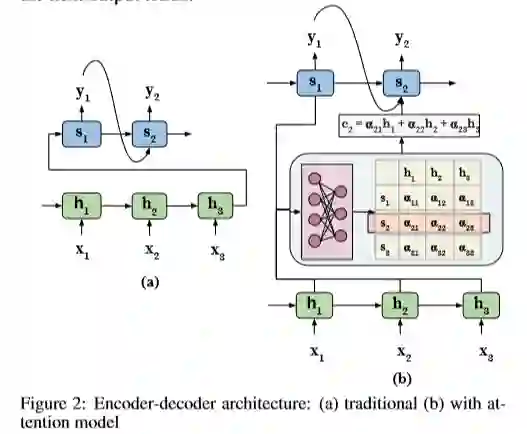

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。