自编码器26页综述论文:概念、图解和应用

在这篇新论文中,TOELT LLC 联合创始人兼首席 AI 科学家 Umberto Michelucci 对自编码器进行了全面、深入的介绍。

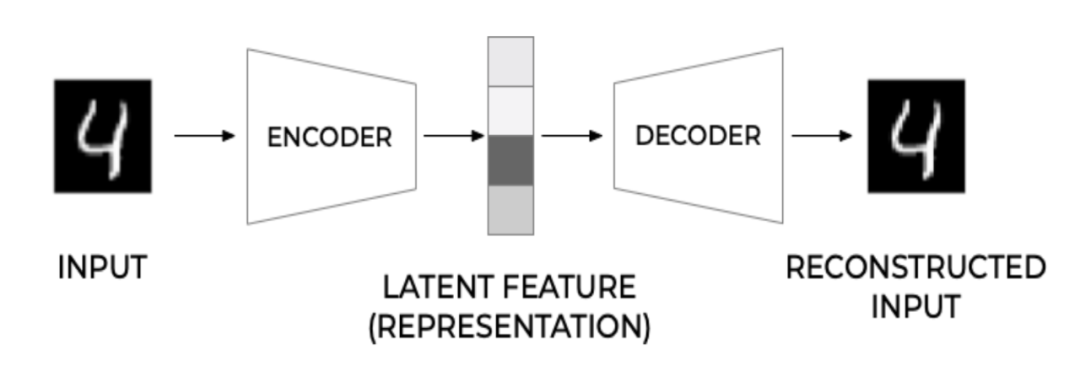

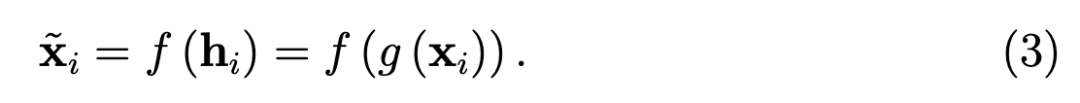

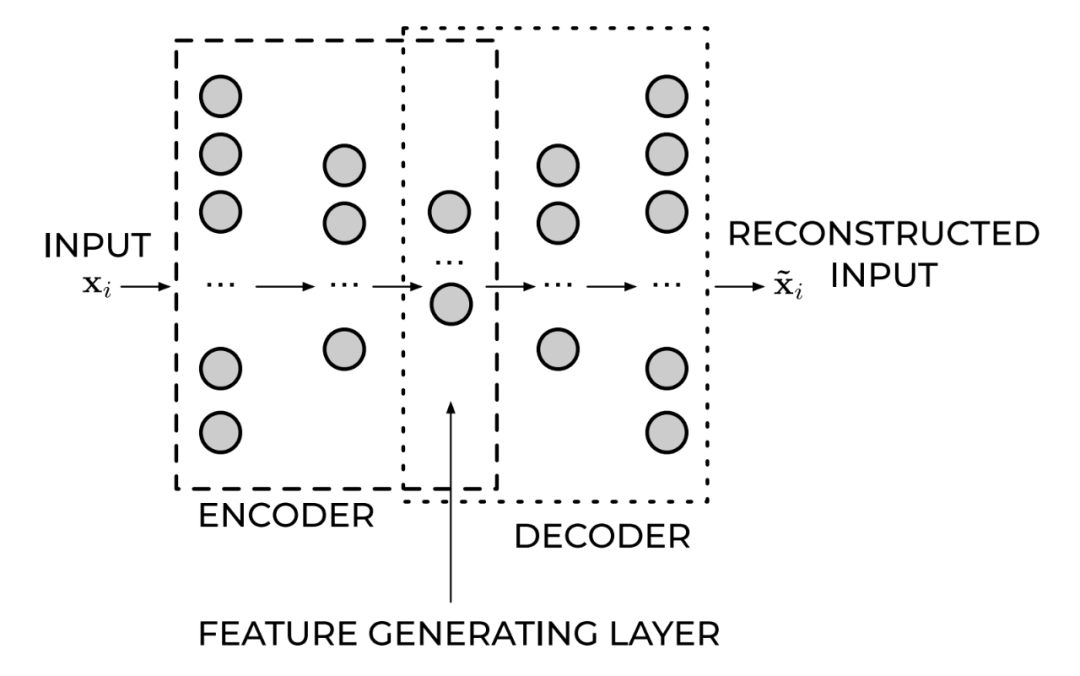

图 1:自动编码器的一般架构。

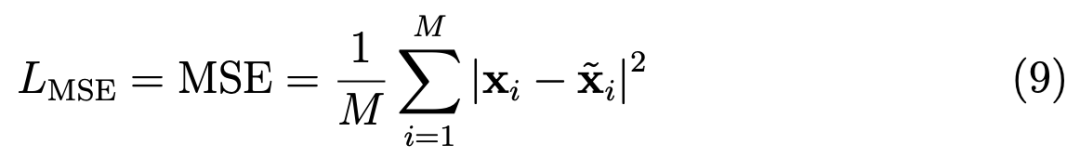

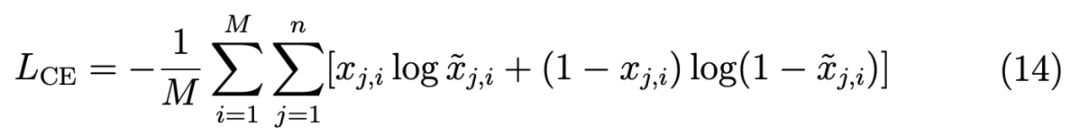

表示的网络输出)可以作为潜在特征的第二个通用函数 f 写入

表示的网络输出)可以作为潜在特征的第二个通用函数 f 写入

增加一个「瓶颈(bottleneck)」是通过使潜在特征的维度比输入的维度更低(通常要低得多)来实现的。

这就是本文将详细讨论的情况。

但在研究这种情况之前,需要提到正则化问题。

增加一个「瓶颈(bottleneck)」是通过使潜在特征的维度比输入的维度更低(通常要低得多)来实现的。

这就是本文将详细讨论的情况。

但在研究这种情况之前,需要提到正则化问题。

。

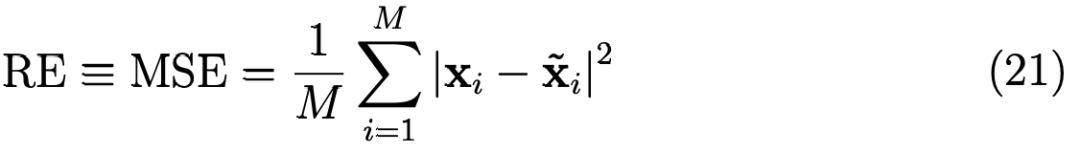

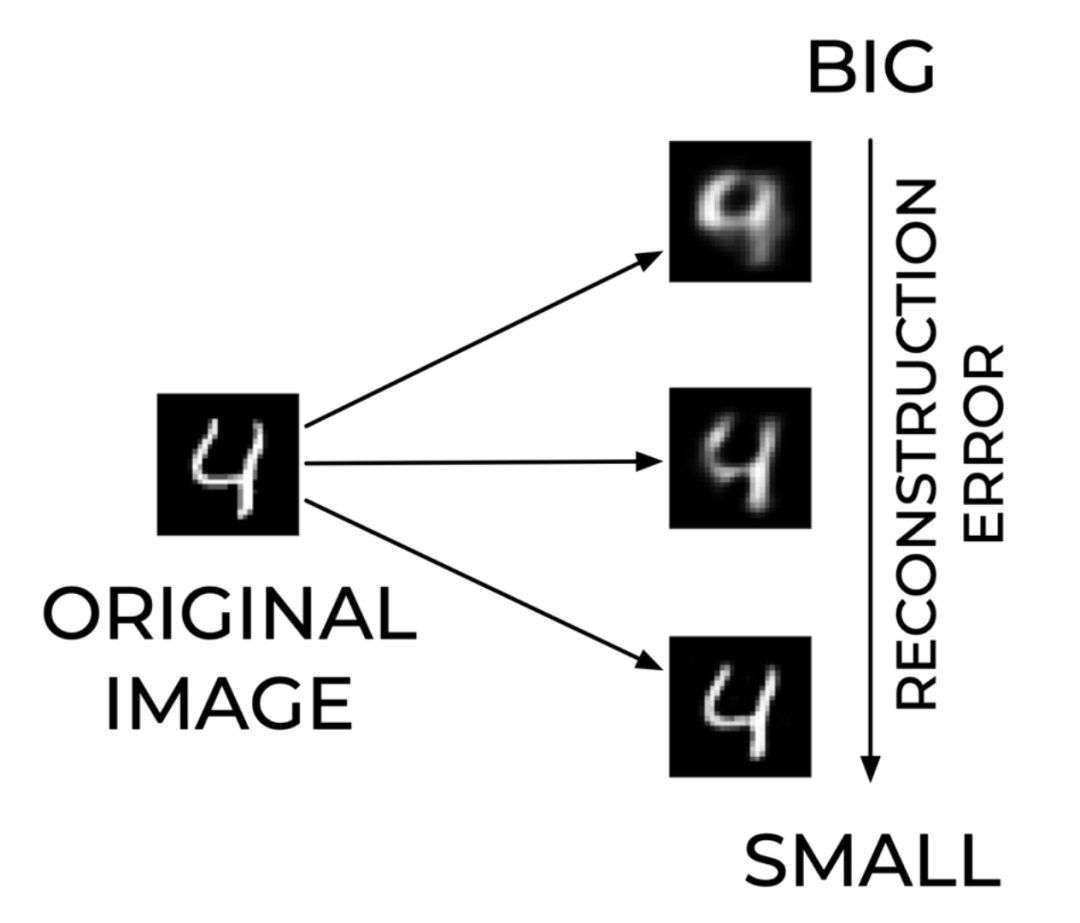

需要注意的是,解码器只需要使用比最初的输入观测值 (n) 少得多的特征数 (q) 就可以重构输入。

中间层的输出也称为输入观测值 x_i 的学习表示。

。

需要注意的是,解码器只需要使用比最初的输入观测值 (n) 少得多的特征数 (q) 就可以重构输入。

中间层的输出也称为输入观测值 x_i 的学习表示。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“AE26” 就可以获取《自编码器26页综述论文:概念、图解和应用》专知下载链接

登录查看更多

相关内容

Arxiv

100+阅读 · 2020年2月20日

Arxiv

11+阅读 · 2017年12月27日