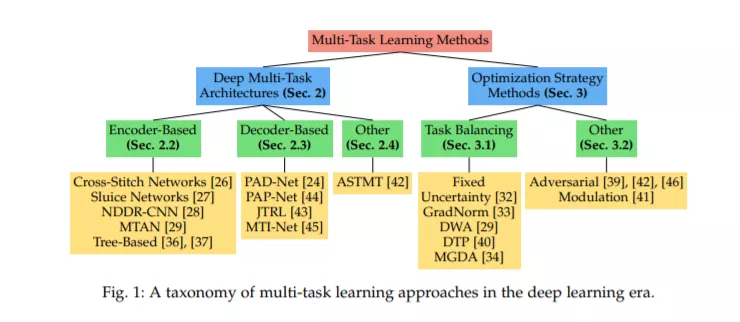

尽管在深度学习方面取得了最近的进展,但大多数方法仍然采用类似“筒仓”的解决方案,专注于孤立地学习每个任务:为每个单独的任务训练一个单独的神经网络。然而,许多现实问题需要多模态方法,因此需要多任务模型。多任务学习(MTL)旨在利用跨任务的有用信息来提高模型的泛化能力。在这个综述中,我们提供了一个最先进的在深度神经网络的背景下MTL技术的全面观点。我们的贡献涉及以下方面。首先,我们从网络架构的角度来考虑MTL。我们包括了一个广泛的概述,并讨论了最近流行的MTL模型的优缺点。其次,我们研究了解决多任务联合学习的各种优化方法。我们总结了这些工作的定性要素,并探讨了它们的共性和差异。最后,我们在各种数据集上提供了广泛的实验评估,以检查不同方法的优缺点,包括基于架构和优化的策略。

https://arxiv.org/abs/2004.13379

概述

在过去的十年中,神经网络在许多任务中都显示了令人印象深刻的结果,例如语义分割[1],实例分割[2]和单目深度估计[3]。传统上,这些任务是单独处理的,即为每个任务训练一个单独的神经网络。然而,许多现实世界的问题本质上是多模态的。例如,一辆自动驾驶汽车应该能够检测场景中的所有物体,定位它们,了解它们是什么,估计它们的距离和轨迹,等等,以便在它的周围安全导航。同样的,一个智能广告系统应该能够在它的视点上检测到人们的存在,了解他们的性别和年龄,分析他们的外貌,跟踪他们正在看的地方,等等,从而提供个性化的内容。与此同时,人类非常擅长同时解决许多任务。生物数据处理似乎也遵循多任务处理策略: 不同的处理过程似乎共享大脑中相同的早期处理层,而不是将任务分开单独处理。上述观察结果促使研究人员开发了多任务学习(MTL)模型,即给定一个输入图像可以推断出所有所需的任务输出。

在深度学习时代之前,MTL工作试图对任务之间的共同信息进行建模,希望通过联合任务学习获得更好的泛化性能。为了实现这一点,他们在任务参数空间上放置了假设,例如:任务参数应该彼此靠近w.r.t.一些距离度量[5],[6],[16]0,[16]2,共享一个共同的概率先验[16]1,[10],[11],[12],[13],或驻留在一个低维子空间[14],[15],[16]或流形[17]。当所有任务都是相关的[5]、[14]、[18]、[19]时,这些假设可以很好地工作,但是如果在不相关的任务之间发生信息共享,则可能导致性能下降。后者是MTL中已知的问题,称为负转移。为了缓解这一问题,其中一些研究人员选择根据先前对任务的相似性或相关性的认识将任务分组。

在深度学习时代,MTL转化为能够从多任务监控信号中学习共享表示的网络设计。与单任务情况下,每个单独的任务由自己的网络单独解决相比,这种多任务网络理论上给表带来了几个优点。首先,由于它们固有的层共享,结果内存占用大大减少。其次,由于他们明确地避免重复计算共享层中的特征,每次都要计算一次,因此他们的推理速度有所提高。最重要的是,如果相关的任务能够分享互补的信息,或者互相调节,它们就有可能提高绩效。对于前者,文献已经为某些对任务提供了证据,如检测和分类[20],[21],检测和分割[2],[22],分割和深度估计[23],[24],而对于后者,最近的努力指向了那个方向[25]。这些工作导致了第一个深度多任务网络的发展,历史上分为软或硬参数共享技术。

在本文中,我们回顾了在深度神经网络范围内的MTL的最新方法。首先,我们对MTL基于架构和优化的策略进行了广泛的概述。对于每种方法,我们描述了其关键方面,讨论了与相关工作的共性和差异,并提出了可能的优点或缺点。最后,我们对所描述的方法进行了广泛的实验分析,得出了几个关键的发现。我们在下面总结了我们的一些结论,并提出了未来工作的一些可能性。

-

首先,MTL的性能在很大程度上取决于任务字典。它的大小、任务类型、标签源等等,都影响最终的结果。因此,最好根据每个案例选择合适的架构和优化策略。尽管我们提供了具体的观察结果,说明为什么某些方法在特定设置中工作得更好,但是MTL通常可以从更深的理论理解中获益,从而在每种情况下最大化预期收益。例如,这些收益似乎取决于多种因素,例如数据量、任务关系、噪音等。未来的工作应该尝试分离和分析这些不同因素的影响。

-

其次,当使用单一MTL模型处理多个密集预测任务时,基于解码器的架构目前在多任务性能方面提供了更多优势,与基于编码器的架构相比,其计算开销有限。如前所述,这是由于基于解码器的体系结构促进了常见的跨任务模式的对齐,这自然很适合密集的预测任务。基于编码器的架构在密集预测任务设置中仍然具有一定的优势,但其固有的层共享似乎更适合处理多个分类任务。

-

最后,我们分析了多种任务均衡策略,并分离出对任务均衡学习最有效的要素,如降低噪声任务的权重、平衡任务梯度等。然而,许多优化方面仍然缺乏了解。与最近的研究相反,我们的分析表明避免任务之间的梯度竞争会损害性能。此外,我们的研究显示,一些任务平衡策略仍然存在不足,突出了现有方法之间的一些差异。我们希望这项工作能促进对这一问题的进一步研究。