目标检测新范式:Sparse R-CNN,港大同济伯克利联合工作

1

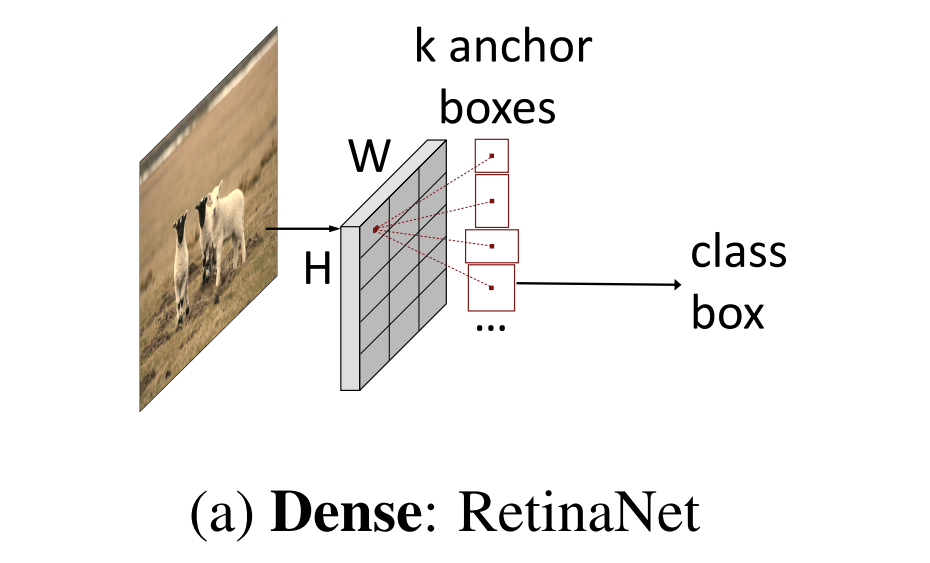

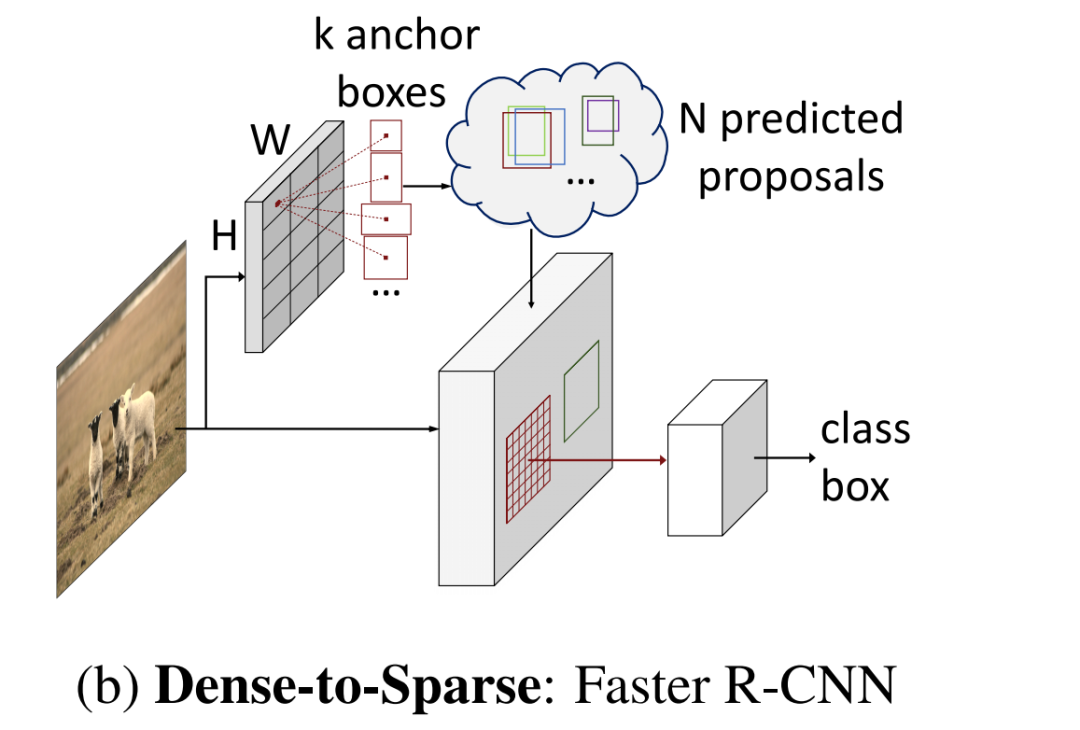

动机

-

NMS 后处理 -

many-to-one 正负样本分配 -

prior candidates的设计

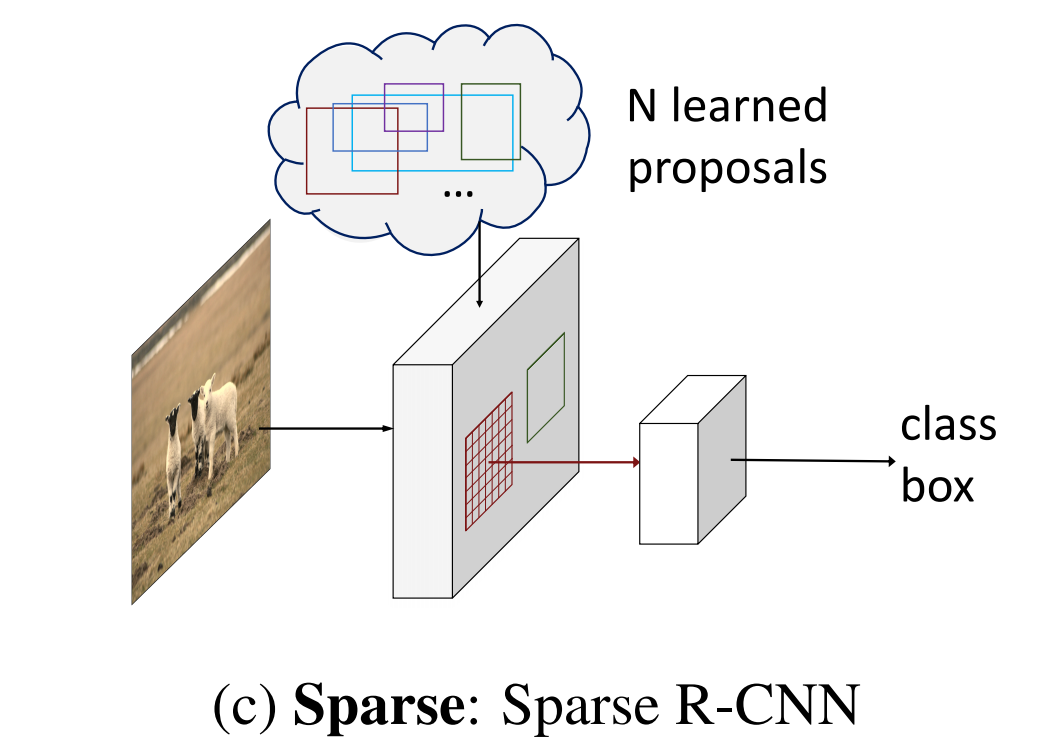

Sparse R-CNN

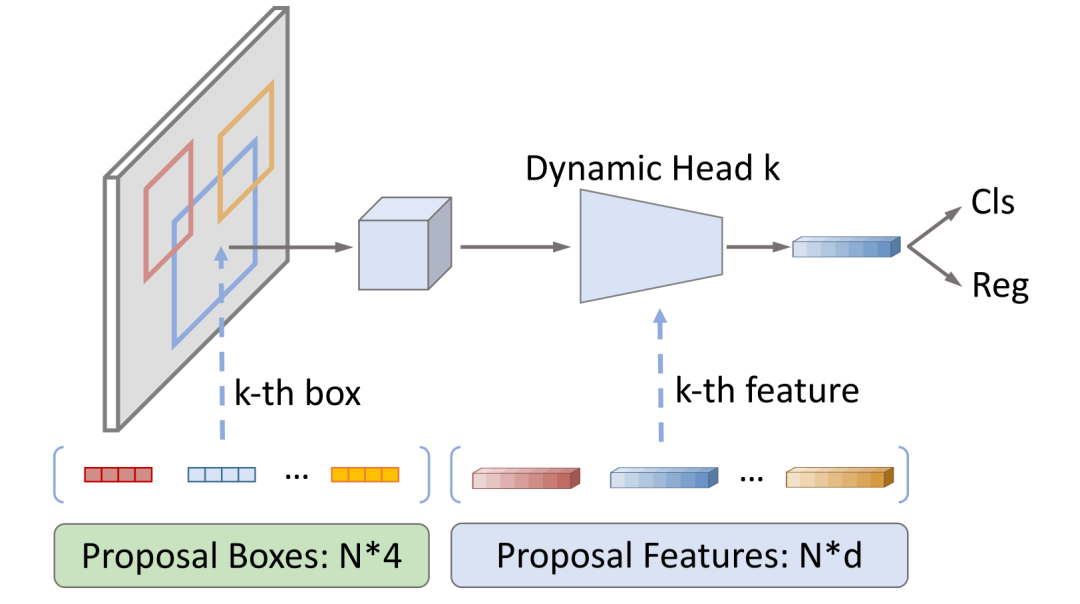

架构设计

-

Backbone是基于ResNet的FPN。 -

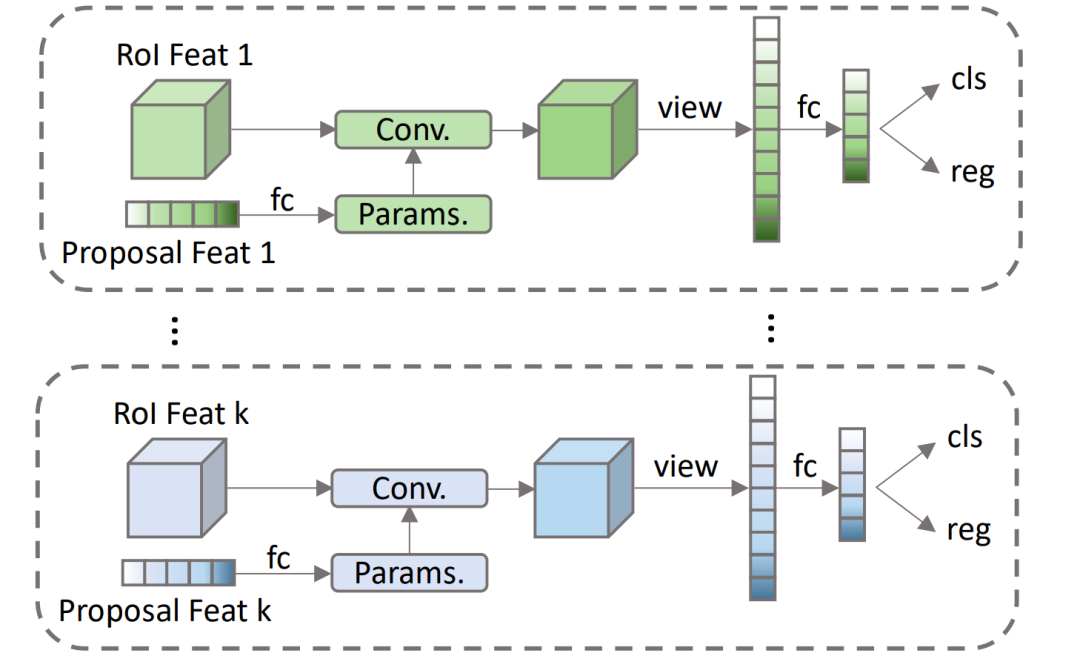

Head是一组iterative的Dynamic Instance Interactive Head,上一个head的output features和output boxes作为下一个head的proposal features和proposal boxes。Proposal features在与RoI features交互之前做self-attention。 -

训练的损失函数是基于optimal bipartite matching的set prediction loss。

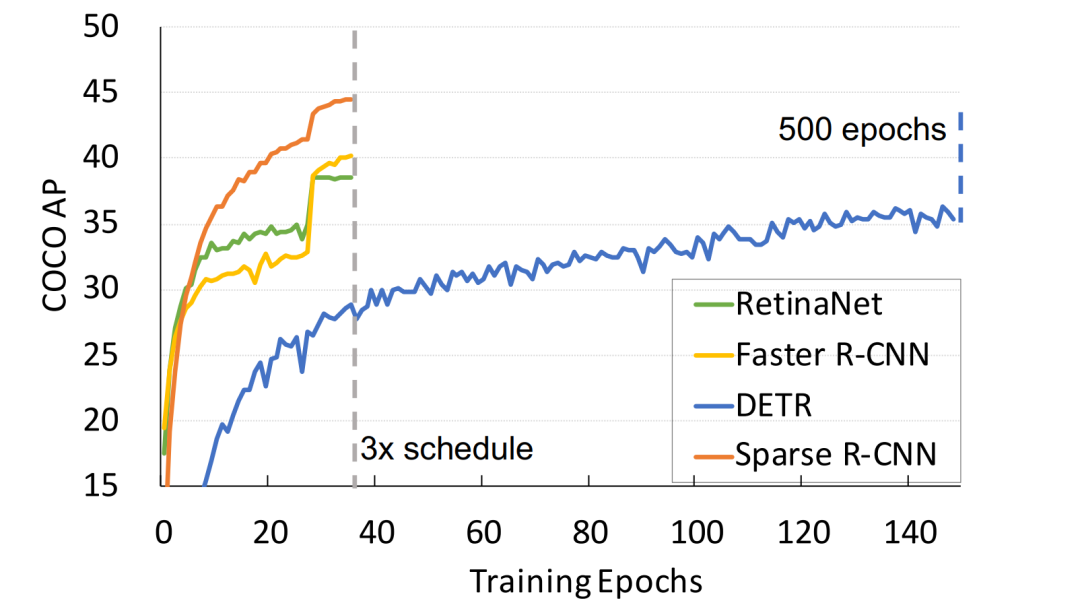

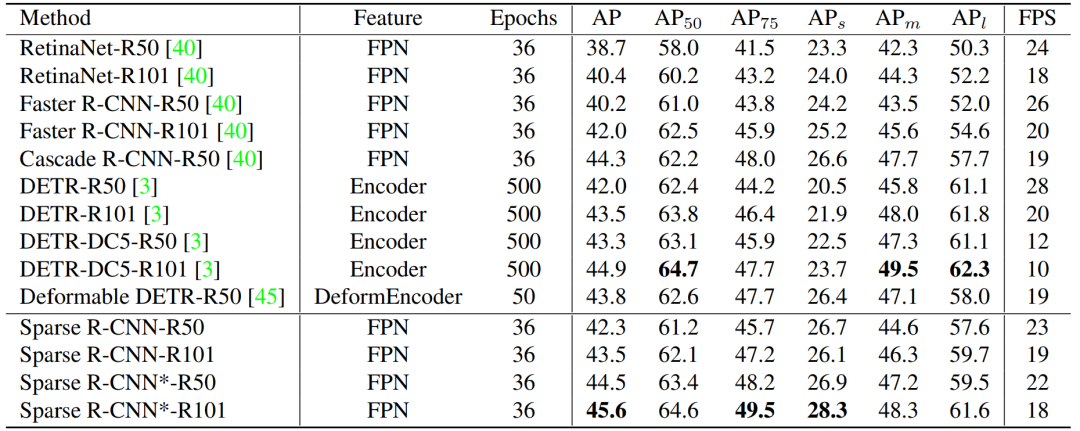

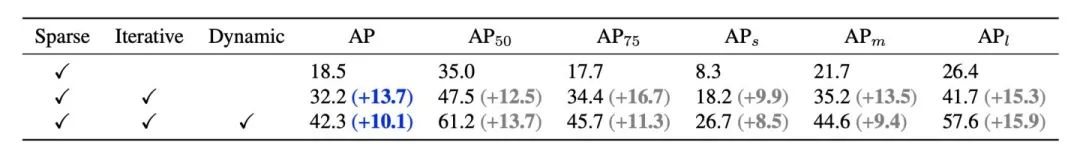

性能

结论

本文经授权转载自知乎:https://zhuanlan.zhihu.com/p/310058362

点击阅读原文,直达NeurIPS小组!

登录查看更多

相关内容

专知会员服务

85+阅读 · 2019年11月15日

Arxiv

6+阅读 · 2018年7月19日

Arxiv

8+阅读 · 2018年2月21日