最新Anchor-Free目标检测模型—FoveaBox

作者丨孙明珊

学校丨哈尔滨工业大学(深圳)

研究方向丨目标检测

研究动机

在两阶段的目标检测器中,通常利用预先产生的锚点框去拟合待检测的目标,其中包含对目标物的尺寸、长宽比、位置的拟合,然而锚点框的产生通常是离散变化的,因此锚点框的预设定对该类算法的效果有很大影响。

FoveaBox 为了解除这种影响,类比人类视觉系统感知世界的原理,认为人类先判定某个范围物体是什么,然后再对其边缘轮廓进行仔细判定,而不是去匹配任何事先在脑海里设定的模板矩形框,从而开辟了无需锚点框的检测方法:1)预测类别相关的语义图来表征目标存在的概率;2)产生类别无关的可能包含目标物体的矩形框。也正因为其不依靠于默认的锚点框,使得其对锚点框的分布更具鲁棒性。

研究方法

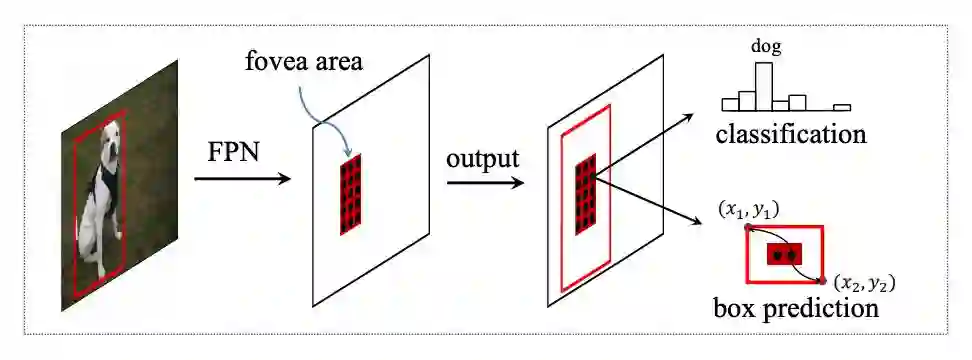

FoveaBox 是个端到端的网络,由提取特征的基础网络和带有双任务的子网络构成,双任务包括了对基础网络输出的每个空间位置进行分类以及对应区域矩形框坐标的预测。整体流程如下图所示:

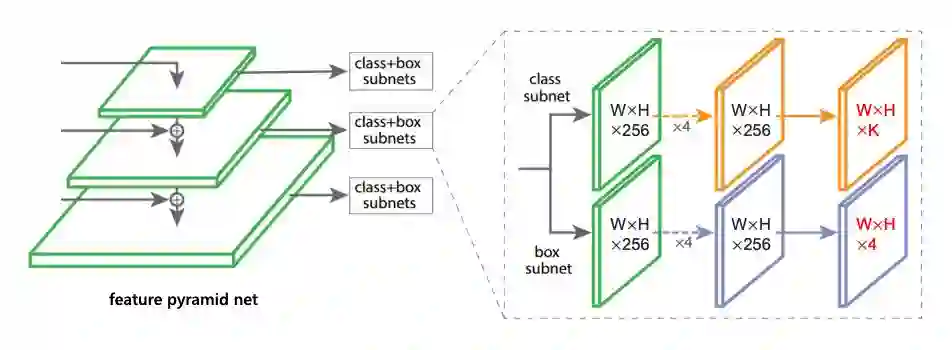

基于特征金字塔(FPN)的基网络

FoveaBox 将特征金字塔每层特征上进行上述两个任务,最后将结果进行合并。

尺度的设定

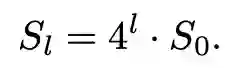

首先明确最终目标是预测目标的轮廓,然而直接预测物体的轮廓难度过大,因为其尺度变化范围大,为了解决这个问题,FoveaBox 将连续尺度划分成多个区间,并将它们和特征金字塔中的不同层对应。

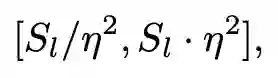

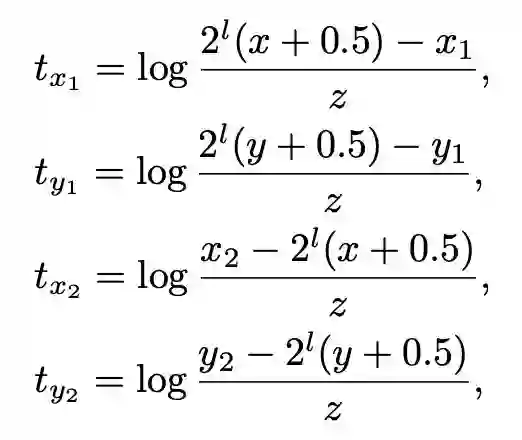

因此,特征金字塔中每层只负责预测某个特定尺度范围的矩形框,其中表示第 l 层特征的基础大小,而给定的区间范围由一个系数 η 控制,衡量方式如下二式所示:

其中值得注意的是某个尺寸的物体可能会被映射到金字塔不同层次,这与之前 FPN 的概念有差异(某尺寸只被映射到金字塔特定某层)。

构建目标Fovea

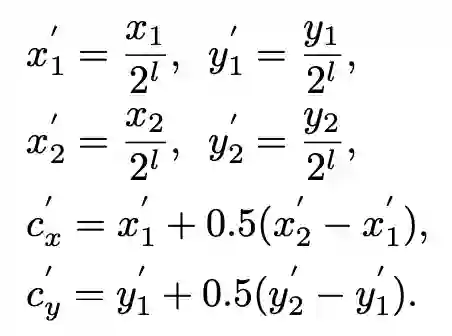

Fovea 其实就是依据 ground truth 在输出的特征上制定的正样本区域。给定一个 ground truth 的坐标 (X1,Y1,X2,Y2),首先将这个矩形框映射到其对应的金字塔层,其缩放公式如下所示:

在其映射得到的坐标基础上添加缩放因子来制定正区域,也就是 Fovea(中心点不变,缩放尺寸),如下:

σ1 是缩放因子,处于正区域范围内的单元会在训练的时候被标上相应类别标签。而另外一个缩放因子 σ2 会被用在制定负区域,同样的计算方式(实验中采用的是 σ1=0.3,σ2=0.4)。与此同时,需要注意此时的正样本只占了一小部分,为了克服正负样本不均衡,在分类任务中采用了 Focal loss。

矩形框的预测

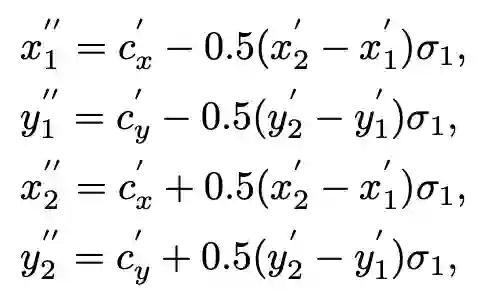

与 Faster R-CNN 不同的,矩形框偏移量的回归并不是只针对中心点而言,而是 Fovea 中的每一个 cell 的坐标映射回原始图像之后和对应的 ground truth 的偏移量,计算方式如下:

其中,z 为标准化因子使得输出空间映射到以 1 为中心的新空间。

推理阶段

首先经过 0.05 的置信度阈值过滤掉一部分置信度过低的预测框,在每层选出置信度排名前 1000 的矩形框,接下来用 0.5 的非极大值抑制单独对每个类别进行操作,最后选出图片钟得分前 100 的矩形框。同时为了与基于锚点的目标检测方法进行对比,并没有在推理阶段采取软非极大值抑制和投票机制作为后处理的手段。

实验内容及分析

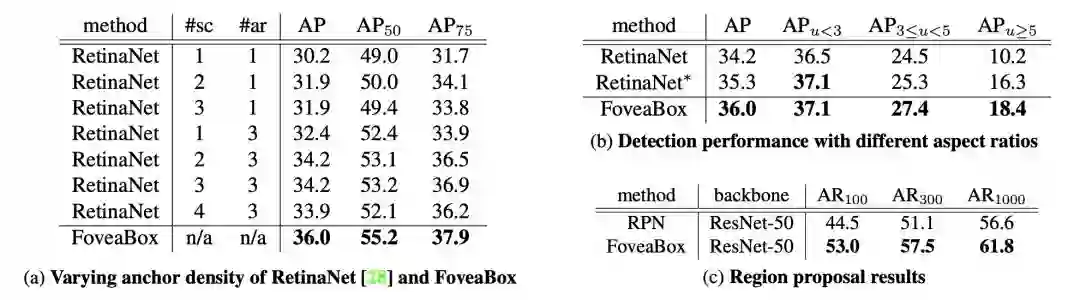

对比实验的选取对象的是带有稠密锚点框的 RetinaNet,实验表明带锚点框的 RetinaNet 增加 feature map 每个单元对应的 anchor 并不会对实验的提升有帮助,并且证实了某个特定的位置只对应一个锚点的回归预测相对稠密锚点的方式有提升。

这使得 FoveaBox 具有的优势是:输出空间缩小为原来的 1/A,其中 A 是每个位置的锚点个数;比起模棱两可的优化目标已有一个框的方式更加直接;FoveaBox 更灵活,无需提前设置锚点尺寸。具体结果如下两表所示:

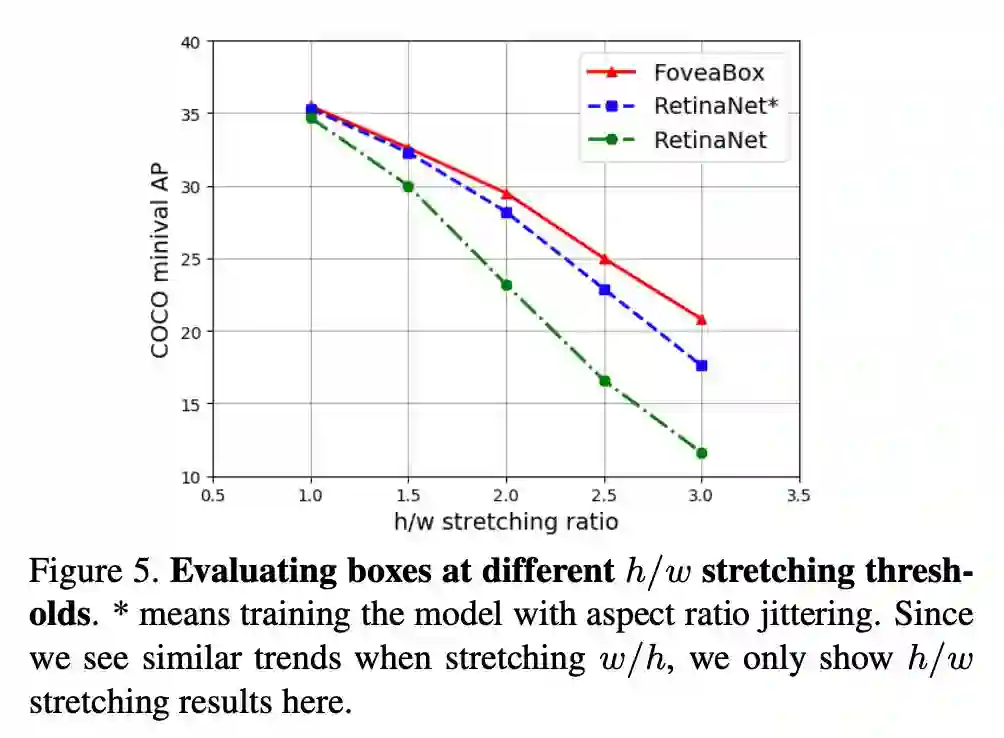

为了进一步验证 FoveaBox 对矩形框尺寸分布更具鲁棒性,将验证集进行不同宽高比的拉伸,使得矩形框尺寸变化。实验结果表明 FoveaBox 对宽高比变化更具有鲁棒性。

背后的原因:基于锚点的方法只对预测为正样本的建议框进行回归预测,并且是只针对一定的宽高比,所以其学习到的拟合能力较弱,面对极端变化的情况无法处理。

而 FoveaBox 每个单元的矩形框只有一个且是任意比例,由此拟合能力更强,可以产生质量更高的区域建议,在宽高比极端的情况下依旧能处理。其实验结果如下图所示:

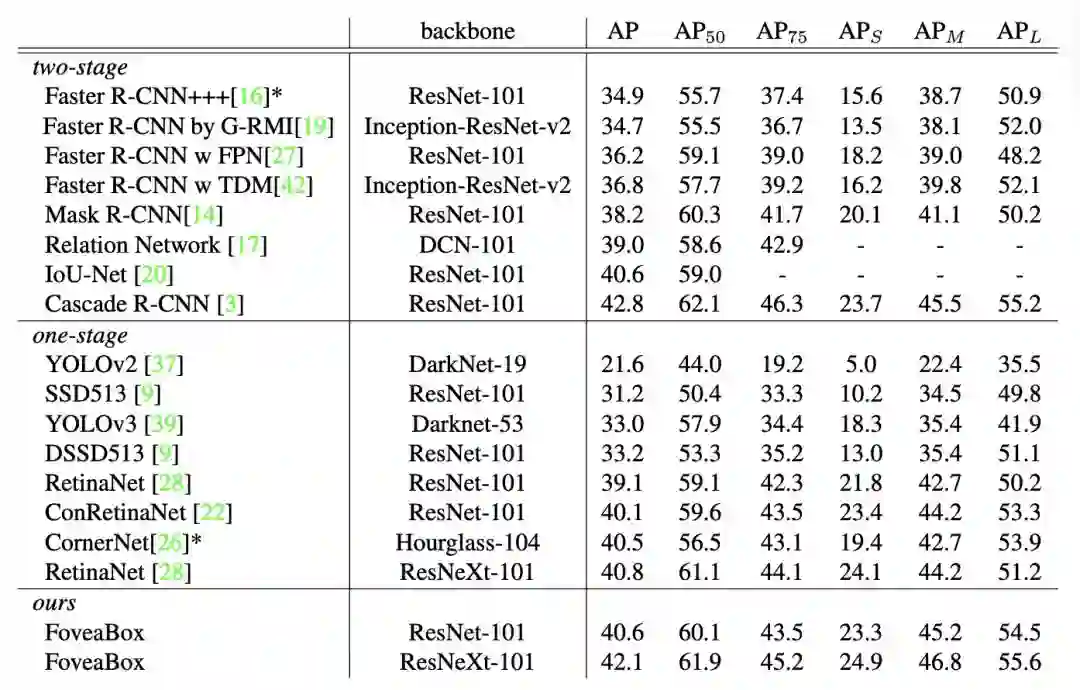

除此之外,FoveaBox 主要是针对矩形框尺寸更任意的目标有明显的改善,与其他主流的一阶段和二阶段对比结果如下:

总结

FoveaBox 提出了一种没有依靠锚点框的目标检测方法,直接预测每个空间位置所属类别,对潜在物体区域的单元进行矩形框的回归预测,因此不受先验锚点框尺寸的束缚,其拟合能力更强,对于长宽比变化较大较极端的物体更具优势。为打破基于锚点框的检测框架提供了新思路。

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文