重磅!13篇基于Anchor free的目标检测方法

极市正在推出CVPR2019的专题直播分享会,邀请CVPR2019的论文作者进行线上直播,分享优秀的科研工作和技术干货,也欢迎各位小伙伴自荐或推荐优秀的CVPR论文作者到极市进行技术分享~

本周四(5月30日)晚,帝国理工学院计算机系IBUG组博士生邓健康,将为我们分享:ArcFace 构建高效的人脸识别系统(CVPR2019),公众号回复“42”即可获取直播详情。

作者 | 黄浴

本文授权转载自公众号CVer

原文 | https://zhuanlan.zhihu.com/p/64563186

作者简介:黄浴

职业经历

奇点汽车美研中心 · 首席科学家兼总裁

上海大学 · 兼职教授

百度美研 · 软件架构师

英特尔总部 · 架构师

教育经历

伊利诺伊大学厄本那香槟分校 (UIUC) · 计算机视觉

埃尔朗根-纽伦堡大学 · 模式识别

清华大学 · 人机交互/多媒体

个人简介

专业领域:图像视频处理,计算摄影,机器学习,计算机视觉和数据可视化。

从事的工业界:安防,多媒体,电讯,半导体,互联网。

个人信息来源:

https://www.zhihu.com/people/yuhuang2019/activities

正文

感觉是回归吧,以前是没有anchor的,现在觉得还是去掉anchor(“锚”?)好,主要是灵活性强,今后硬件芯片兼容性好。

回顾一下,目标检测分单步和两步,单步法的历史中从SSD和YOLO-2开始引入锚框(anchor box),而两步法直到Faster RCNN才开始采用“锚”的想法。

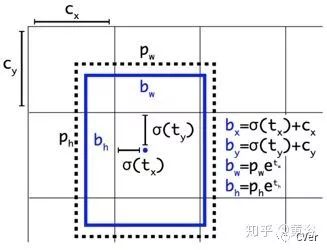

什么是锚框呢?其实就是固定 的参考框。锚框的出现,使得训练时可以预设一组不同尺度不同位置的锚框,覆盖几乎所有位置和尺度, 每个锚框负责检测与其区域交叉比(intersection over union, IOU)大于阈值的目标,这样问题就转换为"这个锚框中有没有认识的目标,目标框偏离锚框多远"的问题。

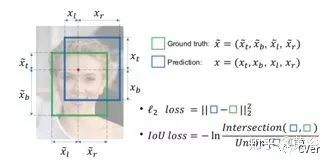

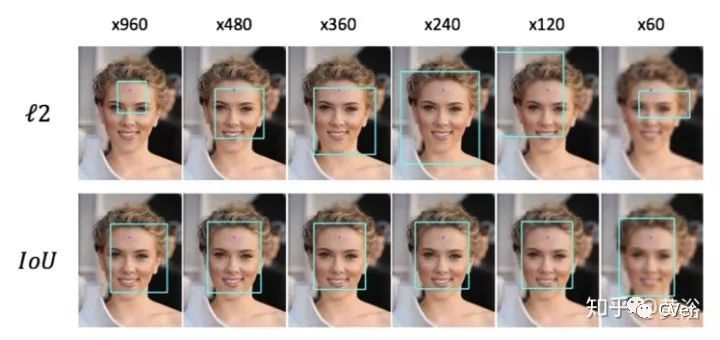

UnitBox: An Advanced Object Detection Network

Densebox

Yolo-1/(-2/3)

CornerNet

ExtremeNet

FSAF: Feature Selective Anchor-Free

FCOS: Fully Convolutional One-Stage

FoveaBox

Center and Scale Prediction: A Box-free Approach for Object Detection

Region Proposal by Guided Anchoring(GA-RPN)

CenterNet: Objects as Points

CenterNet: Keypoint Triplets for Object Detection

CornerNet-Lite: Efficient Keypoint Based Object Detection

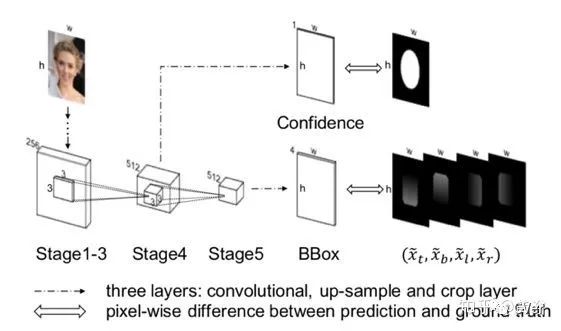

UnitBox: An Advanced Object Detection Network

主要思想:Intersection over Union (IoU) loss function for bounding box prediction

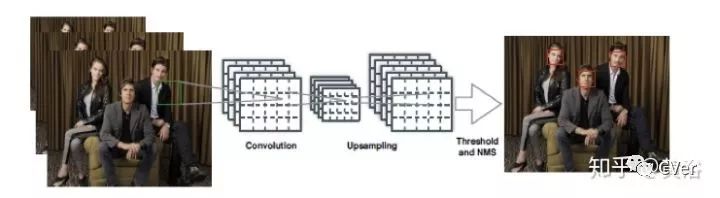

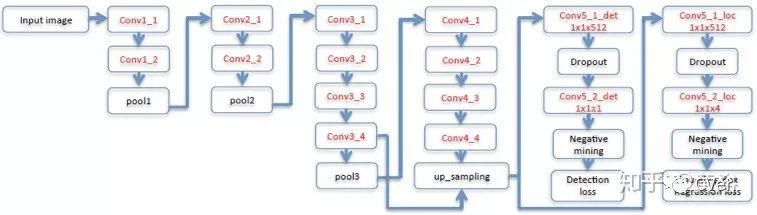

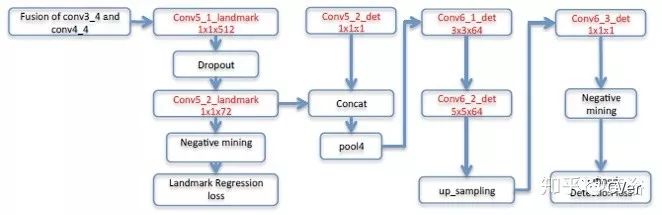

DenseBox: Unifying Landmark Localization and Object Detection

基本思想:直接预测目标框和目标类。

系统流水线:

1) 图像金字塔.

2) 类似编码器-解码器.

3) feature map 转换成 bounding boxes,加NMS处理。

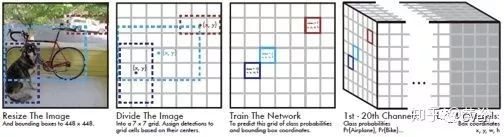

You Only Look Once (YOLO) for Object Detection

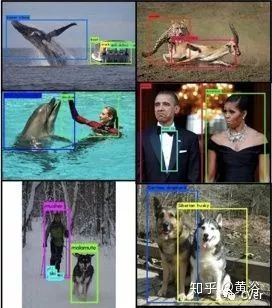

检测定义为一个张量的回归问题,直接通过张量的估计得到目标框位置和类别概率。

注:之后YOLO-2/3版采用了anchor方法,这里也加在一起参考。

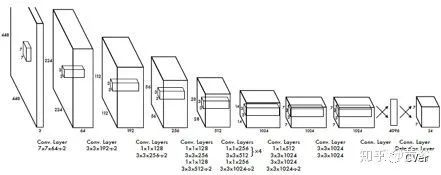

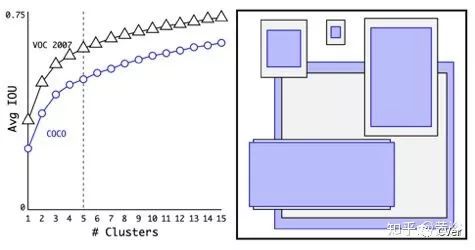

YOLO9000: Better, Faster, Stronger

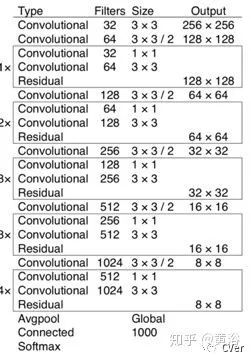

Darknet-19: 19 convolutional layers and 5 max-pooling layers

WordTree with 9418 classes

YOLOv3: An Incremental Improvement

CornerNet: Detecting Objects as Paired Keypoints

相关解读:ECCV 2018 | CornerNet:目标检测算法新思路

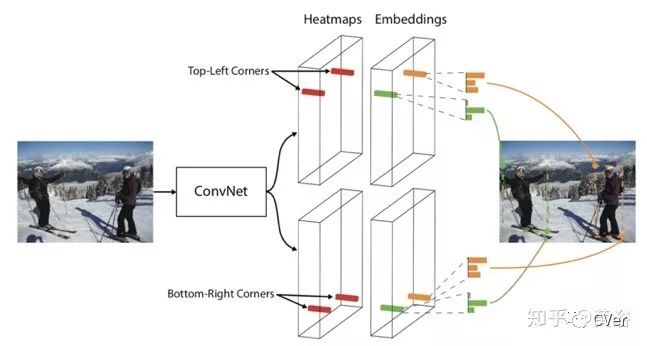

把检测目标框变成一对关键点的问题,即左上角和右下角,这样就消除了锚框的设计麻烦。另外,采用的角点池化(corner pooling)技术帮助CNN更好地定位角点位置。 下图给出了系统流程图:CNN模型输出两个关键点的各自热图(heatmap),同时各跟一个嵌入向量。同一个目标的角点,训练后的神经网络会预测类似的嵌入。

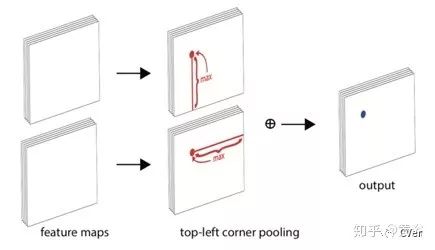

下图是定位的角点池化技术:每个特征图通道沿着两个方向取最大值,然后求和。

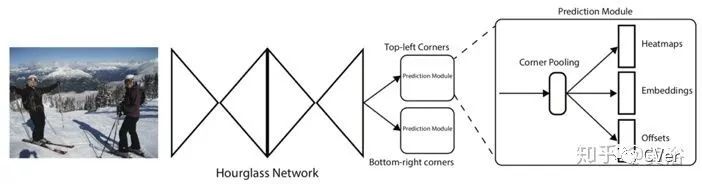

测试流程图:沙漏型的核心网络的后面跟着两个预测模块定位和聚类焦点。

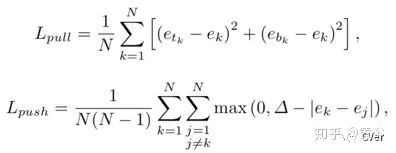

定义loss函数聚类corner:push和pull

ExtremeNet: Bottom-up Object Detection by Grouping Extreme and Center Points

主要思想:也是将目标检测变成了纯粹关键点估计问题,包括目标的4个extreme points 和1个中心点,将这几何校准的5个点组成一个目标框。

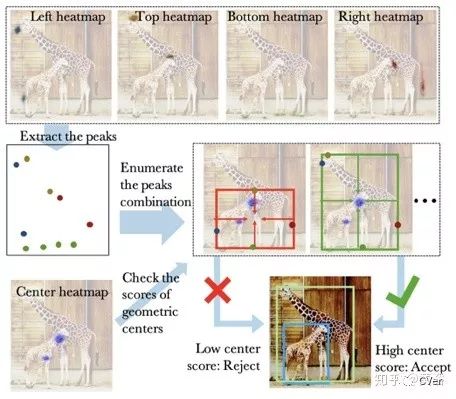

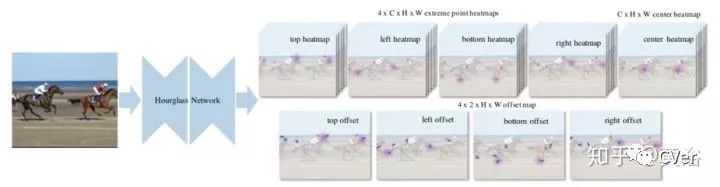

下图是系统流程图:类似CornerNet,对每个目标类,CNN网络预测5个热图,只有几何中心的热图响应足够大才会生成目标框。

如下是模型的测试流程图:输入图像得到5个C-通道热图,4个2-通道类别无关的偏差图(offset map)。热图是通过加权逐像素逻辑回归(logistic regression)训练得到,. 而偏差图则是由平滑L1 损失函数训练的。

下图是中心分组(Center grouping)算法:输入是5个热图,输出则是带有可信度的目标框。

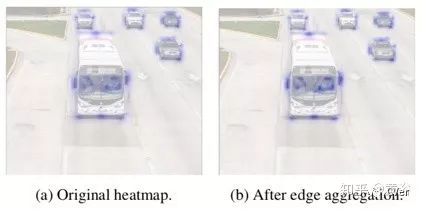

下图是边缘聚集的结果:当一个边缘的多个点都成为extreme point,可见边缘聚集使中间像素的可信度得到增大。

FSAF: Feature Selective Anchor-Free Module

相关解读:CVPR2019 | FSAF:来自CMU的Single-Shot目标检测算法

一作直播:CMU诸宸辰:基于Anchor-free特征选择模块的单阶目标检测(回放视频+PPT)

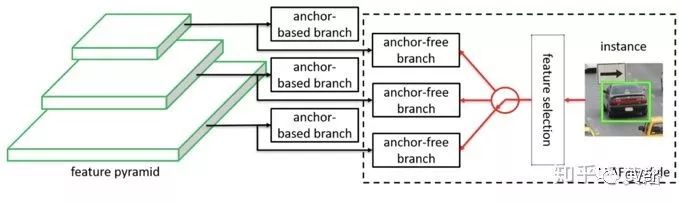

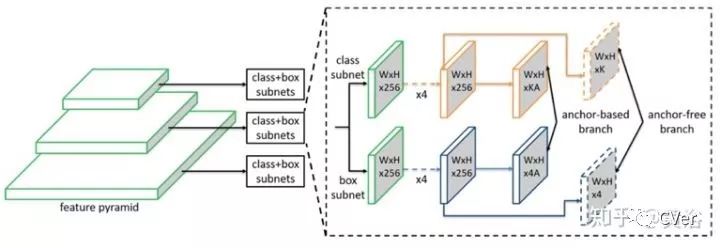

主要思想:基于特征金字塔网络(feature pyramid structure,FPN)的在线特征选择能力, 在训练时可以动态分配每个实例到最适合的特征层,在推理时能够和带锚的模块分支一起工作,最后并行地输出预测。

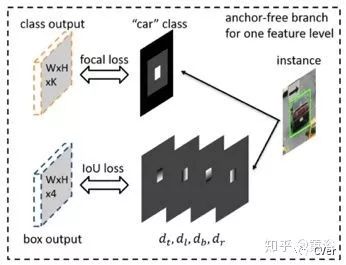

下图展示一个特征层中的实例监督信号,其中两个损失函数:分类的focal loss 和目标框回归的IoU loss 。

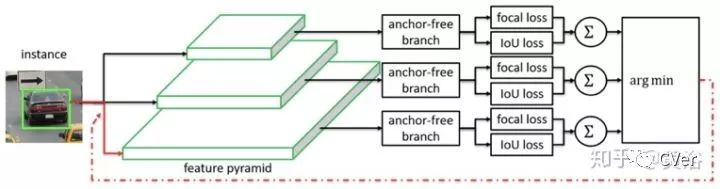

在线特征选择的操作如图:每个实例通过无锚框的所有层计算出所有有效区域的分类损失和回归损失,在最小损失的那层构建该实例的监督信号。

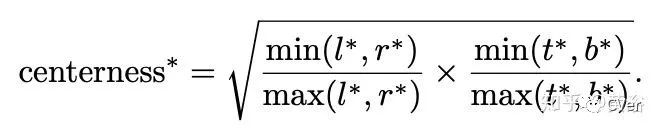

FCOS: Fully Convolutional One-Stage Object Detection

相关解读:FCOS: 最新的one-stage逐像素目标检测算法

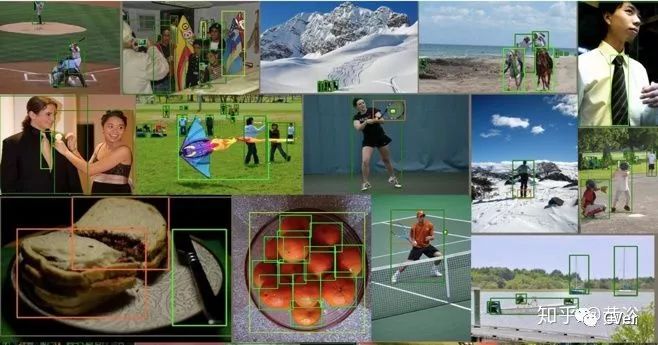

主要思想:是分割,不需要锚框也不需要区域提议。 这样,避免了锚框在模型训练中涉及的重叠计算和性能敏感的参数设计环。

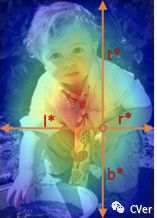

FCOS中定义了一个新损失函数“中心度(centerness)”,如下图( 红和蓝对应 1 和 0, 其他颜色位于其中)。

FoveaBox: Beyond Anchor-based Object Detector

相关解读:FoveaBox,超越Anchor-Based的检测器

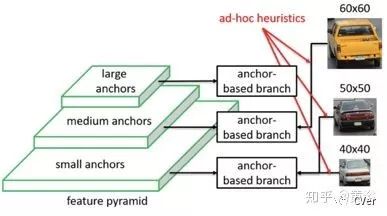

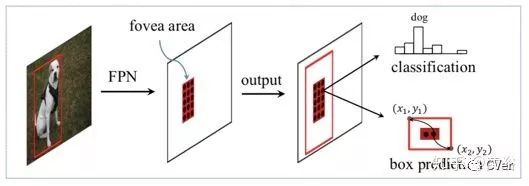

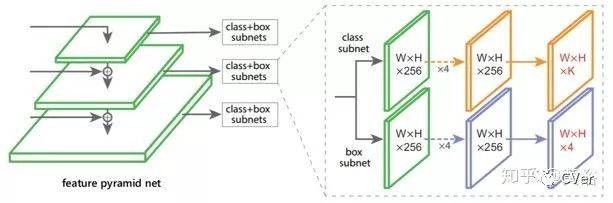

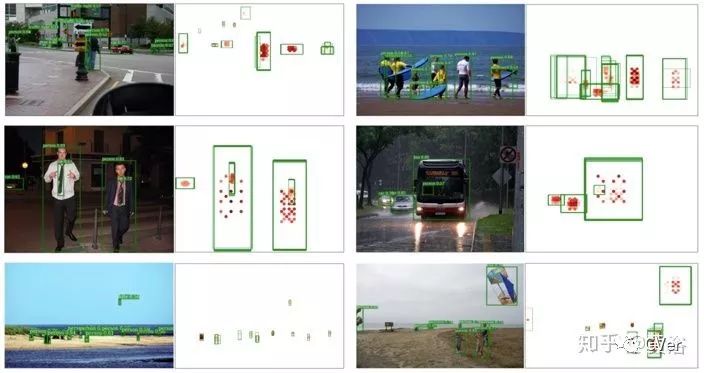

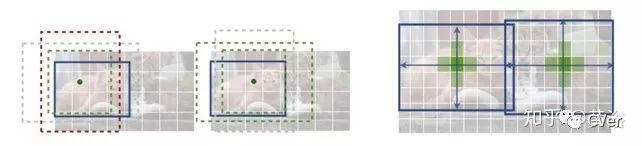

主要思想:直接学习目标存在的概率和目标框的坐标位置,其中包括预测类别相关的语义图和生成类别无关的候选目标框,目标框的大小和特征金字塔的表示相关(如图所示)。

FoveaNet的网络结构如图,一个基于ResNet的特征金字塔网络(FPN)送入两个子网络, 一个做分类,一个做预测。

Region Proposal by Guided Anchoring (GA-RPN)

相关解读:Guided Anchoring: 物体检测器也能自己学 Anchor

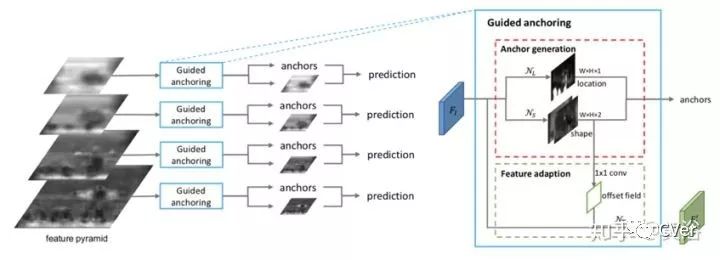

利用语义特征指导抛锚,称为指导性的抛锚。一起预测感兴趣目标的中心位置以及不同位置的尺度和长宽比。有代码: //github.com/open-mmlab/m.

对特征金字塔的每个输出特征图,采用带有两个分支的锚框生成模块分别预测锚位置和形状。一个特征适应模块对原始特征图处理,使其更能体现锚的形状。

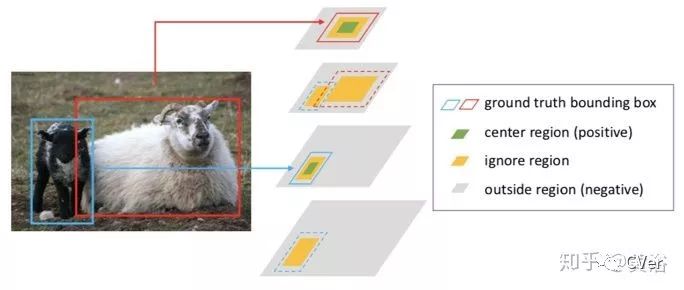

采用多级特征,根据其尺度把真实目标(ground truth objects)提供给不同特征级,相应定义 CR, IR和OR 。

CenterNet: Objects as Points.

相关解读:

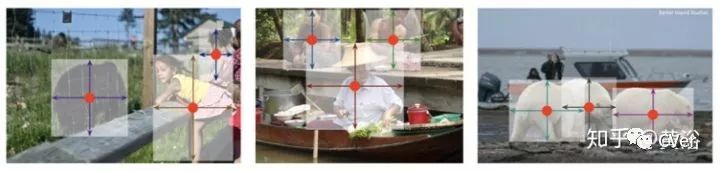

把目标定义成一个单点,即目标框的中心点(下图),检测器采用关键点估计找到中心点并从其关键点的特征回归其他目标特性,如大小,3D位置,朝向和姿势。

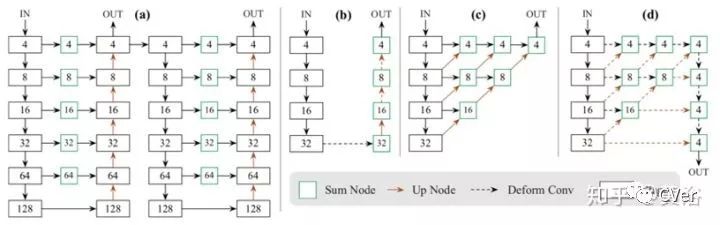

下面是CenterNet的模型框图,其中数字是步进(stride)量:(a) 沙漏网络;(b) 带转置卷积的ResNet,在每个上采样层前面加了个3 × 3 可变形卷积层(deformable convolutional layer);(c) 语义分割的DLA-34 (Deep layer aggregation);(d) 修正的 DLA-34,在可变形卷积层加更多的跳线(skip connections)上采样步骤。

CenterNet: Object Detection with Keypoint Triplets

相关解读:中科院牛津华为诺亚提出:CenterNet,One-stage目标检测最强算法!可达47mAP,已开源!

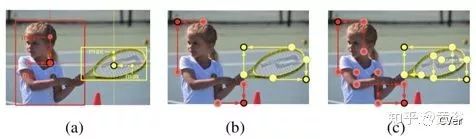

主要思想:基于前面提到的CornerNet,检测目标变成三个关键点的估计(a triplet of keypoints)。

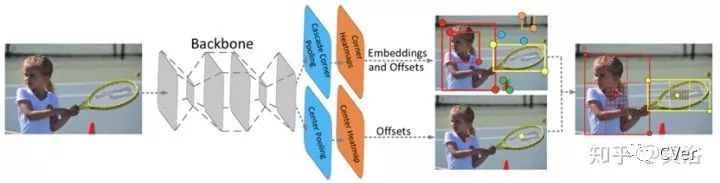

架构图:一个核心网络执行级联角点池化(cascade corner pooling)和中心点池化(center pooling ),输出两个角点热图和一个中心关键点热图;和CornerNet类似,一对检测的角点和嵌入用来检测潜在目标框;然后检测的中心关键点确定最终的框位置。

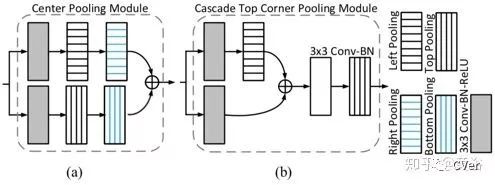

下图给出角点池化和中心点池化的结构图。

CornerNet-Lite: Efficient Keypoint Based Object Detection

相关解读:吊打YOLOv3!普林斯顿大学提出:CornerNet-Lite,基于关键点的实时且精度高的目标检测算法,已开源!

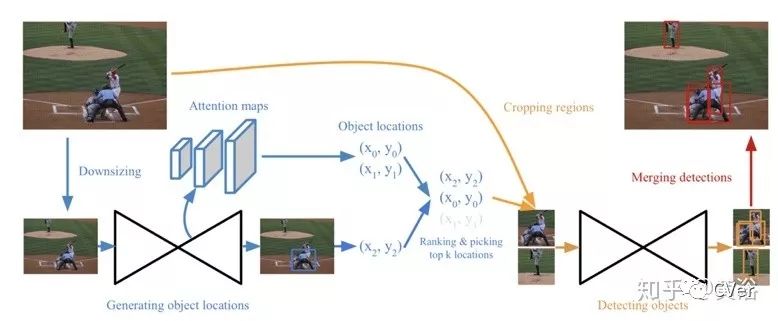

CornerNet-Lite:CornerNet-Saccade(attention mechanism)+ CornerNet-Squeeze

CornerNet-Saccade:缩小的图像中产生的目标框,加上attention map,预测一组可能的目标位置。在每个位置附近取一个小区域,检测目标。对检测的目标位置排序,取前k个,运行NMS。

模型加速:SqueezeNet/MobileNets for CornerNet-Squeeze

替换3 × 3 kernels 成 1 × 1 kernels;

减少输入通道 to 3 × 3 kernels;

下采样.

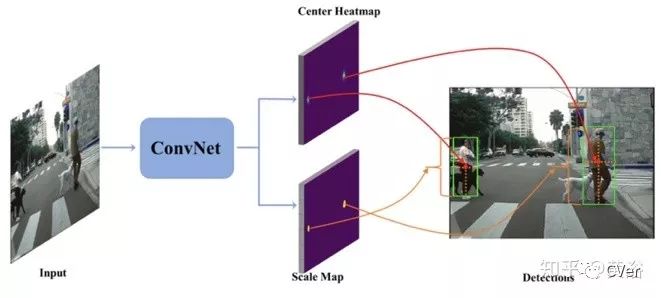

Center and Scale Prediction: A Box-free Approach for Object Detection

主要思想是:目标中心点,语义抽象。

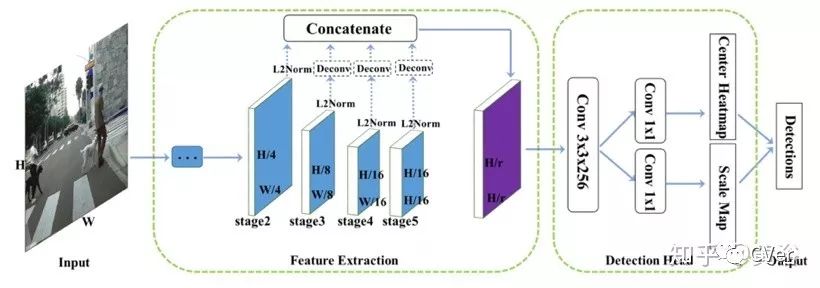

目标检测变成一个直接的中心和尺度预测。最后卷积有两个通道,一个是关于中心位置的热图,另一个是中心的尺度图。

包括两个成分:特征提取和检测。前者把不同分辨率的特征图连在一起,后者是卷积层和两个预测层,分别对应中心位置和尺度大小。

*延伸阅读

点击左下角“阅读原文”,即可申请加入极市目标跟踪、目标检测、工业检测、人脸方向、视觉竞赛等技术交流群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

觉得有用麻烦给个看啦~