【泡泡一分钟】一种应用于人形机器人SLAM系统的组合RGB和深度信息的描述符

每天一分钟,带你读遍机器人顶级会议文章

标题:A Combined RGB and Depth Descriptor for SLAM with Humanoids

来源:2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

作者:Rasha Sheikh Stefan Oßwald Maren Bennewitz

编译:章绩伟

审核:陈世浪,颜青松

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权。

摘要

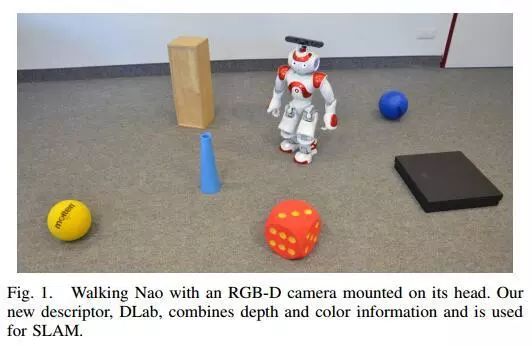

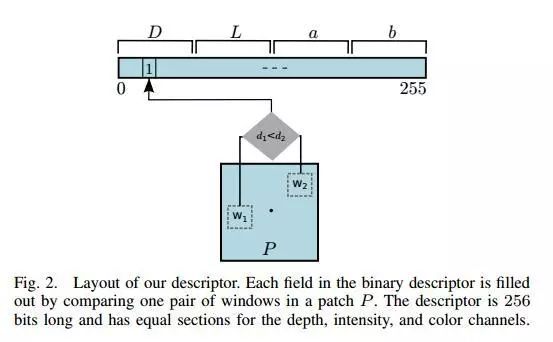

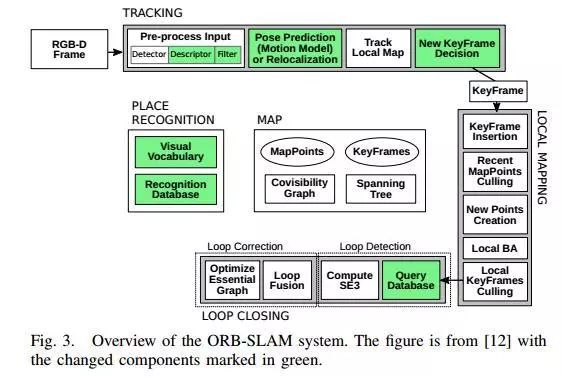

在本文中,我们提出了一个用于人形机器人的视觉即时定位和地图构建(SLAM)系统。我们引入了一种称为DLab的新二进制描述符,它利用颜色,深度和强度的组合信息来实现唯一性,可重复性和稳健性。我们在ORB-SLAM中使用DLab描述符。在ORB_SLAM中我们用修改后的FAB-MAP模块替换了原有的地点识别模块,FAB-MAP模块使用我们的二进制描述符与新建的码本一起工作。

图1 步行机器人Nao,其头部安装了RGB-D摄像头。 我们的新描述符DLab结合了深度和颜色信息并用于SLAM。

图2 描述符的布局。 通过比较补丁P中的一对窗口来填充二进制描述符中的每个字段。描述符有256位并且具有用于深度,强度和颜色通道的相等部分。

图3 ORB-SLAM系统概述。 该图来自文献[12],更改的组件标记为绿色。

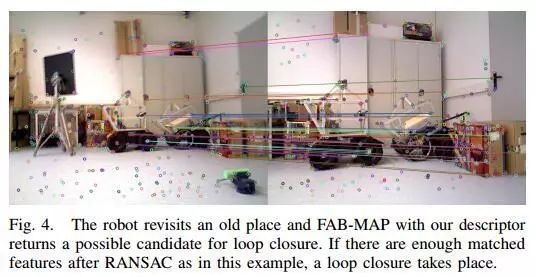

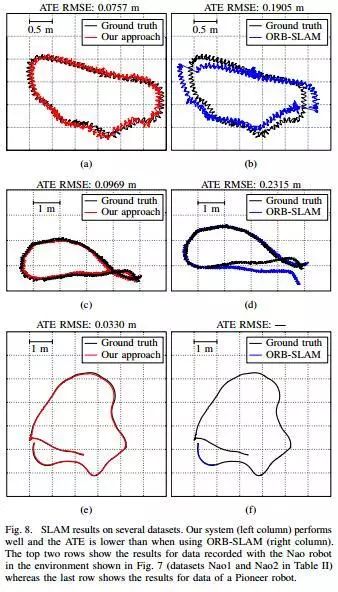

在模拟实验和配备了RGB-D相机的真实人形机器人实验中,我们发现DLab与其他描述符相比具有优越的性能。特征跟踪和位置识别的应用表明,即使在图像严重模糊的序列中新描述符也能够可靠地跟踪特征,并且对于识别相似图像它具有更高的正确率。因此,与ORB-SLAM相比,我们提出的视觉SLAM系统具有更低的绝对轨迹误差,并且能够准确跟踪机器人的轨迹。

图4 机器人重新访问一个旧位置时,FAB-MAP使用我们的描述符返回一个可能的回环候选者。 如果在RANSAC之后有足够的匹配特征,则发生回环。

图5 将图像平移10个像素时各种描述符的精度-召回曲线。每个点表明当考虑与描述符之间的特定最大距离的匹配时的精度和召回率。 可以看出DLab表现最佳,因为它具有最高的召回率和精度。

图6 将图像旋转30°时的精度-召回曲线。 显然,精度低于仅进行平移变换的情况。 同样,DLab具有最高的精度。

图7 记录轨迹的环境

图8 SLAM在几个数据集上产生结果。 我们的系统(左栏)表现良好,ATE低于使用ORB-SLAM(右栏)时的情况。前两行显示了在图7所示环境中用Nao机器人记录的数据结果而最后一行显示了Pioneer机器人的数据结果

Abstract

In this paper, we present a visual simultaneous localization and mapping (SLAM) system for humanoid robots. We introduce a new binary descriptor called DLab that exploits the combined information of color, depth, and intensity to achieve robustness with respect to uniqueness, reproducibility, and stability. We use DLab within ORB-SLAM, where we replaced the place recognition module with a modification of FAB-MAP that works with newly built codebooks using our binary descriptor. In experiments carried out in simulation and with a real Nao humanoid equipped with an RGB-D camera, we show that DLab has a superior performance in comparison to other descriptors. The application to feature tracking and place recognition reveal that the new descriptor is able to reliably track features even in sequences with seriously blurred images and that it has a higher percentage of correctly identified similar images. As a result, our new visual SLAM system has a lower absolute trajectory error in comparison to ORB-SLAM and is able to accurately track the robot’s trajectory。

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com