Graph Normalization (GN):为图神经网络学习一个有效的图归一化

极市专栏

论文推荐:在图神经网络里面,应该如何选择更好的归一化技术?本文将介绍一种为图神经网络学习有效的图归一化的方式。

摘要

Learning Graph Normalization for Graph Neural Networks

https://arxiv.org/abs/2009.11746

Source Code:

https://github.com/cyh1112/GraphNormalization

背景

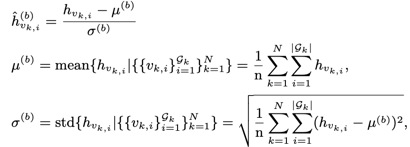

核心思想介绍

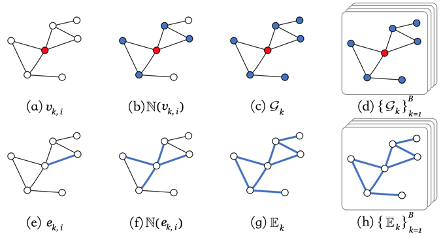

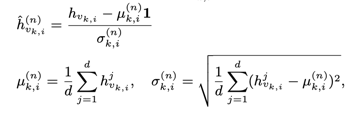

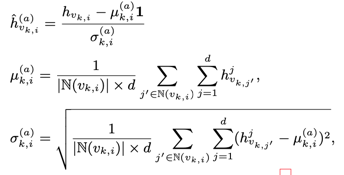

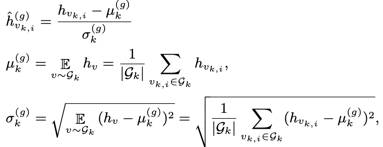

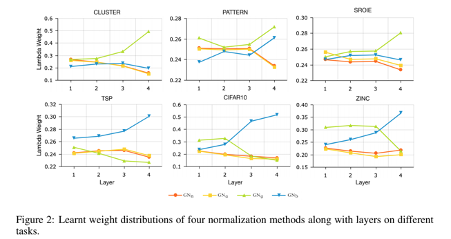

4种归一化方法分析

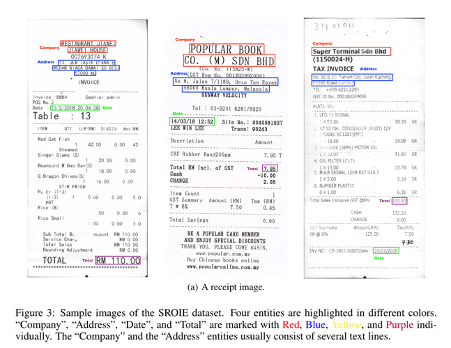

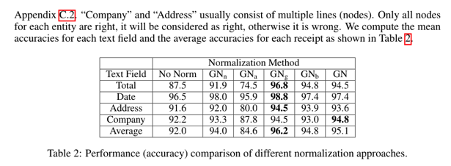

实验

结论

作者团队

登录查看更多

相关内容

专知会员服务

78+阅读 · 2020年5月31日

Arxiv

15+阅读 · 2020年3月26日

Arxiv

13+阅读 · 2019年5月22日

Arxiv

13+阅读 · 2018年9月7日