题目: GRAPH-BERT : Only Attention is Needed for Learning Graph Representations

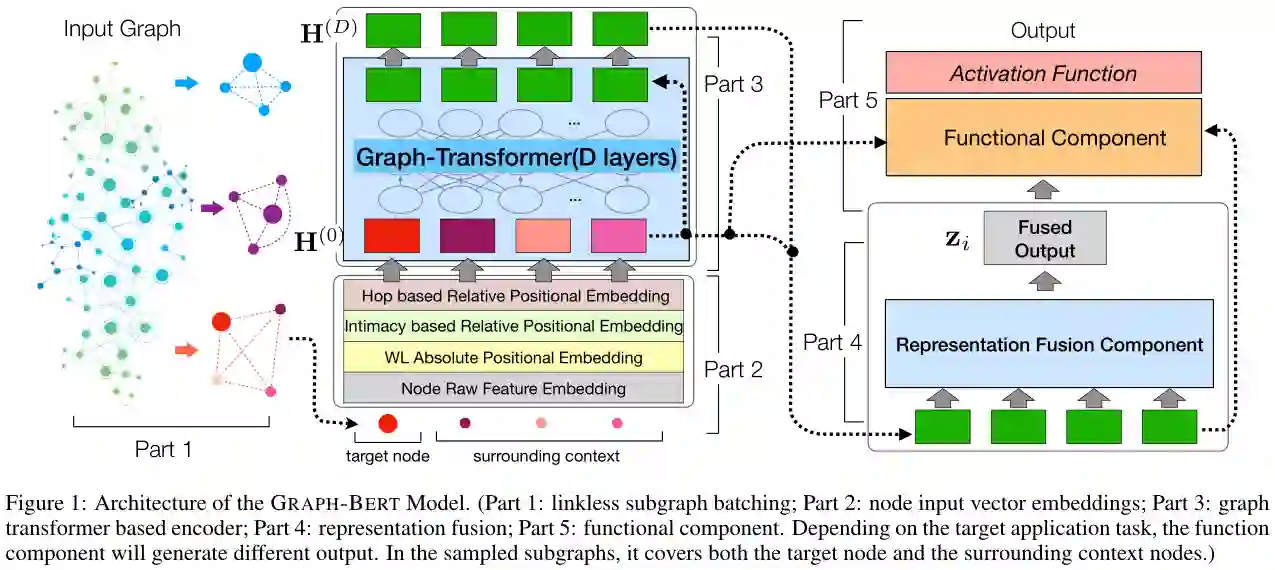

摘要: 主要的图神经网络过度依赖于图链接,已经出现了一些严重的性能问题,如假死问题和过平滑问题。更重要的是,内在的相互连接特性阻止了图数据中的并行化,这对于大型图数据非常重要,因为内存限制限制了节点间的批处理。在本文中,我们将介绍一种新的图神经网络,即基于图的BERT(Graph-BERT ),它完全基于注意力机制,没有任何图的卷积或聚合操作。我们不再用完整的大输入图来训练Graph-BERT,而是在局部上下文中用抽取的无链接子图来训练Graph-BERT。Graph-BERT可以在独立模式下有效地学习。同时,如果有任何监督的标签信息或特定的应用导向的目标可用,一个预先训练的Graph-BERT也可以直接转移到其他应用任务中,或者进行必要的微调。我们在几个图基准数据集上测试了Graph-BERT的有效性。在节点属性重构和结构恢复任务的预训练Graph-BERT的基础上,进一步对节点分类和图聚类任务的Graph-BERT进行微调。实验结果表明,该算法在学习效率和学习效果上都优于现有的神经网络算法。

成为VIP会员查看完整内容

相关内容

专知会员服务

85+阅读 · 2020年1月15日

专知会员服务

115+阅读 · 2020年1月3日