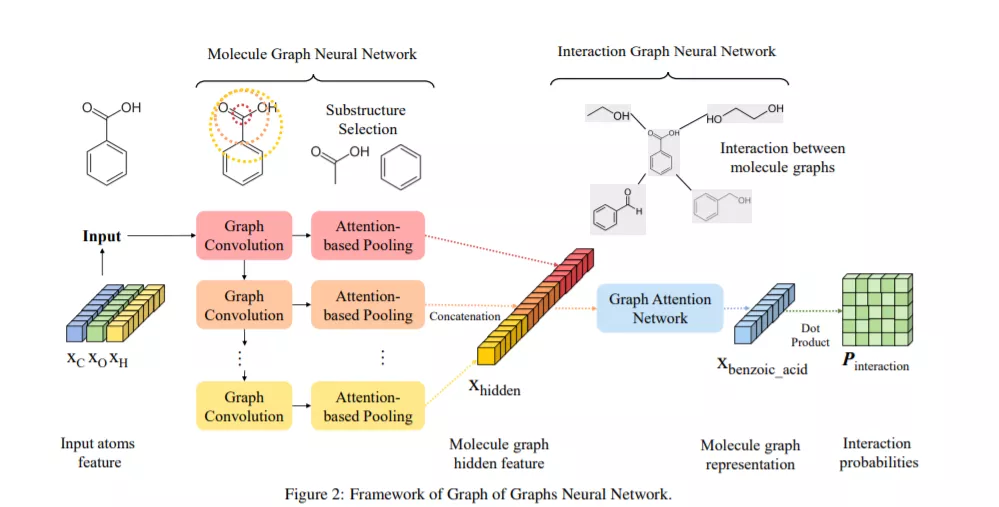

实体交互预测在许多重要的应用如化学、生物、材料科学和医学中是必不可少的。当每个实体由一个复杂的结构(即结构化实体)表示时,这个问题就变得非常具有挑战性,因为涉及到两种类型的图:用于结构化实体的局部图和用于捕获结构化实体之间交互的全局图。我们注意到,现有的结构化实体交互预测工作不能很好地利用图的唯一图模型。在本文中,我们提出了一个图的神经网络图,即GoGNN,它以分层的方式提取了结构化实体图和实体交互图中的特征。我们还提出了双重注意力机制,使模型在图的两个层次上都能保持相邻的重要性。在真实数据集上的大量实验表明,GoGNN在两个有代表性的结构化实体交互作用预测任务上的表现优于最先进的方法:化学-化学交互作用预测和药物-药物交互作用预测。我们的代码可以在Github上找到。

成为VIP会员查看完整内容