题目: GNNExplainer: Generating Explanations for Graph Neural Networks

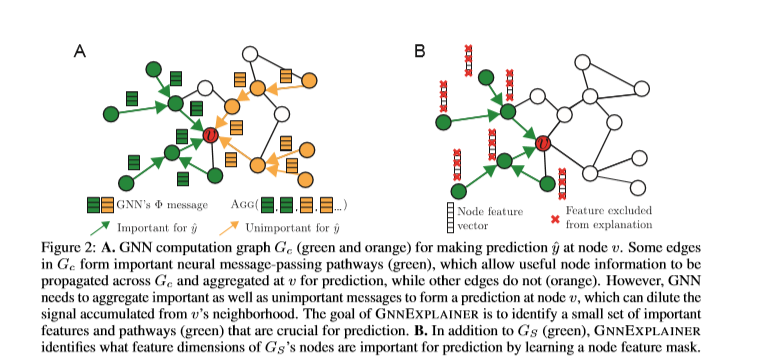

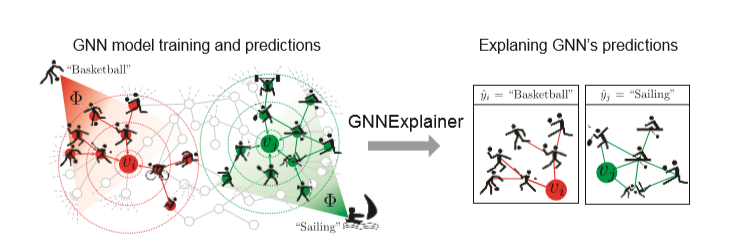

简介: 图神经网络(GNN)通过沿输入图的边缘递归传递神经消息,将节点特征信息与图结构结合在一起。但是同时包含图结构和特征信息会导致模型复杂,并且解释GNN所做的预测仍未解决。在这里,我们提出GNNExplainer,这是第一种通用的,与模型无关的方法,可为任何基于GNN的模型的预测提供可解释性。给定一个实例,GNNExplainer会确定紧凑的子图结构和节点特征的一小部分,这些特征对GNN的预测至关重要。此外,GNNExplainer可以为整个实例类生成一致而简洁的解释。我们将GNNExplainer公式化为优化任务,该优化任务可最大化GNN的预测与可能的子图结构的分布之间的相互信息。在合成图和真实世界图上进行的实验表明,我们的方法可以识别重要的图结构以及节点特征,并且比基准性能高出17.1%。 GNNExplainer提供了各种好处,从可视化语义相关结构的能力到可解释性,再到洞悉有缺陷的GNN的错误。

作者简介: 领域的大牛Jure Leskovec,是斯坦福大学计算机学院的副教授,也是图表示学习方法 node2vec 和 GraphSAGE 作者之一。研究重点是对大型社会和信息网络进行挖掘和建模,它们的演化,信息的传播以及对它们的影响。 调查的问题是由大规模数据,网络和在线媒体引起的。 Jure Leskovec主页

成为VIP会员查看完整内容

相关内容

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

66+阅读 · 2020年4月17日

专知会员服务

78+阅读 · 2020年3月1日

专知会员服务

146+阅读 · 2019年12月10日

Arxiv

59+阅读 · 2020年1月20日

Arxiv

6+阅读 · 2019年9月27日

Arxiv

11+阅读 · 2018年5月16日