ICLR 2022 | 腾讯ARC Lab议程速览!Transformer、图像检索新工作

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

▋论文速览

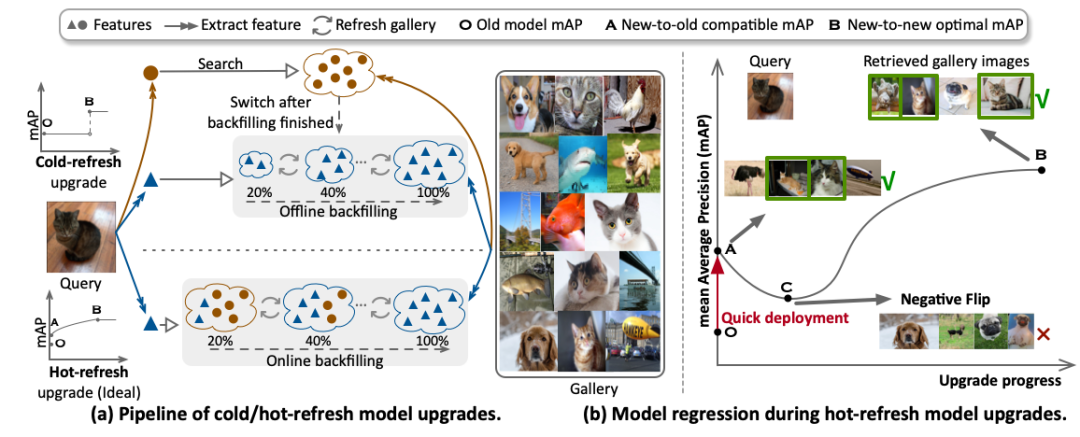

Hot-Refresh Model Upgrades with Regression-Free Compatible Training in Image Retrieval

模型升级对于提升检索系统性能、改善用户体验至关重要,传统的冷刷新式模型升级需要在部署新模型之前将所有底库中的特征刷新,考虑到工业界亿级数据量,这种特征回填的过程可能持续数月。本文首次引入的热刷新式模型升级可以通过兼容学习使得新模型可以即时部署,且使得底库特征可以在线动态地更新,从而大大缩短了模型迭代周期。然而传统的兼容训练在热刷新升级过程中会遇到模型退化的现象,即在升级过程的初期阶段系统性能出现下降趋势,我们分析这种现象是由新->旧正例对的距离小于新->新负例对的距离造成的。因此,我们提出了退化缓解的兼容训练方法来缓解模型退化问题。此外,为了进一步加速模型性能的提升,我们在推理阶段引入了一种高效的基于不确定性的特征回填策略。我们在大规模检索数据集(Google Landmark)上进行实验测试,来证明本文方法的有效性。

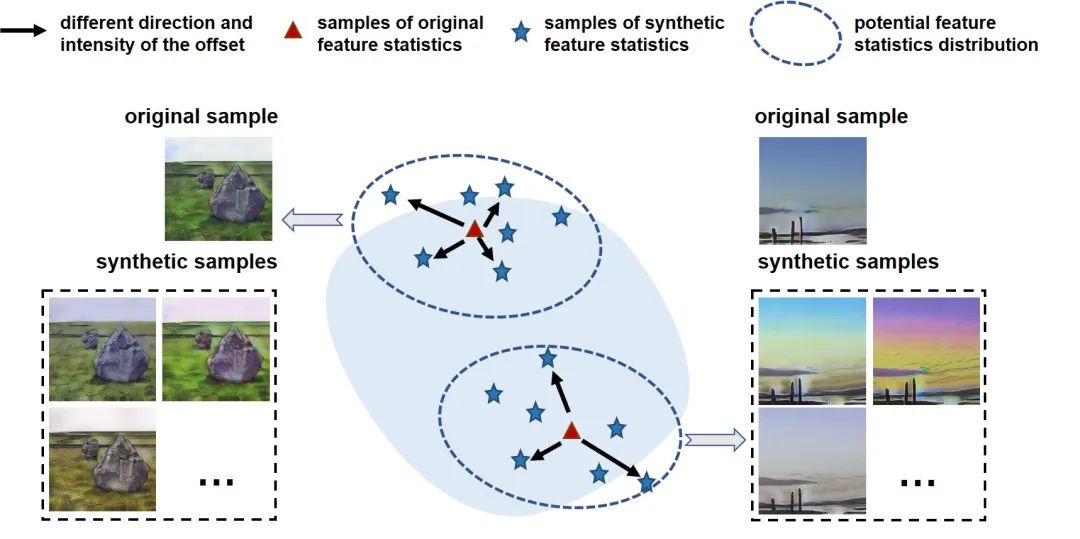

Uncertainty Modeling for Out-of-Distribution Generalization

尽管近年来深度神经网络在各项视觉任务中取得了突出的进展,其仍会在与训练数据非独立同分布的场景下表现出严重的性能下降。在本文中,我们认为对携带有训练数据领域特征的特征统计量信息进行适当地处理可以有效地提高深度学习模型应对不同域偏移的鲁棒性。我们通过考虑到由于训练和测试场景存在的潜在领域偏移所带来的不确定性统计量差异。在网络训练阶段对领域偏移所带来的统计分布不确定性进行建模来提高网络泛化能力。具体来说,我们假设每一个特征统计量在考虑了潜在的不确定性后遵循一个多元高斯分布。因此,每个特征统计量不再是一个确定的属性,而是具有不同分布可能性的概率性值。我们可以利用带有不确定性特征统计数据训练模型以减轻域扰动带来的影响,并针对潜在的域偏移实现更好的模型鲁棒性。我们的方法可以很容易地集成到网络中并且无需额外的参数。大量实验表明,我们提出的方法可以持续提高网络在多个视觉任务上的泛化能力,包括图像分类、语义分割和实例检索任务等。

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer6666,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信: CVer6666,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看