![]()

![]()

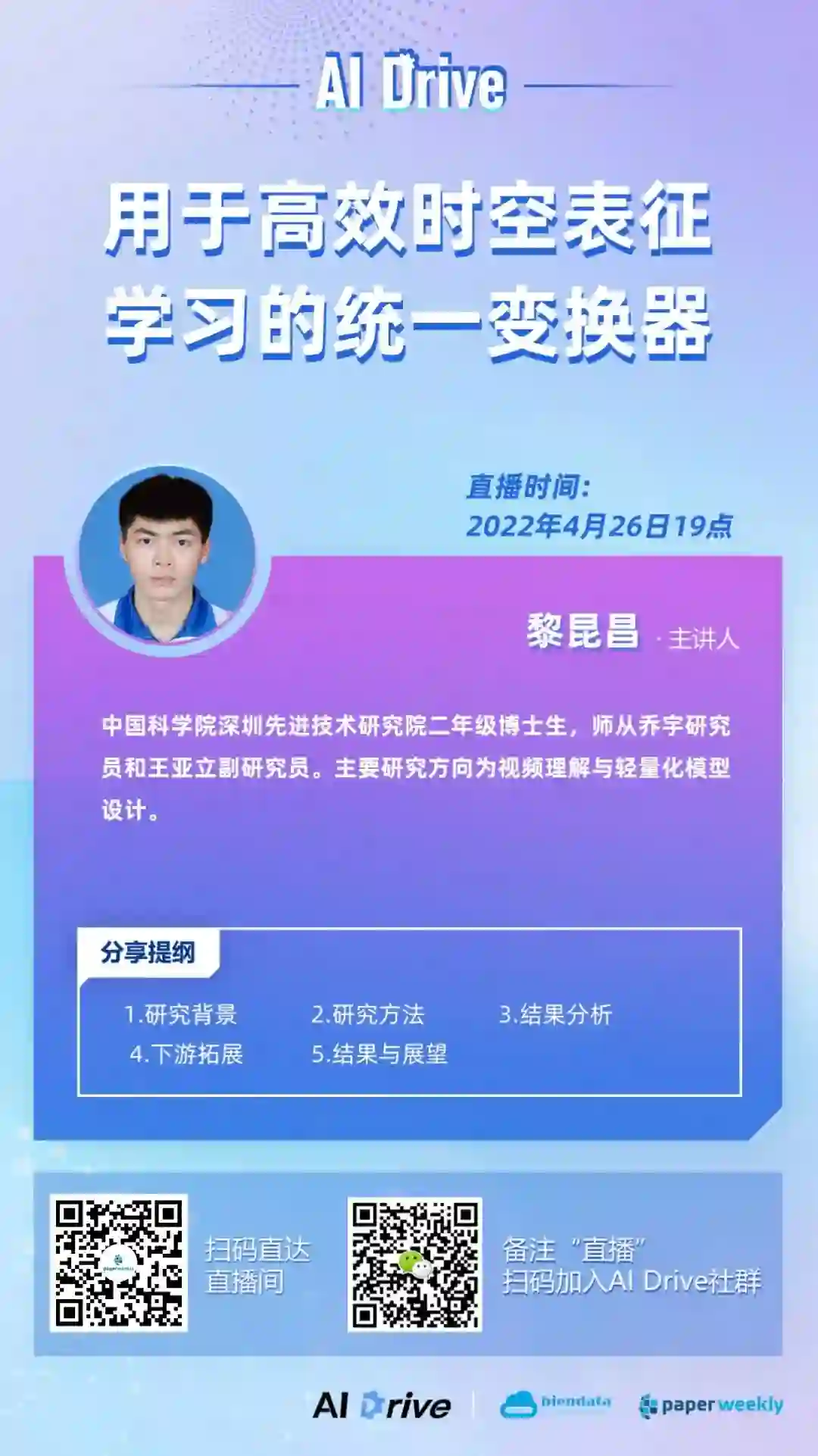

本期 AI Drive,我们邀请到中国科学院深圳先进技术研究院在读博士生黎昆昌,为大家在线解读其发表在 ICLR 2022 的最新研究成果。本次报告的主题为

「UniFormer:用于高效时空表征学习的统一变换器」

。对本期主题感兴趣的小伙伴,4 月 26 日(本周二)晚 7 点,我们准时相约 PaperWeekly 直播间。

直播信息

视频帧间存在巨大的局部冗余性与复杂的全局依赖性,使得从视频中学习丰富的多尺度语义信息极具挑战。现有的两大主流模型 CNN 和 ViT,往往只关注解决问题之一。卷积只在局部小邻域聚合上下文,天然地避免了冗余的全局计算,但受限的感受野难以建模全局依赖;而自注意力通过比较全局相似度,自然将长距离目标关联,但可视化分析表明,自注意力在浅层编码局部特征十分低效。

在 UniFormer 中,我们以 Transformer 的风格统一了卷积与自注意力,在网络浅层和深层分别解决冗余性与长时依赖性两大问题。

实验表明,UniFormer 不仅在视频分类上性能优越,而且拓展到图像分类、检测、分割和姿态估计任务上,同样效果显著。

UniFormer: Unified Transformer for Efficient Spatiotemporal Representation Learning

收录会议:

论文链接:

https://openreview.net/forum?id=nBU_u6DLvoK

演讲提纲

研究背景

研究方法

结果分析

下游拓展

结果与展望

嘉宾介绍

黎昆昌,中国科学院深圳先进技术研究院二年级博士生,师从乔宇研究员和王亚立副研究员。主要研究方向为为视频理解与轻量化模型设计。

直播地址

本次直播将在 PaperWeekly 视频号和 B 站直播间进行,

扫描下方海报二维码

或点击

阅读原文

即可免费观看。

点击下方 PaperWeekly 视频号预约按钮,第一时间获取开播提醒。

https://live.bilibili.com/14884511

![]()

![]()

合作伙伴

![]()

![]()

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()