作者:腾讯ARC Lab & 腾讯OVB-AI技术中心

颠覆传统「冷刷新」模型升级范式,腾讯 ARC Lab、清华大学及腾讯在线视频 BU-AI 技术中心针对大规模检索系统推出「热刷新」模型升级的新机制,实现新模型即时部署上线、精度稳步在线提升等特性,并针对刷新过程中的模型退化问题提出有效解决方案。论文已被 ICLR 2022 接收,这是热刷新模型升级在学术界的首秀,领域主席(AC)评价「这是真实世界的图像检索系统中一个非常实用且重要的问题」。「热刷新」模型升级算法已成功部署在腾讯 PCG 视频关系中台,为千亿级向量索引系统提供快速模型升级服务,迭代效率提升 4 + 倍。

![]()

图像检索的应用在生活中无处不在,例如人脸识别、版权检测、图像定位等等,检索系统在推理时需要利用部署好的模型对查询图像进行特征提取,再与底库中所有预先提取好并存储的图像特征进行比对。对检索系统中部署的模型进行更新迭代是提升检索精度、改善用户体验的必经之路。

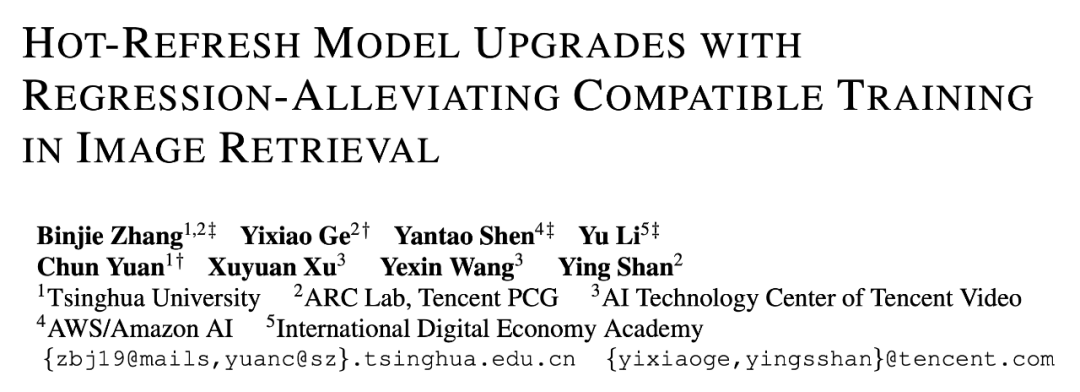

在传统的检索模型升级过程中,需要先用新模型离线刷新底库中的所有特征(称之为特征「回填」),再将新模型部署上线,这一过程被称之

「冷刷新」模型升级

。大规模检索系统往往存在海量的底库图像,将其全部离线刷新一遍可能花费数周乃至数月,冷刷新模型升级存在模型迭代的时间成本高、用户体验不能得到即时改善等几大弊端。

为此,

研究者首次提出「热刷新」模型升级方案

,兼容学习 [1] 训练的新模型所提取的新特征由于可以与底库中的旧特征直接对比,所以无需特征回填便可即时部署上线新模型;同时,由于新特征与旧特征直接可比、可互换,所以在新模型部署上线后,可以利用新模型在线刷新底库特征,实现检索精度的逐步爬升,直至全部底库特征刷新完毕。

如下图所示,「热刷新」模型升级机制无需等待离线特征回填,精度即时提升 (O→A) 且用户体验逐步改善(A→B),离无缝模型升级更近一步。

![]()

在过往的兼容学习 [1] 工作中也曾有对模型即时部署的阐述,研究者提出新模型的兼容特性,使其可以在无特征回填的情况下部署上线,这种升级策略被称之为

「无刷新」模型升级

。在该策略下,底库特征始终保持不变,限制了新模型的精度上限,在多代模型升级后劣势尤其显著。

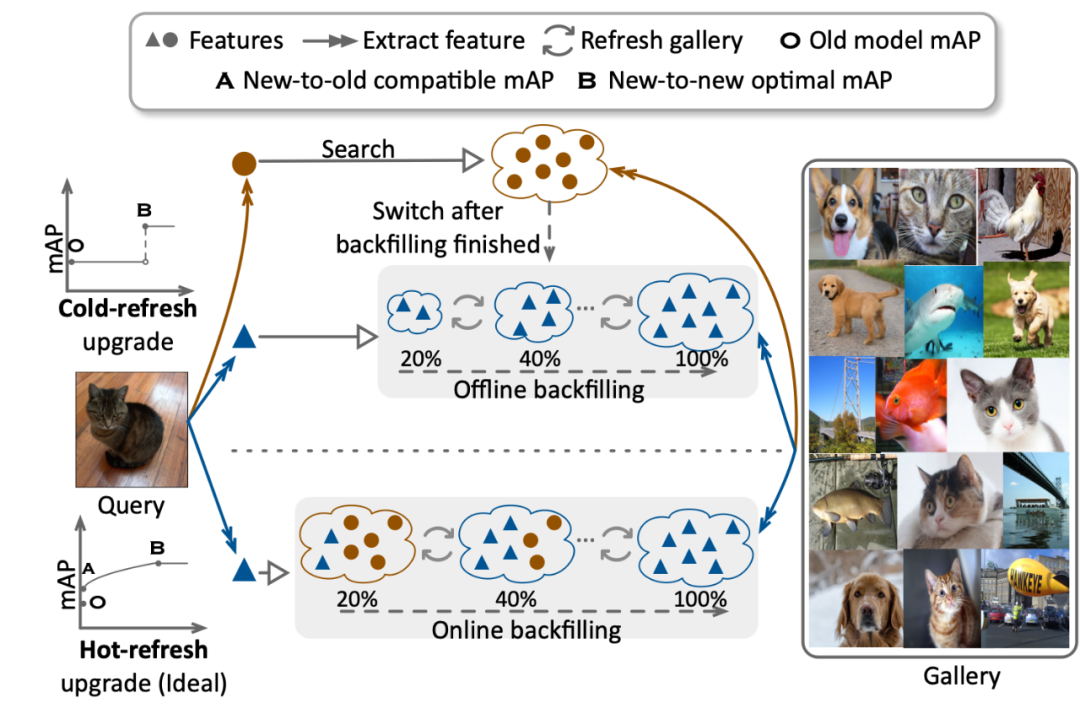

如下图所示,虚线为「无刷新」模型升级,实线为「热刷新」模型升级。从三次模型升级迭代后的精度变化中,可以明显观察出「热刷新」模型升级的优势。大家可能发现,热刷新过程中,模型精度出现了短暂的下降,这也就是下文要继续介绍的「模型退化」(model regression)问题。

![]()

「热刷新」模型升级(实线)& 「无刷新」模型升级(虚线)

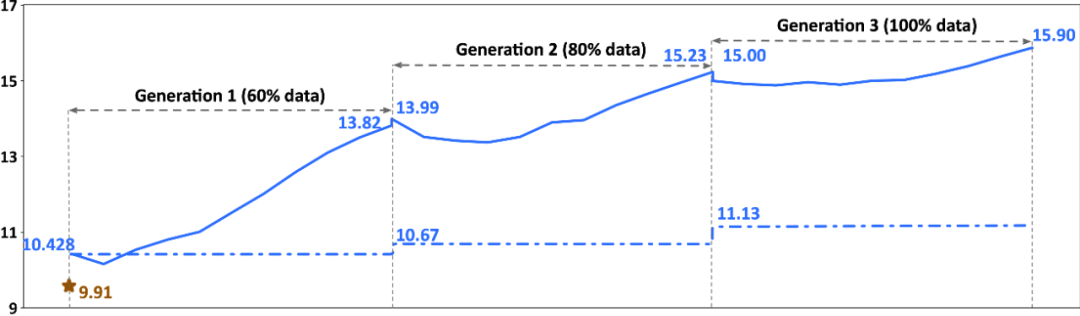

尽管现有的兼容训练算法使得热刷新模型升级成为了可能,但他们均面临刷新过程中的

「模型退化」

问题,即升级中检索精度的下降,如下图所示(A→C)。

![]()

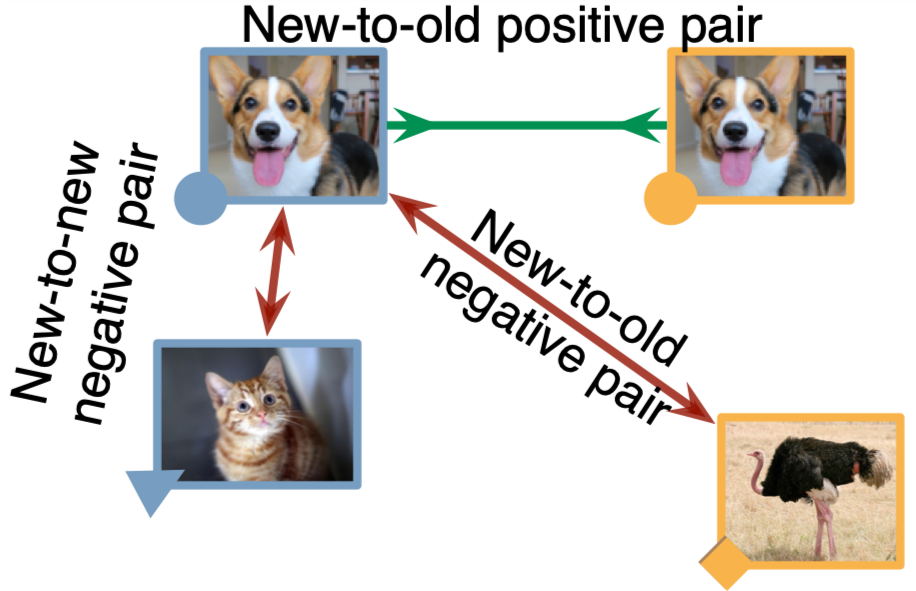

研究者发现,这实际上是由升级过程中的

负翻转

造成,负翻转指的是旧检索系统中可以正确识别的查询图像在热刷新升级过程中被错误识别。而造成负翻转的最主要原因,是在底库特征在线回填过程中,存在新→新负样本对距离小于新→旧正样本对距离的情况,如下图所示。

![]()

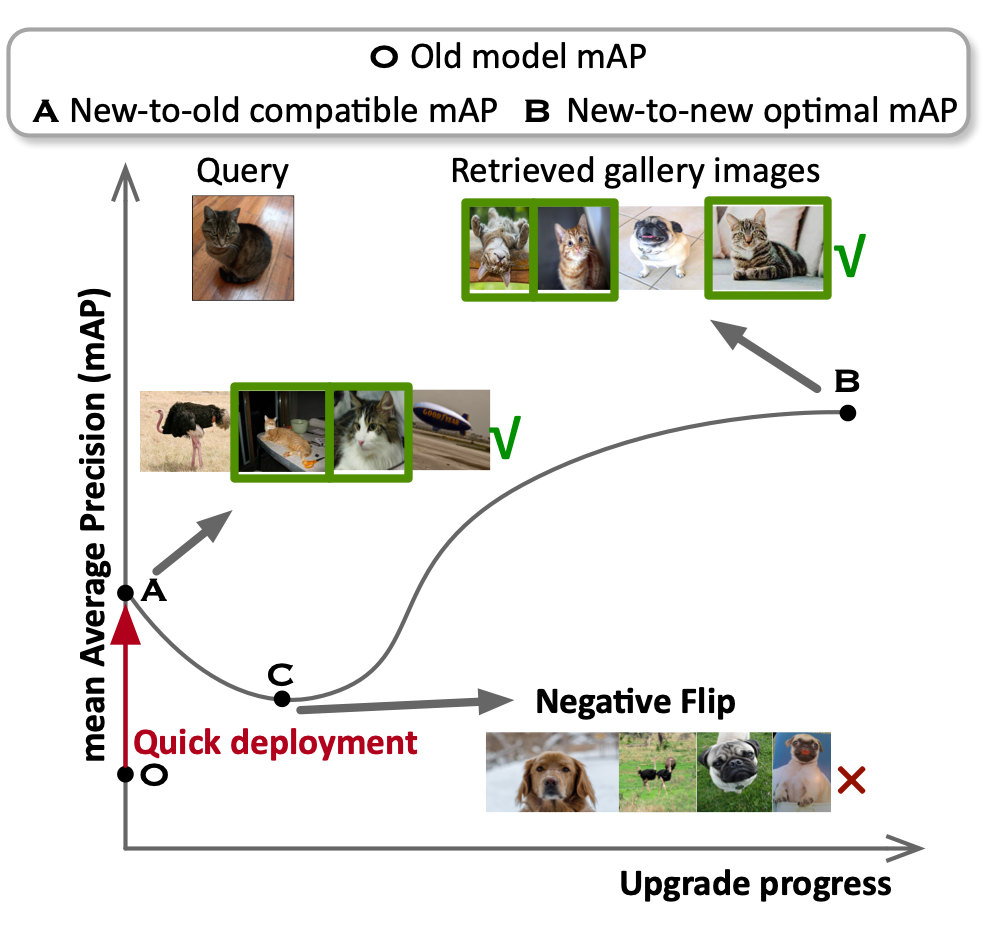

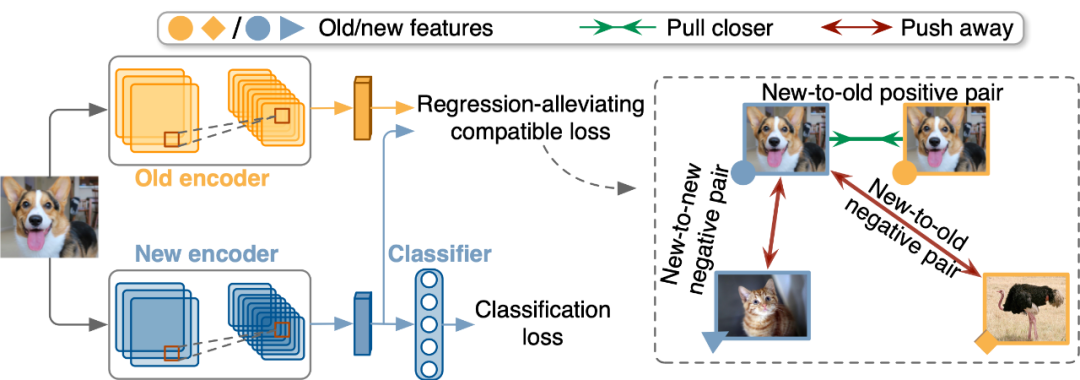

为了缓解热刷新模型升级过程中的模型退化问题,作者提出了一种简单有效的正则化,即约束新→旧正样本对距离不光要小于新→旧负样本对距离,也要小于新→新负样本对距离(过往兼容学习算法只约束了前者),并以对比学习的形式呈现。如下图所示,该正则化被称之为缓解退化的兼容损失函数,具体公式不在此呈现,感兴趣的读者可翻阅论文。

![]()

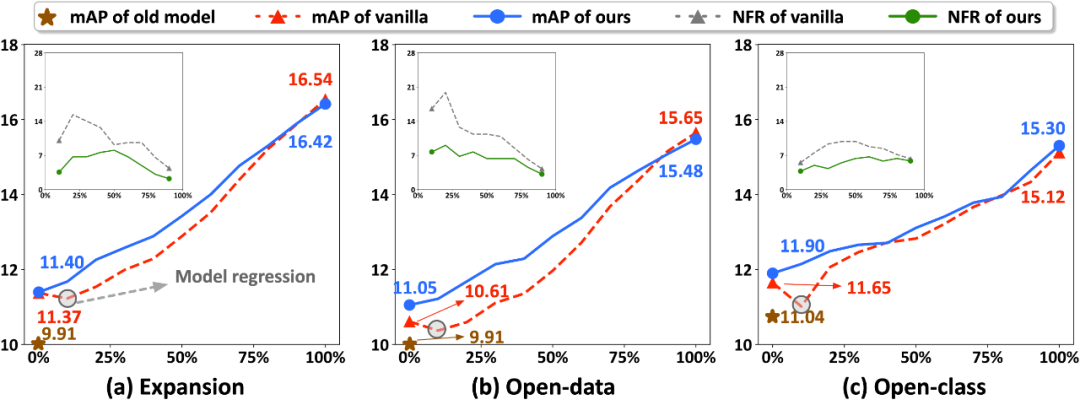

这一正则化看似是对已有兼容损失函数的细微修改,但对于缓解模型退化问题来说起着本质的作用。如下图所示,研究者在 Google Landmark v2 数据集上针对三种不同类型的数据设置(数据拓展、开放数据以及开放类别)进行了实验,均可观察到所提出算法的有效性。同时,他们对热刷新模型升级过程中的负翻转率进行了定义,量化模型退化程度,如图中内嵌小图所示,所提出的算法可有效减少负翻转率。

![]()

传统兼容训练(虚线)& 缓解退化的兼容训练(实线)

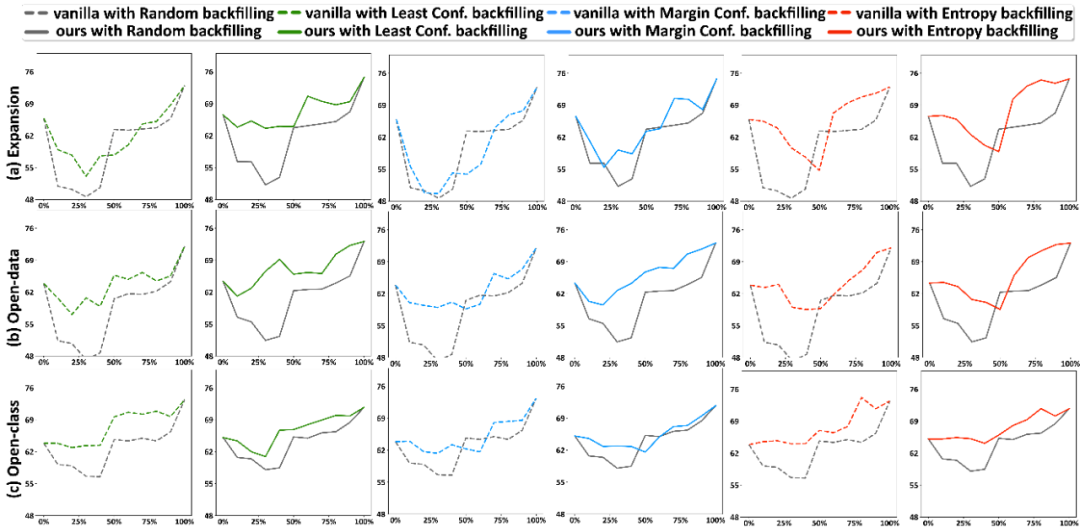

上文提到的损失函数在训练阶段显式地约束新模型减少负翻转的可能性出现,同时研究者也提出一种基于不确定性的底库回填策略,可以在热刷新过程中隐式地减少负翻转。该回填策略基于「辨识度差的特征应优先被刷新」的原则,通过轻量快速地估计底库旧特征的分类不确定性,判断特征的可辨识度。

如下图所示,研究者在 Oxford 数据集上进行了测试,无论在部署传统兼容训练的新模型(虚线)还是缓解退化兼容训练的新模型(实线)时,基于不确定性的回填策略(彩色)都可以间接减轻模型退化问题并实现精度更快更稳定的提升。

![]()

随机回填策略(灰色)& 基于不确定性的回填策略(彩色)

腾讯 PCG - 视频关系中台主要提供视频排重、视频侵权、视频语义关系的检测及数据服务。目前,向包括腾讯视频、腾讯小世界、微信视频号、微视等多个视频业务提供服务,涉及千亿量级的视频指纹特征,模型迭代带来的时间及机器成本十分高昂。而基于兼容特征的「热刷新」方案加速了 4+ 倍算法版本更新效率,同时节约了数百万元的机器成本,使得中台的算法服务可以更加灵活的面对变化多样的业务环境。

该文对热刷新模型升级及其过程中会出现的模型退化问题进行了首次研究和深入剖析,这是实际应用中非常重要的一项任务,研究者希望该论文能够引起公众对业界中高效模型升级瓶颈问题的关注。尽管引入的缓解退化的兼容性正则化可以在一定程度上减少负翻转,但要彻底消除模型退化的问题还有很长的路要走,因此呼吁更多的研究人员加入这个方向进行进一步的研究。

1. Yantao Shen, Yuanjun Xiong, Wei Xia, and Stefano Soatto. Towards backward-compatible representation learning. In CVPR, 2020.

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com