【动态】CSIG云上微表情第26期研讨会成功举办

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)和中国科学院心理研究所主办、CSIG机器视觉专业委员会和CSIG情感计算与理解专业委员会联合承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

第二十六期云上微表情于2022年3月31日晚上7点进行,由中国科学院心理研究所王甦菁老师团队的李婧婷博士主持。此次讲座的主题是基于面部动作单元(AU)的微表情分析,邀请到来自芬兰奥卢大学机器视觉和信号分析中心(CMVS)的博士生李妍特和英国圣安德鲁斯大学计算机学院在读博士生张靓菲来作报告。此次讲座得到了微表情研究领域的广泛关注,期间有八十余名听众参加了此次讲座。

芬兰奥卢大学机器视觉和信号分析中心(CMVS)的博士生李妍特同学

李妍特同学主要介绍了在IEEE FG21上发表的工作,Micro-expression Action Unit Detection with Dual-view Attentive Similarity-Preserving Knowledge Distillation。

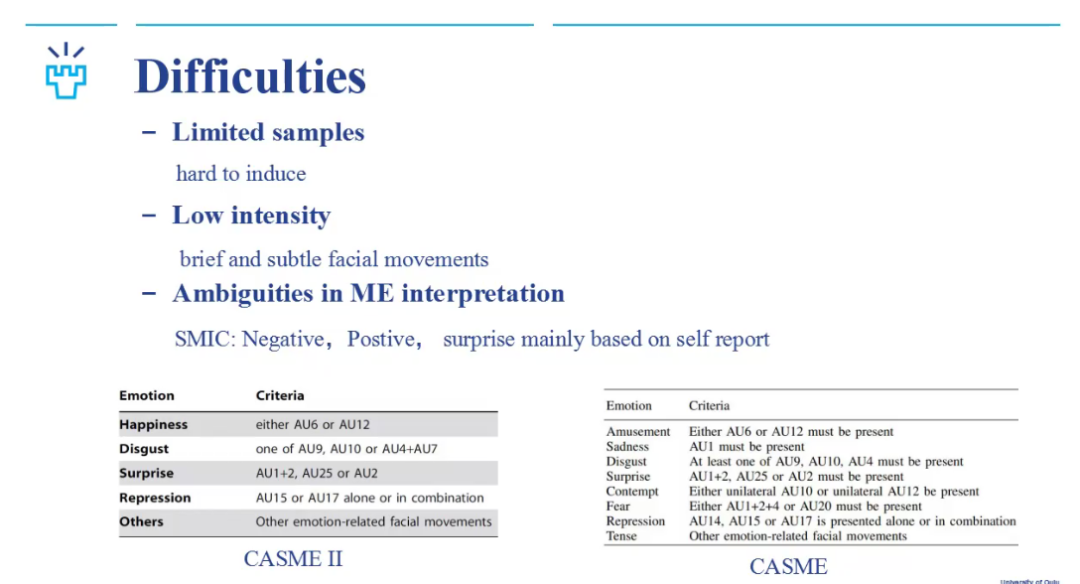

李妍特同学首先介绍了微表情和宏表情的对比、以及微表情的定义。然后展示了微表情研究中存在的困难。特别的,在微表情识别的研究中,由于不同数据库可能会有不同的标注标准,会影响模型学习普适化的特征。

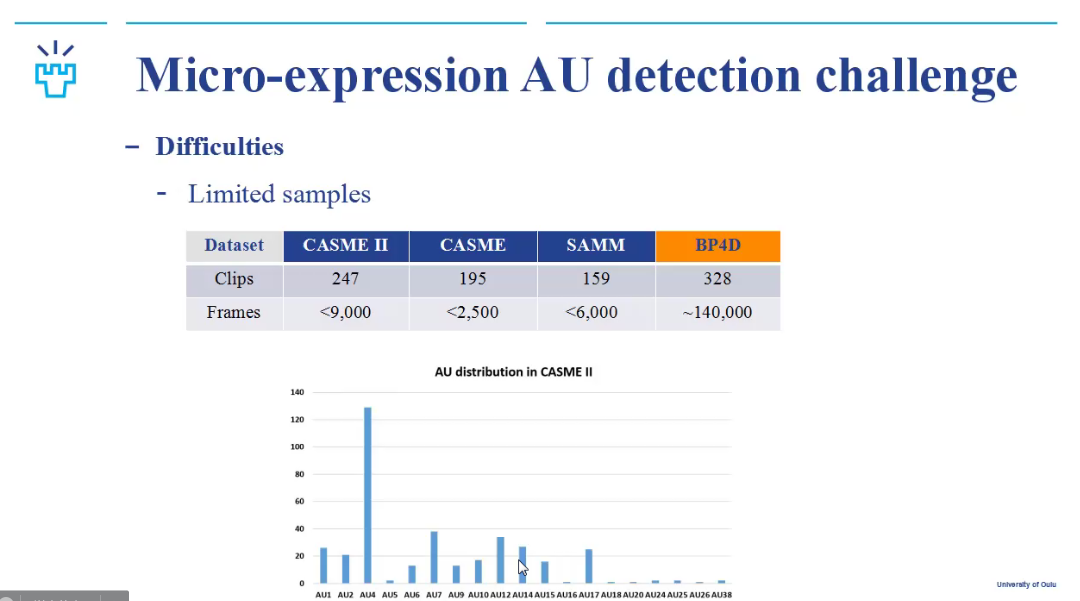

然后李同学对面部动作编码系统(Facial Action Coding System, FACS),和动作单元(Action Unit)进行了介绍,并说明微表情中AU检测研究存在的困难,包括不均衡的分布、样本量很小等问题。

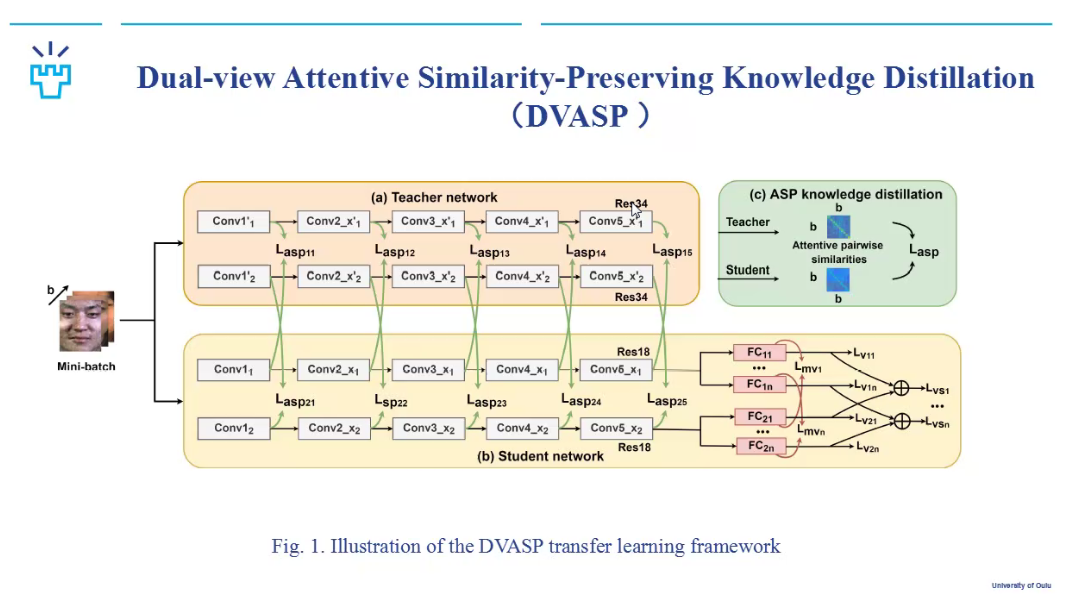

基于上述情况,李同学等人提出了基于双视角注意力相似性保留的知识蒸馏法进行微表情动作单元检测(Micro-expression Action Unit Detection with Dual-view Attentive Similarity-Preserving Knowledge Distillation)。模型框架如下所示:

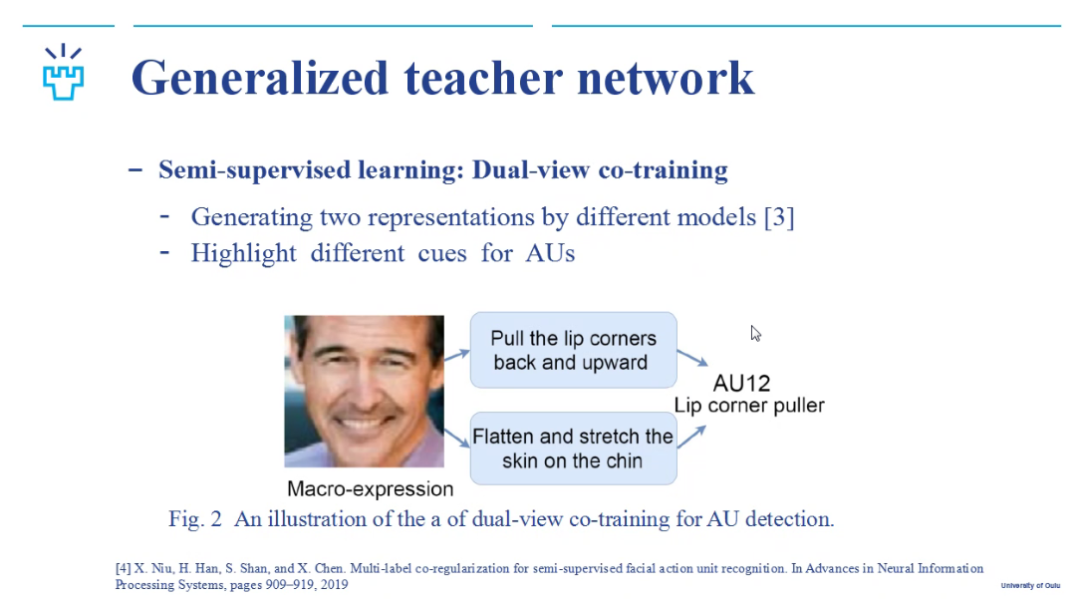

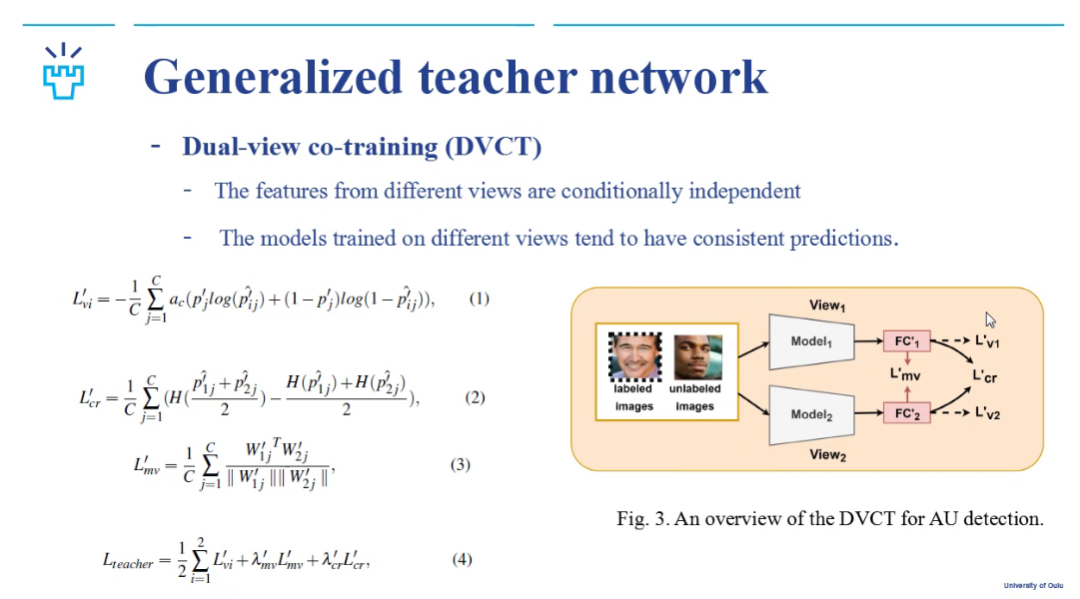

在向听众们介绍了知识蒸馏(Knowledge distillation)的基本概念以后,李同学介绍了她们构建的半监督双视角协同训练的普适化教师网络。由于AU是一种相对客观的面部动作编码方法,就可以通过大规模的人脸表情数据库对模型进行训练。

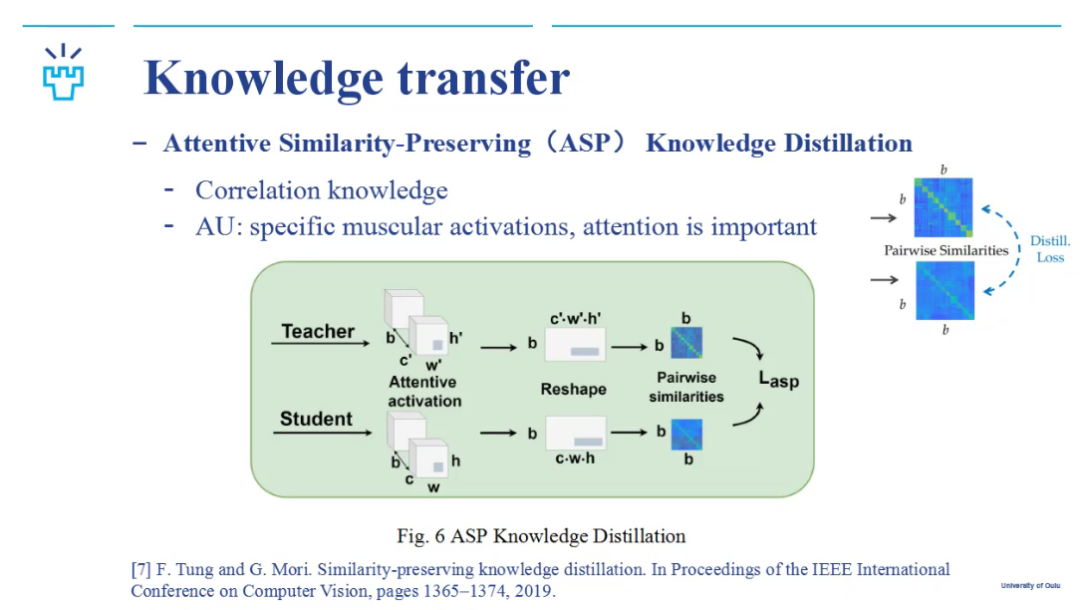

由于宏表情和微表情还是存在差异的。放大微表情面部动作的过程会引起噪声,存在领域偏移(domain shift)的问题。因此,在知识迁移的过程中,AU本身可以有很好的跨域特性,可以一定程度上避免领域偏移。此外,李同学等人首先通过加入注意力机制,减弱领域偏移,使得网络可以有效地从宏表情迁移到微表情。

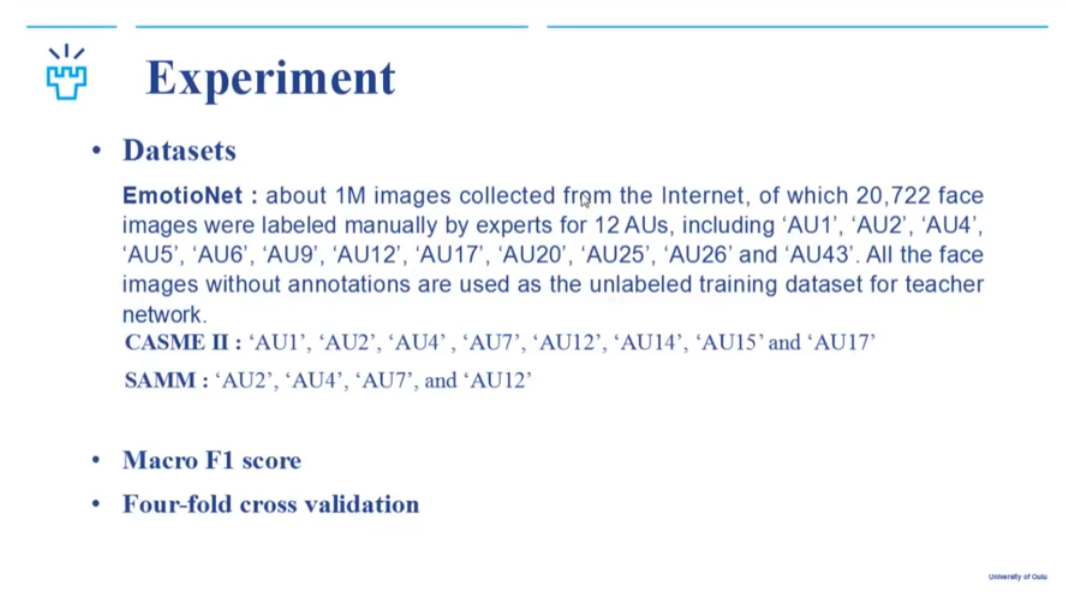

在实验部分,李同学首先介绍了实验设置(如下图所示),并且展示了与SOTA方法比较、消融实验的实验结果。实验表明,李同学等人提出的知识提炼方法可以有效地提炼和转移跨领域的知识,从而应用于具有鲁棒性的微表情AU检测。

在报告的最后,李同学对她们所提方法的贡献进行了总结,并介绍了后续有待探索的要点。

参考文献:

Li, Y., Peng, W., & Zhao, G. (2021, December). Micro-expression Action Unit Detection with Dual-view Attentive Similarity-Preserving Knowledge Distillation. In 2021 16th IEEE International Conference on Automatic Face and Gesture Recognition (FG 2021) (pp. 01-08). IEEE.

英国圣安德鲁斯大学计算机学院在读博士生张靓菲同学

张靓菲同学主要报告了在FME21 (ACM MM21 workshop)上发表的工作,Facial Action Unit Detection with Local Key Facial Sub-region based Multi-label Classification for Micro-expression Analysis。

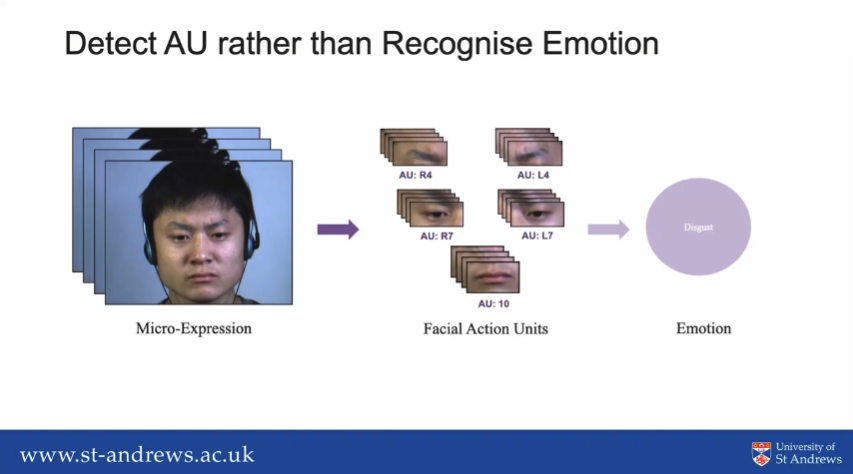

张同学首先介绍了微表情的概念,然后指出目前大部分关于微表情分析的计算机视觉工作都关注于直接识别出微表情所反映出的情绪。然而面部表情是由面部动作所构成的。人脸动作编码系统从人脸解剖学的角度定义了一组面部动作单元(AU),用于精确刻画人脸表情变化。每个AU描述了一组脸部肌肉运动产生的表观变化,不同AU的组合可以表达任意的人脸表情,因此心理学专家通常会通过分析一个微表情中所激活的AU来识别出他所反映的情绪,所以AU也可以被看作是微表情和其反映出的情绪的一个中间变量。

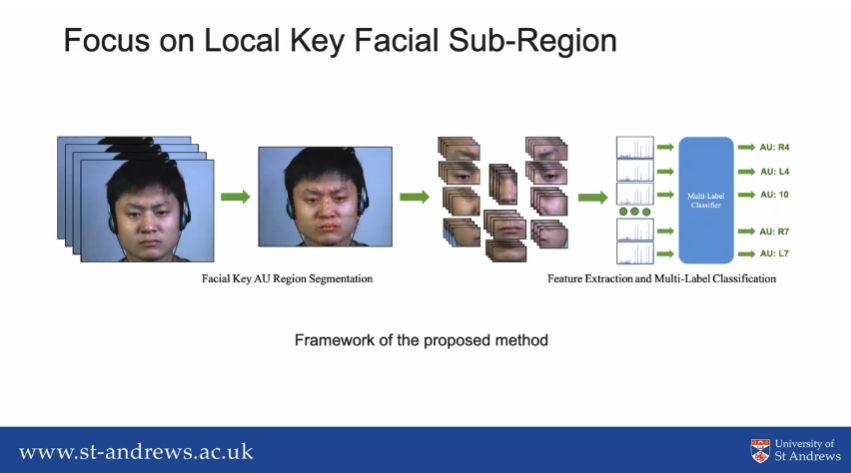

张同学等人聚焦于检测微表情发生时的AU,通过传统计算机视觉方法,拨茧抽丝地来解构整个任务。整体方法流程如下图所示,包含面部关键AU区域分割,特征提取和多标签分类。

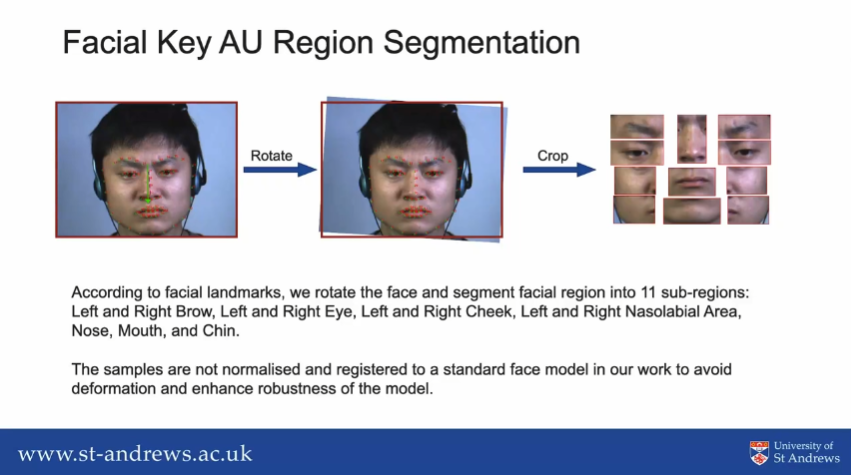

在面部关键AU区域分割的环节,通过面部关键点检测、面部对齐等预处理操作后,张同学从样本中提取出了11个子区域作为AU关键区域进行分析。

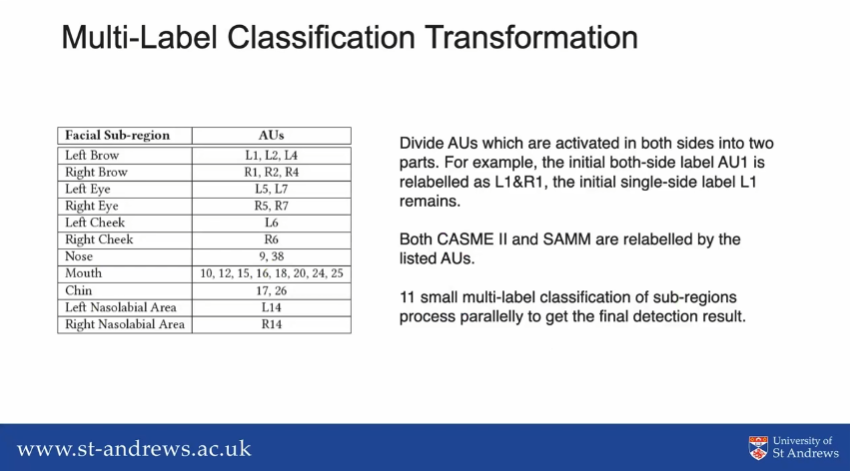

之后,在分割出的每一个子区域分别进行LBP-TOP特征提取,进而进行多标签分类的学习。张同学等人为了能够将AU检测过程化繁为简,将CASME II和SAMM数据集中出现过的所有AU分配到每一个分割出的面部AU关键子区域上,如下图所示。由于每一个AU只会出现在特定的子区域,并且几乎和其他区域无关,所以张同学等人可以将针对整体面部的非常大规模的多标签问题,分解成可以并行处理的11个小规模的多标签分类。

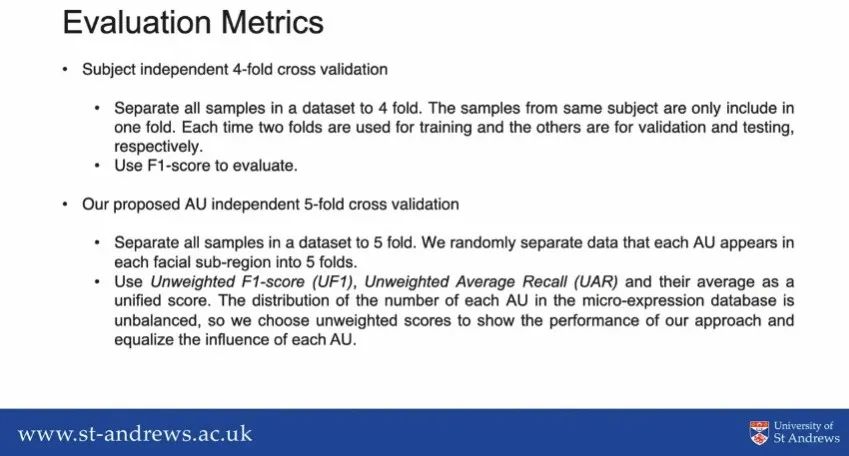

在结果评估部分,通过个体独立的4折交叉验证和AU独立的5折交叉验证(如下图所示),张同学等人在CASME II和SAMM上验证了结果。通过AU区域细化,可以减少不平衡的数据集中出现次数较多的标签对其他类别的影响。跨数据库的实验也验证了张同学等人提出方法的鲁棒性。此外,即使没有使用深度学习方法,该工作也得到了不错的结果,并且几乎可以满足实时检测的需求。

参考文献:

Zhang, L., Arandjelovic, O., & Hong, X. (2021, October). Facial Action Unit Detection with Local Key Facial Sub-region Based Multi-label Classification for Micro-expression Analysis. In Proceedings of the 1st Workshop on Facial Micro-Expression: Advanced Techniques for Facial Expressions Generation and Spotting (pp. 11-18).

在Panel环节,听众和讲者们就微表情数据库AU的人工标注以及AU相关性对算法研究的影响、微表情视频预处理以及算法细节等问题进行了讨论。

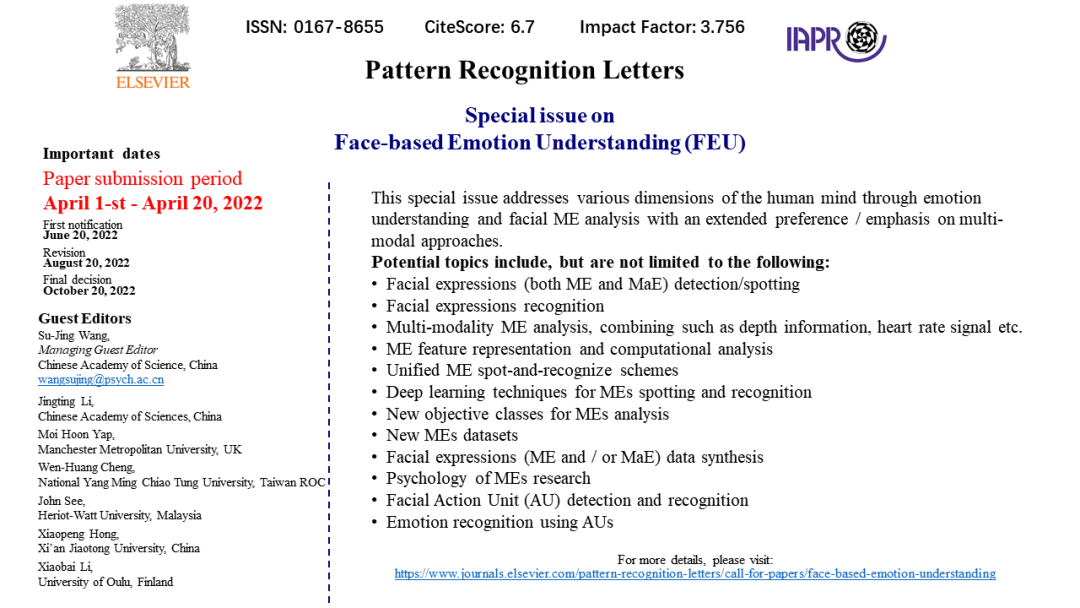

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结并对第二十七期CSIG云上微表情活动进行了预告。此外,王甦菁博士等人在Pattern Recognition Letters申请了主题为“Face-based Emotion Understanding”的专刊,目前投稿窗口已经开放(4月1日-4月20日),欢迎大家关注!

另外,李博士还介绍了将由ACM Multimedia2022举办的微表情挑战赛和微表情研讨会。其中,挑战赛将分为两个任务,分别为长视频中微表情和宏观表情的检测挑战、以及微表情生成挑战。挑战赛和研讨会的相关细节将会在网站上(https://megc2022.github.io)陆续发布,欢迎大家关注!

此次讲座的回放已经发布在B站:https://www.bilibili.com/video/BV1JS4y117BY?share_source=copy_web,欢迎观看!

最后,中国科学院心理研究所微表情实验室(MELAB)诚聘博士后,微表情相关方向、计算机或心理学专业皆可,有意请联系王甦菁老师(wangsujing@psych.ac.cn)。

来源:CSIG机器视觉专委会