CSIG云上微表情第十一期研讨会成功举办--结合计算机视觉的微表情检测与识别

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)主办、CSIG机器视觉专业委员会承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

第十一期云上微表情于2020年12月29日晚上7点进行,由中国科学院心理研究所王甦菁老师团队的李婧婷博士主持。此次讲座的主题是结合计算机视觉的微表情检测与识别,由来自台湾交通大学电子研究所的博士生谢洪霞和中国科学院心理研究所的李婧婷博士分别介绍了相关的研究工作。本次报告得到了微表情研究领域的广泛关注,期间有五十多位听众参加了此次讲座。

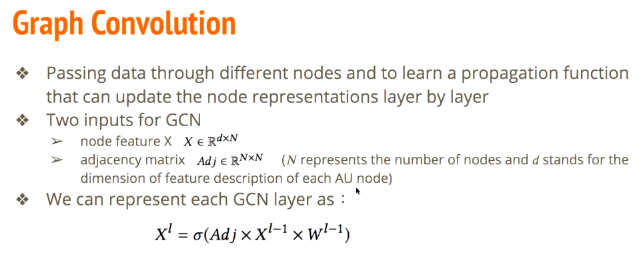

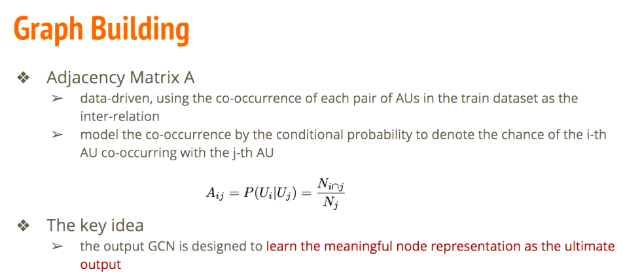

首先,谢洪霞指出GCN网络在人脸分析方面逐渐获得关注,GCN通过其顶点、边以及邻接矩阵来体现节点之间的关系,从而提取到有效特征。对于微表情,其人脸动作单元(Action Unit, AU)具备一定的共同出现的特性,通过图网络来研究AU之间共同出现的关系,从而能够实现对微表情识别有表征性的特征提取。

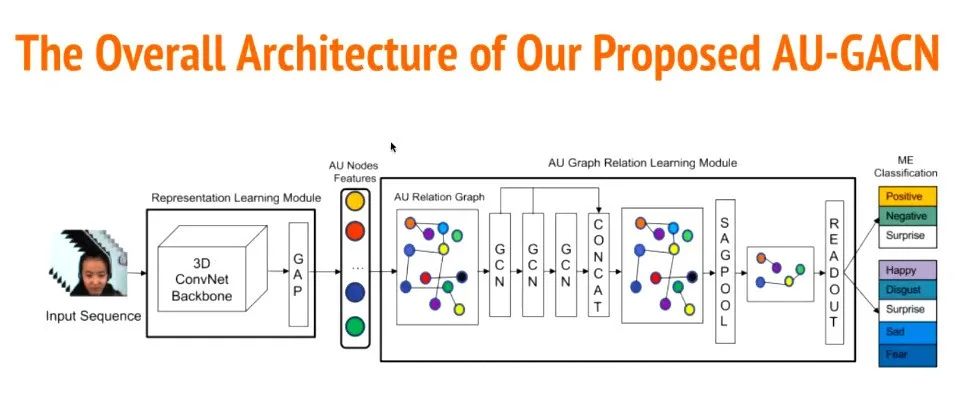

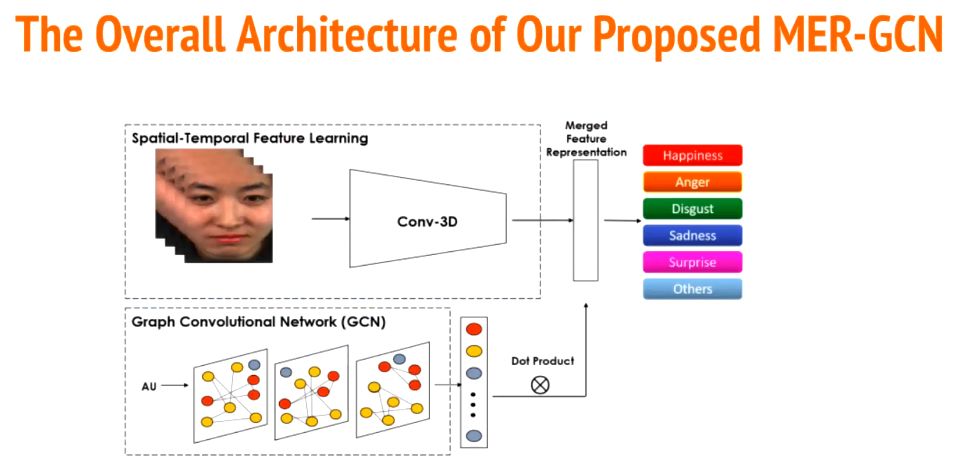

随后,谢洪霞进一步介绍了后续开展的基于GCN的微表情AU相关特征提取的研究,提出了如下图所示的AU-GACN 网络。首先通过3D-Conv网络输出微表情片段的AU节点特征,进而通过AU的图相关学习模型提取有用的AU节点信息,最终实现微表情的情感分类。

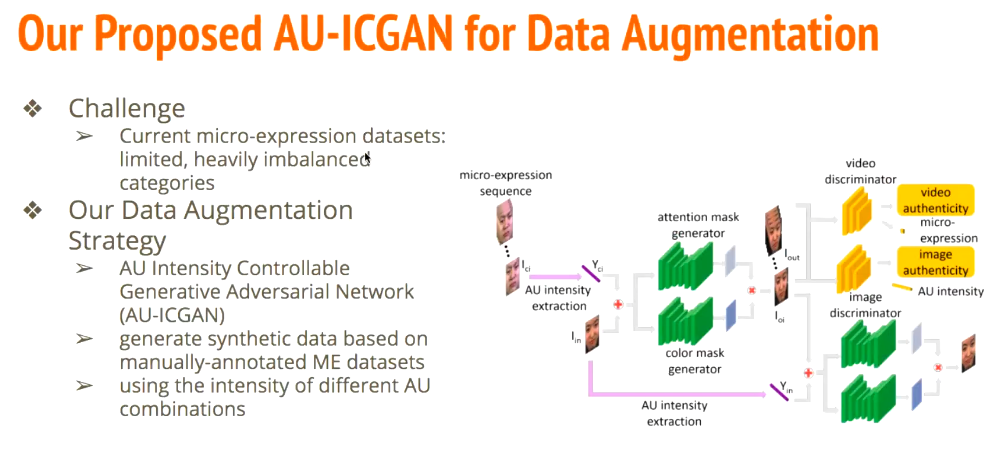

由于微表情的样本数目十分小,限制了结合深度学习的微表情识别研究。针对这一问题,谢洪霞也介绍了基于可控AU强度对抗生成网络(AU-ICGAN)的微表情样本生成方法,并为ICIP2020微表情挑战赛提供了样本。

在报告的最后,谢洪霞讨论了微表情小样本且分布不均、面部不对称性和机器偏差等问题,并对多模态分析、不确定性建模、以及真实场景应用等进行了展望。

2、基于局部时空特征的数据扩增和微表情检测 – 中国科学院心理研究所李婧婷博士

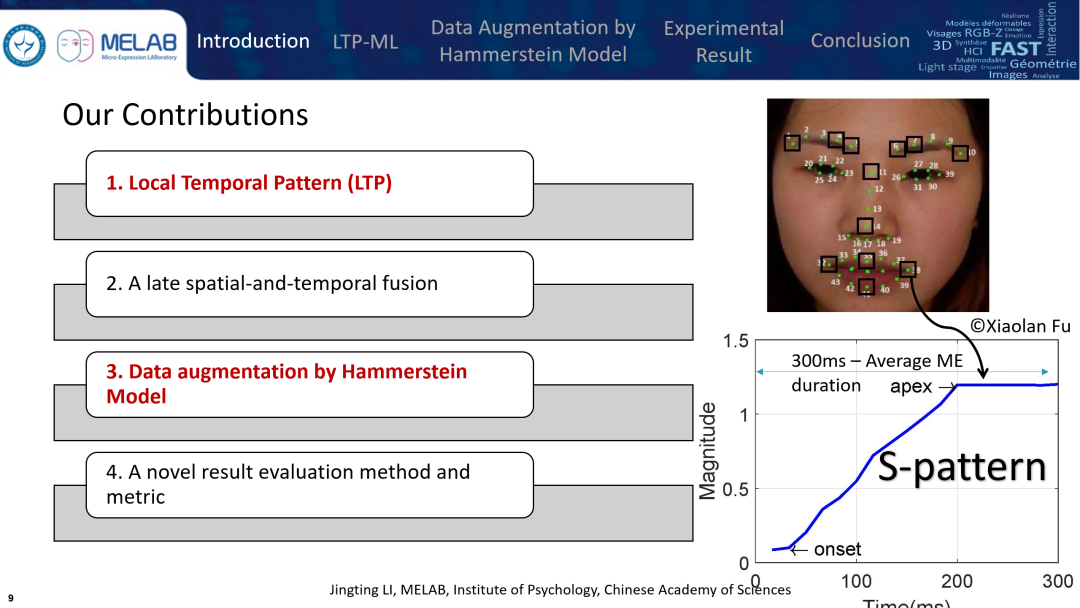

李婧婷博士主要汇报了发表在IEEE Transactions on Affective Computing的文章:Local Temporal Pattern and Data Augmentation for Micro-Expression Spotting。

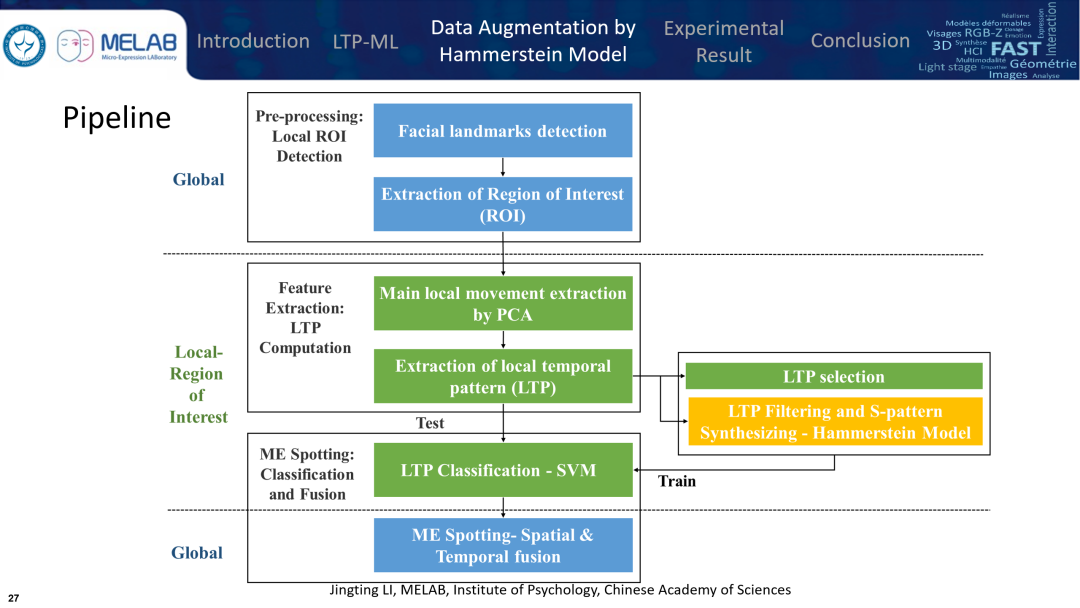

李博士首先简要介绍了目前主流的两种微表情检测思路:传统的帧差异比较法和结合机器学习的检测方法。然后,针对微表情持续时间短、动作强度低以及局部发生的三个特点,李博士提出了结合局部时空特征提取、局部机器学习和晚期融合的微表情检测方法,并采用基于Hammerstein模型进行数据扩增,提升模型分类性能。下图为方法的流程框架:

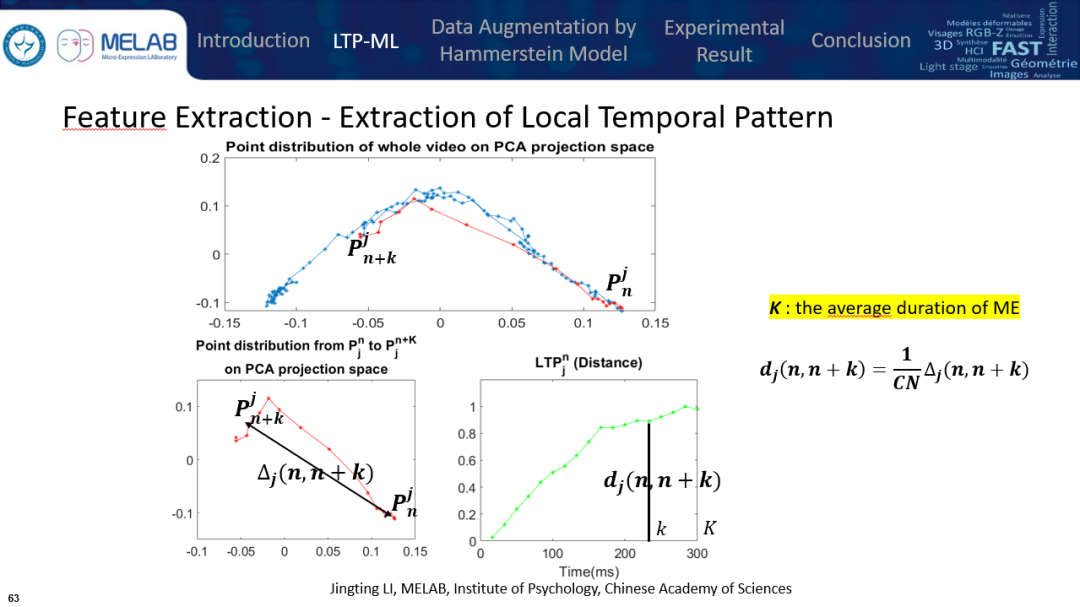

在得到局部兴趣区间的微表情视频片段后,李博士提出利用主成分分析(PCA)来提取视频在时域上的主要变化,通过基于微表情平均时长的滑动窗口,计算窗口首帧与其余帧的距离,最终得到局部时域模式(LTP)。

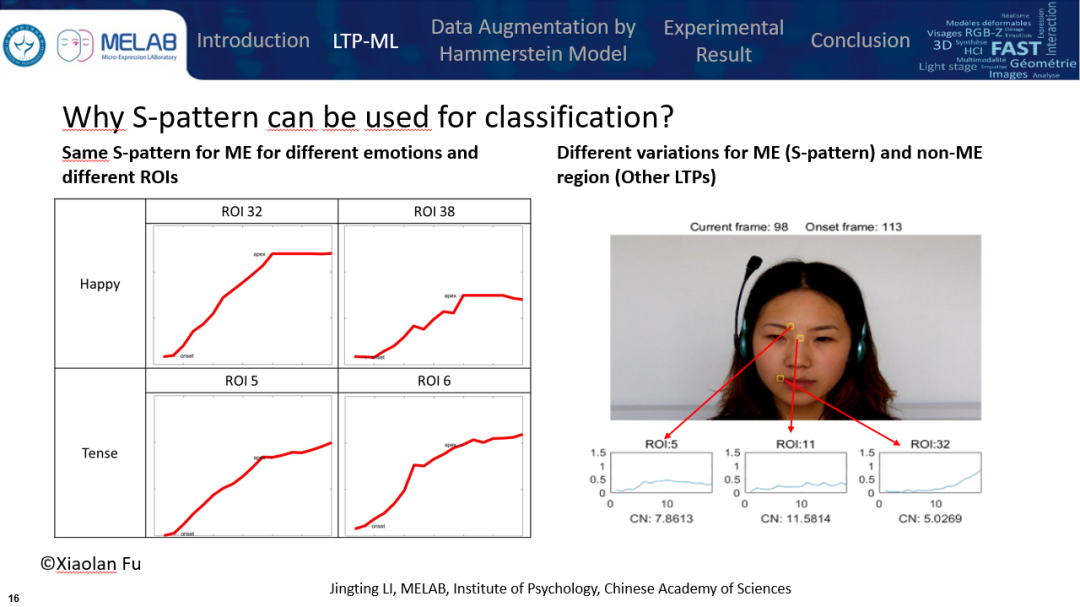

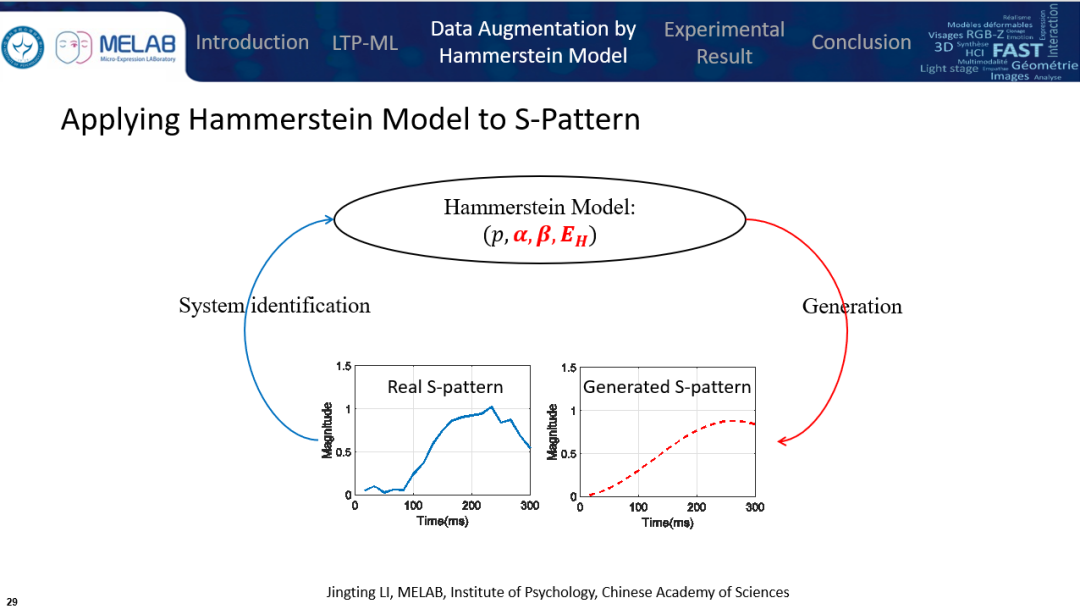

李博士等人发现针对微表情的LTP具有一定的变化模式,一般在150ms内达到峰值,随后保持稳定或下降。这种特定于微表情的LTP被称为S-pattern,并且S-pattern对于不同的人脸兴趣区域和不同的情绪都具备相似的变化模式。因此,从视频片段中提取的LTP被分为S-pattern和non-S-pattern两大类,进而可以判定局部兴趣区域是否发生了类似微表情变化。

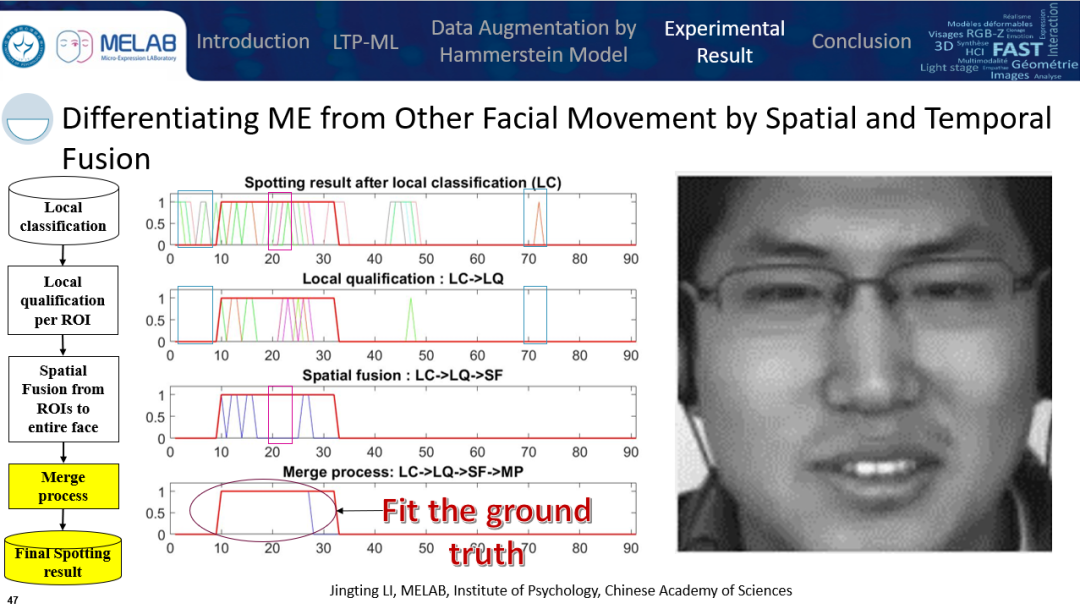

在得到局部的检测结果后,李博士提出了局部量化、从局部到全脸的时空融合和连续帧融合三个步骤,从而获得最终的微表情片段检测结果。该晚期融合增强了检测方法区分微表情和其他面部动作的能力。

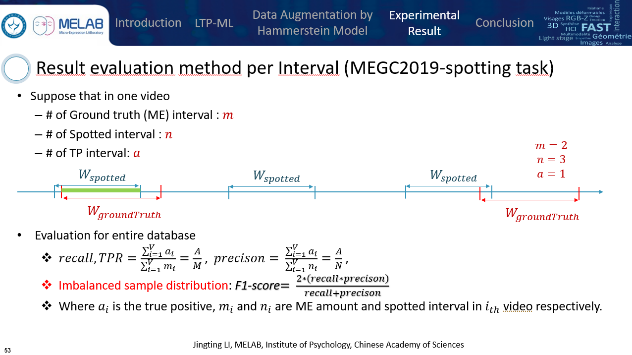

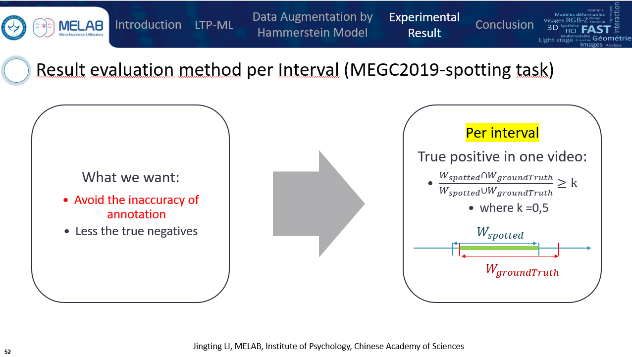

为了避免微表情标注不准确带来的影响和逐帧检测导致大量真负值的出现,李博士提出了基于区间的微表情评估方法。通过比较检测区间和真实微表情区间的重叠率来判定检测结果是否正确。同时,为了避免样本分布均衡导致的问题,最终的检测性能由F1分数来衡量。这个评估方法被用于第二、三届微表情挑战大赛(MEGC2019, 2020)的检测任务结果衡量。

在讨论环节,听众们踊跃发言,提出了很多非常有讨论意义的问题。两位讲者回答了微表情识别在实际场景中的应用、结合情景的人类复杂情感分析、情感分类从个体到泛化和微表情数据人工标注不准确对分析的影响等问题。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结并对第十二期CSIG云上微表情活动进行了大致预告。敬请继续关注!

此次讲座的回放已经发布在B站:https://www.bilibili.com/video/BV18V411b7VS,欢迎观看!

祝大家新年快乐,健康平安,诸事皆宜!