CSIG云上微表情第二期研讨会成功举办--针对微表情识别基于峰值帧网络的遗传算法

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)举办、CSIG机器视觉专业委员会承办,中国科学院心理研究所的王甦菁博士计划组织一系列云上微表情的学术活动。

第二期云上微表情研讨会于2020年8月14日晚上8点进行,由中国科学院心理研究所王甦菁老师团队的李婧婷博士主持。此次讲座邀请到了台湾逢甲大学的梁诗婷博士以及来自厦门大学的许黄超同学和金秋实同学。其中,梁诗婷博士介绍了她团队在微表情检测与识别领域的进展,包括基于光流的微表情特征提取从人工到机器学习的演变,对不同场景的微表情数据库的分析等。许黄超和金秋实同学则介绍了她们在梁诗婷博士指导下作为共同一作发表的论文:针对微表情识别基于顶点帧网络的遗传算法。本次报告得到了微表情研究领域的广泛关注,期间有三十多位听众参加了此次讲座。

梁诗婷博士的讲座内容分为4个部分,包括:简要的微表情系统介绍、顶点帧检测、微表情情感识别、通过遗传算法的特征加强。

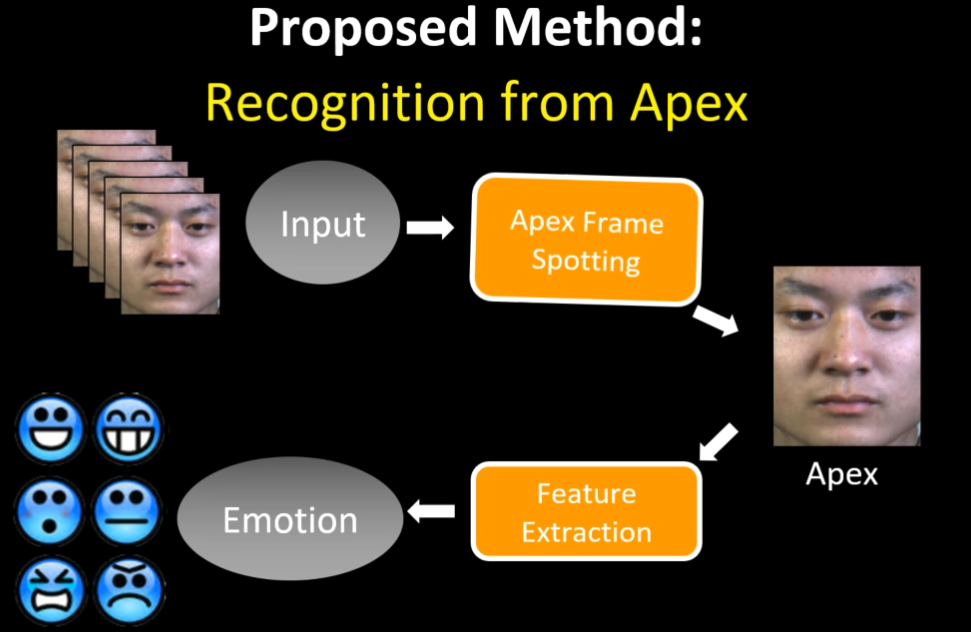

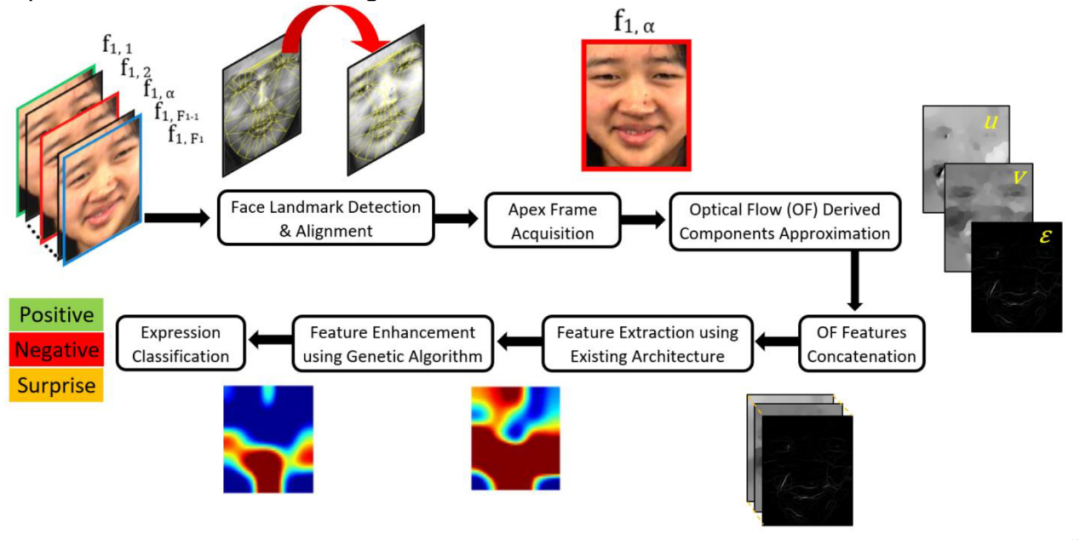

常见的微表情识别系统的输入为一段微表情连续帧,通过预处理、特征提取和分类得到最终针对这段微表情序列的情绪分类。由于顶点帧具有较强的针对微表情的特征表示,包括更多有用的行为信息,梁博士团队提出首先检测顶点帧,然后通过从顶点帧提取特征进行微表情的情感分类。

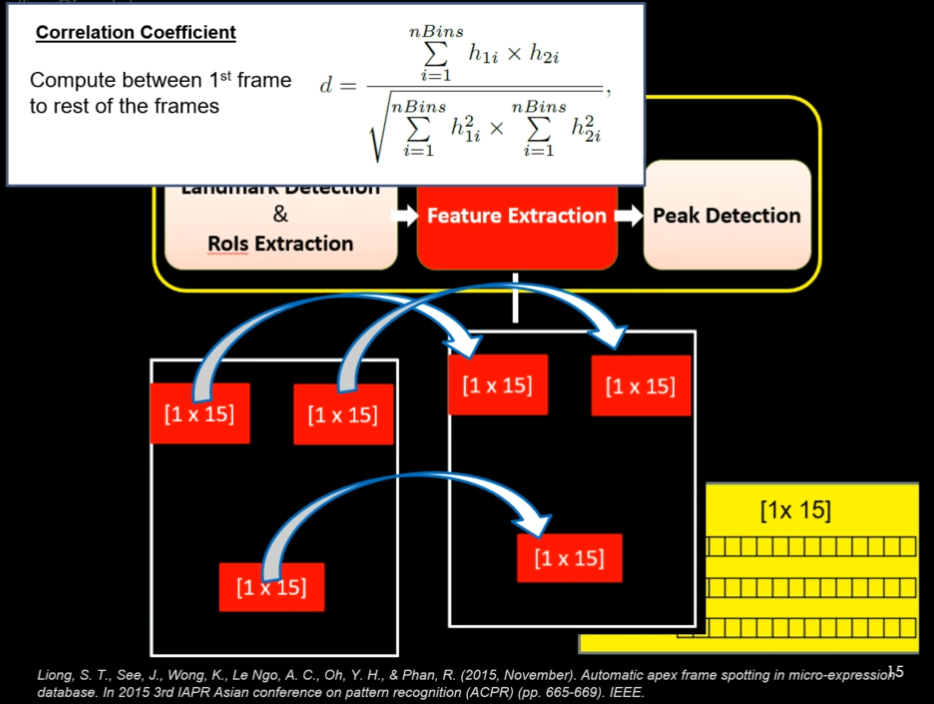

在这个部分,梁博士主要介绍了视频中顶点帧的检测。在脸部特征点和兴趣区间的选取后,在特征提取的部分,首先计算第一帧和视频中其余帧的相关系数,再对这一系列系数进行“Divide & Conquer”的策略比较,得到这段视频中的微表情的顶点帧。

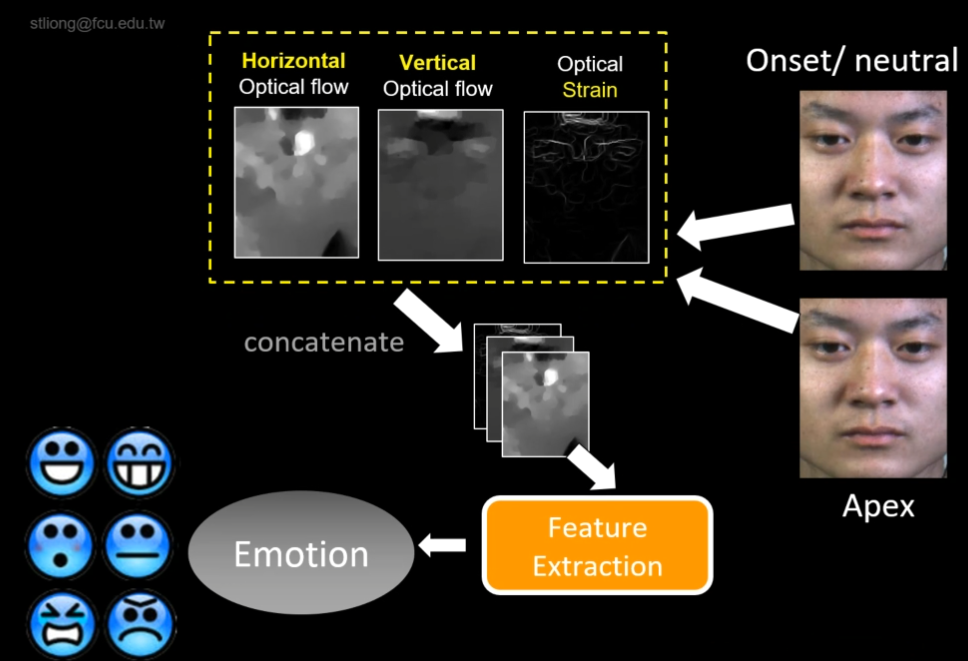

梁老师团队构建的微表情识别系统主要是基于顶点帧的特征提取,通过提取顶点帧的光流特征,包括水平和垂直方向的光流以及光流应力,利用不同的分类器进行微表情的情感识别。他们提出了不同的光流特征和机器学习的组合方法进行微表情的情感分类,包括利用利用光流方向、幅度和应力的BI-WOOF方法、利用水平和垂直光流以及光流应力的浅层卷积神经网络STSTNet,和利用水平和垂直光流的并行卷积神经网络OFF-ApexNet。

梁老师还对相同方法在不同数据库中的检测性能的差别进行了分析,证明了遮挡眼部对减少眨眼导致虚警的有效性,并且讨论了真实环境数据库对于目前微表情研究的复杂性。

这个部分主要由许黄超同学进行介绍,在第三部分微表情情感分类方法的基础上(BI-WOOF、STSTNet和OFF-ApexNet),通过遗传算法筛选更具有微表情表征的特征,再进行微表情分类。这个特征增强的方法很好地提升了微表情的分类性能。

在梁诗婷博士和许黄超、金秋实同学精彩的报告后,听众们踊跃发言,提出了很多非常有讨论意义的问题。相关的讨论主要涉及到以下几个问题:

首先,在基于遗传算法的微表情特征增强方面,听众提出了关于方法普适性以及分类器选择的问题。许黄超和金秋实同学进一步阐述了该方法对于三种基于光流的组合特征都有进一步的性能提升。同时,在这个流程中,卷积神经网络只用于特征提取部分,四种不同的传统机器学习分类器进行情感识别。

其次,来自芬兰奥卢大学的李晓白博士和梁诗婷博士对眼睛遮挡对微表情识别的影响进行了讨论。李博士提出眼睛的遮挡减少眨眼虚警的同时,也减少了微表情真值的检测率。梁博士指出如果选择更适应眼睛形状的六边形,会比传统的四边形有更优的检测性能。后续眨眼和微表情分析的联系与研究还需大家进一步的探索。梁博士与李博士的探讨说明了这种小领域的定期的活动有利于大家在一起充分讨论一些细节问题。

另外,参会者们还对光流特征的提取方法、目前微表情检测方法在长视频中的应用、微表情时间特征和单纯利用顶点帧的比较等问题展开了讨论。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结,并对后续三期CSIG云上微表情活动进行了预告。敬请关注!