CSIG云上微表情第22期研讨会成功举办--ACM MM’21微表情挑战大赛检测任务

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)主办、CSIG机器视觉专业委员会和CSIG情感计算与理解专业委员会联合承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

第二十二期云上微表情于2021年11月26日晚上7点进行,由中国科学院心理研究所王甦菁老师团队的李婧婷博士主持。此次讲座邀请到ACM Multimedia 2021-微表情挑战大赛检测任务的三位优胜者分享算法,分别是哈尔滨工业大学的在读博士生何雨鸿、电子科技大学的在读博士生余旺旺、以及日本KDDI综合研究所的杨博博士。此次讲座得到了微表情研究领域的广泛关注,期间有五十多位听众参加了此次讲座。

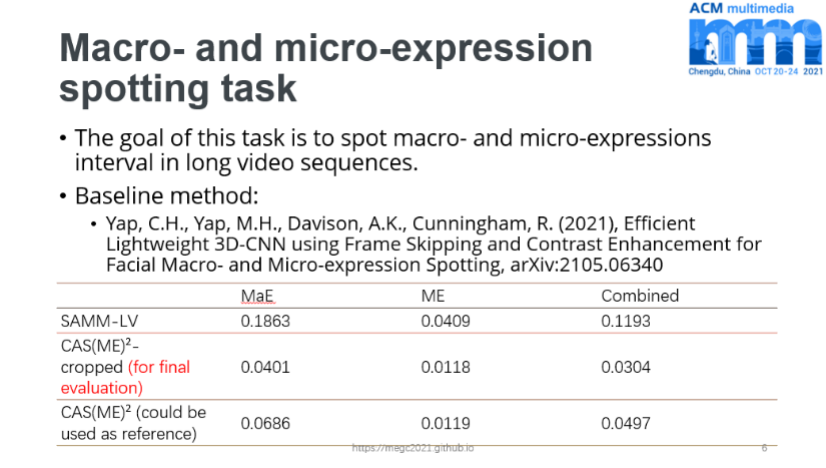

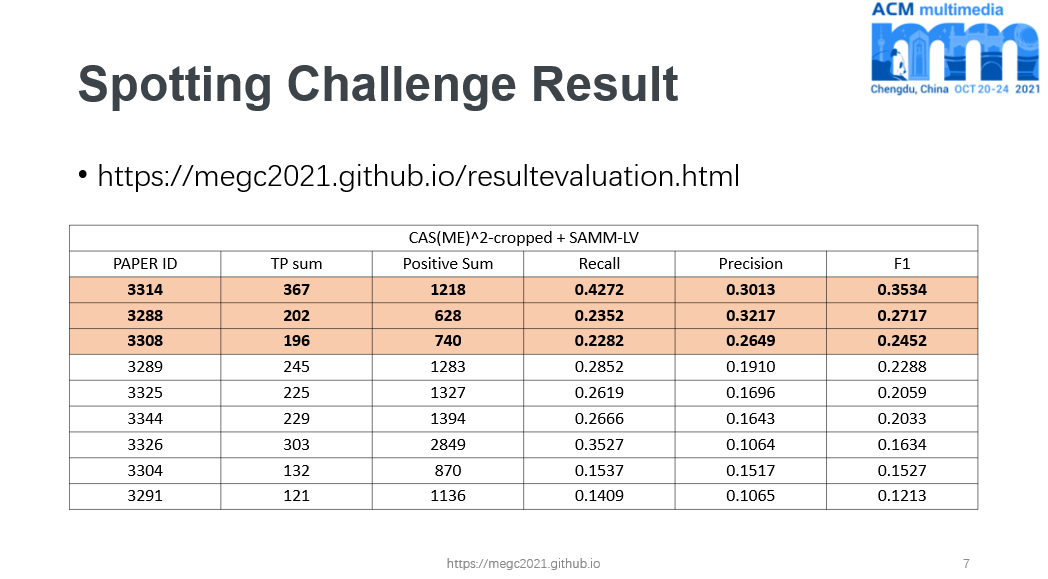

在讲座的开始,李婧婷博士简要介绍了ACM Multimedia 2021-微表情挑战大赛(https://megc2021.github.io)以及其中的检测任务。挑战大赛由中国科学院心理研究所、台湾阳明交通大学、西安交通大学、英国曼彻斯特城市大学、马来西亚多媒体大学和芬兰奥卢大学共同举办。微表情检测任务的目标是在长视频中同时检测微表情和宏表情。共有九支队伍参加了“微表情和宏表情的检测”任务,任务的前三名文章被录取,获胜者们在 ACM MM21的多媒体挑战大赛分会场进行了口头报告。

检测任务第一名-哈尔滨工业大学的在读博士生何雨鸿

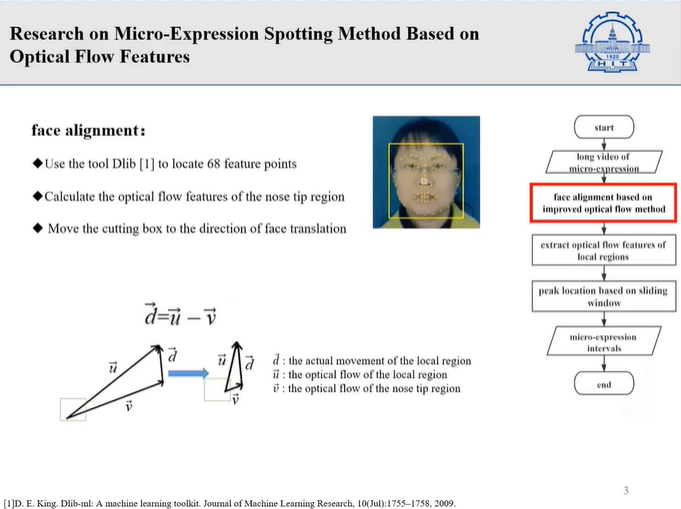

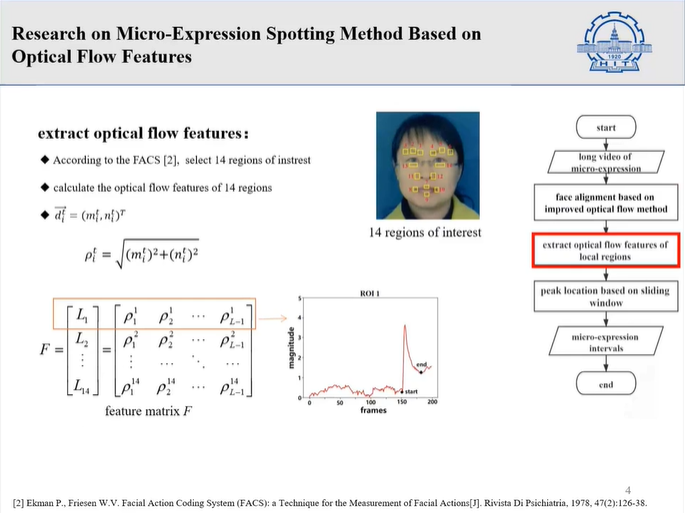

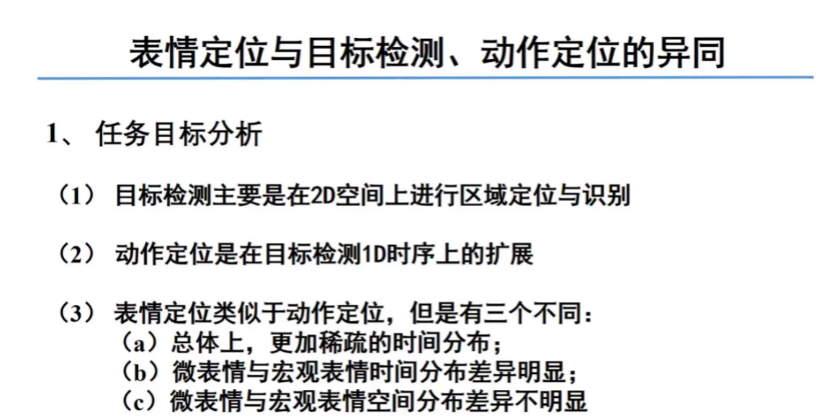

何雨鸿同学首先介绍了微表情是一种速度快、幅度小、难以捕捉的面部动作,可以揭示人们试图隐藏的真实情绪。针对微表情检测问题,何雨鸿同学利用光流方法进行面部对齐和微表情动作特征提取,取得不错的成绩。

在第四届国际微表情挑战赛的“微表情和宏表情检测”任务中获得第一名。检测CAS(ME)2数据库和SAMM长视频数据库的总体F1-score参数为0.3534。

相关论文已被ACMMM’21论文集收录:Yuhong, H. (2021, October). Research on Micro-Expression Spotting Method Based on Optical Flow Features. In Proceedings of the 29th ACM International Conference on Multimedia (pp. 4803-4807).

-

检测任务第二名-电子科技大学的在读博士生余旺旺

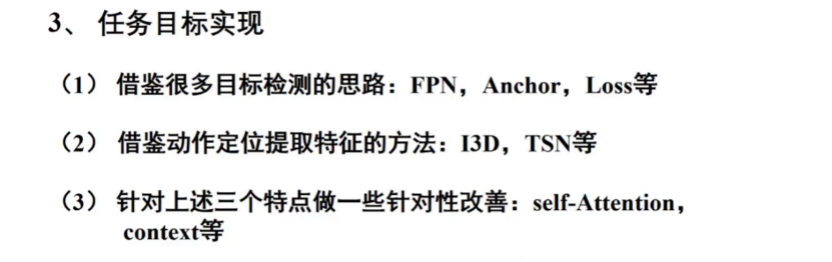

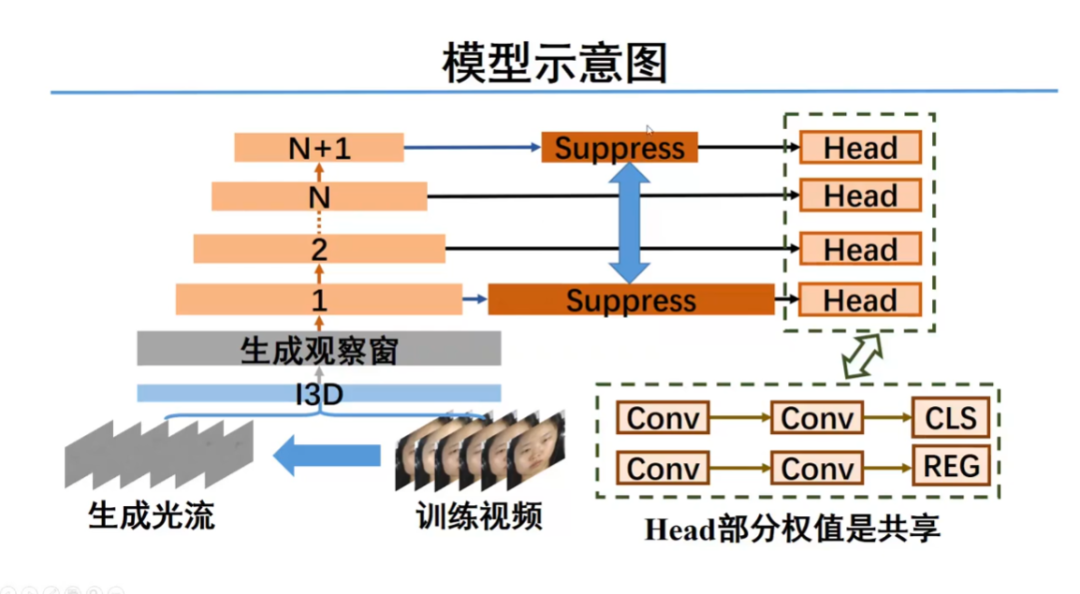

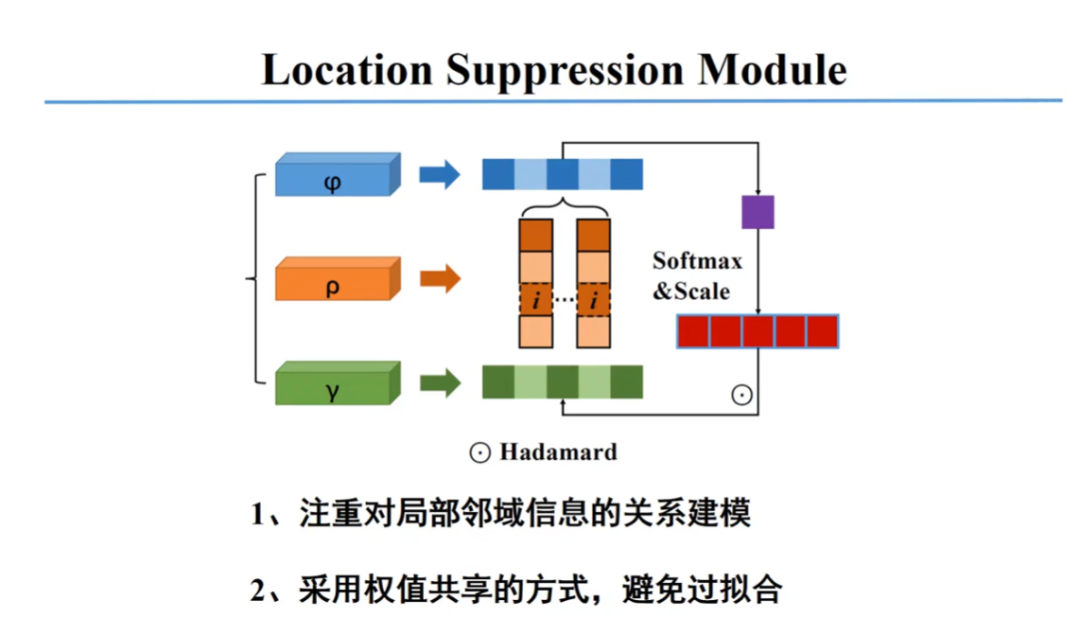

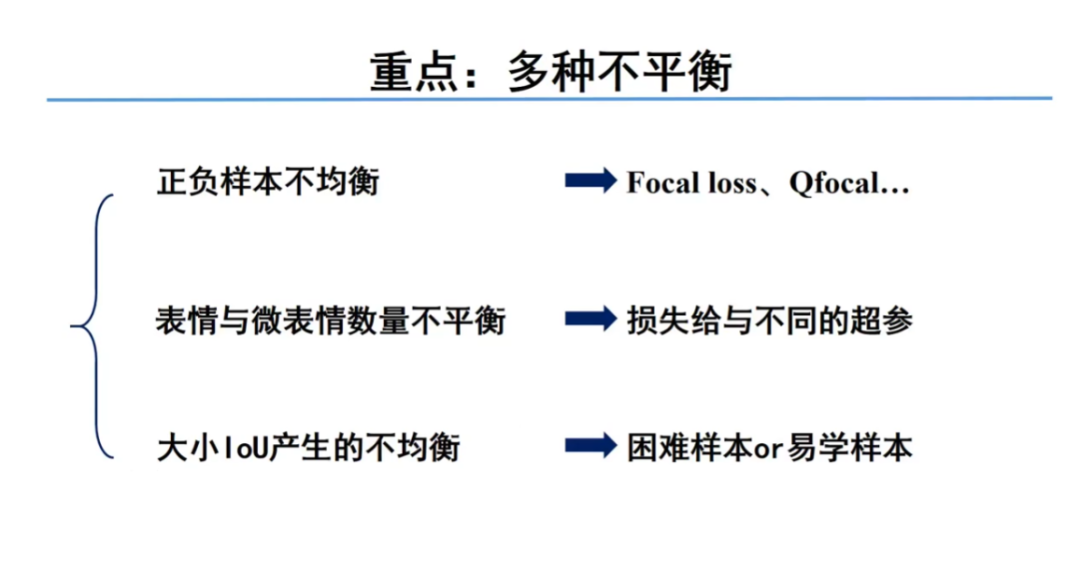

LSSNet包括三个部分。首先,使用传统的TV-L1算法来提取光流并捕获细微的面部运动,同时增加时间信息来缓解样本不足的问题。然后,通过I3D模型从光流和RGB图像中提取固定长度的特征,该特征用于设置观察窗。最后,在金字塔卷积神经结构中加入局部抑制模块以减少较长与较短时序的生成。

他们采用LOSO来训练模型。实验结果表明LSSNet最终取得较好的结果,特别是在CAS(ME)2数据集上。

此外,余旺旺同学还对未来的工作进行了展望:

相关论文已被ACMMM’21论文集收录:Yu, W. W., Jiang, J., & Li, Y. J. (2021, October). LSSNet: A Two-stream Convolutional Neural Network for Spotting Macro-and Micro-expression in Long Videos. In Proceedings of the 29th ACM International Conference on Multimedia (pp. 4745-4749).

检测任务第三名-日本KDDI综合研究所的杨博博士

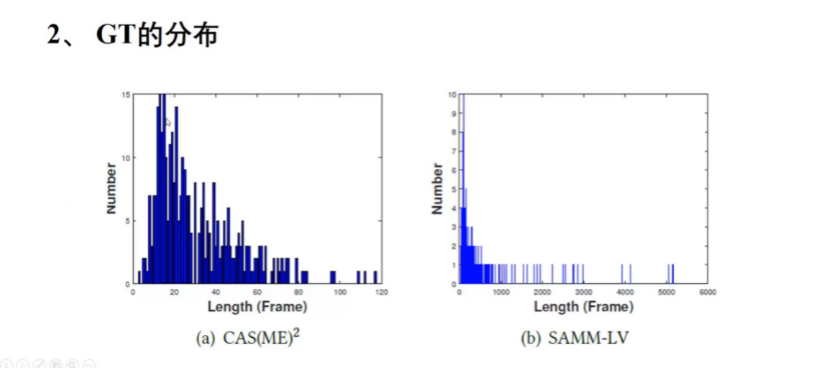

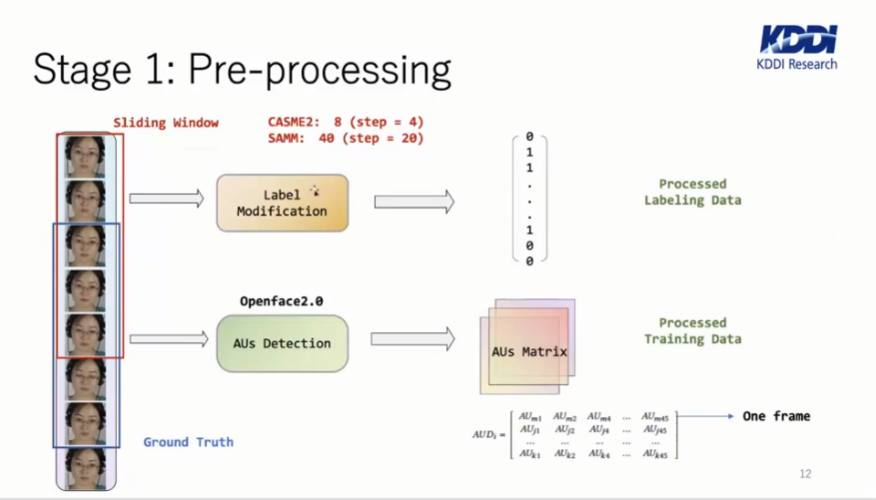

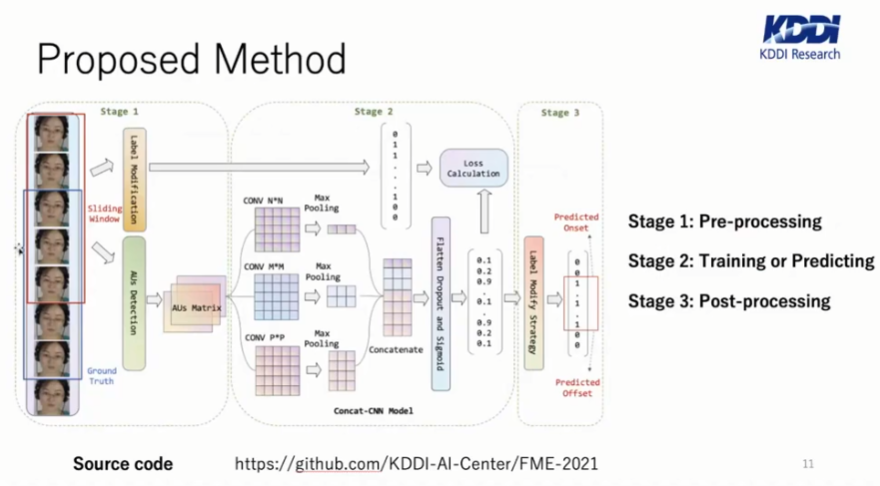

杨博博士首先简要介绍了本次挑战赛使用的两个长视频数据库:CAS(ME)2数据库和SAMM长视频数据库,以及微表情检测的相关工作。然后杨博士介绍了他们研究主要思想,是根据微表情和宏表情间主要区别是0.5s左右这个特点,将“视频中宏表情及微表情的检出任务“看成是一段定长视频是否是宏表情、微表情、无表情的三分类问题。

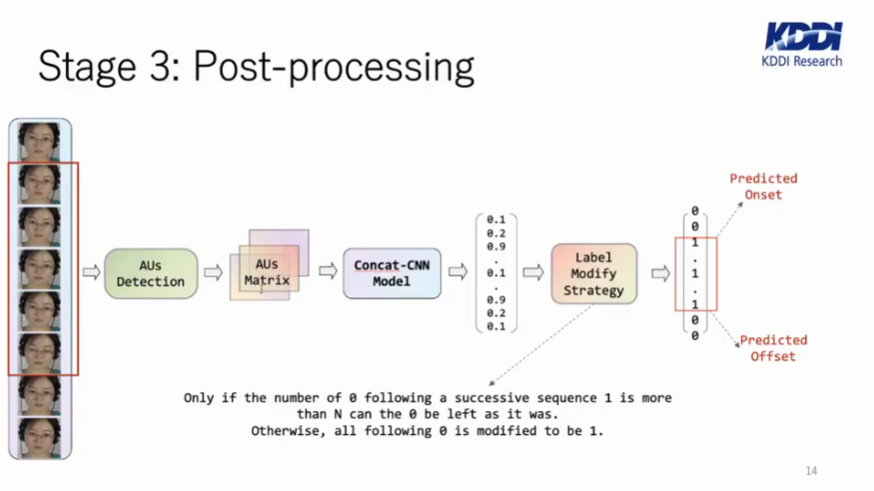

受启发于人脸动作单元,杨博士他们利用OpenFace提取视频样本中的AU,构成特征矩阵。他们模型体系主要分为三个阶段,在第一步预处理阶段,依据已有的表情标签对每段定长的帧群进行再次贴标签,从而形成多个定长的连续序列数据。

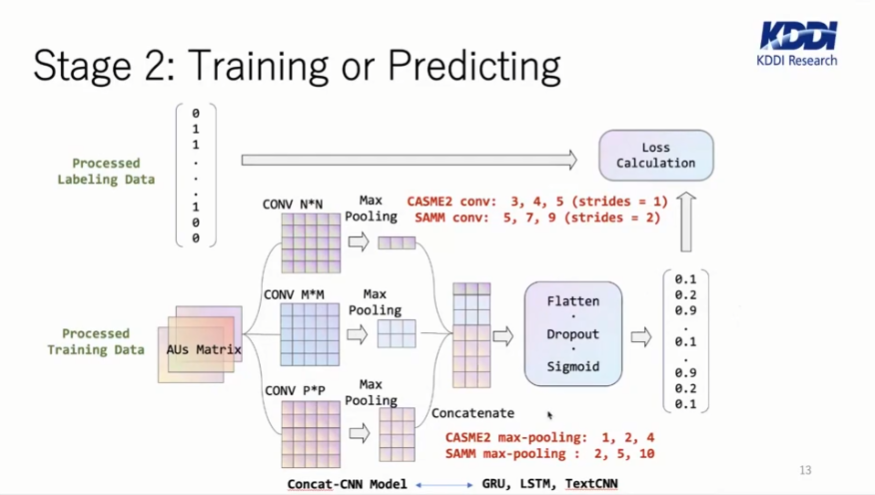

在第二步的模型训练阶段,根据定长一维数据的数据特征,他们参考了自然语言处理的模型TextCNN并选择效果最好的卷积核大小,从而获得分类效果最好的深度学习模型。

从最后模型的使用结果,可以看出本方法表现出了较好的检出效果。

未来,他们计划将针对本方法在微表情检出效果不如宏表情检出效果的问题,进行模型和算法的进一步改善。

相关论文已被ACMMM’21论文集收录:Yang, B., Wu, J., Zhou, Z., Komiya, M., Kishimoto, K., Xu, J., ... & Takishima, Y. (2021, October). Facial Action Unit-based Deep Learning Framework for Spotting Macro-and Micro-expressions in Long Video Sequences. In Proceedings of the 29th ACM International Conference on Multimedia (pp. 4794-4798).

在讨论环节,听众们踊跃发言,提出了很多非常有讨论意义的问题,例如探讨了OpenFace对微表情中AU检测性能、不同人种表现出的微表情强度、微表情与宏表情检测区间的区分标准等。

此次讲座的回放已经发布在B站:https://www.bilibili.com/video/BV1h44y1Y7Ca?share_source=copy_web。

另外,中国科学院心理研究所微表情实验室(MELAB)诚聘博士后,微表情相关方向、计算机或心理学专业皆可,有意请联系王甦菁老师(wangsujing@psych.ac.cn)。