【PKDD 2021】PaGNN:基于交互结构学习的链路预测

论文解读者:蚂蚁集团 杨硕

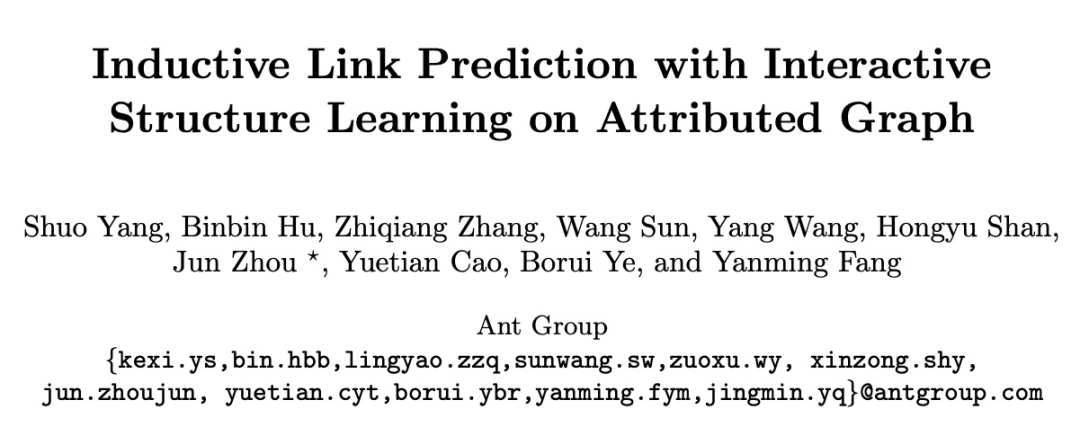

1 引言

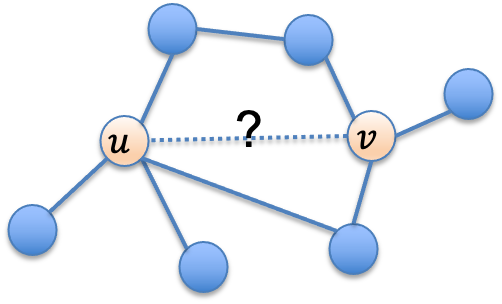

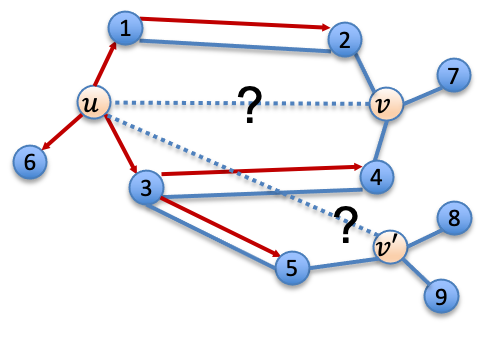

2 方法

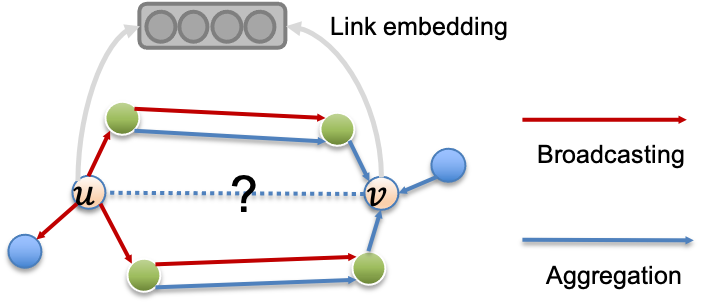

2.1 PaGNN概述

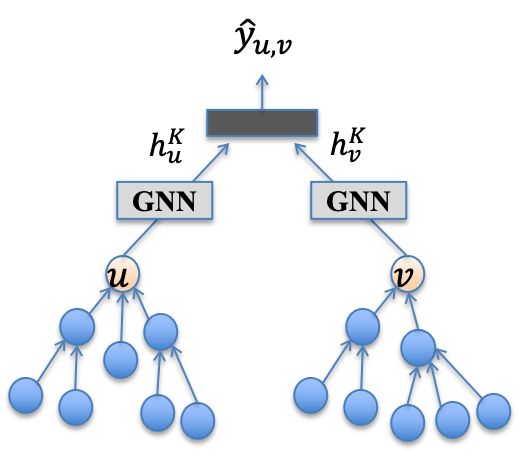

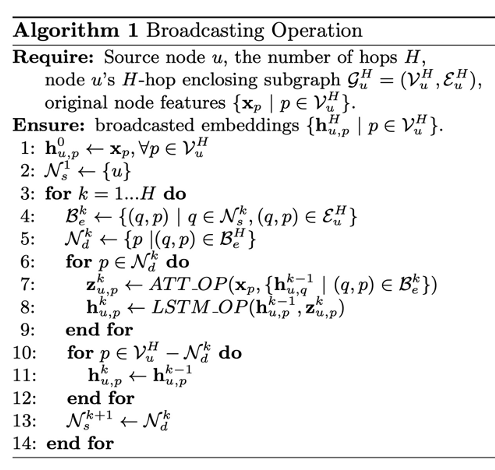

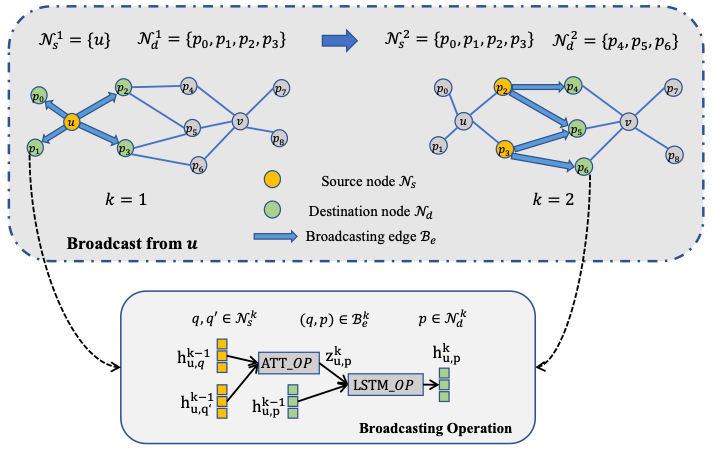

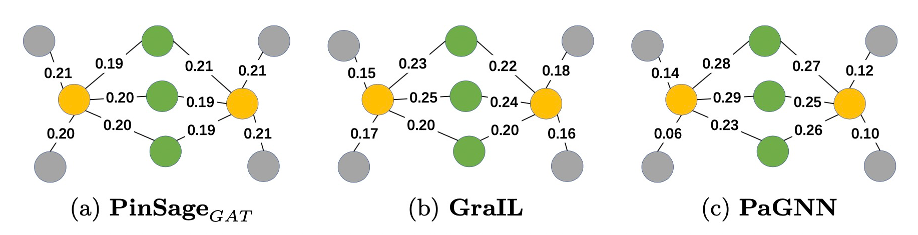

2.2 Broadcasting操作

图5 Broadcasting操作

图5 Broadcasting操作

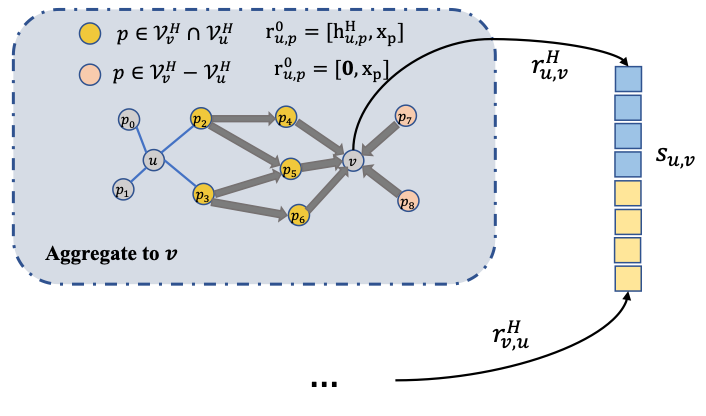

2.3 Aggregation操作

2.4 边表达学习

2.5 缓存策略

2.6 时间复杂度分析

3 实验

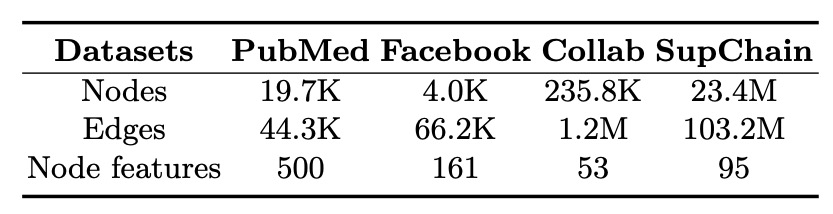

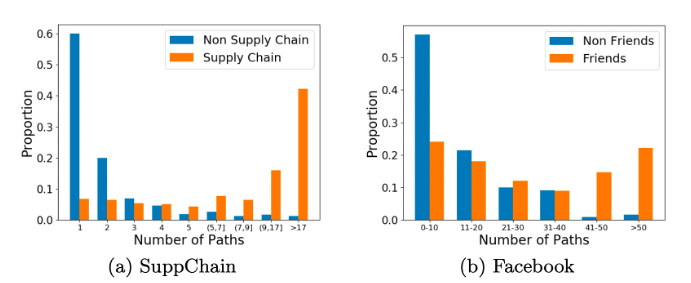

3.1 数据集

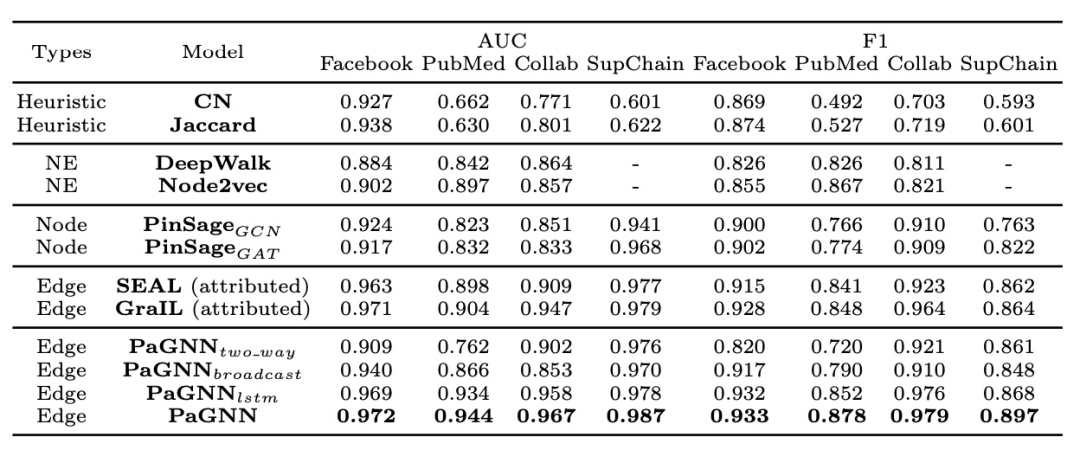

3.2 Baseline

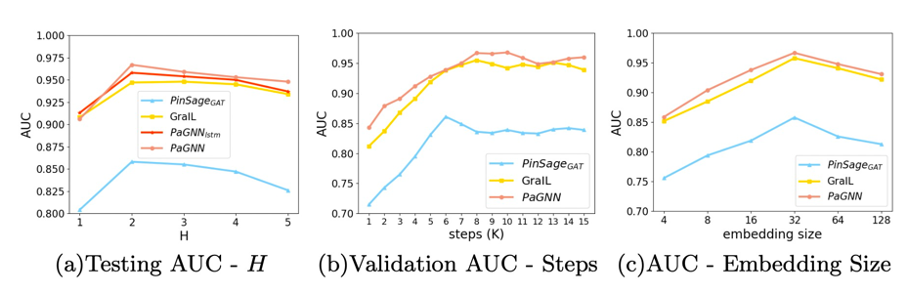

3.3 模型性能

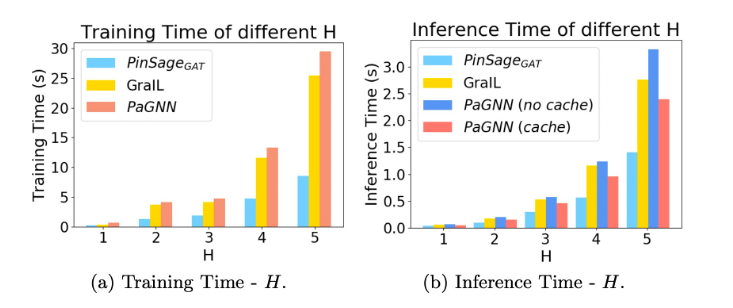

3.4 模型效率

4 总结

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PGNNP” 就可以获取《【PKDD 2021】PaGNN:基于交互结构学习的链路预测》专知下载链接

登录查看更多

相关内容

Arxiv

14+阅读 · 2021年1月29日