图神经网络黑盒攻击近期进展

作者:北邮GAMMA Lab硕士生 于越

本文旨在简要总结近期的图对抗攻击中的黑盒攻击方法,带领读者了解图黑盒攻击的基本定义和最新进展。

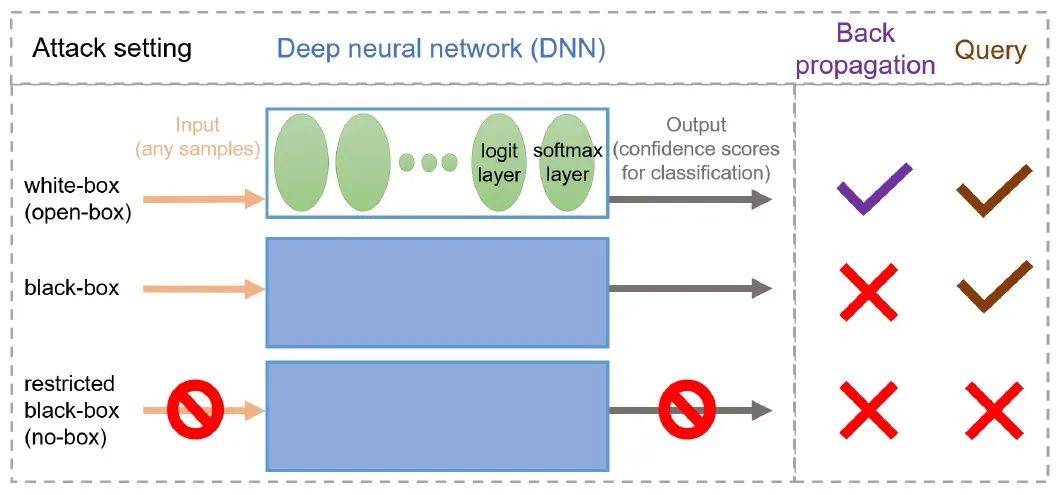

1 简介

2 方法介绍

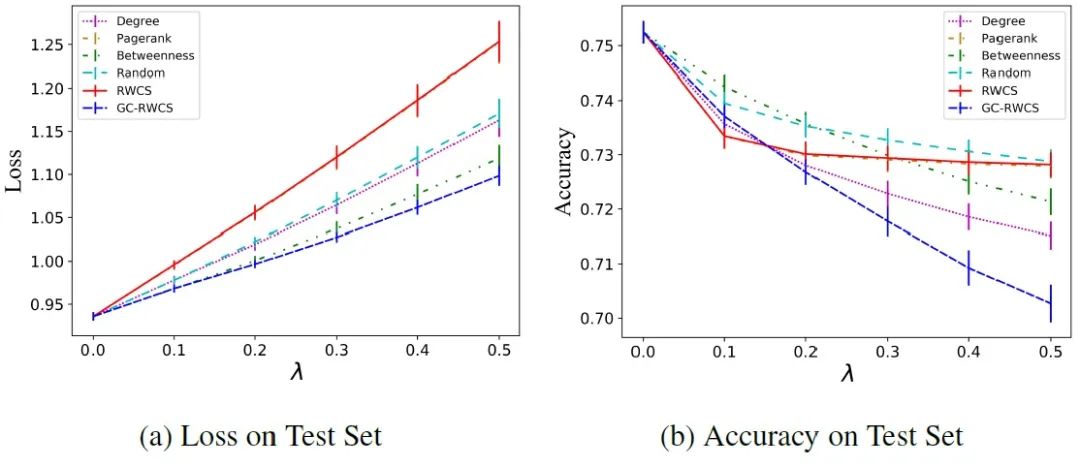

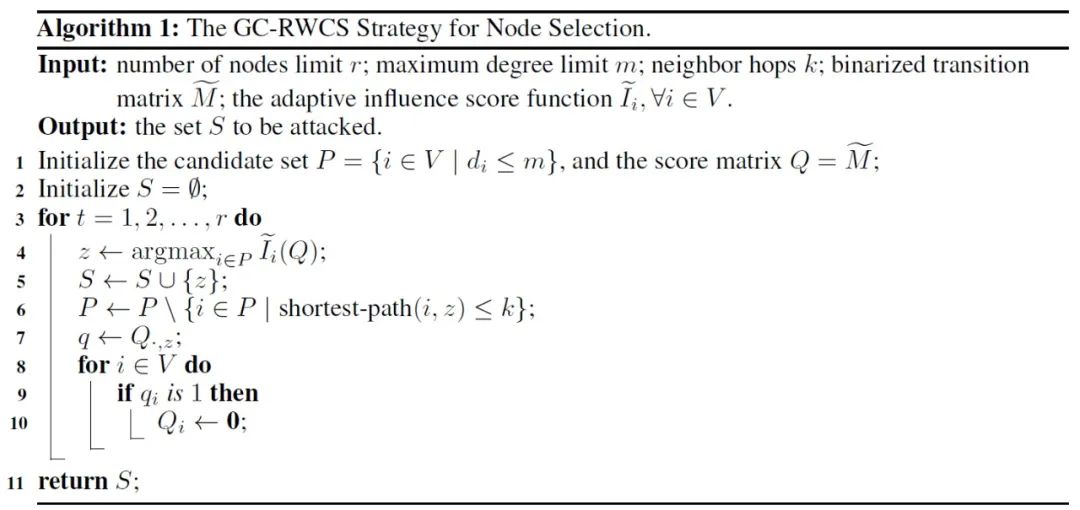

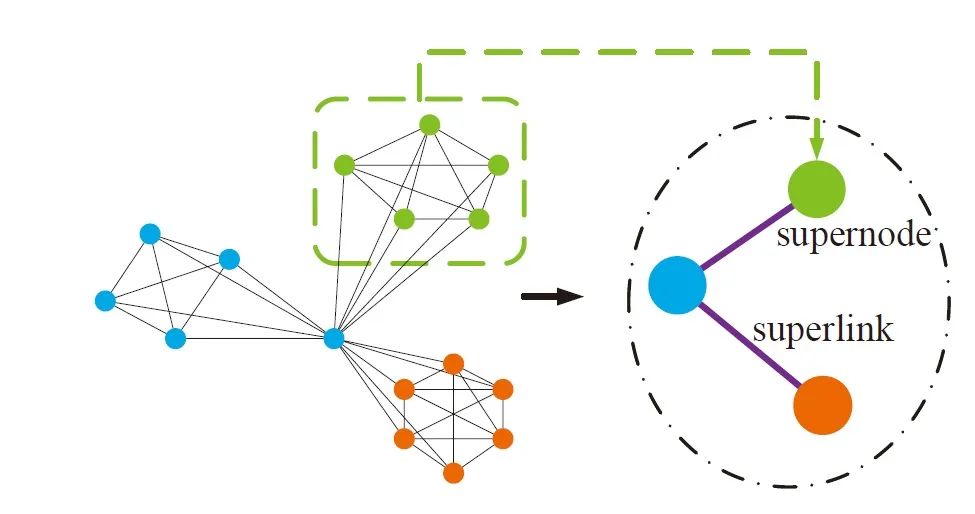

2.1 Towards More Practical Adversarial Attacks on Graph Neural Networks (NeurIPS 2020)

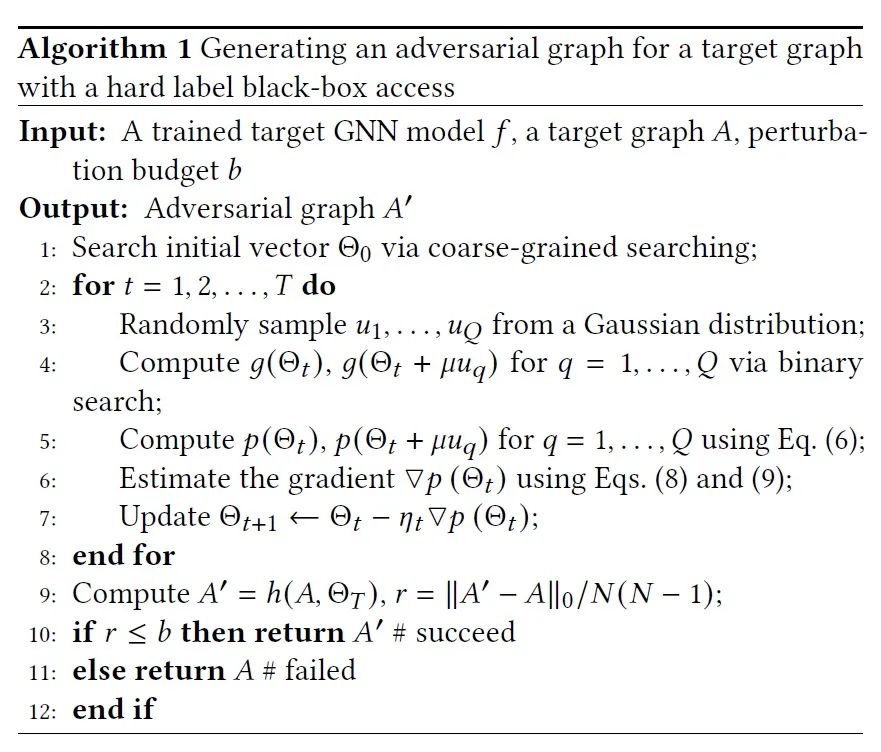

2.2 A Hard Label Black-box Adversarial Attack Against Graph Neural Networks (CCS 2021)

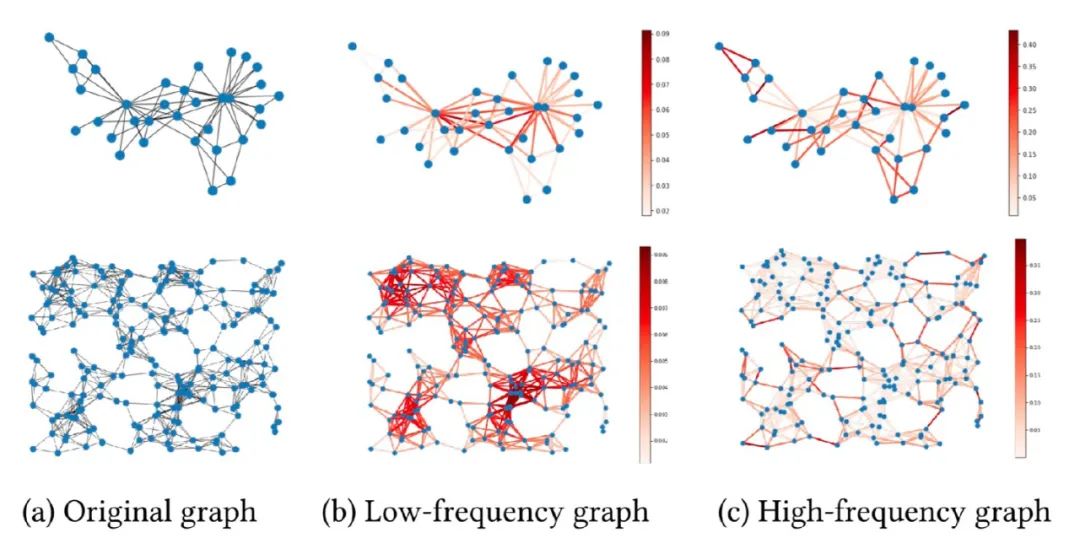

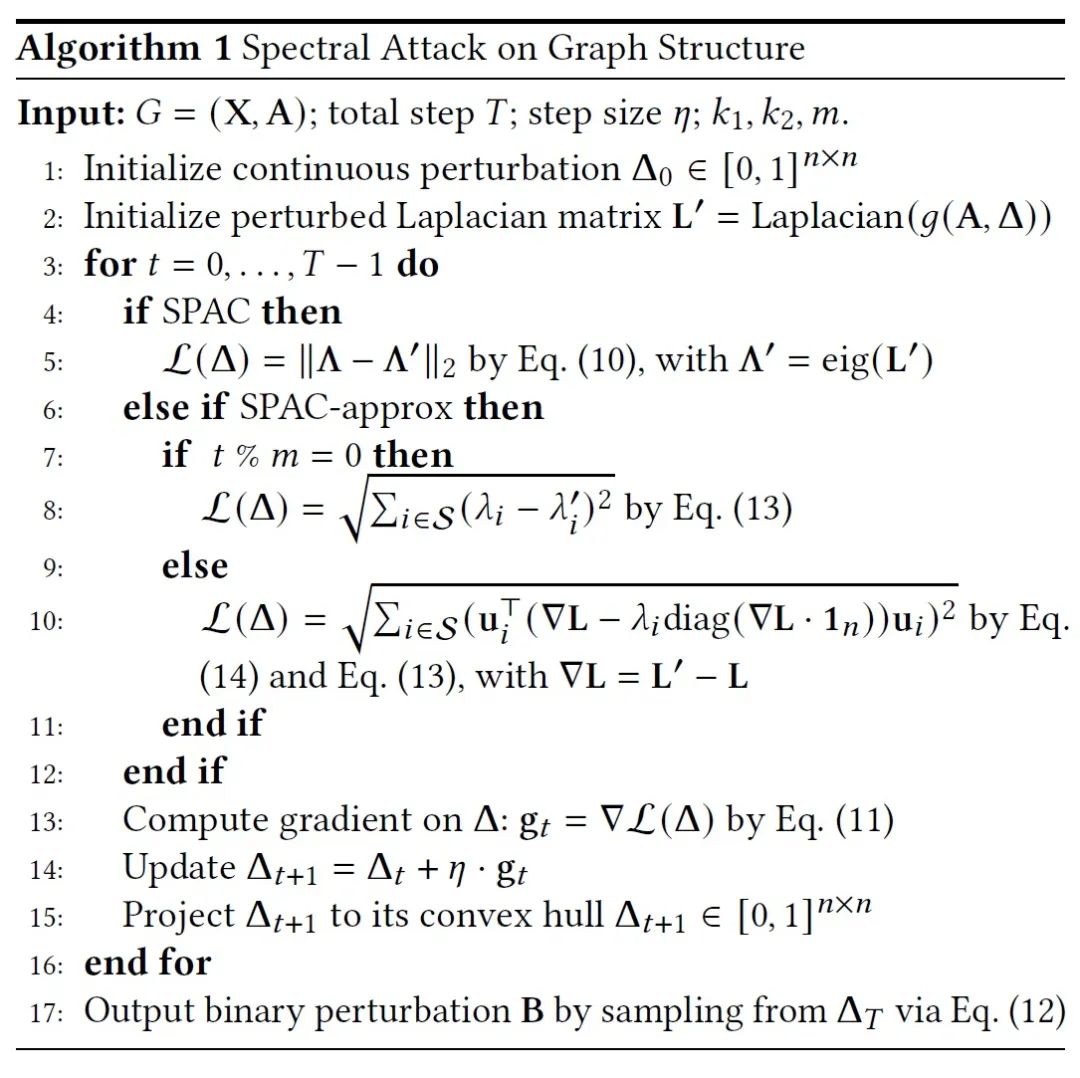

2.3 Graph Structural Attack by Perturbing Spectral Distance (KDD 2022)

3 总结

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GNBA” 就可以获取《图神经网络黑盒攻击近期进展》专知下载链接

登录查看更多

相关内容

Arxiv

16+阅读 · 2019年9月23日