AAAI 2022 | 正交图神经网络

论文介绍

图神经网络 (GNNs) 模型依靠消息传递和特征转换函数来编码来自邻居的结构和特征信息,消息传递是沿着边传递邻居消息,特征转换是通过投影节点嵌入来提高模型的学习能力,但卷积层太多则会导致 GNNs 的性能降低。最近的研究指出这个问题来源于过平滑,也就是因为图结构上的递归邻域聚合导致节点表示变得难以区分。最近提出了图增强等模型来缓解过平滑,主要思想是避免过多的邻域信息,在每个卷积层都强化自身的特定节点特征。

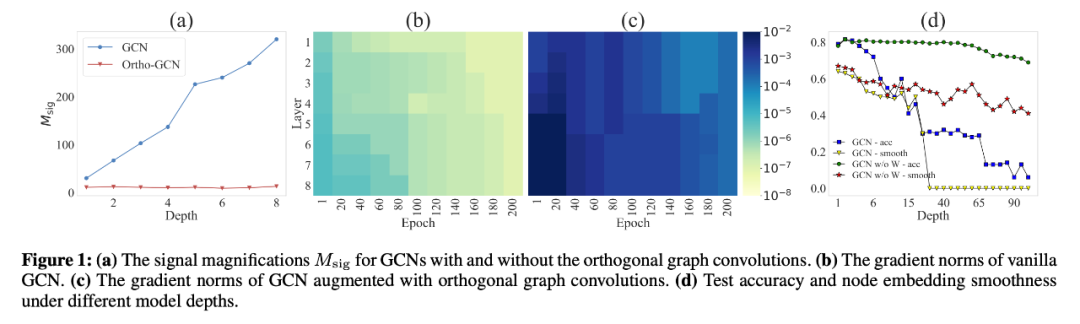

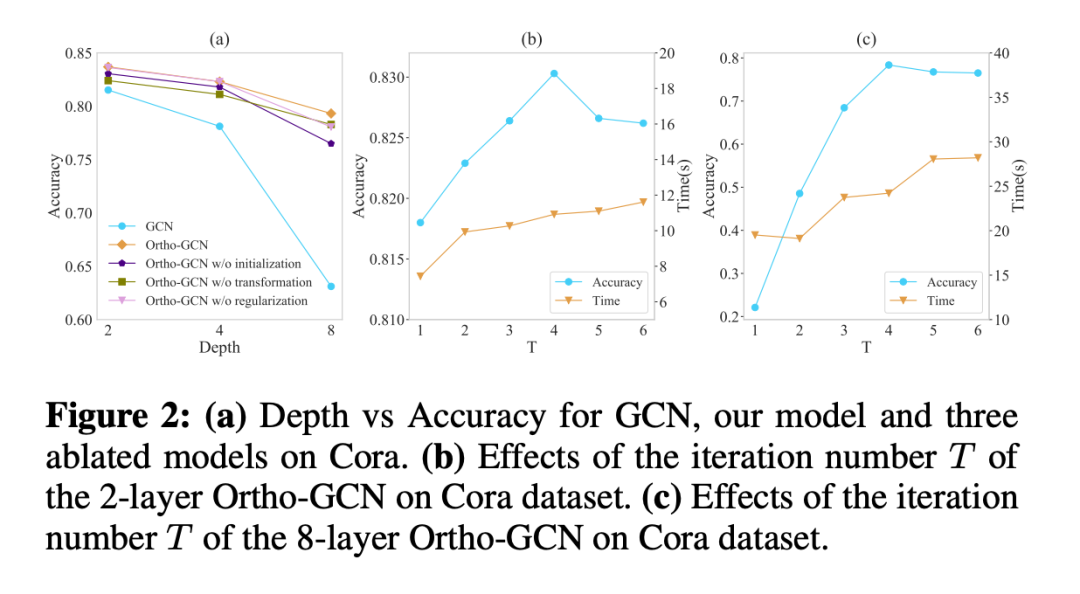

相比于深层的 GNNs 模型,本文更加关注影响浅层 GNNs 性能的主要因素。因为从图 1(d) 中可以看到,当 GNNs 的深度增加达到 8 层时,节点分类精度就会迅速下降,但此时还没有达到过平滑的状态。而作者发现仅仅移除特征转换模块,即便有几十个卷积层,但 GNNs 依然可以稳定的执行。

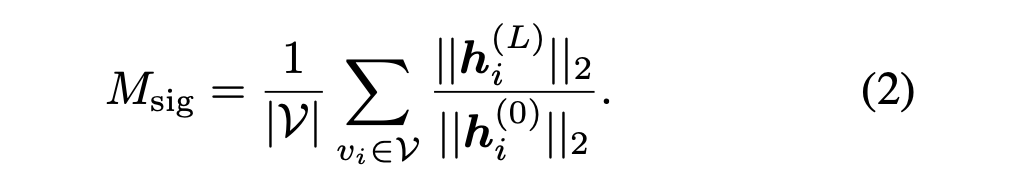

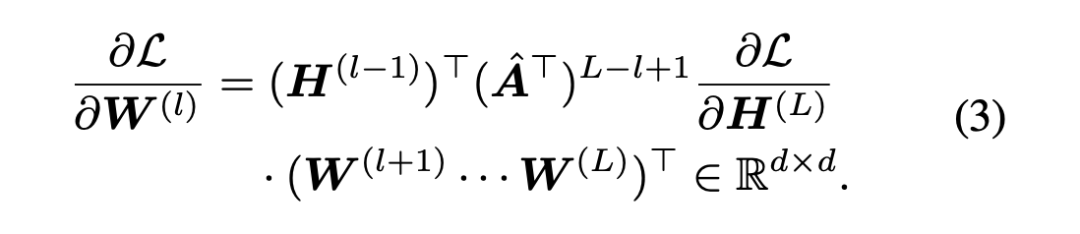

作者通过大量实验提出,因为设计了不恰当的特征转换导致不稳定的前向归一化和后向梯度,最终导致了 GNNs 性能下降。如图 1(a) 和 (b)vanilla GNNs 有前向嵌入爆炸和后向梯度消失的问题,前向嵌入爆炸改变了层之间的内部嵌入分布,使模型训练效率低下,后向梯度消失阻碍了特征转换模块适应下游任务的优化。因此作者认为 vanilla 特征转换在前向和后向都破坏了模型的稳定,从而导致性能降低。

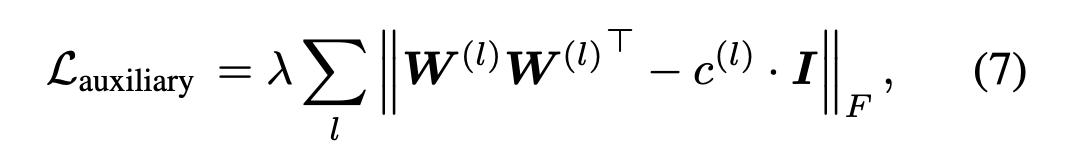

为了克服训练的不稳定性,本文提出了一种新的正交特征变换方法来保证特征变换的正交性,称为 Ortho-GConv,可以对现有的 GNNs 进行扩展,提升泛化能力。

论文链接:

实验方法

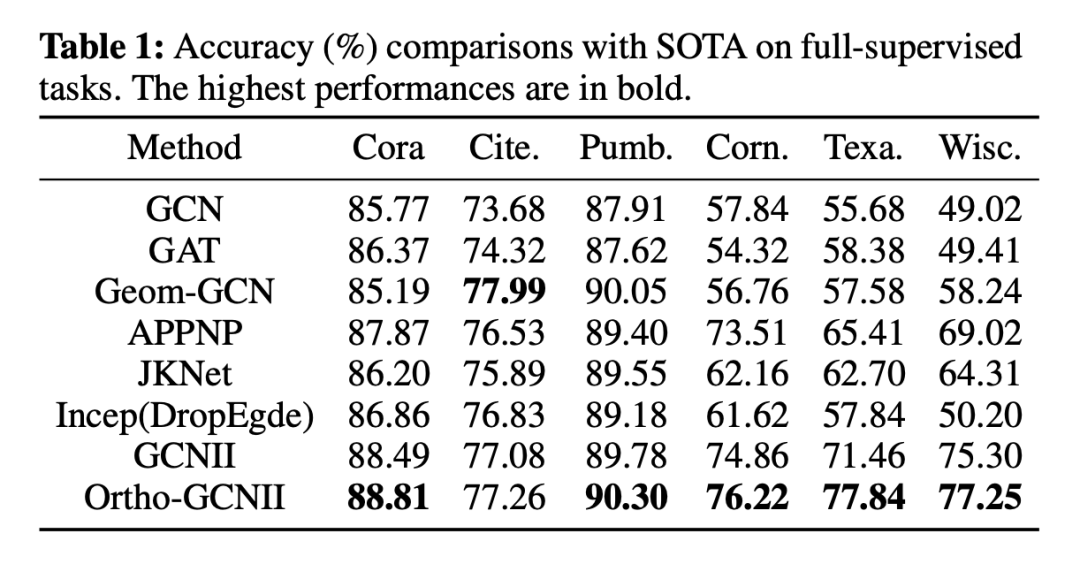

实验结果

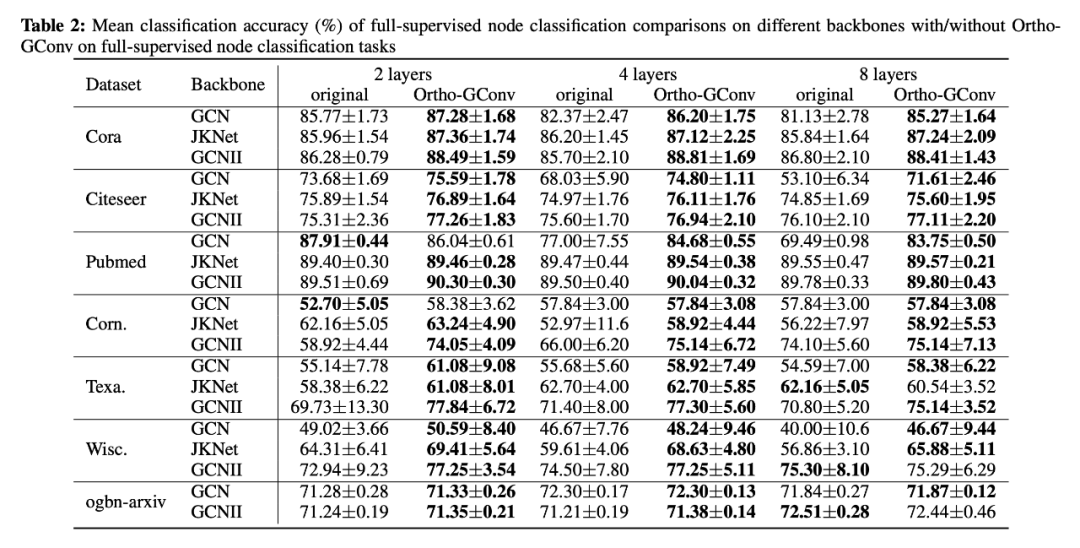

测试了在六个上的分类精确度,并进行了比较,Ortho-GCNII 的平均提升为 2.2%。

在不同的层数下,Ortho-GConv 在性能上都有一定的提升。在 Cora 和 Citeseer 上,Ortho-GConv 在 2 层基础上分别实现了 1.9% 和 2.1% 的提升;而在 8 层的情况下,获得了 2.8% 和 12.4% 的提升。

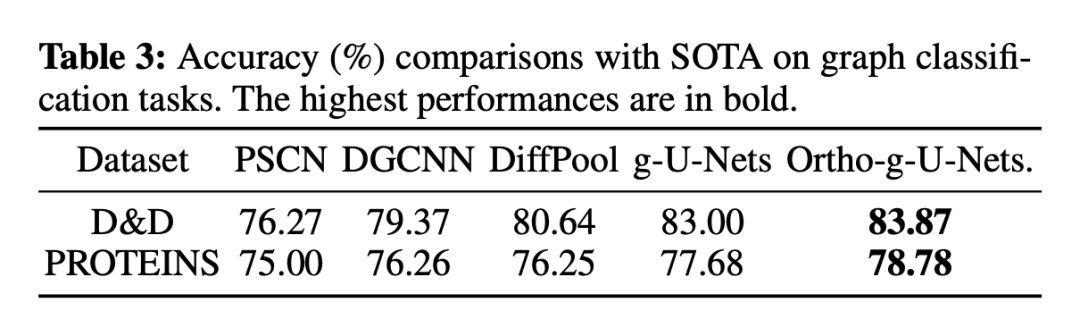

在 D&D 和蛋白质数据集上,Ortho-g-U-Nets 得到了较好的性能。

随着 T 的增加,时间消耗变得越来越大;较大的迭代次数和较小的迭代次数会降低我们提出的模型的性能。当迭代次数为 4 时,可以得到最好的性能。因此优化适当的T可以在可接受的时间复杂度下获得较高的精度。

本文首先进行了一系列的分析实验,探讨在使用更多卷积层时 GNNs 性能下降的原因,指出主要因素是 GNNs 中不稳定的前向和后向信号。因此提出了一种正交图卷积对 GNNs 进行增强,以稳定模型训练,提高模型的泛化性能。最后通过实验验证模型的性能。

登录查看更多

相关内容

Arxiv

20+阅读 · 2021年12月27日

Arxiv

15+阅读 · 2021年1月21日

Arxiv

13+阅读 · 2018年9月7日