图神经网络+推荐系统的最新进展

图神经网络+推荐系统已经成为了一个比较火热的研究方向,其中有哪些还需要进一步解决的问题,进一步提升图模型的协同过滤方法的性能呢?

CIKM'21 UltraGCN: Ultra Simplification of Graph Convolutional Networks for Recommendation

https://arxiv.org/pdf/2110.15114.pdf

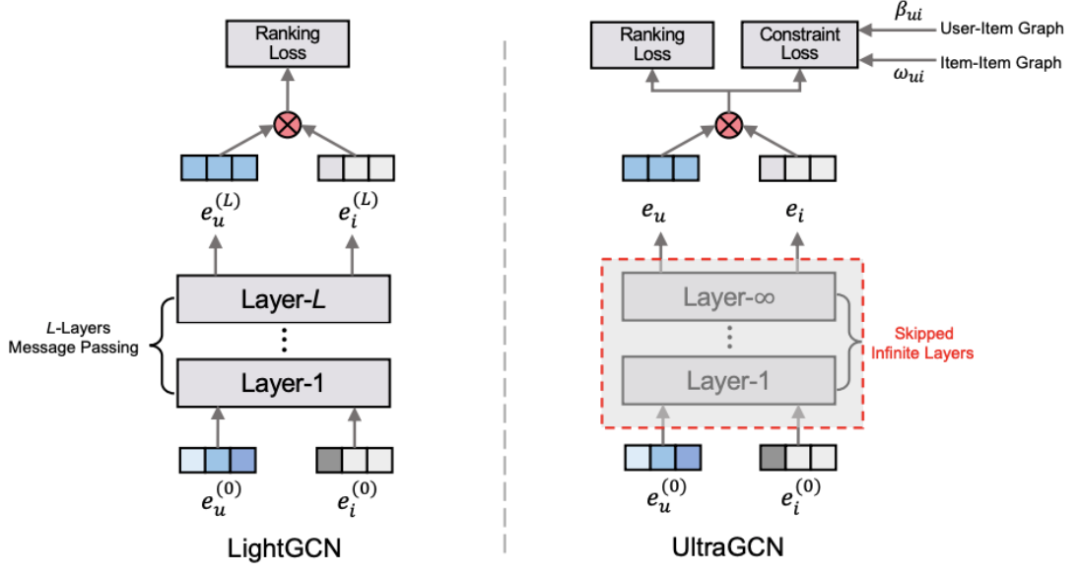

导读:文章分析了LightGCN为代表的图卷机神经网络模型在推荐系统上的局限性。其指出GCN在推荐系统场景下的核心是通过消息传播机制收集信息,而LightGCN简化了特征转换和非线性激活函数。文章进一步提出极简GCN模型(UltraGCN), 其跳过了无限的消息传播层进而进行更高效的推荐。相比显示的消息传播,UltraGCN通过constraint loss直接近似无限图卷积层的极限。同时,UltraGCN 灵活调整不同类型关系的边的权重,易于实现且训练高效。四个基准数据集的实验结果表明 UltraGCN 不仅优于LighGCN模型,也比 LightGCN 实现了 10 倍以上的加速。

CIKM'21 SimpleX: A Simple and Strong Baseline for Collaborative Filtering

https://arxiv.org/abs/2109.12613

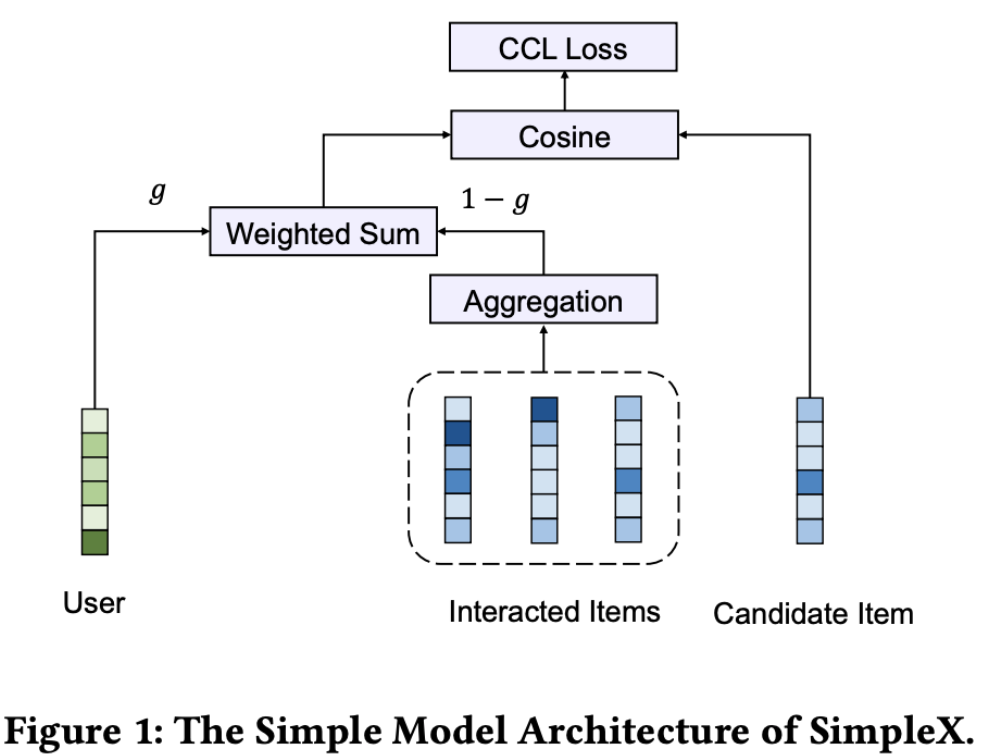

导读:这个工作的作者和前面的UltraGCN作者来自相同的机构。文章同样分析图神经模型应用于协同过滤场景。其认为对于一个协同过滤模型的学习依赖于3个组件:交互编码,损失函数和负采样。过去的方法主要是在于设计出有效的交互编码器,但是较少的关注到损失函数和负采样的比例。

本文则指出,选择损失函数和负采样的比例同样重要。文章提出一个余弦对比损失函数(CCL),并切进一步应用到一个简单的CF模型(SimpleX)中。实验在11个标准数据集上和29个CF模型比较,SimpleX 可以大幅度的超越当前的最优模型。作者认为SimpleX不仅能够作为一个简单的强有效基准模型,也进一步显示改善损失函数和负采样的必要性。

此外,上述的模型都基于一个benchmark系统,推荐系统研究人员可以进一步关注:https://github.com/openbenchmark/Open-Match-Benchmark

TKDE'21 Hierarchical User Intent Graph Network for Multimedia Recommendation

https://arxiv.org/pdf/2110.14925v1.pdf

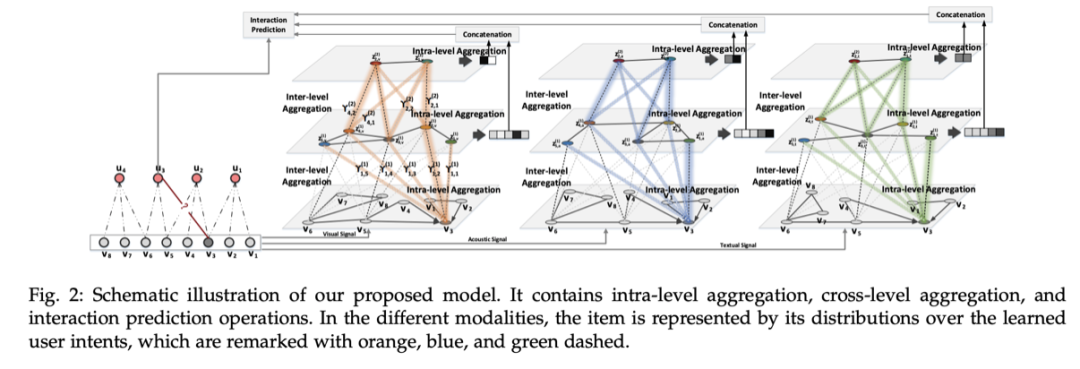

导读:文章关注的场景是多媒体推荐场景。其指出,了解用户对项目上下文的偏好是获得高质量多媒体推荐的关键。通常,对于物品会通过预训练模型提出表征,引入推荐系统中以捕获用户偏好。然而,作者认为这样的方式无法输出有效的用户表示,这很难很好地描述个人兴趣。关键原因是目前的方法在很大程度上保持用户意图不变,未能对用户的信息表示进行编码。

在本文中,作者的目标是从物品的交互模式中学习多层次的用户意图,以获得高质量的用户和物品的表示,并进一步提高推荐性能。为此,作者提出了一个新的框架等级用户意图网络(HUIGN)以层次图结构展示从细粒度到粗粒度的用户意图。