【学界】Hinton领衔谷歌大脑新研究,提出防御对抗攻击新方法

来源:量子位

最近,深度学习之父Geoffrey Hinton带领的谷歌大脑团队,提出了一种防御对抗攻击的新方法。

一种叫作DARCCC的技术,能将重构图像和输入图像作对比,继而识别出对抗图像,检测系统有没有受到攻击。

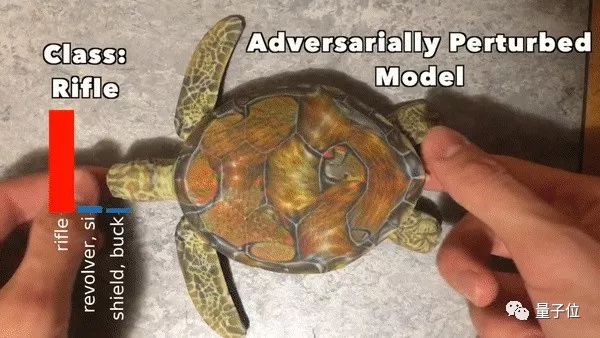

对抗攻击,是一种专职欺骗图片识别AI的方法。此前,那个广为流传的AI将乌龟识别成步枪的操作,就是对抗攻击的杰作。

悄悄修改图片的纹理,就可以在人类毫无察觉的情况下,骗过AI。

不过这一次,对抗攻击遇到了对手。

利用对抗攻击的弱点

虽然,对抗攻击是种高超的骗术,但也有弱点。

还以乌龟和步枪的故事为栗:

即便和步枪分在一类,乌龟还是和步枪长得很不一样。

Hinton团队就是利用它们之间的区别,来把那些分类错误的图像,从大部队里揪出来。

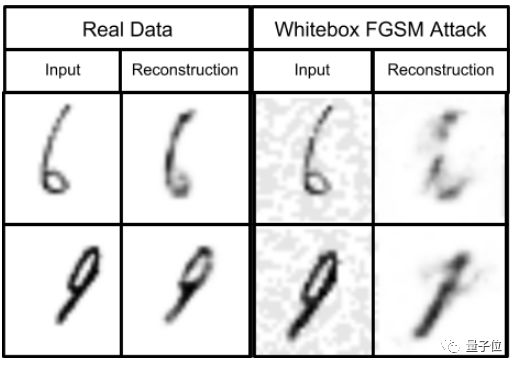

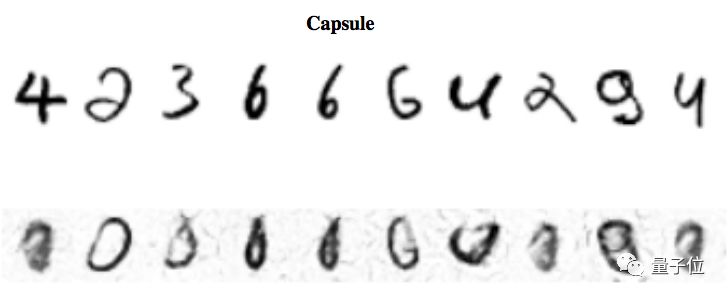

模型识别图像的时候,除了输出一个分类 (如乌龟/步枪) ,还会输出一个重构 (Reconstruction) 的图像。

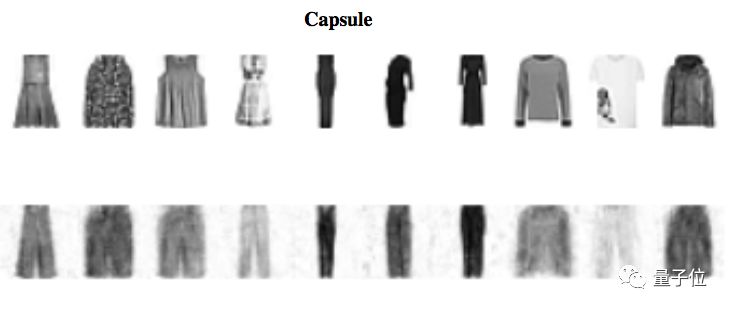

如果是对抗图像,重构出来会和原图差别很大 (在AI眼里已靠近步枪) 。若是未加篡改的真实图像,重构结果应该和输入图像 (乌龟) 很接近:

△ 受到白盒攻击之后,AI看到的东西,已经变了

所以,要做一个识别算法,就先给验证集的重构误差 (Reconstruction Error) 定义一个阈值。

只要一张图的重构误差超过这个阈值,就把它标记成对抗图像。

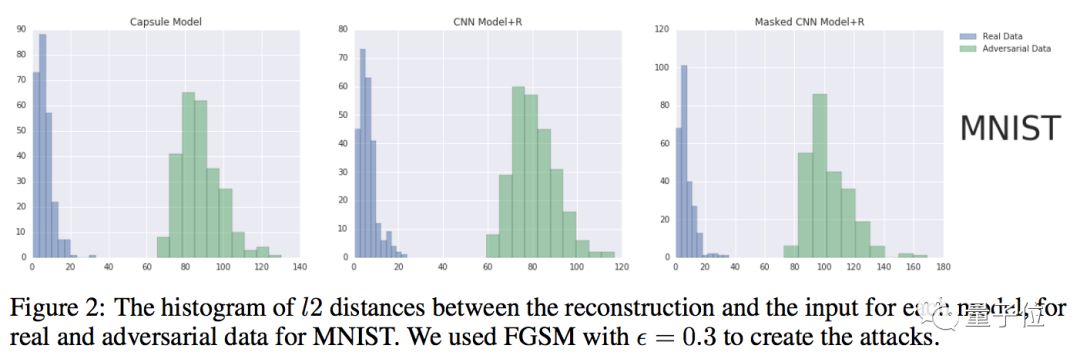

△ 输入与重构之间的距离

如此,这个算法就可以识别出,系统有没有受到不明力量的攻击。

魔高一尺,道高一丈

随后,研究人员将DARCCC扩展到更多标准图像分类网络中,进一步探索这种检测方法在黑盒攻击和典型的白盒攻击下是否有效。

Frosst等人选用MNIST、Fashion-MNIST和SVHN三个数据集,进行下一步:有效性验证。这一次,研究人员用了三种常用的白盒攻击方法。

前两种是白盒攻击中的常用的FGSM(Fast Gradient Sign Method)和BIM(Basic Iterative Methods)算法,这两次的结果让研究人员兴奋,因为这两种日常方法都没有攻击成功。

虽然DARCCC抵挡住FGSM和BIM的攻势,但在第三种白盒攻击面前,还是败下阵来。

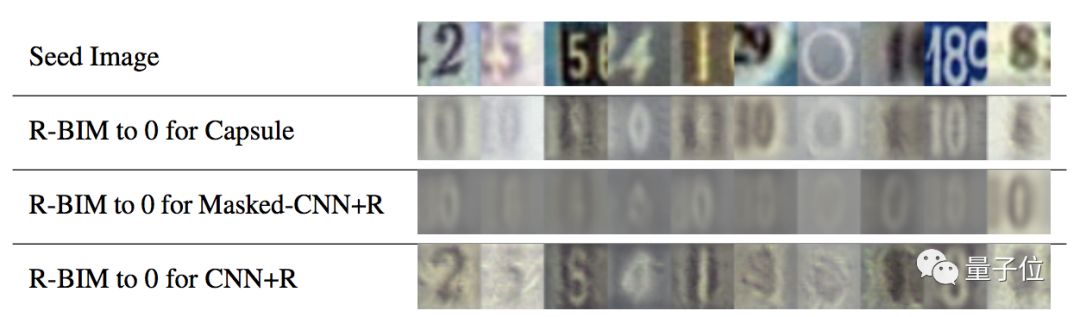

这种更强大的白盒攻击,叫做R-BIM(Reconstructive BIM)。可以把重构损失计算在内,不断迭代地扰乱图片。

这样一来,就算是对抗图像,AI还是可以为它生成一个优雅的重构。

系统就没有办法检测到攻击了。

这是在MNIST和fashionMNIST数据集中检测时的结果:

当用SVHN数据集检测时,结果如下:

传送门

目前,这篇论文DARCCC: Detecting Adversaries by Reconstruction from Class Conditional Capsules已经被NeurIPS的安全Workshop收录。

论文地址:

https://arxiv.org/abs/1811.06969

Frosst推特原文:

https://twitter.com/nickfrosst/status/1064593651026792448

☞ OpenPV平台发布在线的ParallelEye视觉任务挑战赛

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【学界】Ian Goodfellow等人提出对抗重编程,让神经网络执行其他任务

☞【学界】六种GAN评估指标的综合评估实验,迈向定量评估GAN的重要一步

☞【资源】T2T:利用StackGAN和ProGAN从文本生成人脸

☞【学界】 CVPR 2018最佳论文作者亲笔解读:研究视觉任务关联性的Taskonomy

☞【业界】英特尔OpenVINO™工具包为创新智能视觉提供更多可能

☞【学界】ECCV 2018: 对抗深度学习: 鱼 (模型准确性) 与熊掌 (模型鲁棒性) 能否兼得