【导读】对抗攻击防御研究用于提升深度学习的鲁棒性,是当下的关注焦点。最近,中山大学等学者发布了最新关于图对抗学习综述论文,19页pdf83篇文献,对在图形分析任务中对现有的攻防工作进行了梳理和统一,同时给出了适当的定义和分类。此外,我们强调了相关评价指标的重要性,并对其进行了全面的调查和总结。

图数据的深度学习模型在节点分类、链路预测、图数据聚类等各种图数据分析任务中都取得了显著的效果。然而,它们暴露了对于设计良好输入的不确定性和不可靠性, 对抗样本。因此,在不同的图数据分析任务中,出现了各种攻击和防御的研究,从而导致了图数据对抗学习中的竞争。例如,攻击者有投毒和逃避攻击,防御组相应地有基于预处理和对抗的方法。

尽管工作蓬勃发展,但仍然缺乏统一的问题定义和全面的调研综述。为了弥补这一不足,我们对已有的关于图对抗学习任务的研究进行了系统的总结。具体来说,我们在图形分析任务中对现有的攻防工作进行了梳理和统一,同时给出了适当的定义和分类。此外,我们强调了相关评价指标的重要性,并对其进行了全面的调查和总结。希望我们的工作可以为相关研究者提供参考,为他们的研究提供帮助。更多关于我们工作的细节,

请访问

https://github.com/gitgiter/Graph-Adversarial-Learning

https://www.zhuanzhi.ai/paper/d3c6ab73e330a4095be601732e9ea322

在过去的几十年里,深度学习已经成为人工智能领域的皇冠上的宝石,在语音和语言处理[72,18]、人脸识别[45]和目标检测[33]等各种应用中都表现出了令人印象深刻的表现。然而,最近频繁使用的深度学习模型被证明是不稳定和不可靠的,因为它们容易受到干扰。例如,一张图片上几个像素的细微变化,对于人眼来说是难以察觉的,但是对于深度学习模型[44]的输出却有很大的影响。此时,定义良好并通过反向传播学习的深度学习模型具有固有的盲点和非直观特征,应该以明显的[59]方式推广到数据分布中。

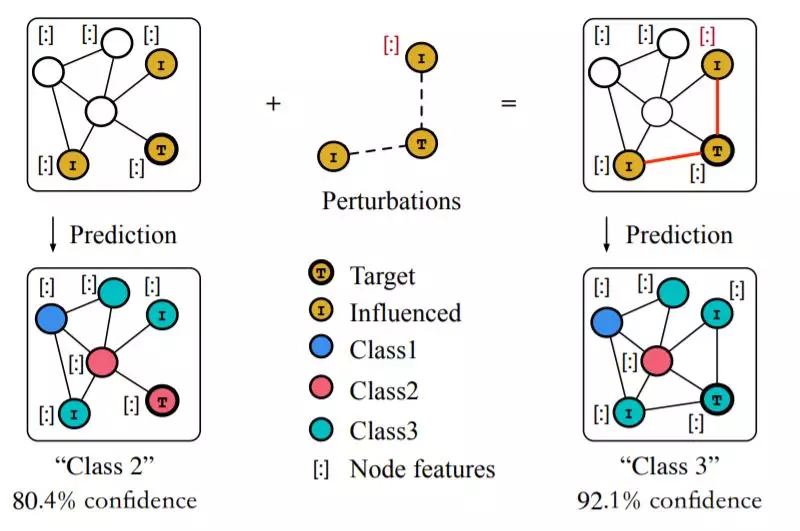

图作为一种强大的表示方法,在现实的[25]中有着重要的作用和广泛的应用。当然,深度学习对图形的研究也是一个热门话题,并在不同的领域带来了许多令人耳目一新的实现,如社交网络[46]、电子商务网络[64]和推荐系统[14,71]。不幸的是,作为机器学习关键领域的图分析领域也暴露了深度学习模型在受到精心设计的攻击时的脆弱性[81,83]。例如,考虑到节点分类的任务,攻击者通常控制多个假节点,目的是欺骗目标分类器,通过在这些节点与其他良性节点之间添加或删除边缘,从而导致误分类。通常,这些恶意节点被称为“攻击者节点”,而其他受害节点被称为“受影响节点”。如图1所示,在一个干净的图上执行了小的扰动(增加了两个链接,改变了几个节点的特征),这导致了图学习模型的错误分类。

随着对图数据模型安全性的日益关注,图数据对抗学习的研究也随之兴起。,一个研究图数据模型安全性和脆弱性的领域。一方面,从攻击图数据学习模型的角度出发,[81]首先研究了图数据的对抗性攻击,在节点特征和图结构受干扰较小的情况下,目标分类器容易对指定的节点进行欺骗和误分类。另一方面,[65]提出了一种改进的图卷积网络(GCNs)模型,该模型具有对抗防御框架,以提高鲁棒性。此外,[55]研究了现有的图数据攻防对抗策略的工作,并讨论了它们的贡献和局限性。然而,这些研究主要集中在对抗性攻击方面,而对防御方面的研究较少。

挑战 尽管关于图表对抗学习的研究大量涌现,但仍然存在一些需要解决的问题。i) 统一与具体的形式化。目前的研究都是将图对抗学习的问题定义和假设用自己的数学形式化来考虑,大多没有详细的解释,这使得比较和跟进更加困难。ii) 相关评价指标。而对于不同的任务,对应性能的评价指标也有很大的不同,甚至有不同的标准化。此外,图对抗学习场景的特殊度量还没有被探索,例如,对攻击影响的评估。

对于公式和定义不一致的问题,我们考察了现有的攻防工作,给出了统一的定义,并从不同的角度进行了划分。虽然已经有了一些努力[81,37,19]来概括定义,但大多数公式仍然对自己的模型进行定制。到目前为止,只有一篇文章[55]从综述的角度概述了这些概念,这不足以全面总结现有的工作。在前人研究的基础上,我们总结了不同类型的图,并按层次介绍了三个主要任务,分别在3.1节和4.1节给出了攻击和防御的统一公式。

自然地,不同的模型伴随着许多量化的方法,其中提供了一些新的度量。为了帮助研究人员更好地量化他们的模型,也为了系统地总结度量标准,我们在第5节中对度量标准进行了更详细的讨论。特别地,我们首先介绍了防御和攻击的一些常见度量,然后介绍了它们各自工作中提供的三个类别的度量:有效性、效率和不可感知性。例如,攻击成功率(ASR)[9]和平均防御率(ADR)[10]分别被用来衡量攻击和防御的有效性。

综上所述,我们的贡献如下:

- 我们深入研究了这一领域的相关工作,并对当前防御和攻击任务中不统一的概念给出了统一的问题公式和明确的定义。

- 我们总结了现有工作的核心贡献,并根据防御和攻击任务中合理的标准,从不同的角度对其进行了系统的分类。

- 我们强调了相关指标的重要性,并对其进行了全面的调查和总结。

- 针对这一新兴的研究领域,我们指出了现有研究的局限性,并提出了一些有待解决的问题