黑魔法防御术:Ian Goodfellow对抗样本研究现状与未来方向综述

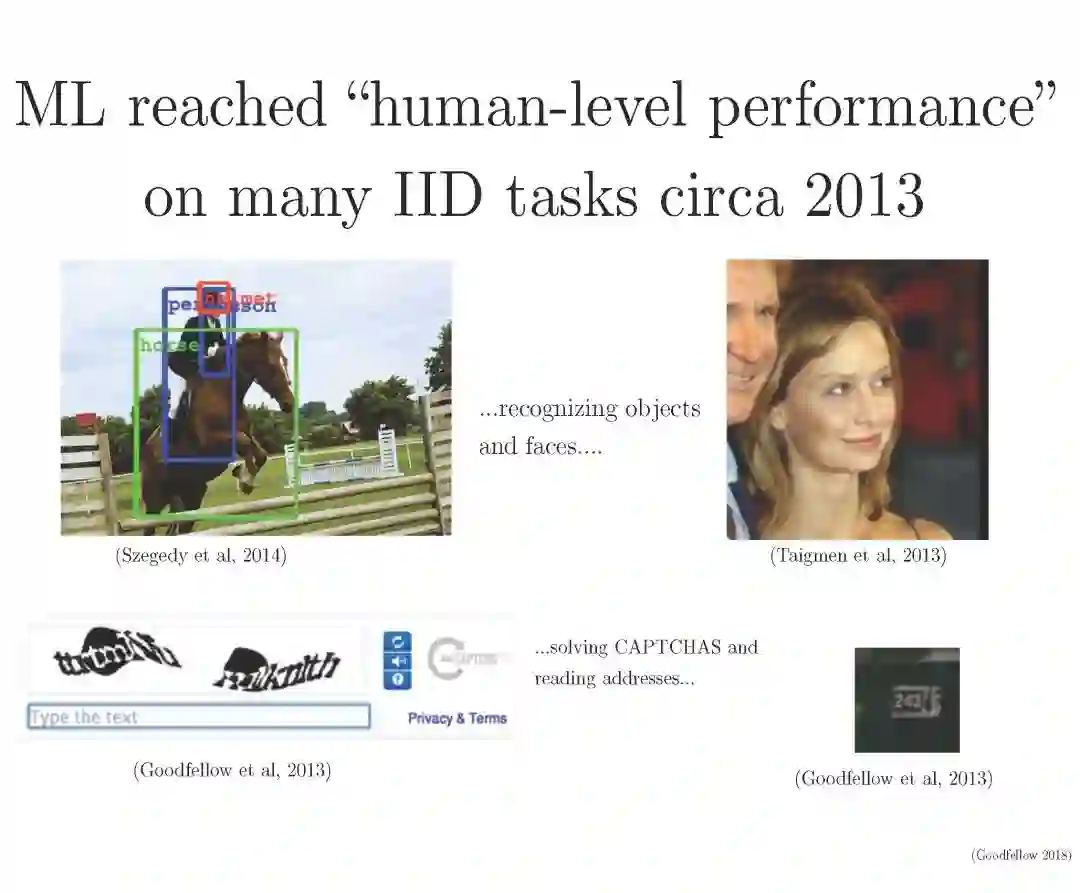

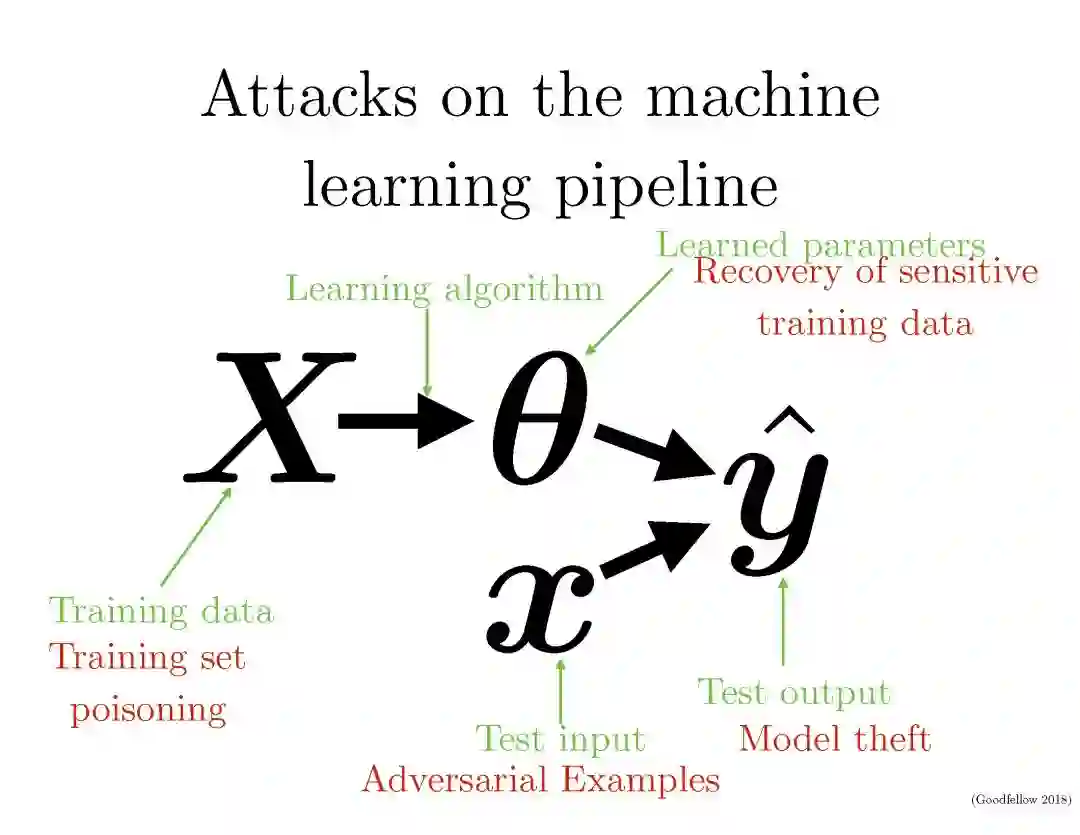

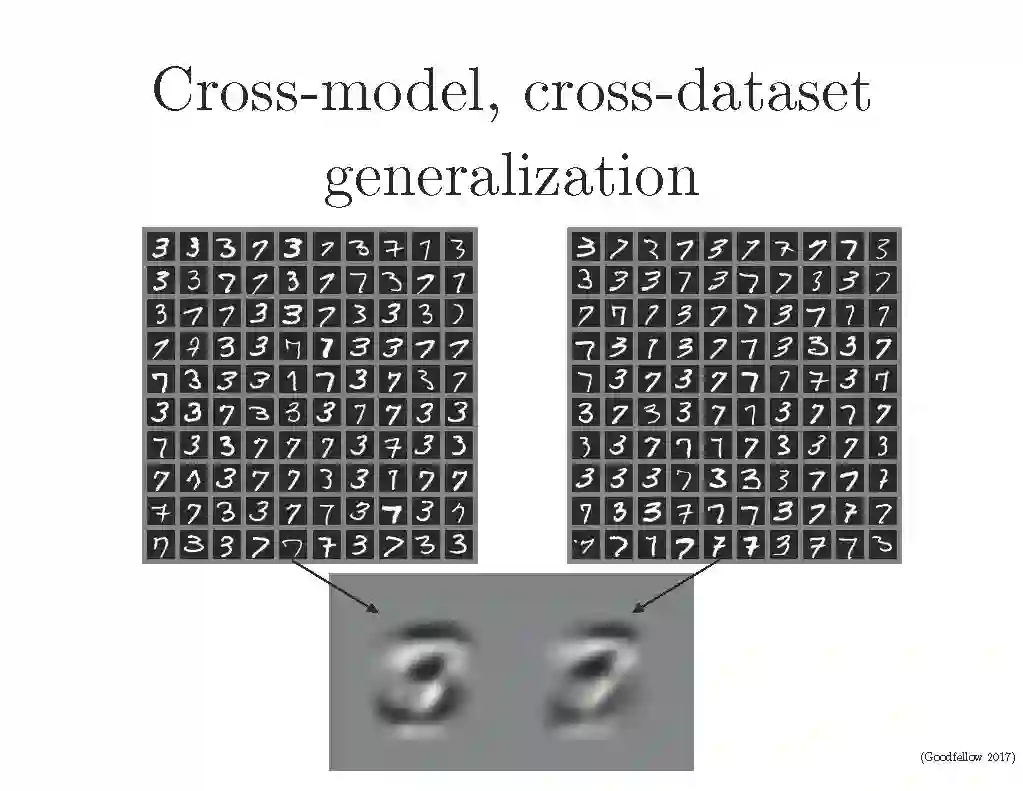

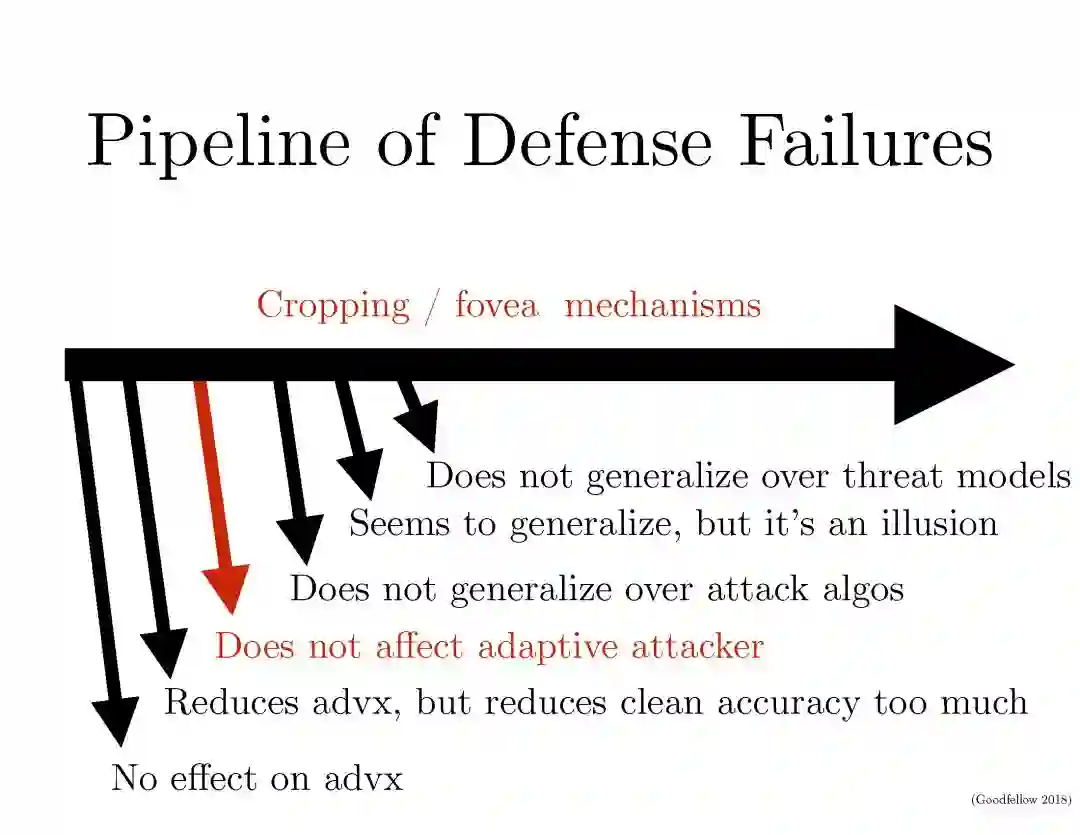

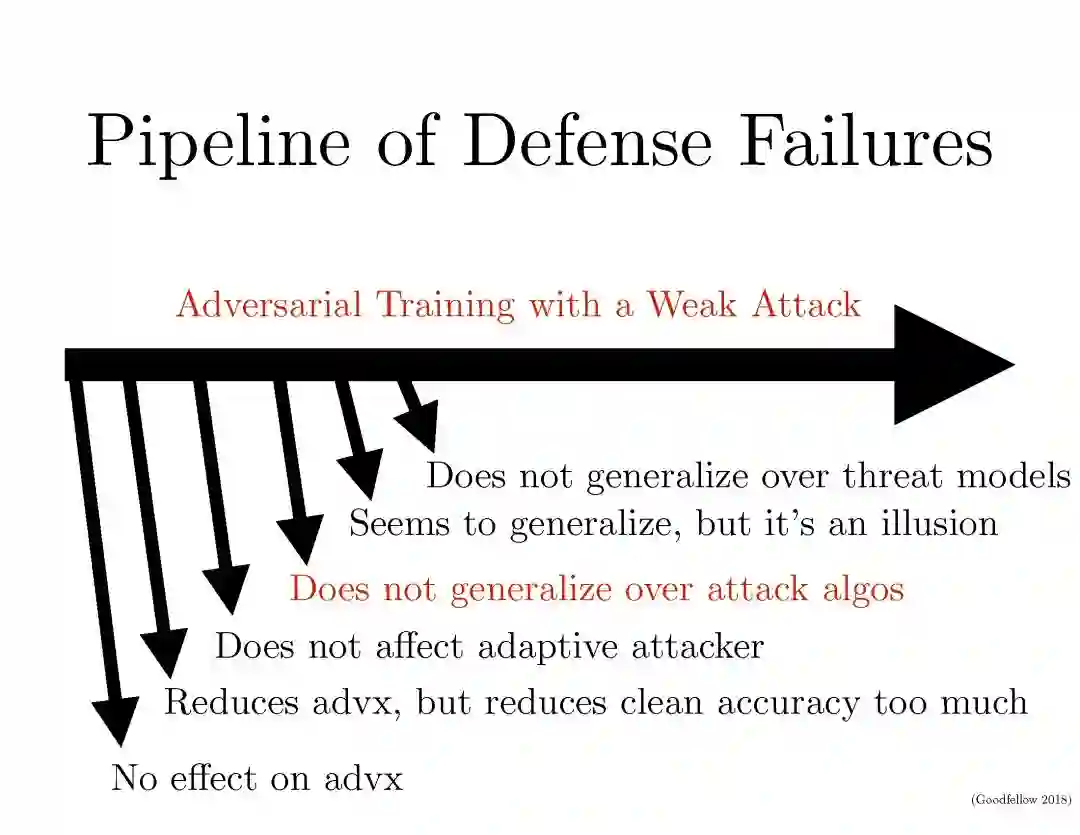

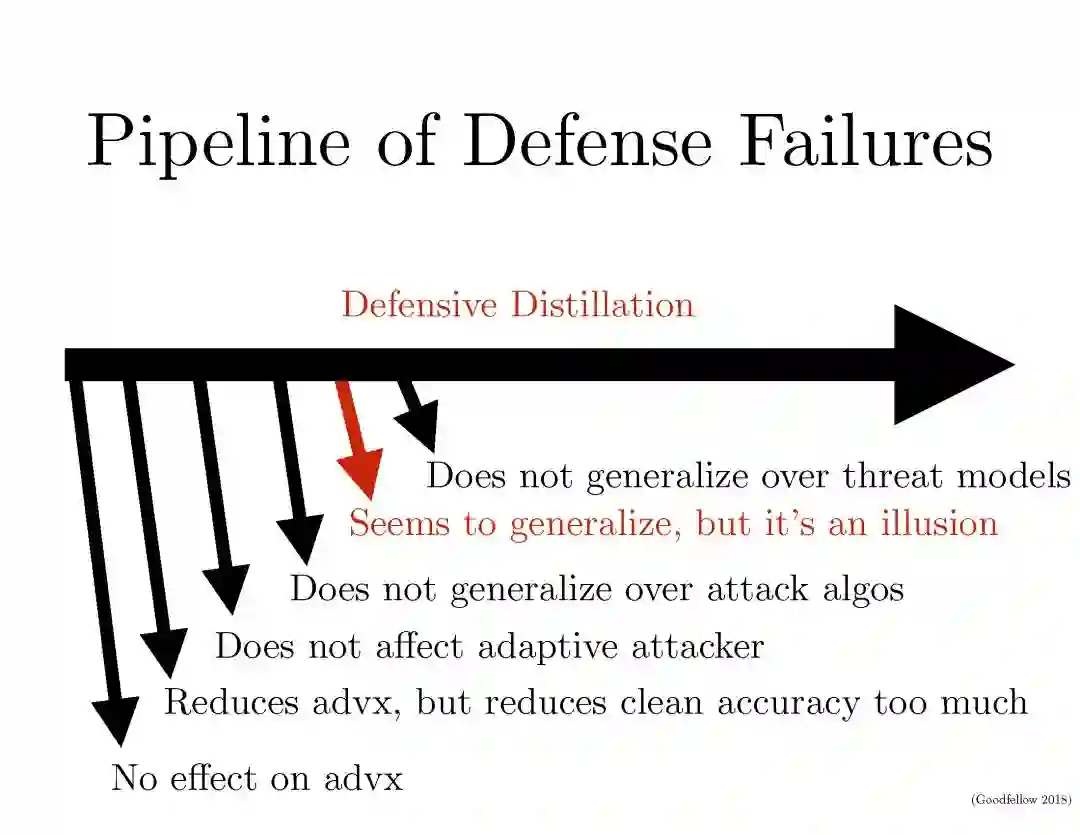

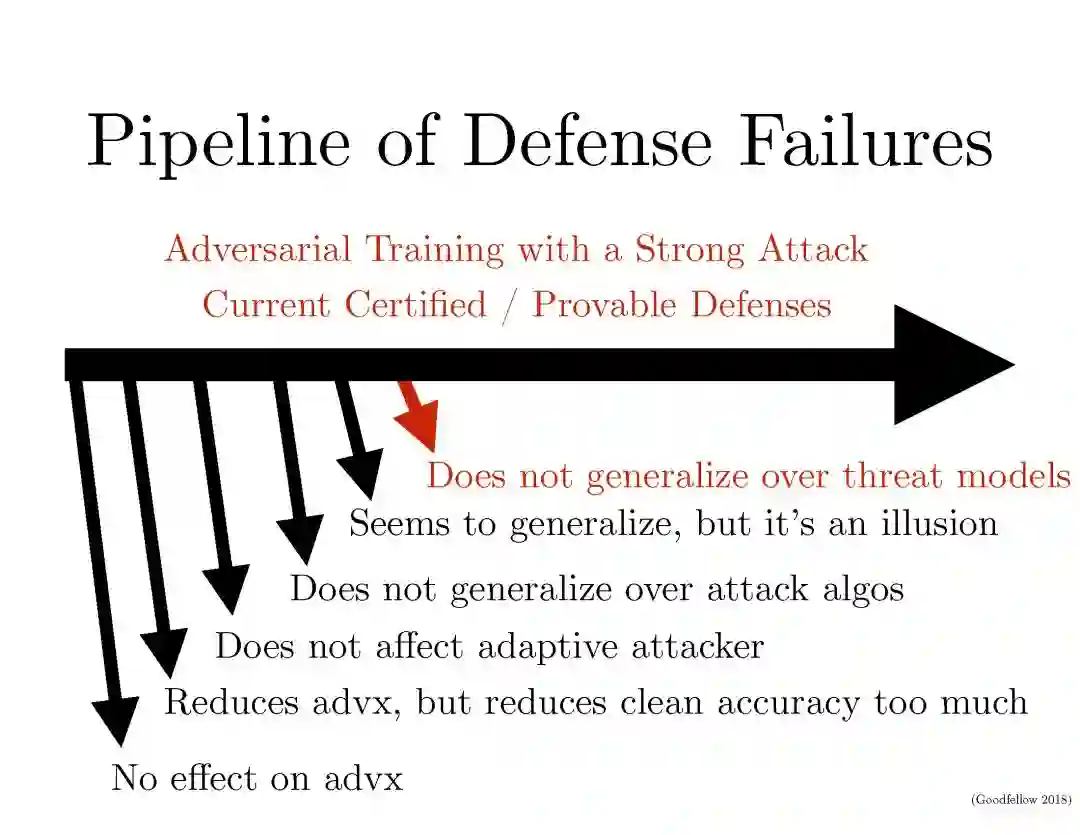

【导读】第一届深度学习与安全研讨会上GAN作者Ian Goodfellow带来关于人工智能安全的演讲,用对抗样本攻击机器学习。对抗样本是扮演攻击角色、试图用来引发模型出错的机器学习模型的输入。对抗样本难以防御是因为很难构造对抗样本处理过程的理论模型。对抗样本样本最近几年引起了人们对人工智能的极大担忧,比如专知在去年曾报道伊利诺伊大学香槟分校(UIUC)构建对抗样本的方法可以在图像上欺骗目标检测算法Faster RCNN,这可能使得基于图像的自动驾驶受到攻击,从而带来灾难性的后果。

详细请看专知以前报道:

对抗样本再下一城,攻陷目标检测!自动驾驶或受攻击?UIUC学者构建欺骗检测器的对抗样本!

什么是对抗样本

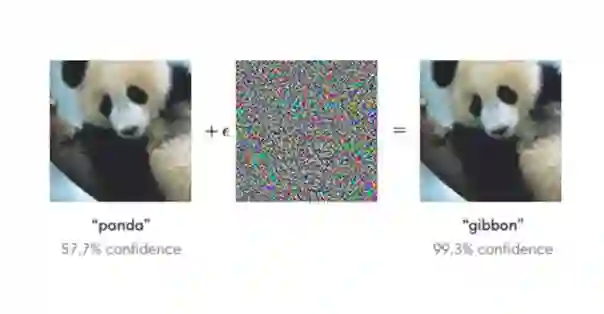

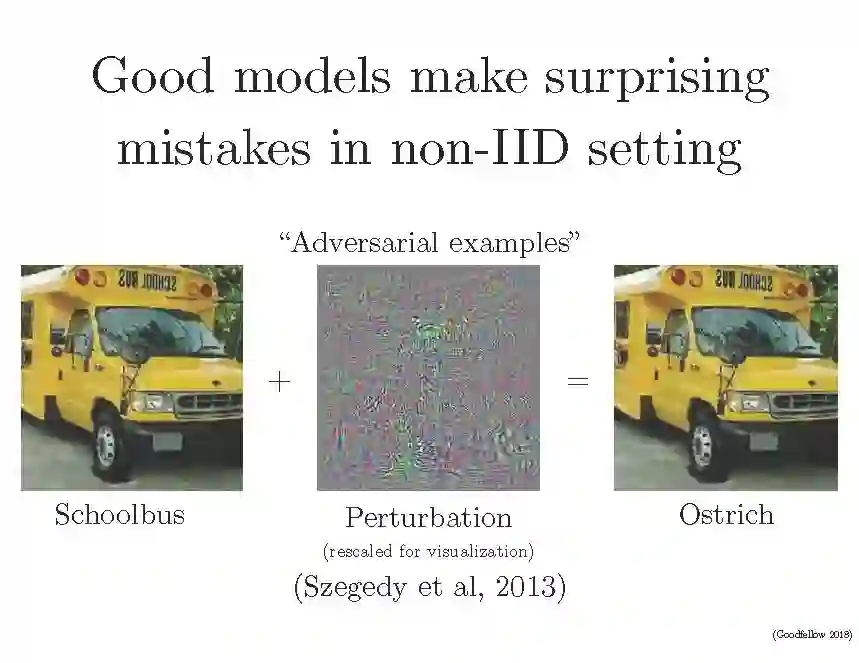

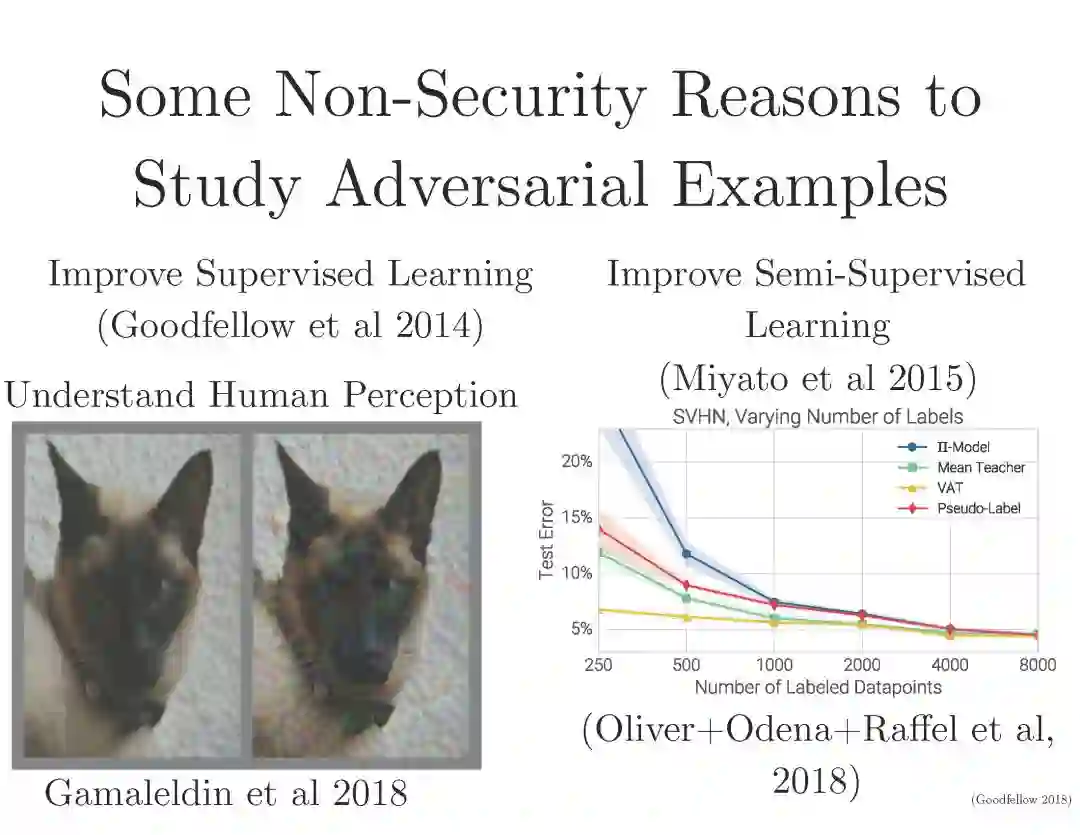

对抗样本是扮演攻击角色、试图用来引发模型出错的机器学习模型的输入;如同机器产生的光影幻觉。《Explaining and Harnessing Adversarial Examples》一文中有个很好的例子:首先提供一张熊猫图片,接着,攻击方给图片添加了小的噪声,虽然加上这个噪声过后再人类看来图片还是一张大熊猫的照片,但是在机器看来却有高达99.3%信心认定为一只长臂猿。

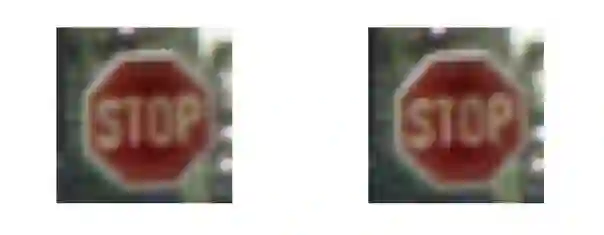

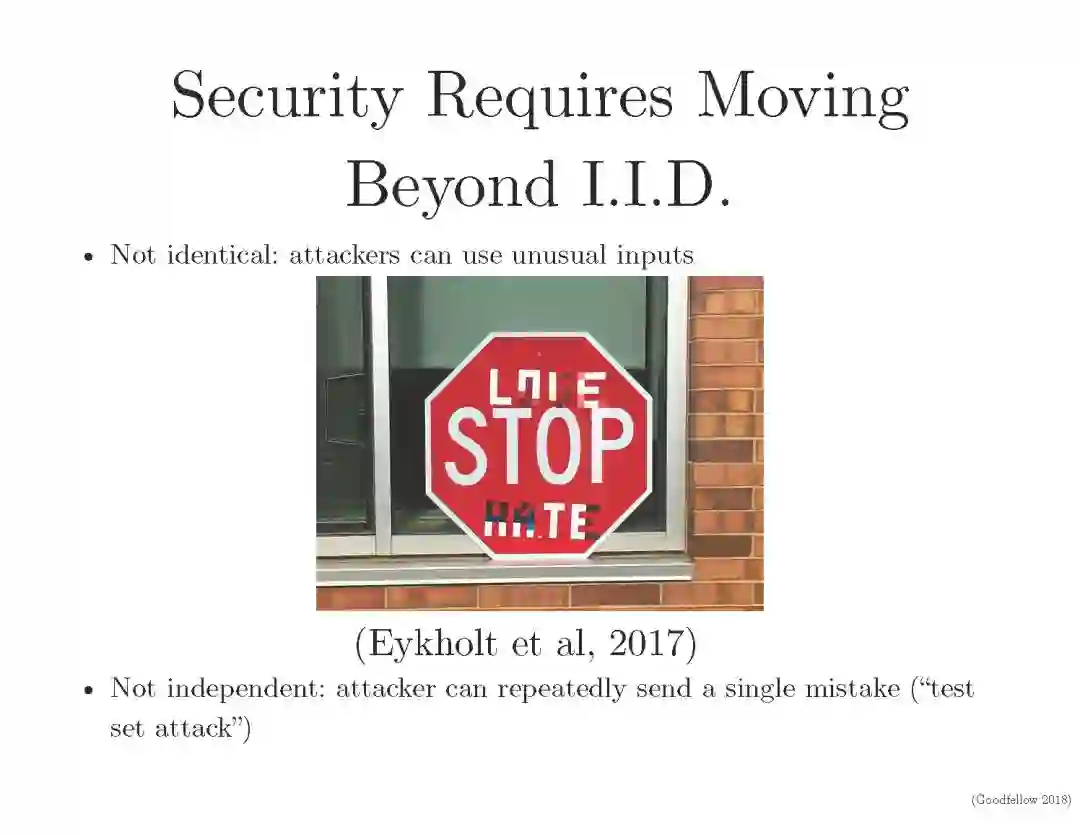

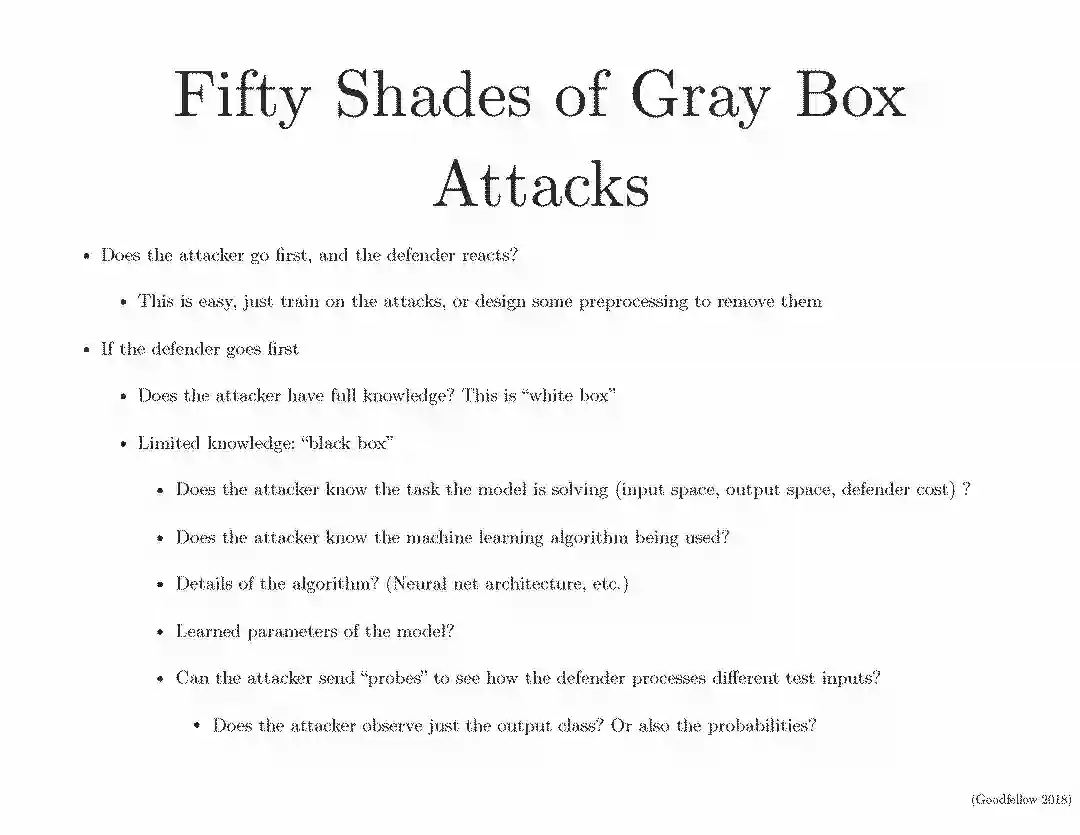

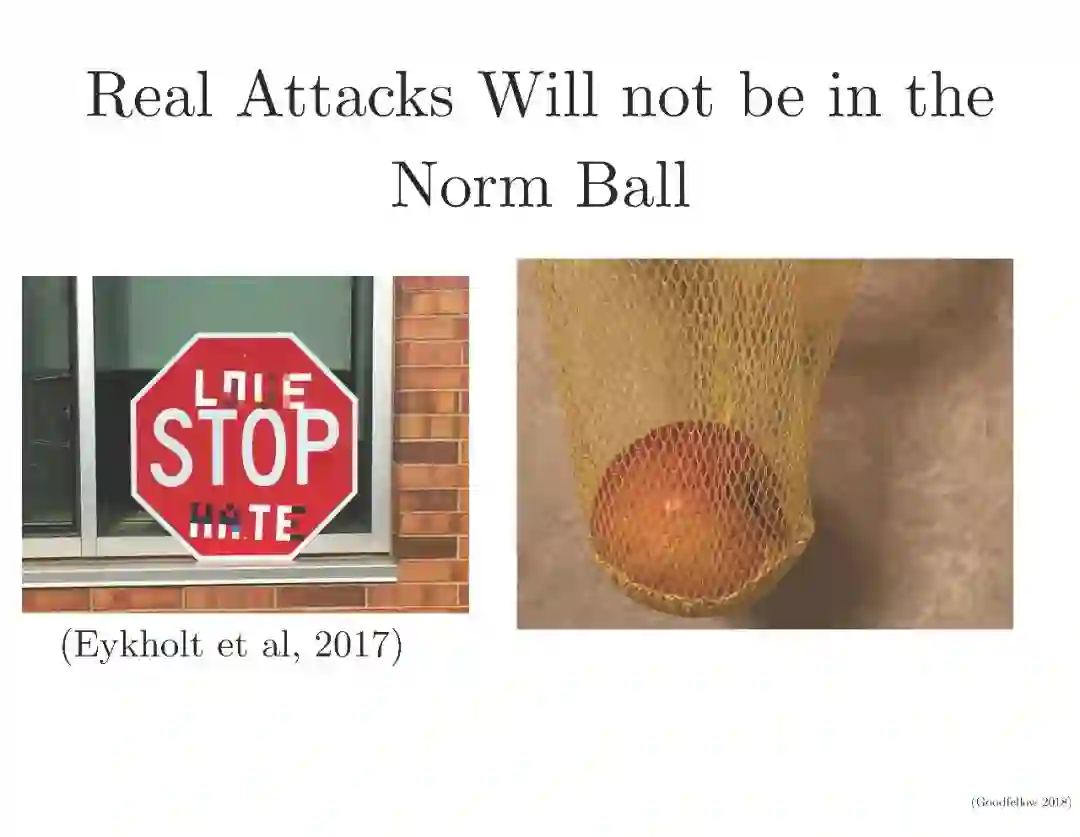

对于一些人为生成的在人眼看来毫无意义的噪声或者纹理,计算机可能会以极高的概率将其分为某种类别对抗样本具有潜在危险性。比如,攻击者可能会用贴纸或者一幅画做一个对抗式「停止(stop)」交通标志,将攻击对象瞄准自动驾驶汽车,这样,车辆就可能将这一「标志」解释为「放弃」或其他标识,进而引发危险。Practical Black-Box Attacks against Deep Learning Systems using Adversarial Examples 讨论过这个问题。左边正常的交通停止标志,右边其对抗样本,在人眼看来,这两张图几乎是无差别的,但是无人驾驶系统却会把右图认为是可以通行的标志。

演讲PPT

原文链接:

https://www.ieee-security.org/TC/SPW2018/DLS/

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“DLS2018” 就可以获取 2018年Ian Goodfellow最新PPT下载链接~

-END-

专 · 知

人工智能领域主题知识资料查看与加入专知人工智能知识星球服务群:

【专知AI服务计划】专知AI知识技术服务会员群加入与人工智能领域26个主题知识资料全集获取。欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知