机器之心专栏

作者:程雪莲、熊欢、范登平、钟怡然等

本文提出了一个用于视频伪装物体分割的方法 SLT-Net,并构建了第一个大规模 VCOD 数据集,MoCA- Mask,该研究入选CVPR 2022。

视频伪装物体检测(Video Camouflaged Object Detection,VCOD)是找出视频中在外观上与背景展现出极高相似性的物体的任务。尽管拥有广泛的应用场景(例如:监控与安防 [25]、自动驾驶 [33, 5]、医学图像分割 [12, 43]、蝗虫检测 [18] 与机器人 [29]),伪装物体检测(Camouflaged Object Detection,COD)仍是一项有挑战的任务,因为伪装物体往往连人眼都难以分辨。因此,在计算机视觉领域内,与视频目标检测(Video Object Detection,VOD) [48, 1]、视频显著性目标检测(Video Salient Object Detection, VSOD)[16] 以及视频运动分割(Video Motion Segmentation, VMS) [17, 47] 等任务相比,VCOD 仍是一个未被充分研究的问题。

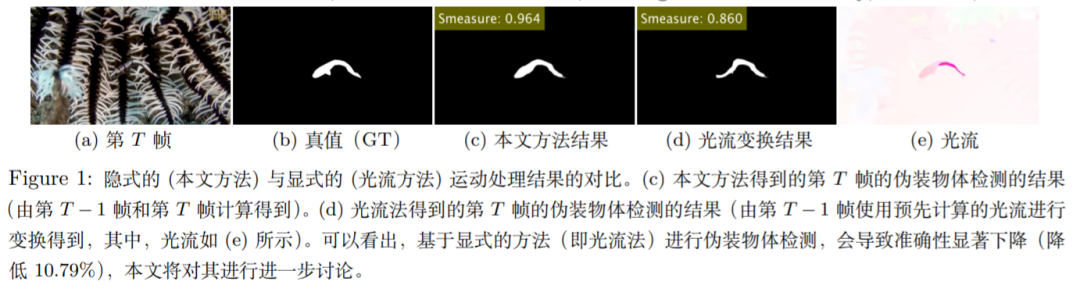

在大多数计算机视觉任务中(例如:实例分割 [52] 和显著性检测 [50]),都假设物体有清晰的边界。因此,在解决此类问题时可依赖于图像层面的信息,并且融合运动信息,还可以进一步提升目标任务的效果。相反,在伪装物体检测中,物体的边缘是模糊且难以分辨的。这不仅使得从图像中进行检测具有挑战,还导致了难以准确估计视频中的光流与运动线索 [38, 53, 37]。

缺乏清晰的边界,即伪装物体的外观与背景非常相似。这意味着两个主要的难点:

1) 物体边缘往往无缝地混合在背景中,只有当物体运动的时候才能被发现;

2) 物体通常有与环境相似的、重复的纹理。因此,想要通过帧间像素点的移动来估计运动(正如光流法所实现的),将难以预测且容易出错。考虑到第一个难点,要想解决 VCOD 任务,神经网络需要在运动信息的帮助下,有效地发现伪装物体与背景之间存在的细微差别。

此外,如图 1 所示,从第二个难点可以得知,运动信息本身是有噪声的,并且是不精确的。因此,将 VOD、VSOD 和 VMS 技术直接或组合地应用于 VCOD 任务, 往往会得到很差的结果。

![]()

本文提出了

SLT-Net

,一个用于解决 VCOD 任务的新模型。该模型利用短期动态与长期一致性信息,在视频中检测伪装物体。

具体来讲,本文使用一个短期动态模块来隐式地捕捉连续帧之间的运动。使用一个全程相关性金字塔策略(full-range correlation pyramid strategy)来隐式地表征运动,而非使用光流来显式地表征。使用相关性金字塔的主要动机是,即使是当前最先进的光流算法也会在伪装物体检测的任务中失败,并且其误差会在整个视频中累积。而本文的模型可以在仅有分割掩膜监督信息的情况下,同时对运动估计(隐式地)和分割预测进行优化。为了给出稳定的估计,本文进一步引入一个长期优化模块,用来降低短期动态模块中的误差累积。

SLT-Net 是由 Transformer 与 CNN 组件组合而成的混合模型。具体来讲,本文使用 Transformer 架构来编码特征,构建相关性金字塔(correlation pyramid)。该架构除了具有设计灵活的特点,Transformer 提取的特征还包含了全局上下文信息,其中包含长程依赖,以及更少的归纳偏差 [41, 32]。使得在运动估计中,更容易分辨被识别物体。

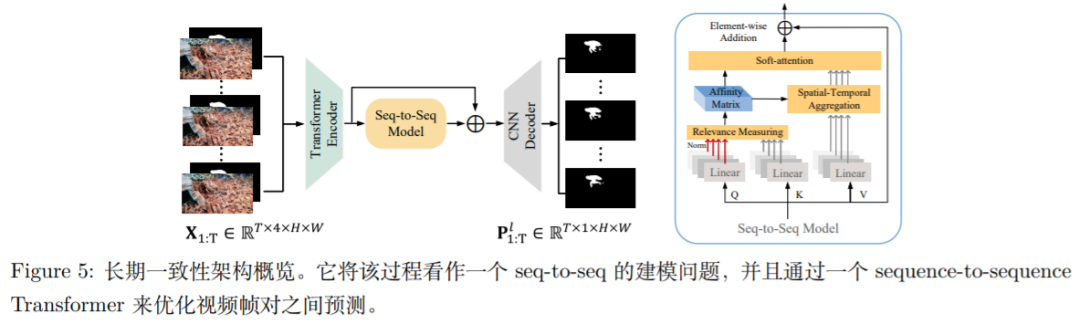

虽然相关性金字塔策略可以有效地捕捉运动,实现伪装物体检测。但是,由于它的计算复杂性高,无法方便地扩展到长视频序列中。为了解决这个问题,本文采用一个包含时空 Transformer 的 sequence-to-sequence 架构,通过长期一致性来优化并预测视频中连续帧。本文发现该架构相比标准的 ConvLSTM 模型 [45, 54],能得到更准确的预测结果。

此外,作为一个未被深入研究的问题,VCOD 缺乏大规模的数据集来进行系统地评测。为了促进该领域的发展,本文基于 MoCA(Moving Camouflaged Animals) [19],重新整理并构建了一个大规模的 VCOD 数据集,

MoCA-Mask

,该数据集包含 87 个视频序列,共计22,939 帧,并配有像素级的真值掩模。MoCA-Mask 囊括大量的挑战,例如:复杂的背景、微小的、完美伪装的物体。本文对数据集中的每个视频序列,每隔 5 帧,给出标注、包围盒、以及稠密的分割掩模。本文还提供了该领域第一个全面的评测基准,包含对已有的 VCOD 以及相关方法的测评。本文的贡献点概括如下:

本文提出了一个新的 VCOD 框架,它可以有效地建模视频中的短期动态与长期一致性。其中,伪装物体运动与分割可以同时被优化。

本文构建了第一个大规模 VCOD 数据集,MoCA- Mask,以促进 VCOD 领域的发展。以及一个全面的评测基准,为后续 VCOD 研究提供便利。

在 VCOD 任务上,本文的方法达到了当前最好的结果,超过之前的 SOTA 模型 [46] 达 9.88%。

![]()

论文主页:

https://xueliancheng.github.io/SLT-Net-project

本文 SLT-Net 模型的输入是一段包含有伪装物体的视频片段,输出是视频每一帧的像素级二值化伪装物体掩模。具体来讲,T 帧的视频片段用

![]()

![]() 来表示,其中 H, W 是帧的高与宽。本文的网络被用来估计出 t 时刻,视频帧 I^t的一个二值化的掩模

来表示,其中 H, W 是帧的高与宽。本文的网络被用来估计出 t 时刻,视频帧 I^t的一个二值化的掩模

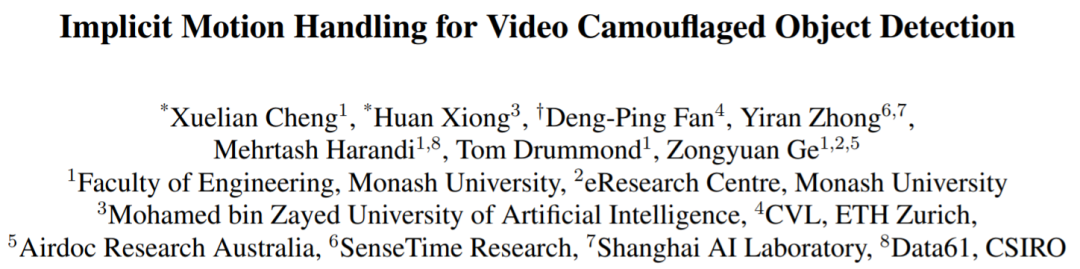

![]() 下图 2 为 SLT-Net 模型整体框架。SLT-Net 包括一个短期检测模块和一个长期优化模块。短期检测模块输入一对连续的帧,输出对于参考帧的伪装物体掩模的预测。使用一个 sequence-to-sequence 模块,用时序一致性先验,同步优化输入的视频片段的结果。本文采用两阶段(two-stage)策略来训练 SLT-Net 。首先,本文只用像素级标注来训练短期检测模块。一旦模型收敛,本文将长期优化模块连接到 SLT-Net ,固定短期检测模块,训练整个模型。

下图 2 为 SLT-Net 模型整体框架。SLT-Net 包括一个短期检测模块和一个长期优化模块。短期检测模块输入一对连续的帧,输出对于参考帧的伪装物体掩模的预测。使用一个 sequence-to-sequence 模块,用时序一致性先验,同步优化输入的视频片段的结果。本文采用两阶段(two-stage)策略来训练 SLT-Net 。首先,本文只用像素级标注来训练短期检测模块。一旦模型收敛,本文将长期优化模块连接到 SLT-Net ,固定短期检测模块,训练整个模型。

![]()

Figure 2: SLT-Net 的总体框架。SLT-Net 包含一个短期检测模块和一个长期优化模块。短期检测模块输入一对连续帧,输出参考帧的伪装物体掩模。长期优化模块输入由短期检测模块生成的 T 步预测,以及相应的参考帧,输出最终的预测结果。

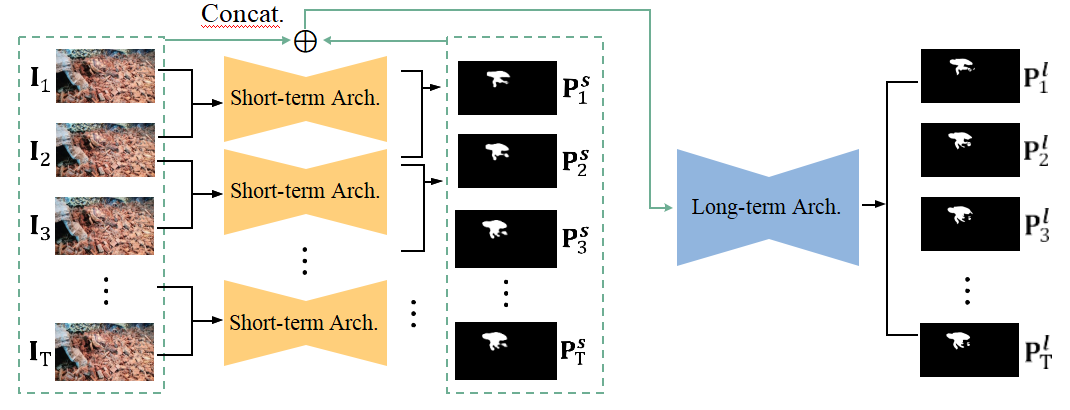

图3展示了本文的短期架构。它输入视频中的连续两帧,预测参考帧的二值化掩模。本文的模型包括三个主要模块:(1) Transformer 编码器,用来提取特征; (2) 短期相关性金字塔,用来捕捉短期动态; 以及 (3) CNN 解码器,用来预测短期分割。

![]()

1. Transformer 编码器:本文采用金字塔视觉 Transformer(Pyramid Vision Transformer,PVT [40] 的孪生结构(Siamese Structure)来从连续两帧提取特征。编码器包括四个阶段,分别从四个不同的尺度生成特征图。所有的阶段都共享相似的结构,其中包括一个 Patch 嵌入层和 Transformer Block。每个阶段的特尺寸是

![]() ,其中 H, W, C 分别表示高、宽和通道数。在实验中,本文设置 C = 32。

2. 短期相关性金字塔:本文提出一个相关性金字塔来隐式地捕捉运动信息。如图3所示,CNN 解码器直接将相关金字塔作为它唯一的输入。这意味着,只有在给定正确的运动估计前提下,网络才能给出正确的分割估计。此外,由于形成相关性金字塔的特征的更新,要用到分割的真值(Ground Truth)。因此,可以使用分割真值来同时优化运动估计和检测结果。

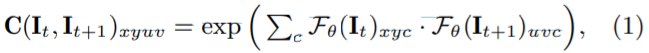

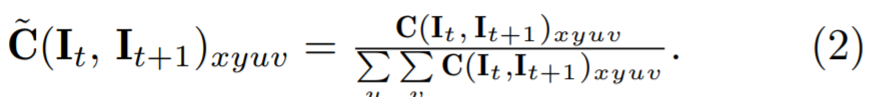

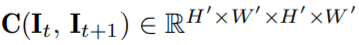

如图4所示,本文给出了相关性金字塔的核心单元,相关性聚合模块(Correlation Aggregation Block,CAB)C。给定一个视频帧特征对

,其中 H, W, C 分别表示高、宽和通道数。在实验中,本文设置 C = 32。

2. 短期相关性金字塔:本文提出一个相关性金字塔来隐式地捕捉运动信息。如图3所示,CNN 解码器直接将相关金字塔作为它唯一的输入。这意味着,只有在给定正确的运动估计前提下,网络才能给出正确的分割估计。此外,由于形成相关性金字塔的特征的更新,要用到分割的真值(Ground Truth)。因此,可以使用分割真值来同时优化运动估计和检测结果。

如图4所示,本文给出了相关性金字塔的核心单元,相关性聚合模块(Correlation Aggregation Block,CAB)C。给定一个视频帧特征对

![]() ,4D 相关性体积

,4D 相关性体积

![]() 定义如下:

定义如下:

![]()

其中,c 是帧的特征通道维度的索引(index)。随着所有的相邻特征被相关性给配对起来,本文可以在全局尺度找出其一致性。为了降低计算复杂度,本文通过对特征进行最大池化(max-pooling)来下采样相邻帧, 并保持参考帧的分辨率不变。该设计帮助模型在保持高分辨率图像细节的同时,还能学习多尺度位移。

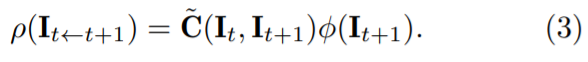

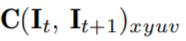

接下来,由于特征相关性体积在所有的空间位置上表征了参考帧与下采样相邻特征帧之间的一致性,本文对其

![]() 沿着最后两个维度 uv,基于他们的和(sum),做归一化。

归一化的相关性体积计算公式如下所示:

沿着最后两个维度 uv,基于他们的和(sum),做归一化。

归一化的相关性体积计算公式如下所示:

![]()

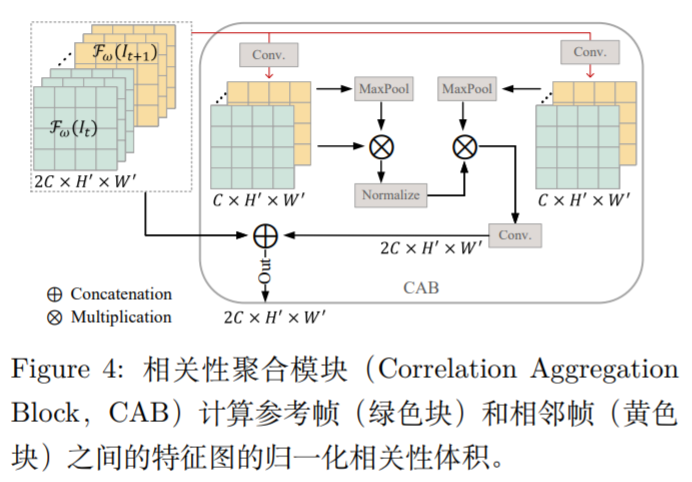

本文用一个卷积操作 ϕ(·) 来有选择的考虑通道维度的信息,因此,得到了优化的特征图 ϕ(I_t+1) ∈R^C×H′×W′。具体地,汇聚特征

![]()

![]() 通过如下公式计算得到:

通过如下公式计算得到:

![]()

![]()

3. CNN 解码器:如 [9] 所述,近邻连接解码器相比通常的连接解码器(如稠密连接或者短连接)更加可靠。此外,[9] 所使用的分组反向注意力(Group-Reversal Attention,GRA)策略可以在物体边界处提供更加准确的分割结果。基于此,本文直接将来自短期相关性金字塔的特征,即

![]() , i ∈ {2, 3, 4},输入到 GRA 中,生成优化的特征图。

近邻连接解码器(Neighbor Connection Decoder,NCD)用来生成粗糙的图,该图可以提供伪装物体大致定位的反向引导。

如此

,就可以汇聚来自 CNN 解码器的低层 特征和来自相关金字塔的高层特征。

给定一个来自短期架构的序列,

, i ∈ {2, 3, 4},输入到 GRA 中,生成优化的特征图。

近邻连接解码器(Neighbor Connection Decoder,NCD)用来生成粗糙的图,该图可以提供伪装物体大致定位的反向引导。

如此

,就可以汇聚来自 CNN 解码器的低层 特征和来自相关金字塔的高层特征。

给定一个来自短期架构的序列,

![]()

![]() 与像素级的预测

与像素级的预测

![]()

![]() , 本文将长期一致性优化过程定义为一个 seq-to-seq 问题。图5给出长期一致性的架构。本文使用同样的骨干网络,即 Transformer 编码器和 CNN 解码器模块,作为短期架构。因为该架构已经在伪装数据集做过了预训练,使得大大加速长期框架的训练过程。

, 本文将长期一致性优化过程定义为一个 seq-to-seq 问题。图5给出长期一致性的架构。本文使用同样的骨干网络,即 Transformer 编码器和 CNN 解码器模块,作为短期架构。因为该架构已经在伪装数据集做过了预训练,使得大大加速长期框架的训练过程。

![]()

对于输入序列的每一帧,本文将色彩帧 I_t 与其在通道维对应的预测

![]() 进行拼接,然后堆

叠每个序列中拼接的帧,形成一个 4D 张量

进行拼接,然后堆

叠每个序列中拼接的帧,形成一个 4D 张量

![]()

![]() 。

网络将

。

网络将

![]() 作为输入,输出

最终的预测 序列

作为输入,输出

最终的预测 序列

![]() 。

有两类 seq-to-seq 的建模框架:一类是使用 ConvLSTM 来建模时序信息,另一类使用基于 Transformer 的建模网络。本文实现了两种架构,并且在4.4小节对比了它们的结果。据本文所知,使用 Transformer 结构可以得到更好的结果,所以,本文选择 Transformer 来作为序列建模的网络,来引入长期一致性约束。

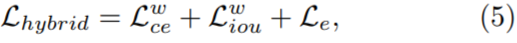

如图5中右侧所示,为 seq-to-seq 建模网络的细节。对于每一个目标像素,为了减少构建稠密时空相似度矩阵的复杂度,本文选择一个固定数量的关联性度量 块来构建受约束邻域内的相关度矩阵。训练中,本文采 用一个混合损失函数 [10]:

。

有两类 seq-to-seq 的建模框架:一类是使用 ConvLSTM 来建模时序信息,另一类使用基于 Transformer 的建模网络。本文实现了两种架构,并且在4.4小节对比了它们的结果。据本文所知,使用 Transformer 结构可以得到更好的结果,所以,本文选择 Transformer 来作为序列建模的网络,来引入长期一致性约束。

如图5中右侧所示,为 seq-to-seq 建模网络的细节。对于每一个目标像素,为了减少构建稠密时空相似度矩阵的复杂度,本文选择一个固定数量的关联性度量 块来构建受约束邻域内的相关度矩阵。训练中,本文采 用一个混合损失函数 [10]:

![]()

其中,

![]() 是增强对齐损失。

这样的混合损失可以 引导网络去学习像素级、物体级以及图像级的特征。

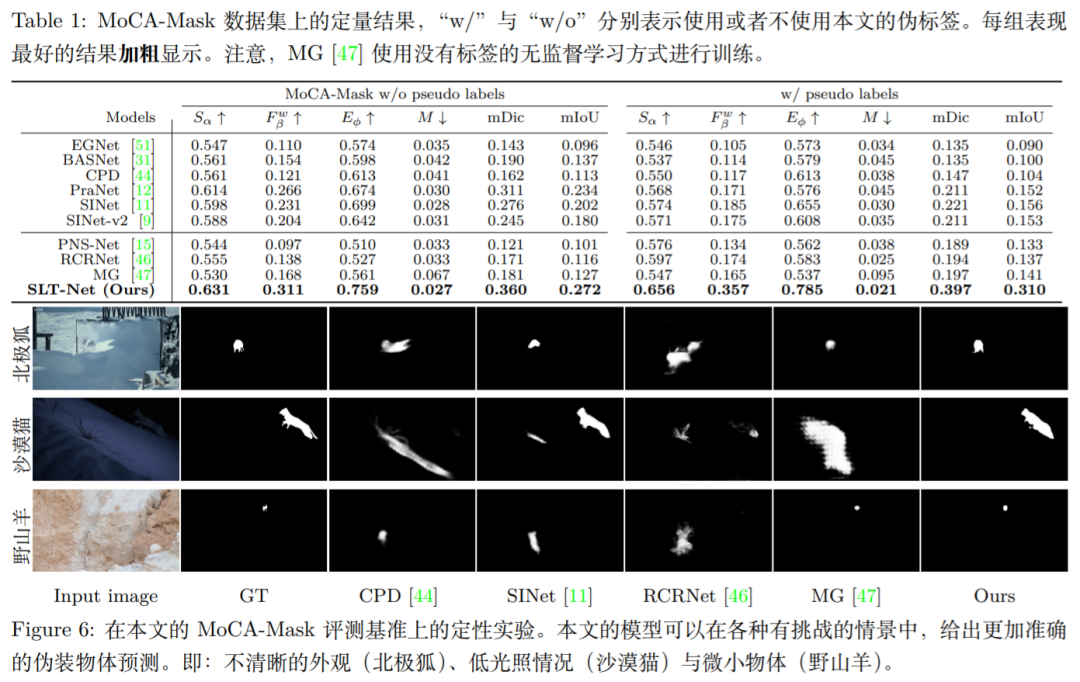

本节在 CAD 数据集和本文提出的 MoCA-Mask 数据集上,对本文所提的框架进行了系统地评估。本文同时给出了一个 VCOD 任务的全面的评测基准,来促进该领域发展。

MoCA-Mask 数据集上的性能:如表1所示,本文的方法明显优于对比方法。其中,在 S_α 指标上以 9.88% 的差距,超过当前最好的对比模型 RCRNet [46],在

是增强对齐损失。

这样的混合损失可以 引导网络去学习像素级、物体级以及图像级的特征。

本节在 CAD 数据集和本文提出的 MoCA-Mask 数据集上,对本文所提的框架进行了系统地评估。本文同时给出了一个 VCOD 任务的全面的评测基准,来促进该领域发展。

MoCA-Mask 数据集上的性能:如表1所示,本文的方法明显优于对比方法。其中,在 S_α 指标上以 9.88% 的差距,超过当前最好的对比模型 RCRNet [46],在

![]() 指标上以 92.97% 超过了 SINet [11] 模型。如图6, 给出本文的方法与基准模型的定性对比。本文的模型可以在很多有挑战性的情况(例如物体有纤细的躯干 或复杂的外观纹理、模糊或者突变运动)中,更加准确地定位与分割伪装物体。

指标上以 92.97% 超过了 SINet [11] 模型。如图6, 给出本文的方法与基准模型的定性对比。本文的模型可以在很多有挑战性的情况(例如物体有纤细的躯干 或复杂的外观纹理、模糊或者突变运动)中,更加准确地定位与分割伪装物体。

![]()

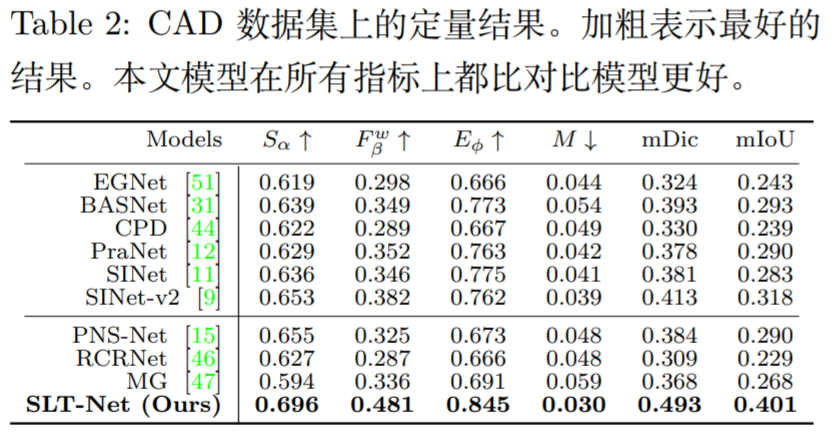

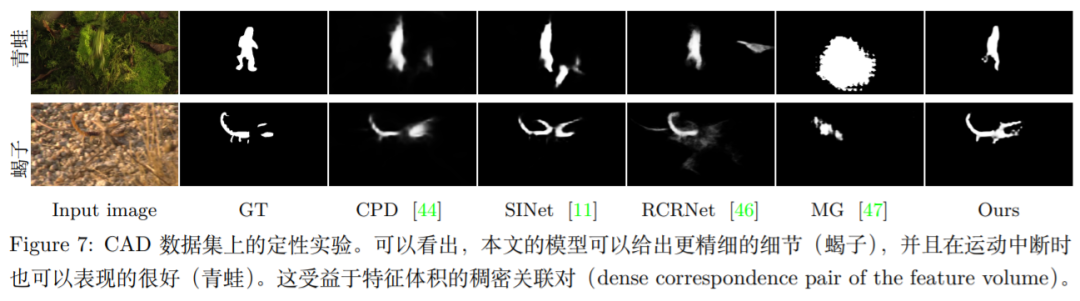

CAD 数据集上的性能:如表2所示,本文评估了不同方法在 CAD 数据集上的跨数据集的泛化性。本文的方法再次在所有 6 个评测指标上优于对比方法。进一步展现出本文方法的鲁棒性。如图7所示,本文的方法可以得到更加清晰的边界与更细粒度的可视化细节。这受益于模型在特征空间所构建的像素级相关性对。

![]()

![]()

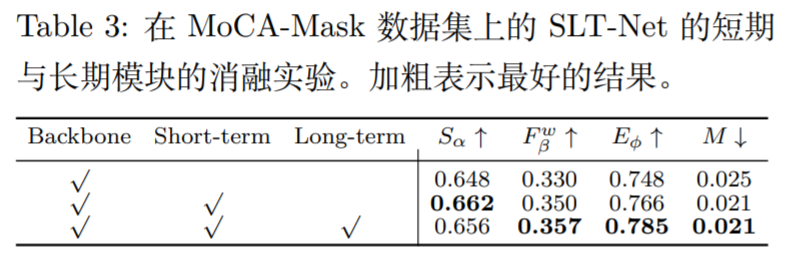

本文在 MoCA-Mask 数据集上进行消融实验。具体来讲,本文深入研究了:短期和长期模块的功能性分析,sequence-to-sequence 框架选择以及本文的伪掩模。

短期和长期模块:本文从两个方面来评估短期和长期模块的有效性。首先,如表3所示,本文在 MoCA-Mask 数据集上对短期和长期模块进行了消融实验。

![]()

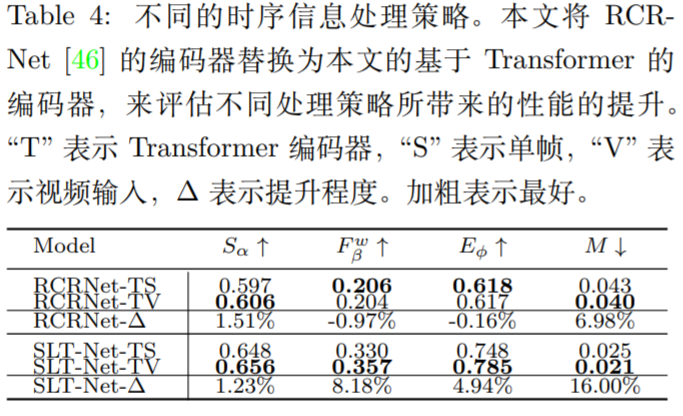

然后,本文在当前先进的 VSOD 模型 RCRNet [46] 上,用本文的基于 Transformer 的编码器来替换它原来的编码器,用来比较这两种方法对于时序信息的处理策略,结果如表4所示。在时空一致性建模层面,在评估指标上,能看出操作所带来的指标的提升与下降,在 S_α 指标上提升1.51%,在

![]() 上下降 0.97%,在 E_ϕ 上降低 0.16%,在 M 上提升 6.98%。

上下降 0.97%,在 E_ϕ 上降低 0.16%,在 M 上提升 6.98%。

![]()

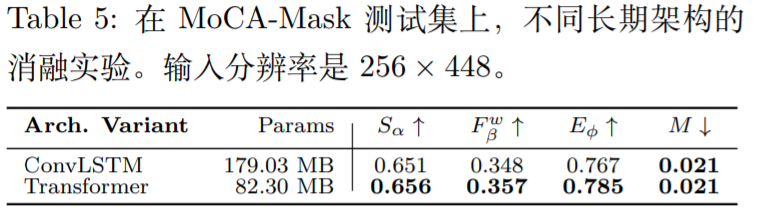

Transformer 与 ConvLSTM 的对比:本文用两种不同的方法来实现长期架构,分别是基于 Transformer 的方法和基于 ConvLSTM 的方法。对于 ConvLSTM 方法,本文采用了 [6] 提出的一个比较新的 ConvLSTM 模型变体,但是本文将其中 VGG 风格的 CNN 编码器解码器结构,用本文的 Transformer 风格的骨干网络代替。从表5中能看到,Transformer 变体相比 ConvLSTM 模型在 4 个指标上都更优,

并且参数量更少。

![]()

本文提出了一个用于视频伪装物体分割的方法 SLT-Net。具体来讲,本文使用短期模块来隐式捕捉连续帧之间的运动,使得本文可以在一个框架下同时优化运动的估计和分割。本文还提出了一个基于 sequence- to-sequence Transformer 的长期模块,来保证视频序列上的时序一致性。为了促进 VCOD 领域的发展,本文重新构造了名为 MoCA-Mask 的新数据集,包括了 87 段高质量视频序列,共计 22,939 帧,是 VCOD 领域目前最大的像素级标注数据集,使得物体级别评测成为可能。对比了当前最先进的基准模型,本文提出的网络在两个 VCOD 评测基准上均取得了最优的表现。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

来表示,其中 H, W 是帧的高与宽。本文的网络被用来估计出 t 时刻,视频帧 I^t的一个二值化的掩模

来表示,其中 H, W 是帧的高与宽。本文的网络被用来估计出 t 时刻,视频帧 I^t的一个二值化的掩模

,其中 H, W, C 分别表示高、宽和通道数。在实验中,本文设置 C = 32。

,其中 H, W, C 分别表示高、宽和通道数。在实验中,本文设置 C = 32。

,4D 相关性体积

,4D 相关性体积

定义如下:

定义如下:

沿着最后两个维度 uv,基于他们的和(sum),做归一化。

归一化的相关性体积计算公式如下所示:

沿着最后两个维度 uv,基于他们的和(sum),做归一化。

归一化的相关性体积计算公式如下所示:

通过如下公式计算得到:

通过如下公式计算得到:

, i ∈ {2, 3, 4},输入到 GRA 中,生成优化的特征图。

近邻连接解码器(Neighbor Connection Decoder,NCD)用来生成粗糙的图,该图可以提供伪装物体大致定位的反向引导。

如此

,就可以汇聚来自 CNN 解码器的低层 特征和来自相关金字塔的高层特征。

, i ∈ {2, 3, 4},输入到 GRA 中,生成优化的特征图。

近邻连接解码器(Neighbor Connection Decoder,NCD)用来生成粗糙的图,该图可以提供伪装物体大致定位的反向引导。

如此

,就可以汇聚来自 CNN 解码器的低层 特征和来自相关金字塔的高层特征。

与像素级的预测

与像素级的预测

, 本文将长期一致性优化过程定义为一个 seq-to-seq 问题。图5给出长期一致性的架构。本文使用同样的骨干网络,即 Transformer 编码器和 CNN 解码器模块,作为短期架构。因为该架构已经在伪装数据集做过了预训练,使得大大加速长期框架的训练过程。

, 本文将长期一致性优化过程定义为一个 seq-to-seq 问题。图5给出长期一致性的架构。本文使用同样的骨干网络,即 Transformer 编码器和 CNN 解码器模块,作为短期架构。因为该架构已经在伪装数据集做过了预训练,使得大大加速长期框架的训练过程。

进行拼接,然后堆

叠每个序列中拼接的帧,形成一个 4D 张量

进行拼接,然后堆

叠每个序列中拼接的帧,形成一个 4D 张量

。

网络将

。

网络将

作为输入,输出

最终的预测 序列

作为输入,输出

最终的预测 序列

。

。

是增强对齐损失。

这样的混合损失可以 引导网络去学习像素级、物体级以及图像级的特征。

是增强对齐损失。

这样的混合损失可以 引导网络去学习像素级、物体级以及图像级的特征。

指标上以 92.97% 超过了 SINet [11] 模型。如图6, 给出本文的方法与基准模型的定性对比。本文的模型可以在很多有挑战性的情况(例如物体有纤细的躯干 或复杂的外观纹理、模糊或者突变运动)中,更加准确地定位与分割伪装物体。

指标上以 92.97% 超过了 SINet [11] 模型。如图6, 给出本文的方法与基准模型的定性对比。本文的模型可以在很多有挑战性的情况(例如物体有纤细的躯干 或复杂的外观纹理、模糊或者突变运动)中,更加准确地定位与分割伪装物体。

上下降 0.97%,在 E_ϕ 上降低 0.16%,在 M 上提升 6.98%。

上下降 0.97%,在 E_ϕ 上降低 0.16%,在 M 上提升 6.98%。