CVPR 2022 | 上交&腾讯&港中文开源FAME:助力视频表征学习运动感知的数据增强

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

CVPR 2022 | 上海交大&腾讯AI Lab&港中文开源FAME:助力视频表征学习运动感知的数据增强

【引言】

鉴于对比学习在图像领域的成功,如何在视频表征学习中更好的运用对比学习引起了极大的关注。我们发现,当简单地拉近视频的两个增强视图时,模型倾向于将常见的静态背景作为捷径来学习,但忽略去捕捉运动信息。这种偏差使模型的泛化能力变弱,导致在动作识别等下游任务上的迁移能力变差。为了解决这类偏差,我们提出了前景-背景融合的数据增强Foreground-background Merging (FAME)。我们特意将所选视频中移动的前景区域组合到其他视频的静态背景上。通过拉近原始视图和融合视图之间的表征,我们使得模型更加关注运动模式,并消除了背景偏差。大量实验表明,在几乎不增加计算开支的前提下,FAME 能够在下游任务(例如动作识别)上取得优异的性能。

1. 论文和代码地址

Motion-aware Contrastive Video Representation Learning via Foreground-background Merging

论文地址:https://arxiv.org/abs/2109.15130

代码地址:https://github.com/Mark12Ding/FAME

2. 研究动机--背景偏见

最近,图像中的无监督学习取得了有竞争力的表现,尤其是对比式的自监督学习。对比学习在特征空间拉近正样本对,并推远锚点与负样本。由于缺少标签,正样本对通常由锚点样本的数据增强得到,而负样本来自其他样本。然而,我们发现直接在视频领域使用对比学习范式会导致模型关注静态区域。

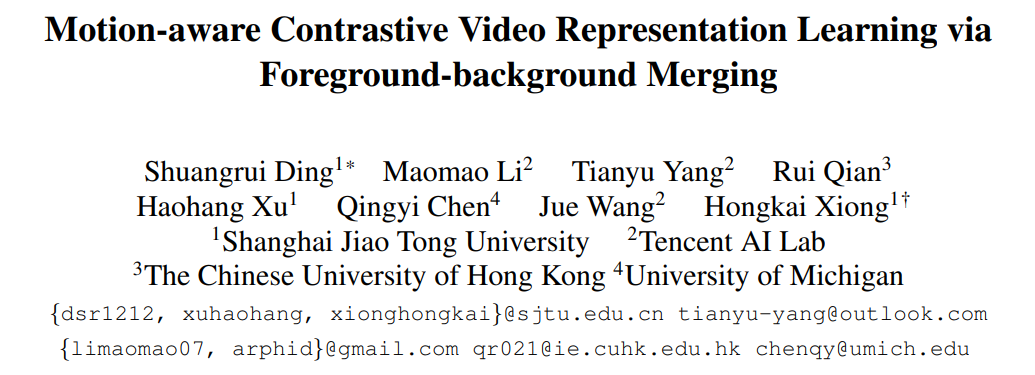

图1: 传统对比学习方法和所提出的FAME类无关激活图。

如图1所示,对比学习通常会忽略移动的人或物体,而是非常关注背景区域。除去激活图的可视化,我们还仔细分析了对比学习学到的骨干网络权重。我们使用了R(2+1)D骨干网络。其中我们可视化了每一个阶段1D的时序卷积的权重。

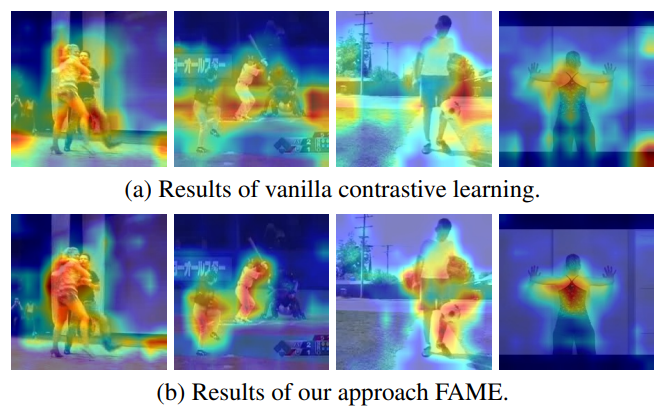

图2: 有监督学习,传统对比学习和FAME的时序卷积核权重的小提琴图。

如图2所示,相比于监督学习,无监督的对比学习学到的权重在所有层都更紧凑和更集中。这表明了有监督方法允许更灵活的时序建模,而基于对比学习的模型只理解单一的运动模式,并且更喜欢静态线索。这个现象被称之为背景偏差。深入分析,这个现象可能有两个可能的原因:1)背景通常比整个视频中的移动对象覆盖的区域要多得多,因此模型更容易专注于背景。2)当同一个视频的两个不同片段作为正样本对时,静态背景几乎相同,但运动模式往往存在细微差别。因此模型自然地会去聚焦于更相似的背景信息而放弃那些有细微不同的运动信息。

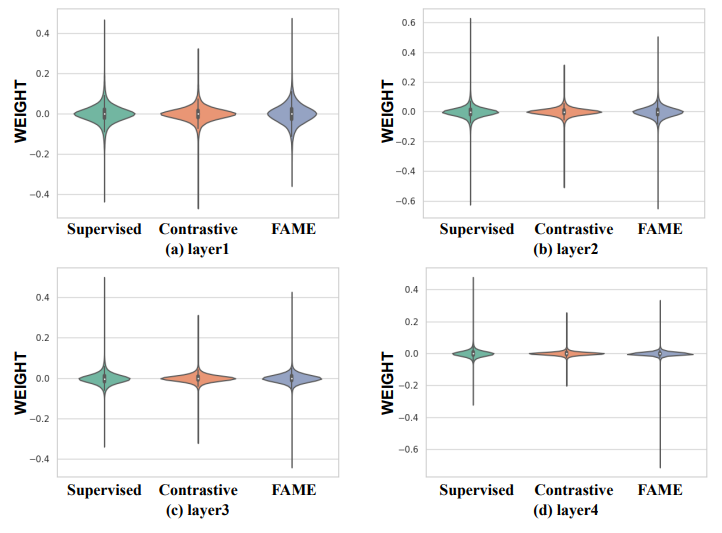

图3: 对比学习产生背景偏差的示意图。绿框内为背景区域,红框内为前景区域。

我们在图3中展示了一个形象的例子。我们从一个跳水视频中采样了两个片段。绿色区域为背景,占屏幕的四分之三以上。红色框仅占一个小区域,包含重要的前景运动信息(跳水运动员)。除此之外,两个片段的背景几乎相同,而两个视频中的动作却有细微不同,一个是站在跳台上,另一个已经起跳。也就是说,当我们遵循传统的数据增强从而形成正样本对作为自我监督时,模型会直观地将静态特征拉近且较少关注运动。因此,为了让对比学习方法更具运动感知能力,我们考虑用运动比背景更相似的正样本对来学习视频表征。

3. 方法

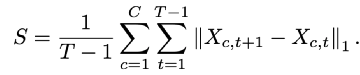

为了减轻自监督视频表征学习中的背景偏差,我们打算保留原始视频中的前景区域并替换视频中的背景区域。因此,我们提出了前景-背景合并方法(FAME),以最小的计算开销来将动态区域从视频中分离出来,然后在其他背景上合成前景。具体地说,我们首先算出帧差(frame difference),然后沿通道和时间维度求绝对值的和以生成种子区域 S。

帧差提供了自然的运动信息。通常来说,移动的前景往往具有很大的值,而静态背景在这个度量中是很小的。在实践中,我们发现种子区域 S 的较大值通常对应于运动物体的边缘区域。为了补全前景物体,我们利用了简单的颜色分布统计来估计运动前景物体(具体方法可参考原文)。得到前景掩码

值得一提的是我们混合到前景视频中的背景区域可能实际上不是真正的背景,并且可能包含不相关的动作。我们认为这些无关运动对于稳健地学习运动模式是必要的。如果所有背景都用静态画面填充,模型将有可能塌缩到仅仅了解该区域是否包含动态像素。这种捷径对于运动感知是没有好处的。

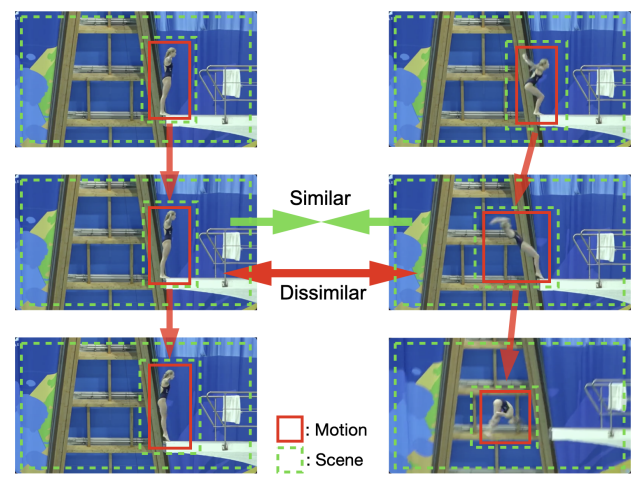

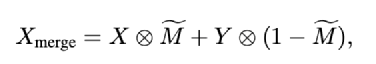

图4: 具有FAME的对比学习框架图。

综上所述,我们在图 4 中展示了基于 FAME 的对比学习框架。详细地说,我们从不同的时间戳中随机采出两段视频。除了基础的数据增强之外,我们使用 FAME 将一个视频的前景与同一mini-batch中其他视频的背景融合。然后,我们将这两个视频作为正样本对输入骨干3D 编码器。最后,我们最小化 InfoNCE 损失函数来预训练 我们的3D 编码器。通过构建具有相同前景但不同背景的正样本对,我们引导了模型关注时序线索并抑制了背景的贡献。

4. 实验

4.1 消融实验

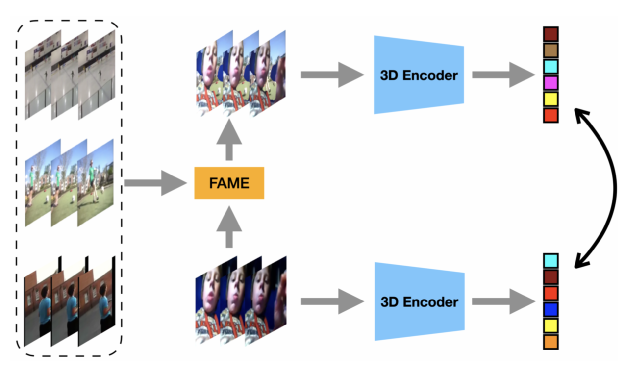

前景比例 β。我们探究了不同的前景比例对表征质量的影响。如表1所示,我们发现当前景比例低的时候(0.3和0.5)在 UCF101 和 HMDB51 上都显著提升基线约 6%。尽管由于背景替换不足而略逊于较小的 β 值,β = 0.7 时增益也相当可观。这个结果验证了我们的想法,即替换静态区域可以引导模型学习运动感知表征,从而增强下游性能。

更强的背景去偏。为了探索 FAME 是否足够强以完全消除背景偏差,我们设计了一个更强的对比方法。我们在 MoCo 的两个分支上都应用了 FAME,即两个正样本对视频都不将包含初始背景信息。我们在表 1 中报告了结果。两种设置之间可忽略的性能差异证明我们的初始设置足够强大,可以学到背景去偏表征。

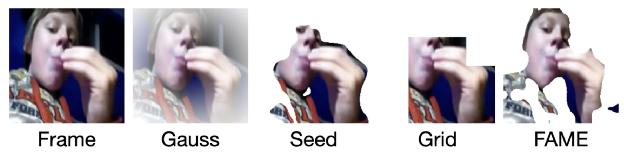

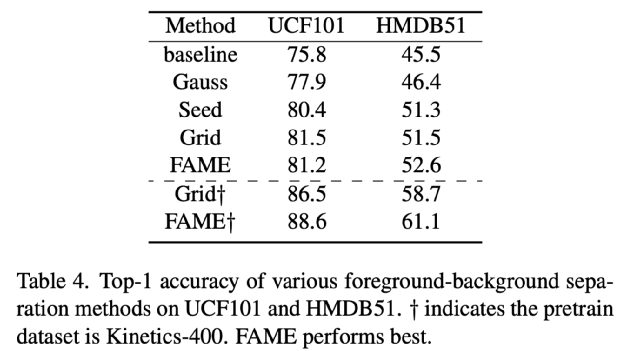

前景蒙版的变体。如图5,我们设计了不同的前景蒙版来验证强调运动前景可提高对比学习中的运动理解。(i) Gauss:我们直接采用二维高斯核矩阵作为前景蒙版。这是基于视频以运动前景为中心拍摄的假设。(ii) Seed:我们只取种子区域 S 来表示前景而不做颜色补全。(iii) Grid:我们在空间上将视频分割成 4 × 4 的网格。我们统计每个网格中 S 的总值,取最大的 8 个网格作为前景区域。我们在表 4 中将 FAME 与这三个变体进行了比较。首先,我们注意到所有变体都大大超越了基线。这证明了引入不同背景的有效。此外,从 Gauss、Seed、Grid 到 FAME 越细化前景蒙版,动作识别结果越好。有趣的是,我们注意到 Grid 在 UCF101 上的表现略胜 于FAME。我们推测,由于在这个实验中预训练数据集和下游数据集都是 UCF101,因此可能模型会利用相似背景作为捷径而不影响性能。为了深入研究这种现象,我们在另一个预训练数据集 Kinetics-400 上进行了额外的实验。在 UCF101 和 HMDB51 上,Grid 变体的 Top-1 准确率比 FAME 低 2% 以上。这表明在将具有运动感知的表征转移到不同的下游数据集时,细致的前景掩码而不是粗糙的网格框能更有效地促进泛化能力。

图5:FAME 和三个变体的示例。

4.2 与现有方法的比较

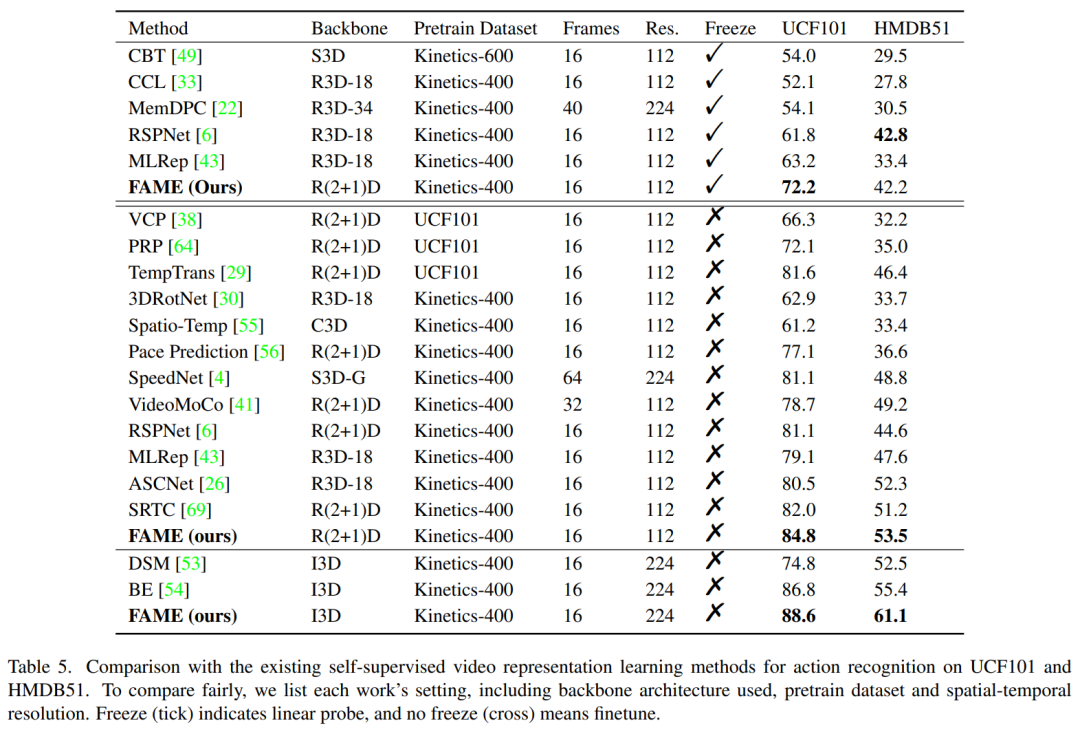

我们将我们的方法与现有技术进行了比较。在表 5 中,我们报告了 UCF101 和 HMDB51 的 Top-1 准确度。具体实现细节可以参考原文。在linear probe设定中,我们的方法在 UCF101 上获得了最佳结果,在 HMDB51 上获得了可比较的结果。在finetune 设定下,具有R(2+1)D 主干的FAME 在UCF101 和HMDB51 上取得了最好的结果。它表明 FAME 在 Kinetics-400 数据集上学习到了场景去偏和运动感知表征,这将模型更好地迁移到下游数据集。值得注意的是,我们与 BE 有着相似的动机,它直接在每一帧添加一个静态帧,并将这个修改过的视频视为原始视频的正样本对。实验结果证实,这种细微的干扰不能充分减轻静态背景偏差。当使用相同的主干 I3D 时,我们的 FAME 在 UCF101 和 HMDB51 上分别优于 BE 1.8% 和 5.7%。这证明了我们的方法可以更好地学习运动模式。

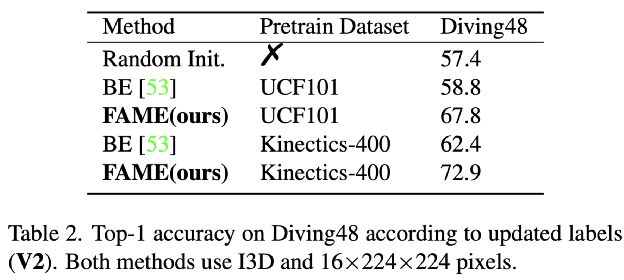

我们还在更具挑战性的细粒度数据集 Diving48 上微调和测试了FAME,结果见表 2。在 Diving48 中,由于静态背景与细粒度类别没有强相关性,我们的运动感知表征可以大大有利于动作识别。在 Kinetics-400 上进行预训练时,FAME 可以提升随机初始化的模型15.5%。相比之下,无论预训练数据集是 UCF101 还是 Kinetics-400,BE 都远不如 FAME 有效。Diving48 上的结果表明 FAME 确实可以使模型感知运动模式并消除场景偏差。

为了更好地展示 FAME 的有效性,我们在图 1 中可视化了FAME方法下的热点激活图。相比之下,通过FAME 学习的模型强化关注了移动前景区域并抑制了背景区域。此外,如图 2所示,与传统对比方法相比,FAME 学到的时序卷积核权重分布更分散,方差更大。综上,在 FAME 此类强运动诱导数据增强的指导下,对比学习可以使3D编码器消除背景偏置并关注运动模式。

5. 总结

我们提出了一种新的前景-背景合并方法来减轻自监督视频表征学习中的背景偏差。通过该方法,我们通过将原始前景与其他视频的背景融合来形成融合视频。当迫使骨干模型学习原始视频和融合视频之间的语义一致时,模型可以学习到具有运动感知的表征。一系列下游任务的实验结果证明了通过简单的数据增强可以有效的消除背景偏差和提高性能。当然,我们的工作仍然存在一些局限性。一是前景提取质量不稳定,尤其是前景和背景在颜色分布上没有明显差异或相机剧烈移动时。此外,前景区域比率现在由超参数 β 固定。设置一个自适应前景区域比率会更合理。

广告内容:

腾讯AI Lab是腾讯的企业级AI实验室,于2016年4月在深圳成立,目前有100多位顶尖研究科学家及300多位应用工程师。借助腾讯丰富应用场景、大数据、计算力及一流人才方面的长期积累,AI Lab立足未来,开放合作,致力于不断提升AI的认知、决策与创造力,向「Make AI Everywhere」的愿景迈步。

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer6666,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信: CVer6666,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看