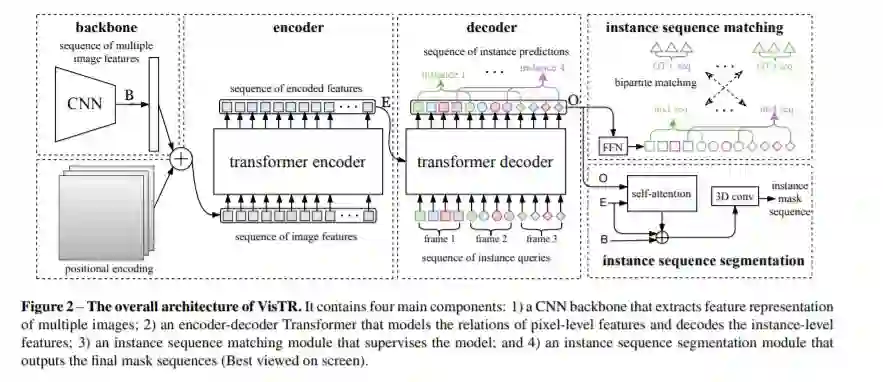

本文是第一个将Transformers应用于视频分割领域的方法。视频实例分割指的是同时对视频中感兴趣的物体进行分类,分割和跟踪的任务。现有的方法通常设计复杂的流程来解决此问题。本文提出了一种基于Transformers的视频实例分割新框架VisTR,该框架将视频实例分割任务视为直接端到端的并行序列解码和预测的问题。给定一个含有多帧图像的视频作为输入,VisTR直接按顺序输出视频中每个实例的掩码序列。该方法的核心是一种新的实例序列匹配和分割的策略,该策略在整个序列级别上对实例进行监督和分割。VisTR将实例分割和跟踪统一到了相似度学习的框架下,从而大大简化了流程。在没有任何trick的情况下,VisTR在所有使用单一模型的方法中获得了最佳效果,并且在YouTube-VIS数据集上实现了最快的速度。

https://www.zhuanzhi.ai/paper/0dfba6abdc5e6a189d86770822c17859

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构