基于视频的目标检测的发展【附PPT与视频资料】

关注文章公众号

回复"郭超旭"获取PPT与视频资料

导读

随着深度卷积神经网络的迅速发展,基于图片的识别任务包括分类、检测与分割等都得到了极大的进步。然而,我们现实生活面临的都是一些视频流信息,而基于图片的模型参数量大且Inference时间较长,如何将这些模型迁移到视频流上成为了一个研究热点。此次分享主要聚焦于基于视频的目标检测,介绍近几年research community 在视频目标检测的几个比较好的工作。

作者简介

郭超旭,中科院自动化研究所二年级硕士生在读,本科毕业于华南理工大学自动化系。2018 MSCOCO竞赛实例分割第三名,全景分割第二名。2018南京人工智能大赛仪表识别组初赛第一名。目前研究方向主要为基于视频、图片的检测与分割。

1.Introduction

基于视频的目标检测与普通的图片目标检测的任务一样,都是需要给出图片上物体的类别以及对应的位置,但是视频目标检测相比图片目标检测有更多的难点和更高的要求。视频中会存在运动模糊、摄像头失焦的现象以及目标物体可能会保持一种奇怪的姿态或者存在严重的遮挡,这往往需要利用视频中的时序信息来对视频中的信息进行推断和预测。除此之外,视频由于包含有大量的视频帧,直接将基于图片的检测模型迁移到视频上可能会带来巨大的计算量,视频中的时序信息可能能够帮助我们不用依赖重复的特征计算就能得到相应的结果。目前主流的方法是利用光流来捕捉视频中的时序信息。

2.Methods

目前利用光流的方法大体分为两个流派,一个是利用光流来进行洗漱关键帧之间的特征传递,从而节省计算量来达到速度与精度的trade-off;一个是利用光流来充分利用邻帧的信息,对视频帧进行特征增强,以达到更高的精度,但是速度一般比较慢。我们接下来会以论文公开时间为顺序来介绍近期的四个工作。

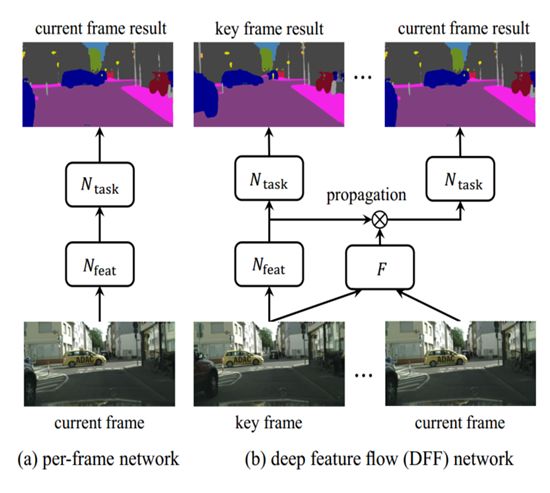

第一个工作是来自MSRA的Deep Feature Flow (DFF),DFF的核心思想就是利用光流中的warp操作来进行特征传递。具体地讲,如下图1,DFF在一段视频帧里面以固定间隔选取稀疏地关键帧,其他的帧则为非关键帧。对于关键帧,DFF 用一个特征提取网络res101去提取高层语义特征,进而检测器则以这些特征为输入从而得到检测结果;对于非关键帧,DFF先经过一个光流网络计算该非关键帧与在此之前最近的关键帧的光流图,然后利用得到的光流图和关键帧的高层特征进行warp操作,从而将特征对齐并传递到该非关键帧,检测器基于此特征输出该非关键帧的检测结果。DFF利用相对轻量的光流网络和warp操作代替原来的res101来得到相应的特征,达到节省计算量的目的。最终在关键帧间隔为10的情况下,达到73.1mAP/20fps(K40). 在比baseline(73.9Map/5fps)损失了0.8mAP的情况下得到了5倍的提速。

图1

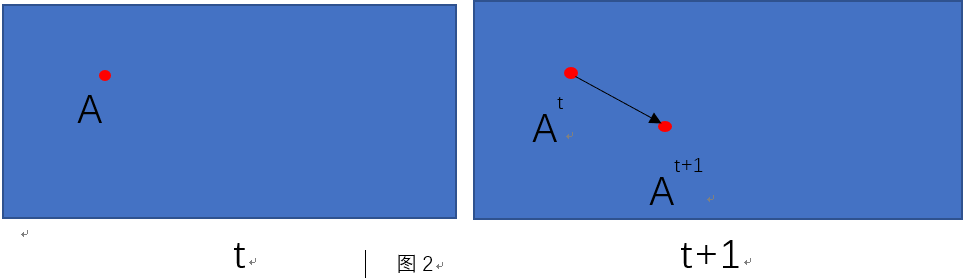

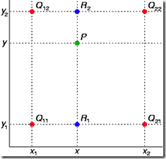

这里我们稍微讲解一下warp操作,warp最开始是用在对图片像素点进行对齐的操作。光流图本质就是记录了某帧图片像素点到另外一帧的运动场,光流图上的每一个点对应着图片上该点的运动矢量。如图2所示,假设我们知道第t帧中的点会运动到第t+1帧的点,这样就得到了运动矢量。如果我们此时要求得第t帧中的像素值,则可以根据其运动矢量和第t+1帧中的像素值来进行双线性插值得到,具体如图3:

图3

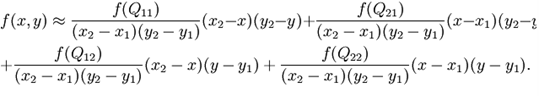

假设落到点,则有:

而DFF则将warp操作扩展到feature map上,从而达到进行特征传递的目的。

第二个工作是MSRA的Flow Guided Feature Aggregation(FGFA)。与DFF不同,FGFA追求精度而不考虑速度,其对于视频的所有帧都利用特征网络res101提取了特征,为了增强特征,其还利用光流将相邻多帧的特征给warp到当前帧,然后所有的特征输入到一个小的embedding网络从而得到每个特征的相对重要性权重,进而利用这些权重对这些特征进行加权求和,最后得到的增强后的特征再送入检测器,以得到检测结果。通过这样的方式,FGFA得到了更高的精度,但是损失了很多速度,最后的结果为76.3mAP/1.36fps。

第三个工作是来自商汤的Impression Network,这个工作是在DFF的基础上做的,Impression除了将关键帧的特征利用warp传递到非关键帧之外,还提出关键帧之间的特征传播与增强,以求保留更多的时序上下文信息。具体地,关键帧的特征利用warp传递到下一个关键帧,两个特征经过几层卷积网络得到相应的重要性权重,进而对其进行加权求和得到新的关键帧的特征,不同的相邻关键帧之间以这种方式不断迭代进行,达到将重要的信息在整个视频中传递的目的。Impression在得到较好结果的同时也有不错的速度,在GTX 1060上达到75.5mAP/20fps。

第四个工作是MSRA的Towards good performance video object detection。之前DFF和Impression选取关键帧的方式都是启发式地以固定间隔来选取,这个工作给光流网络增加了一个输出,新的输出map上的每一个点的值代表两帧的feature map上的对应点的特征一致性程度。而这个工作觉得当上一个关键帧与当前帧的特征一致性程度总体低到一定的阈值的时候,就要将该帧当作新的关键帧。除了提出动态选取关键帧的方法之外,其还提出根据两帧之间的特征一致性程度来动态更新非关键帧的特征,而不是跟之前的工作一样直接利用warp过来的特征。具体地,当feature map上的某个位置特征一致性比较低的时候,我们就不利用warp过来的特征来更新非关键帧的特征,而使用原来的特征;如果比较高的话,则直接使用warp过来的特征。通过这两个技巧,这个工作得到了比较好的一个trade-off:78.6mAP(+deformable)/8.6fps(K40)。

Take Home Message

当前的主流方法都是利用光流在做特征的对齐和传递,这种做法有点曲线救国,如何摆脱光流而设计一个直接基于特征的对齐方法是一个值得探究的方向。

SFFAI讲者招募

为了满足人工智能不同领域研究者相互交流、彼此启发的需求,我们发起了SFFAI这个公益活动。SFFAI每周举行一期线下活动,邀请一线科研人员分享、讨论人工智能各个领域的前沿思想和最新成果,使专注于各个细分领域的研究者开拓视野、触类旁通。

SFFAI目前主要关注机器学习、计算机视觉、自然语言处理等各个人工智能垂直领域及交叉领域的前沿进展,将对线下讨论的内容进行线上传播,使后来者少踩坑,也为讲者塑造个人影响力。

SFFAI还将构建人工智能领域的知识树(AI Knowledge Tree),通过汇总各位参与者贡献的领域知识,沉淀线下分享的前沿精华,使AI Knowledge Tree枝繁叶茂,为人工智能社区做出贡献。

这项意义非凡的社区工作正在稳步向前,衷心期待和感谢您的支持与奉献!

有意加入者请与我们联系:wangxl@mustedu.cn

历史文章推荐: