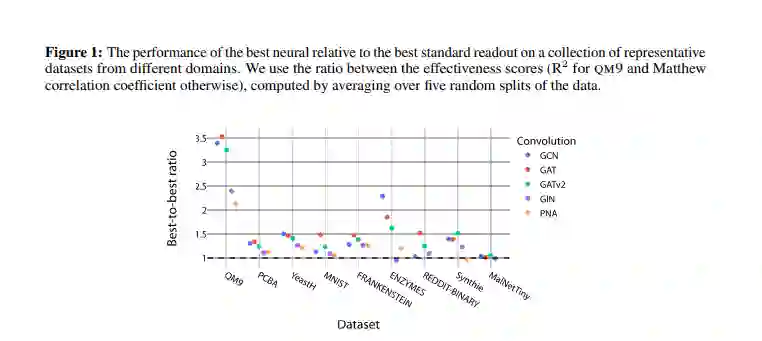

在许多涉及图神经网络的学习任务中,通过读出函数将节点特征有效地聚合为图级表示是必不可少的一步。通常,读出是简单且非自适应的函数,其设计使得得到的假设空间是排列不变的。先前对深度集的研究表明,这样的读出可能需要复杂的节点嵌入,通过标准的邻域聚合方案很难学习。基于此,我们研究了神经网络给出的自适应读出的潜力,这些神经网络不一定会产生排列不变的假设空间。我们认为,在一些问题中,如分子通常以规范形式呈现的结合亲和性预测,可能会放松对假设空间排列不变性的约束,并通过使用自适应读取函数学习更有效的亲和性模型。我们的经验结果证明了神经读出在跨越不同领域和图特征的40多个数据集上的有效性。此外,我们观察到相对于邻域聚合迭代次数和不同的卷积运算符,相对于标准读数(即和、最大值和平均值)有一致的改进。

成为VIP会员查看完整内容