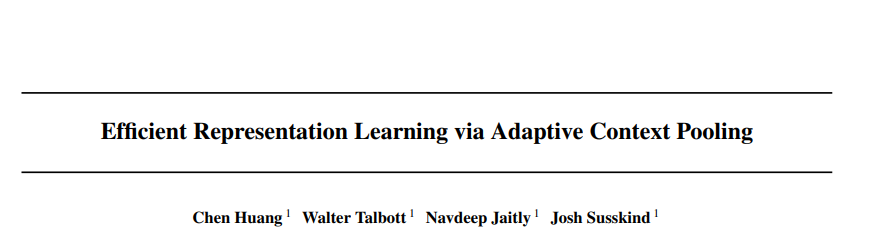

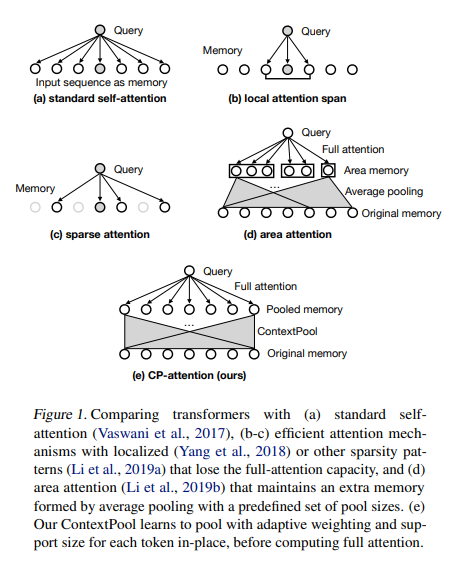

自注意力机制利用所有输入标记之间的成对注意力对长上下文进行建模。在此过程中,他们假设单个标记(例如,文本字符或图像像素)定义了固定的注意力粒度,这对于在更高级别上建模复杂依赖关系可能不是最优的。在本文中,我们提出了ContextPool,通过调整每个标记的注意粒度来解决这个问题。受ConvNets成功结合池化来捕获远程依赖的启发,我们学会了在给定的注意力层中计算注意力之前,为每个令牌池化邻近的特性。池权和支持大小是自适应确定的,允许池特性以不同的规模编码有意义的上下文。我们表明,ContextPool使注意力模型更具表现力,通常用更少的层实现强大的性能,从而显著降低成本。实验验证,当我们的ContextPool模块插入transformer 模型时,在几种语言和图像基准上使用较少的计算,匹配或超过了最先进的性能,在学习上下文大小或稀疏注意力模式方面优于最近的工作,也适用于ConvNets的高效特征学习。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年8月30日

Arxiv

16+阅读 · 2017年11月20日