【泡泡一分钟】一种新型的追踪方法:学习追踪长期依赖的多个线索(ICCV2017-29)

每天一分钟,带你读遍机器人顶级会议文章

标题:Tracking The Untrackable: Learning to Track Multiple Cues with Long-Term Dependencies

作者:Amir Sadeghian, Alexandre Alahi, Silvio Savarese

来源:International Conference on Computer Vision (ICCV 2017)

播音员:Amy

编译:王嫣然 周平(32)

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

多目标追踪(MTT)问题的大多数现有解决方案都没有将线索以长时间连贯的方式进行组合。在本文中,我们提出了一种在线方法,可以对多个线索进行长时间依赖性编码。

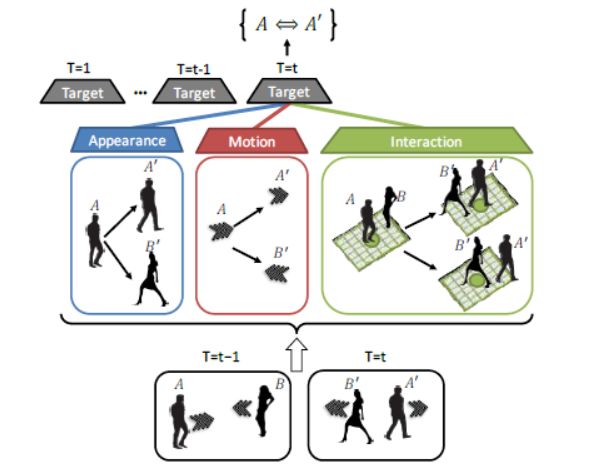

图1 一种基于RNNs结构的方法(每个RNN都是由梯形图描绘的),该方法学习通过多个线索(外观、动作和交互)来编码长期的时间依赖关系。

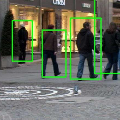

追踪方法的一个关键挑战是准确追踪被遮挡的目标或那些与周围物体具有相似外观属性的目标。为了解决这个问题,我们提出了一种递归神经网络(RNN)结构,这种结构可以将多个线索联合在一个时间窗口上。并且可以修正数据关联错误,从封闭状态恢复观察结果。我们通过使用外观,运动,甚至交互来追踪多个目标,从而证明数据驱动方法的稳健性。我们的方法在多个公开数据集,包括具有挑战性的MOT基准测试上都优于以前的方法。

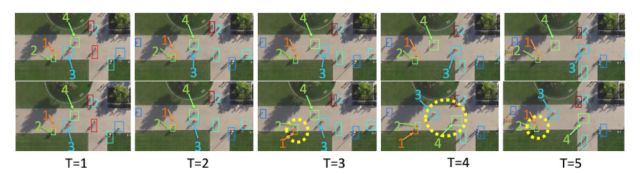

图2 斯坦福无人机数据集的定性结果。第一行展示了我们方法的追踪结果,而第二行显示了mdp+sf-mc的结果。虚线圆圈表示在前面方法中的ID转换。

Abstract

The majority of existing solutions to the Multi-Target Tracking (MTT) problem do not combine cues over a long period of time in a coherent fashion. In this paper, we present an online method that encodes long-term temporal dependencies across multiple cues. One key challenge of tracking methods is to accurately track occluded targets or those which share similar appearance properties with surrounding objects. To address this challenge, we present a structure of Recurrent Neural Networks (RNN) that jointly reasons on multiple cues over a temporal window. Our method allows to correct data association errors and recover observations from occluded states. We demonstrate the robustness of our data-driven approach by tracking multiple targets using their appearance, motion, and even interactions. Our method outperforms previous works on multiple publicly available datasets including the challenging MOT benchmark.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

点击“阅读原文”,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com