【泡泡一分钟】PathTrack:使用路径监督的快速轨迹标注方法(ICCV2017-28)

每天一分钟,带你读遍机器人顶级会议文章

标题:PathTrack: Fast Trajectory Annotation with Path Supervision

作者:Santiago Manen, Michael Gygli, Dengxin Dai, Luc Van Gool

来源:International Conference on Computer Vision (ICCV 2017)

播音员:Suzanne

编译:张鲁 周平

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

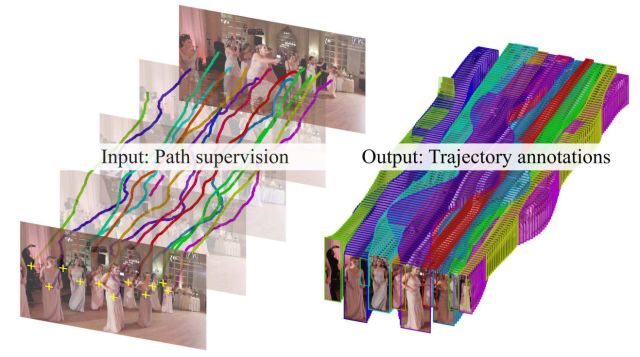

多物体跟踪(MOT)领域的发展一直被现有可用数据集的大小所限制。我们提出了一种高效的框架来标注轨迹,并且借此生成了一个前所未有的大规模MOT数据集。在本文提出的这个新型路径监督机制中,标注者在观看视频时使用光标粗略地跟踪物体,以此提供了视频中各个物体的运动路径标注。我们的方法可以将此类弱标注转化为稠密的边界框轨迹。我们对现有数据集进行的实验证明,我们的框架能够在短时间内产生比现有技术更精确的标注。我们还通过众包的方法建立了PathTrack数据集以此验证本文方法的可行性,该数据集包括超过720个视频序列总共15000个人物轨迹。与物体识别类似,跟踪过程的训练可以受益于大规模的数据集。我们通过重新训练一个现成的人物匹配网络来证明上述结论,该网络原本由MOT15数据集训练,使用本方法几乎将误分类率降低一半。此外,在我们的训练集上训练,可以持续改进跟踪结果,无论是在本数据集中还是MOT15中。在后者中,我们改进了性能最好的跟踪器(NOMT),将ID Sw. 降低了18%,Frag降低了5%。

图1. 图中的序列含有许多相似的人物。标注这类序列是非常耗时且枯燥的。本文的路径监督(path supervision)方法中,用户可以在观看视频时轻松地跟随目标来收集路径标注。本文方法使用这类路径标注来生成稠密的边界框轨迹。

Abstract

Progress in Multiple Object Tracking (MOT) has been historically limited by the size of the available datasets. We present an efficient framework to annotate trajectories and use it to produce a MOT dataset of unprecedented size. In our novel path supervision the annotator loosely follows the object with the cursor while watching the video, providing a path annotation for each object in the sequence. Our approach is able to turn such weak annotations into dense box trajectories. Our experiments on existing datasets prove that our framework produces more accurate annotations than the state of the art, in a fraction of the time. We further validate our approach by crowdsourcing the PathTrack dataset, with more than 15,000 person trajectories in 720 sequences1. Tracking approaches can benefit training on such large-scale datasets, as did object recognition. We prove this by re-training an off-the-shelf person matching network, originally trained on the MOT15 dataset, almost halving the misclassification rate. Additionally, training on our data consistently improves tracking results, both on our dataset and on MOT15. On the latter, we improve the top-performing tracker (NOMT) dropping the number of ID Switches by 18% and fragments by 5%.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

点击“阅读原文”,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com