【2017最佳机器学习论文】AlphaGo Zero最赏心悦目(一文读懂大咖论文)

新智元专栏

作者:邓侃

【新智元导读】2017年,你读过的最有趣、最有价值的机器学习/人工智能论文是什么,为什么?CMU计算机学院暨机器人研究所博士邓侃,2017年在新智元开设专栏,拆解了多篇论文。他从最赏心悦目、最有实践价值和最有潜力这几个方向,给出了他的答案。

前几天与杨静老师和刘江老师,讨论 2017 年人工智能进展时,没来得及说 2017 年最值得读的论文。

“什么是最值得读的论文”,这个话题,仁者见仁智者见智。

下面,说说我个人觉得今年收获最大的论文:

最有实践价值:Attention Is All You Need 和 One Model To Learn Them All

最有研究潜力:Superhuman AI for heads-up no-limit poker: Libratus beats top professionals

最赏心悦目的论文

Mastering the Game of Go without Human Knowledge 是 DeepMind 团队关于 AlphaGo Zero 的论文,发表于 Nature 期刊。

读这篇论文时,要与 DeepMind 先前讲解 AlphaGo 的另一篇论文,对照着读。那一篇论文的题目是,Mastering the Game of Go with Deep Neural Networks and Tree Search。

比较这两篇论文,AlphaGo Zero 比先前的版本 AlphaGo 的算法,更精炼,但是功能更强大。而且 AlphaGo Zero 的论文,写得也更精彩。尤其是叙述 AlphaGo Zero 靠自我博弈,花了多少小时,发现了围棋定式。又花了多少天,AlphaGo Zero 棋力先后战胜樊麾和李世乭等等。

最有实践价值论文(两篇)

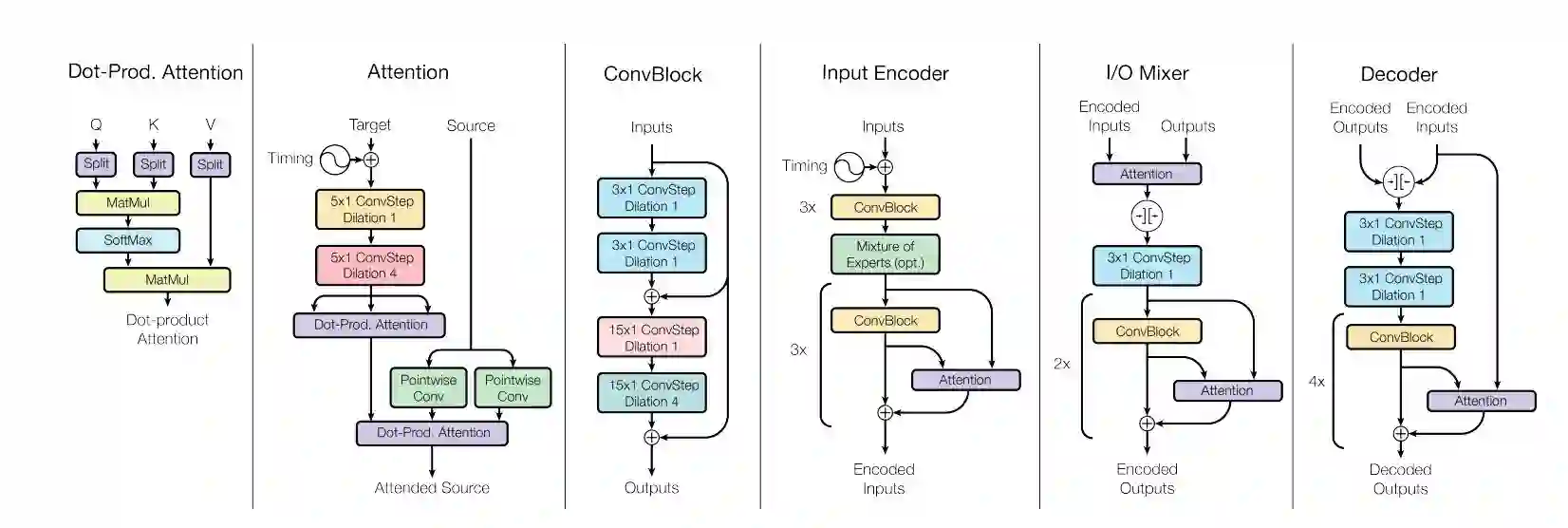

Attention Is All You Need 和 One Model To Learn Them All 这两篇论文,都是 Google Brain 团队的作品,而且都开源了源码,使用非常方便。

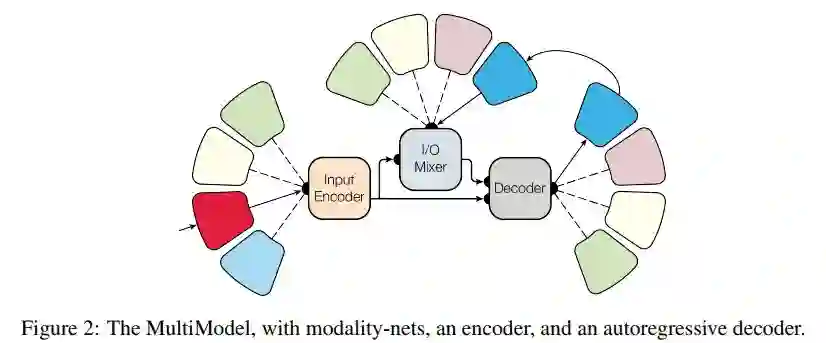

One Model to Learn Them All 论文图片

如果说深度学习,尤其是 CNN 的价值,在于用卷积算法,从原始数据中自动提炼特征,而不必像以往那样,靠人工来提炼特征。那么 Attention 的价值,在于对卷积进行反思。卷积不是提炼特征的唯一方法,而且也不一定是最佳方法。Google Brain 团队认为,Attention 在大多数场景下,可能比卷积更有效。

迄今为止,Attention 的算法大多数基于测算线性相似度。相信明年开始,会有更多的研究,着力于改造 Attention 的算法,尝试非线性相似度,甚至超越相似度,寻找更多的聚焦方式。

最有潜力研究方向

Superhuman AI for heads-up no-limit poker: Libratus beats top professionals 是 CMU 团队讲述人工智能德扑系统 Libratus 的论文,发表于 Science 期刊。

德扑面临着隐信息和反欺诈两个难题,比围棋更接近于真实世界的博弈。

AlphaGo 用深度强化学习,完美地解决了围棋的问题。接下去的悬念,是深度强化学习能否解决隐信息和反欺诈两个难题。有趣的是,Libratus 没有用深度强化学习,却相当漂亮地解决了这两个难题。明年的悬念是,DeepMind 的同事们,能否用深度强化学习来超越 Libratus?

编辑的话

2017年你读过最好的论文是哪些?欢迎留言,大家一起讨论~

专栏延伸阅读:一文读懂大咖论文系列

新智元2018新年寄语

2017年有几个关键词,第一是探索极限,探索人类智能和机器智能的极限。第二是城市升级,无论智能交通还是中国要用人工智能作为支柱产业,可能都会面临国家经济体系的升级。第三是产业跃迁,我们要接地气,每个产业都用AI技术赋能,爆发出来颠覆传统体系的潜力。

2017,新智元见证人工智能成为时代主流,中国企业成为全球互联网主角,新智元平台也实现超35万平台用户产业链互联。与掌握AI技术的智者同行,是新智元之幸。2018,我们不忘初心再出发,一起构建AI开放平台,助力中国智能+

最后,祝愿新智元的朋友们能够利用AI工具赋能社会、赋能人类。

——新智元创始人兼CEO 杨静

加入社群

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信aiera2015入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名-公司-职位;专业群审核较严,敬请谅解)。

此外,新智元AI技术+产业领域社群(智能汽车、机器学习、深度学习、神经网络等)正在面向正在从事相关领域的工程师及研究人员进行招募。

2018,加入新智元社群,一起构建AI开放平台,助力中国智能+